The Nutanix Bible - Classic Edition

[NOTE] 한글 번역본에서는 PDF 다운로드를 지원하지 않습니다.

뉴타닉스 바이블의 클래식 에디션에 오신 것을 환영합니다!! 뉴타닉스 바이블의 목적은 뉴타닉스 플랫폼 아키텍처에 대한 대한 보다 심층적인 기술 정보를 제공하는 것입니다.

Part 1: Core

Book of Basics

web·scale - /web ‘ skãl/ - noun - computing architecture

인프라 및 컴퓨팅 아키텍처에 대한 새로운 접근 방식.

뉴타닉스는 소프트웨어 스택 전체에서 "웹-스케일(Web-scale)" 원칙을 활용한다. 웹-스케일은 이를 활용하기 위해 Google, Facebook, Amazon 또는 Microsoft만큼 커질 필요가 있음을 의미하지 않는다. 웹-스케일 원칙은 3개 노드 또는 수천 개의 노드에 관계없이 모든 규모에 적용 가능하며 많은 장점을 제공한다.

"웹 스케일" 인프라에 대해 이야기할 때 사용되는 몇 가지 핵심 컨스트럭트가 있다.

- 하이퍼컨버전스 (Hyper-convergence)

- 소프트웨어 정의 인텔리전스 (Software defined intelligence)

- 분산 자율 시스템 (Distributed autonomous system)

- 점진적인 선형 스케일-아웃 (Incremental and linear scale out)

기타 관련 항목은 다음과 같다.

- API 기반 자동화 및 풍부한 분석 기능 (API-based automation and rich analytics)

- 핵심 테넌트로서의 보안 (Security as a core tenant)

- 셀프 힐링 (Self-healing)

본 BOOK에서는 이러한 기본적인 아키텍처뿐만 아니라 핵심 아키텍처의 개념을 설명한다.

전략 및 비전

뉴타닉스는 한 가지 목표에 집중했다.

Make infrastructure computing invisible, anywhere.

이러한 간단함은 세 가지 핵심 영역에 중점을 두어 달성할 수 있었다.

- 선택의 자유 및 이식성을 제공한다 (HCI/클라우드/하이퍼바이저)

- 컨버전스, 추상화 및 지능형 소프트웨어(AOS)를 통해 "스택"을 단순화한다.

- 사용자 경험(UX) 및 디자인(프리즘)에 중점을 두어 직관적인 사용자 인터페이스(UI) 제공

HCI/클라우드/하이퍼바이저: “선택의 자유”

뉴타닉스는 단일 하이퍼바이저(ESXi)를 지원하는 단일 하드웨어 플랫폼(NX)으로 시작했지만, 우리는 항상 단일 하이퍼바이저/플랫폼/클라우드 회사 이상이라는 것을 알고 있었다. 이것이 뉴타닉스가 vCenter에서 플러그인으로 실행하지 않고 처음부터 자체 UI를 구축하고, 기본적으로 커널이 아닌 VM을 실행하는 이유 중 하나였다 (물론 더 많은 이유가 있다). 왜 "선택의 자유"를 이야기할까요?

하나의 하이퍼 바이저, 하나의 플랫폼 또는 하나의 클라우드로 모든 고객의 니즈를 만족시킬 수 있는 것은 아니다. 동일 플랫폼에서 여러 개의 환경을 지원함으로써 뉴타닉스는 고객에게 선택과 활용의 자유를 제공한다. 고객에게 선택의 자유를 제공함으로써 뉴타닉스는 고객에서 유연성을 제공한다. 뉴타닉스가 제공하는 모든 것이 뉴타닉스 플랫폼의 일부이므로 모두 동일한 경험을 제공한다.

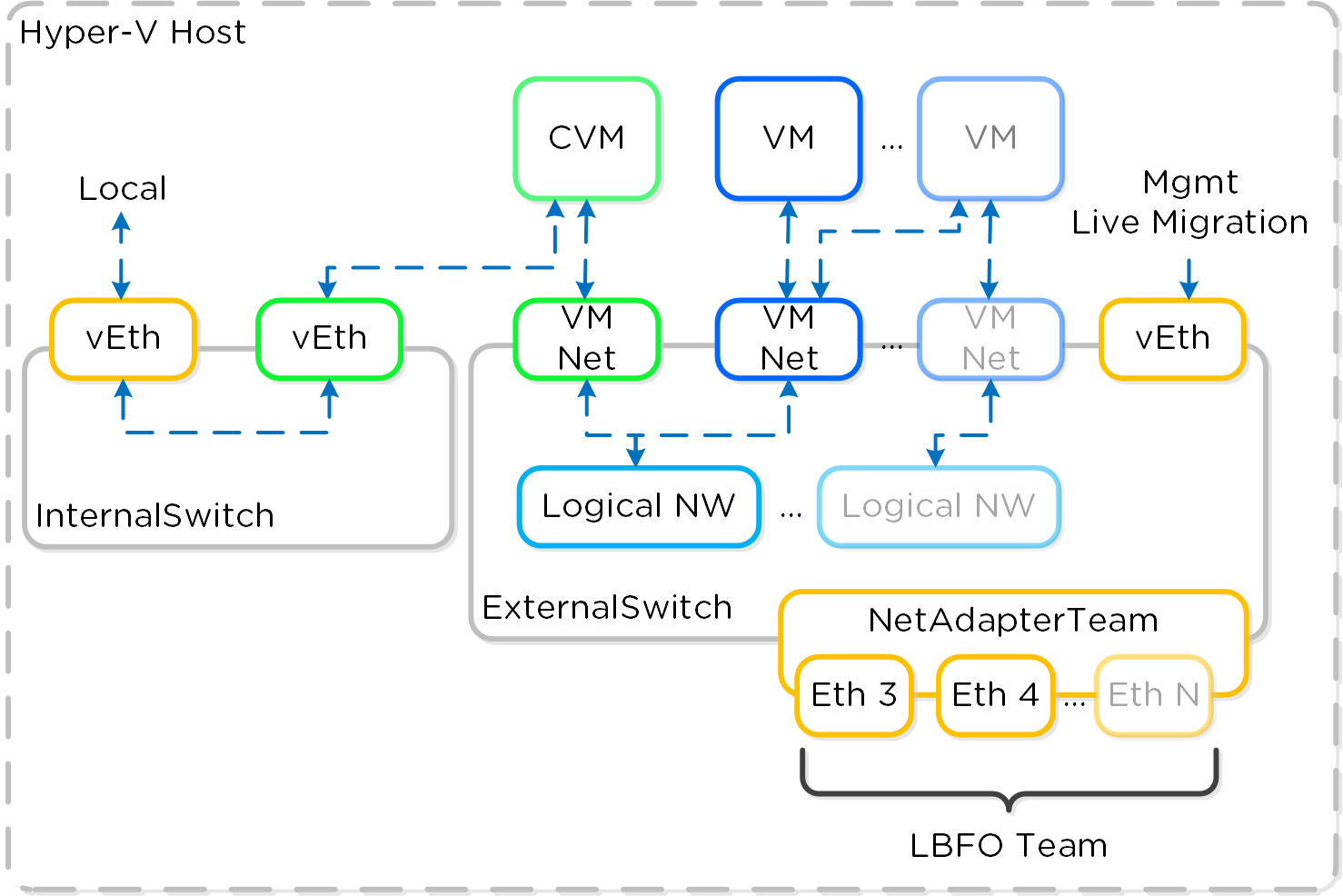

뉴타닉스는 이제 12개가 넘는 하드웨어 플랫폼(직접/OEM/써드-파티), 여러 개의 하이퍼바이저(AHV, ESXi, Hyper-V 등)를 지원하고, 모든 주요 클라우드 공급 업체(AWS, Azure, GCP)와의 통합을 확장하고 있다. 이를 통해 고객은 자신에게 가장 적합한 것을 선택할 수 있으며 공급 업체 간의 협상 목적으로 이를 사용할 수 있다.

NOTE: 플랫폼은 섹션 전체에서 일반적으로 사용되는 키워드이다. 우리는 일회성 제품을 만들려고 하지 않으며 플랫폼을 만든다.

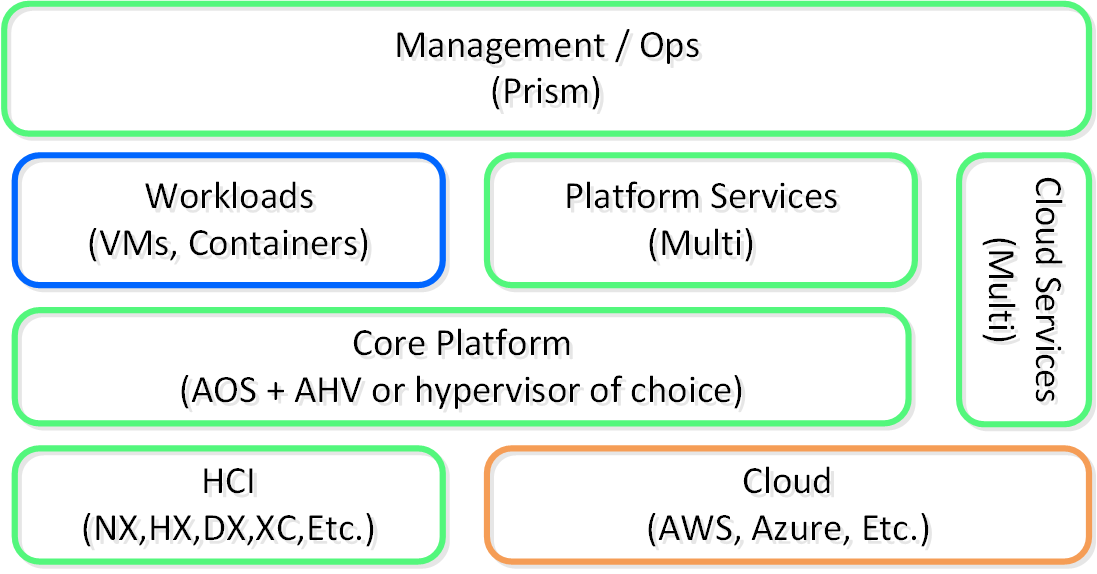

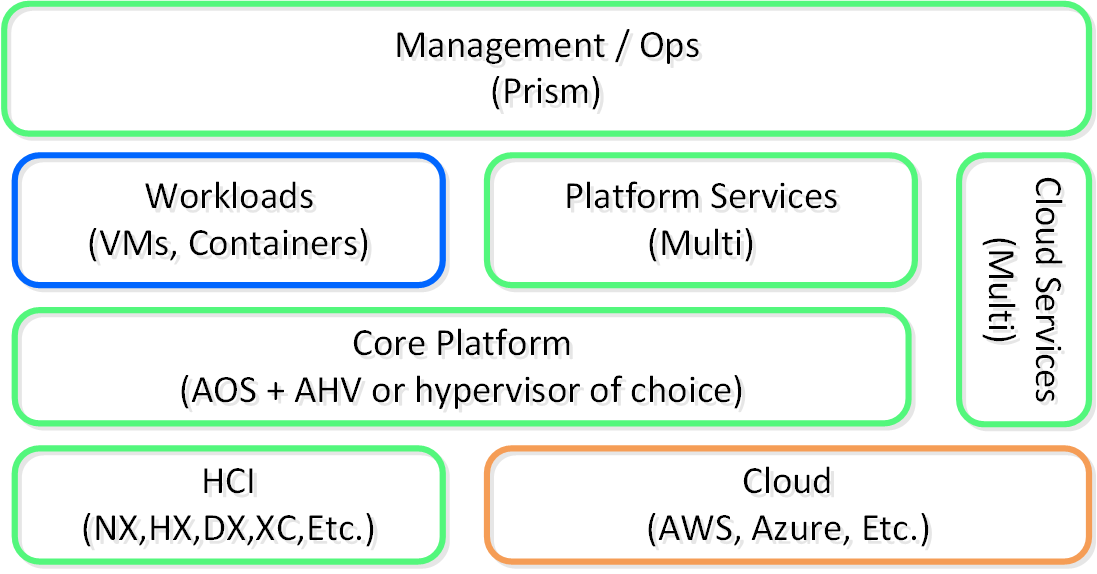

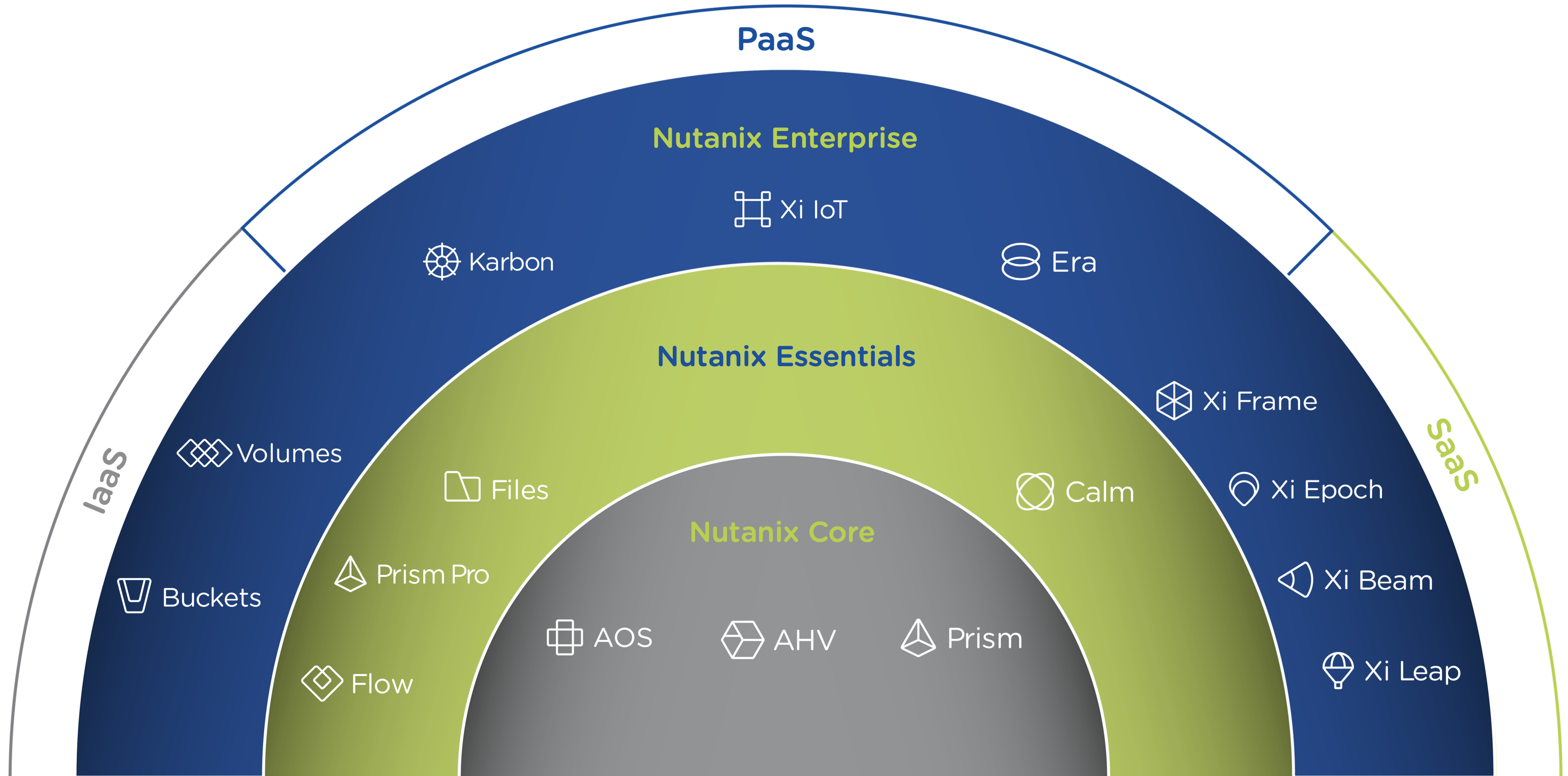

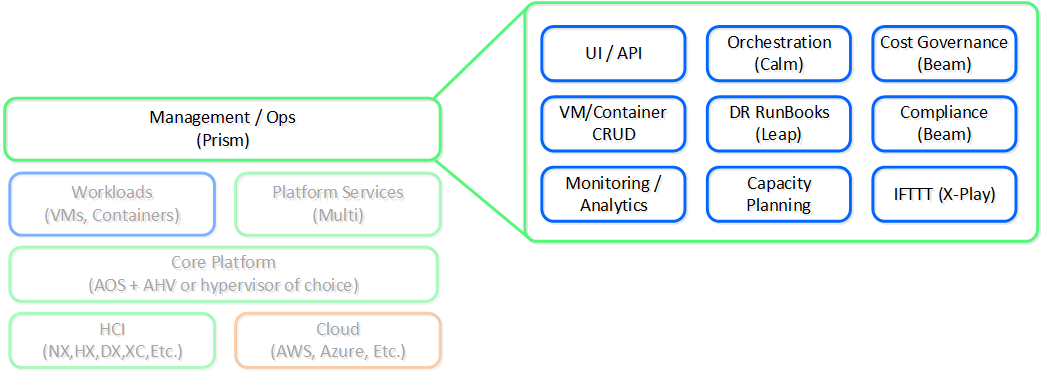

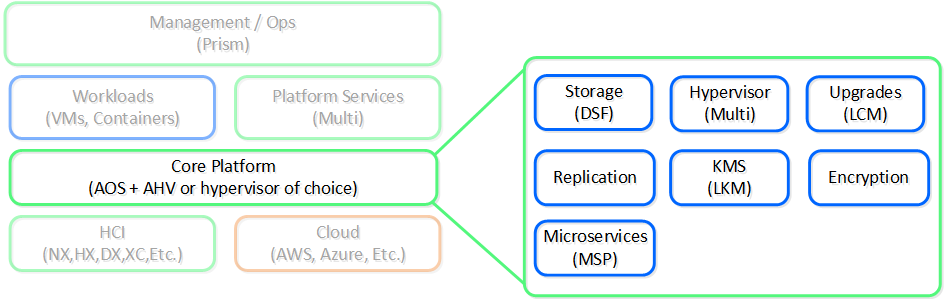

다음은 뉴타닉스 플랫폼의 하이-레벨 아키텍처를 보여준다.

뉴타닉스 플랫폼 - 아키텍처 (Nutanix Platform - Architecture)

뉴타닉스 플랫폼 - 아키텍처 (Nutanix Platform - Architecture)

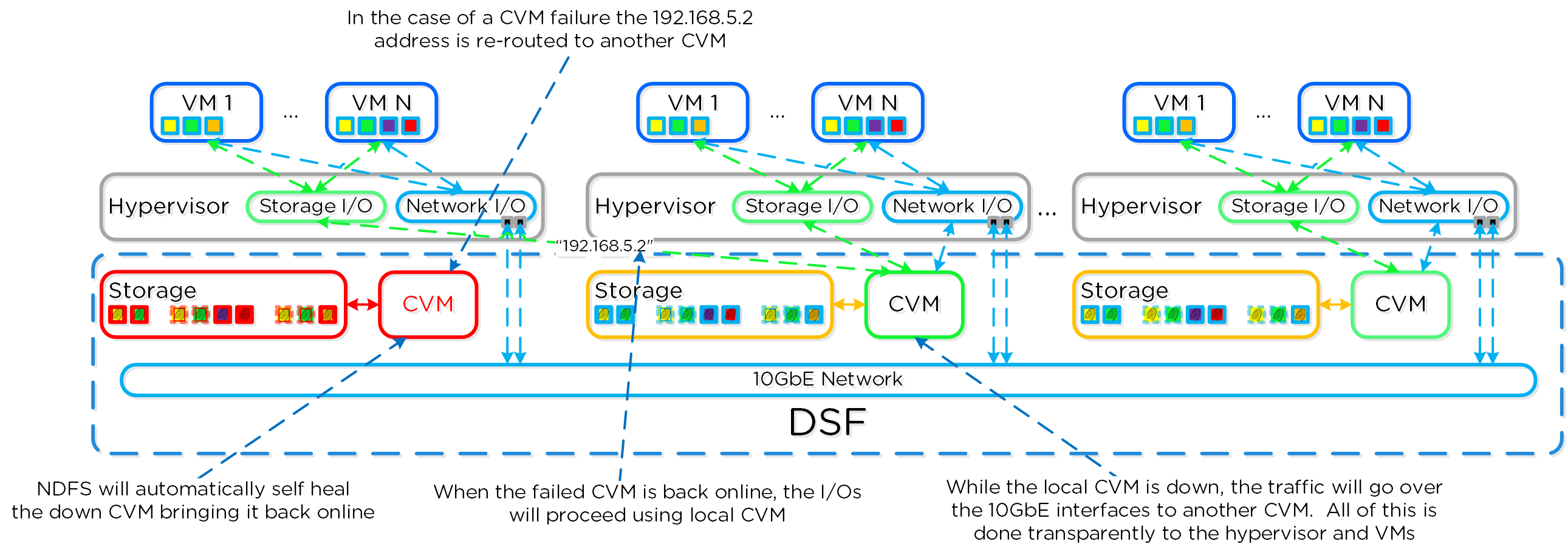

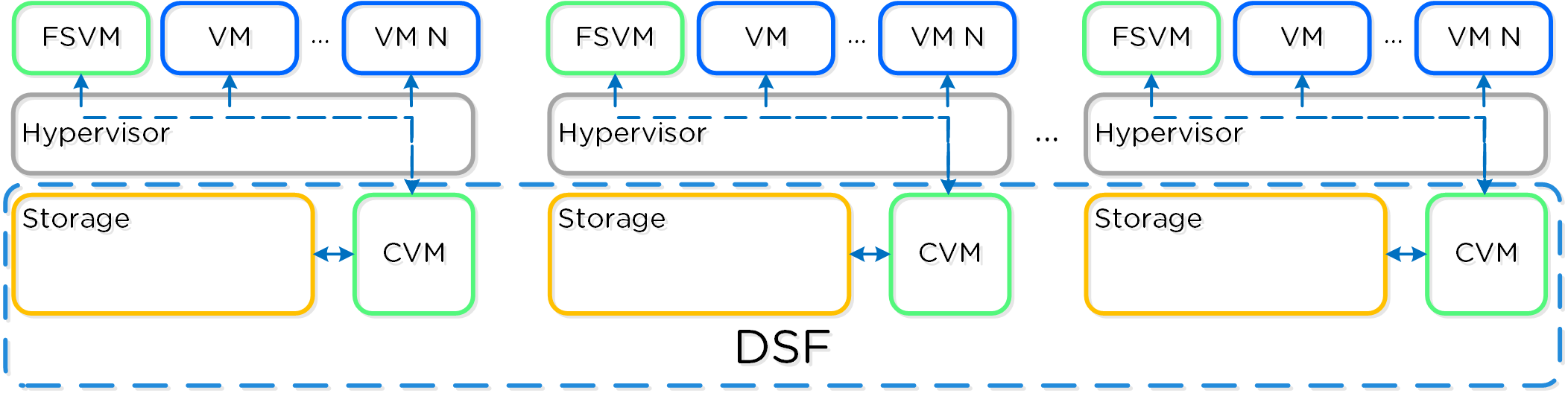

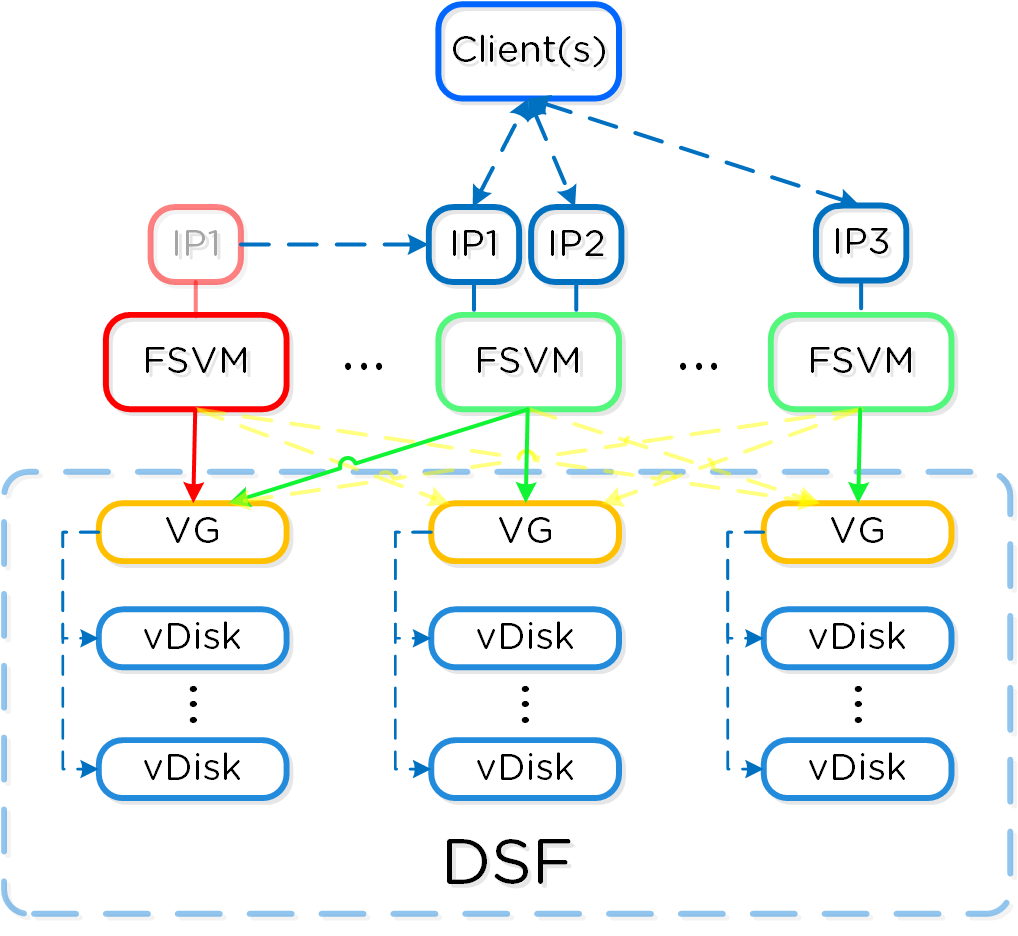

AOS + AHV/하이퍼바이저: “런타임”

뉴타닉스는 로컬 스토리지 리소스와 지능형 소프트웨어를 결합하여 "중앙 집중식 스토리지"를 제공하는 분산 스토리지 패브릭(DSF는 뉴타닉스 분산 파일 시스템 또는 NDFS라고도 함) 기능으로 스토리지를 단순화함으로써 이러한 여정을 시작했다.

수년에 걸쳐 뉴타닉스는 많은 기능을 추가했다. 단순화를 위해 이것을 두 가지 핵심 영역으로 나눈다.

- 핵심 서비스

- 기반 서비스

- 플랫폼 서비스

- 핵심 서비스를 기반으로 추가 기능/서비스를 제공하는 서비스

핵심 서비스는 워크로드(VM/컨테이너) 및 하이-레벨 뉴타닉스 서비스의 실행을 용이하게 하는 기반 서비스 및 컴포넌트를 제공한다. 처음에는 이것이 DSF 제품이었지만 스택의 단순화 및 추상화를 돕기 위해 플랫폼의 기능을 계속 확장하고 있다.

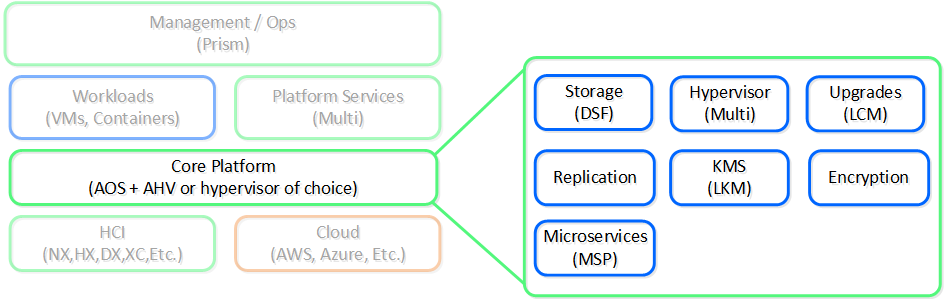

다음은 AOS 핵심 플랫폼에 대한 하이-레벨 뷰를 보여준다.

뉴타닉스 플랫폼 - AOS 코어 (Nutanix Platform - AOS Core)

뉴타닉스 플랫폼 - AOS 코어 (Nutanix Platform - AOS Core)

수년에 걸쳐 이것은 자체 하이퍼바이저(AHV)를 도입하고, 업그레이드를 단순화하고, 보안 및 암호화와 같은 다른 필수 서비스의 제공함으로써 가상화의 추상화(이것은 시스템의 일부이고 투명해야 함)로 확장되었다.

이러한 기능으로 우리는 많은 인프라 수준 문제를 해결했지만 거기서 멈추지 않았다. 사람들은 여전히 파일 공유, 오브젝트 스토리지 또는 컨테이너와 같은 추가 서비스가 필요했다.

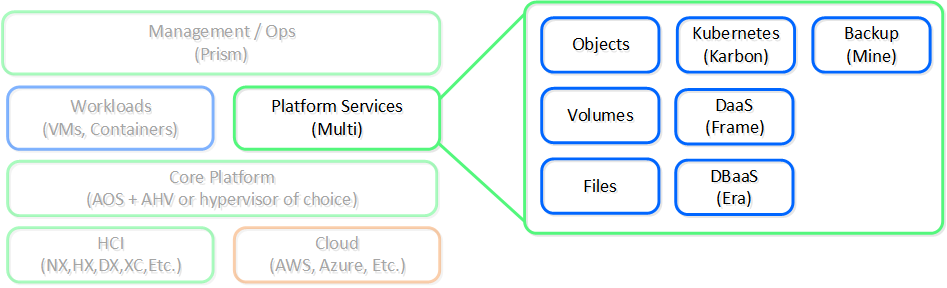

고객에게 일부 서비스에 대해 다른 벤더 및 제품을 사용하도록 요구하기보다 뉴타닉스는 파트너가 해야 하는 것과 뉴타닉스가 구축해야 하는 것을 파악했다. 백업을 위해서는 Veeam 및 HYCU와 같은 벤더와 파트너 관계를 맺고, 파일 및 오브젝트 서비스 등과 같은 서비스는 뉴타닉스 플랫폼에 서비스로 구축했다.

다음은 뉴타닉스 플랫폼 서비스에 대한 하이-레벨 뷰를 보여준다.

뉴타닉스 플랫폼 - 서비스 (Nutanix Platform - Services)

뉴타닉스 플랫폼 - 서비스 (Nutanix Platform - Services)

프리즘: “인터페이스”

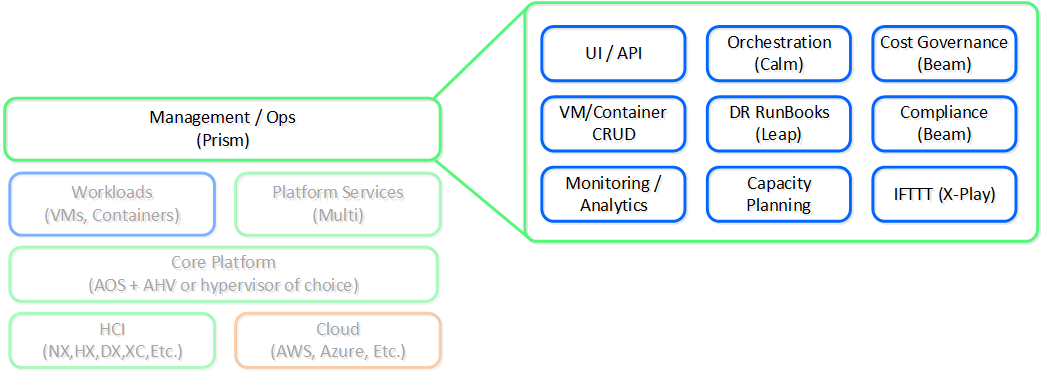

뉴타닉스 플랫폼 - 프리즘 (Nutanix Platform - Prism)

뉴타닉스 플랫폼 - 프리즘 (Nutanix Platform - Prism)

간단히 말해, 간단함, 일관성 및 직관성에 중점을 둔 Apple과 같은 회사에서 개발한 일부 디자인 원칙을 적용한다. 처음부터 우리는 뉴타닉스 제품의 "프런트 엔드"에 상당한 시간과 노력을 투자했다. UI/UX 및 디자인 팀은 항상 선두에 있었다. 예를 들어, 뉴타닉스는 관리 UI를 HTML5로 작성한 최초의 엔터프라이즈 소프트웨어 회사 (SaaS 플레이어 제외) 중 하나였다.

여기서 또 다른 핵심 항목은 플랫폼에 단일 인터페이스를 제공하고 그 경험을 일관되게 유지하는 데 중점을 두는 것이다. 우리의 목표는 인프라를 컨버지드 한 것처럼 UI를 컨버지드 하는 것이다. 우리는 프리즘이 데이터센터에서 가상화 관리, 클라우드에서 DaaS 서비스 관리, 또는 비용 가시성 제공 등의 여부에 관계없이 뉴타닉스 플랫폼을 관리하고 소비할 수 있는 단일 인터페이스가 되기를 원한다.

이는 뉴타닉스가 기능/서비스 생성 및 획득을 통해 플랫폼을 계속 확장할 것이기 때문에 매우 중요하다. 새로운 기능을 강화하는 대신 플랫폼에 기본적으로 통합하는 데 시간을 투자하고 있다. 이를 위한 프로세스는 매우 느린 속도로 진행되지만 장기적으로는 일관된 경험을 유지하고 위험을 줄여준다.

뉴타닉스: 플랫폼

요약하면 뉴타닉스의 비전은 간단하다다: "하나의 플랫폼, 모든 앱, 모든 로케이션". 본 이미지를 제공해 주신 마케팅 팀에 감사드린다. 이것은 완벽하게 맞고 뉴타닉스의 목적을 간결하게 표현한다.

뉴타닉스 플랫폼 - 아키텍처 (Nutanix Platform - Architecture)

뉴타닉스 플랫폼 - 아키텍처 (Nutanix Platform - Architecture)

이것은 처음부터 끝까지 우리의 목표였다. 이에 대한 증거로, 아래는 뉴타닉스 플랫폼 아키텍처에 대해 설명하기 위해 2014년경에 생성된 이미지이다. 크게 변하지 않은 것을 알 수 있듯이 뉴타닉스는 계속 확장하고 이 목표를 향해 노력하고 있다.

뉴타닉스 플랫폼 - Circa 2014 (Nutanix Platform - Circa 2014)

뉴타닉스 플랫폼 - Circa 2014 (Nutanix Platform - Circa 2014)

제품 및 플랫폼

수년에 걸쳐 뉴타닉스 플랫폼 기능 세트 및 포트폴리오가 크게 성장했다. 수년에 걸쳐 가상화를 단순화 및 추상화하고, 업그레이드 및 운영을 자동화하는 등 다양한 작업을 수행했다. 이 섹션에서는 현재 포트폴리오 및 파트너십을 다룬다. NOTE: 최신 포트폴리오 및 오퍼링에 대해서는 뉴타닉스 웹 페이지를 참조한다.

제품에 대해 이야기하기 보다 수년 동안 제품 포트폴리오가 성장함에 따라 오히려 결과 및 그것을 달성하기 위한 여정에 초점을 맞추고자 한다. 다음 단계에서 고객의 "여정(Journey)"과 뉴타닉스가 고객이 그것을 달성할 수 있도록 도와준 결과에 대해 다룬다.

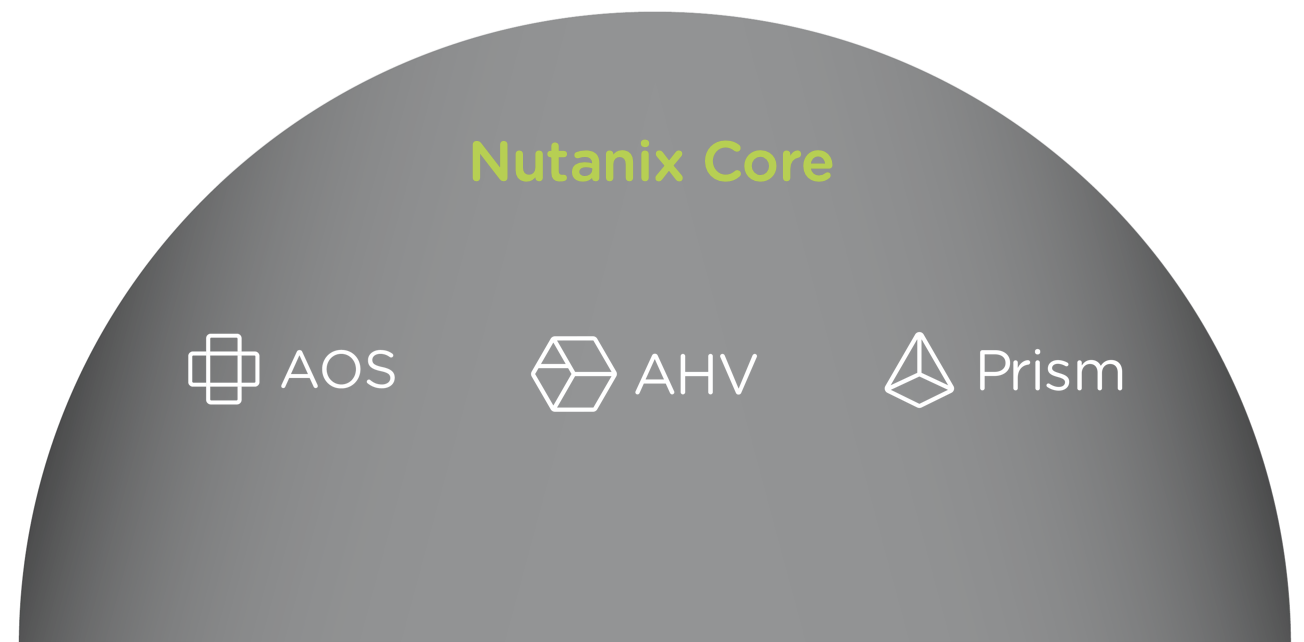

1단계: 데이터센터 현대화 (Core: 코어)

코어(Core)는 복잡한 3-티어 인프라에서 간단한 HCI 플랫폼으로의 마이그레이션을 용이하게 하는 기본 뉴타닉스 제품을 포함한다. AOS는 모든 핵심 서비스(스토리지, 업그레이드, 복제 등)를 제공하고, 프리즘(Prism)은 컨트롤 플레인 및 관리 콘솔을 제공하며, AHV는 무료 가상화 플랫폼(NOTE: ESXi 및 Hyper-V를 사용할 수 있음)을 제공한다.

코어(Core) 기능은 다음을 포함한다.

- 핵심 플랫폼 (HCI)

- 스토리지 서비스

- 가상화

- 중앙 집중식 관리 및 운영

- 업그레이드

- 복제 / DR

제품 에코시스템 - 코어 (Products Ecosystem - Core)

제품 에코시스템 - 코어 (Products Ecosystem - Core)

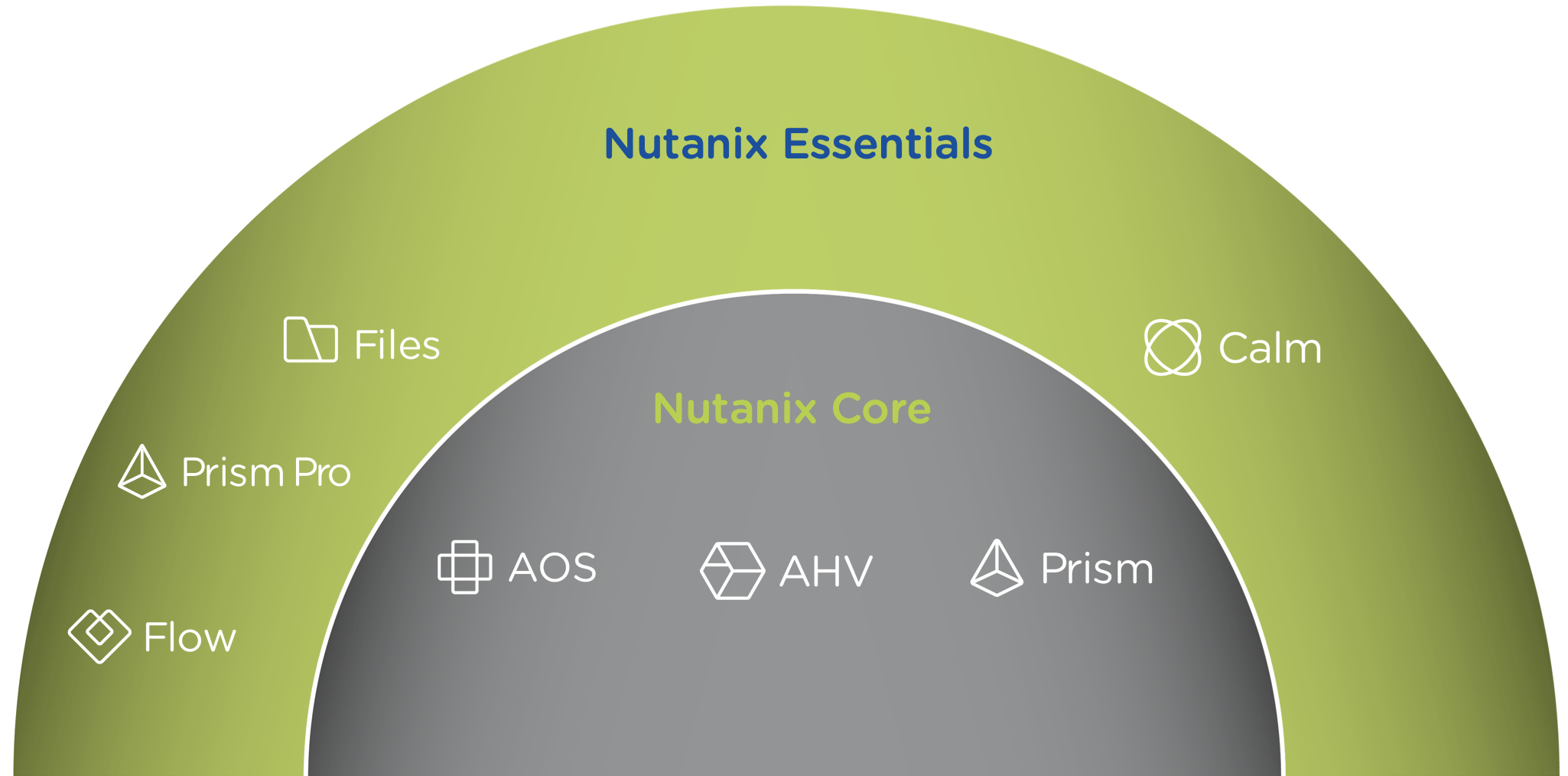

2단계: 프라이빗 클라우드 지원 (Essentials: 에센셜)

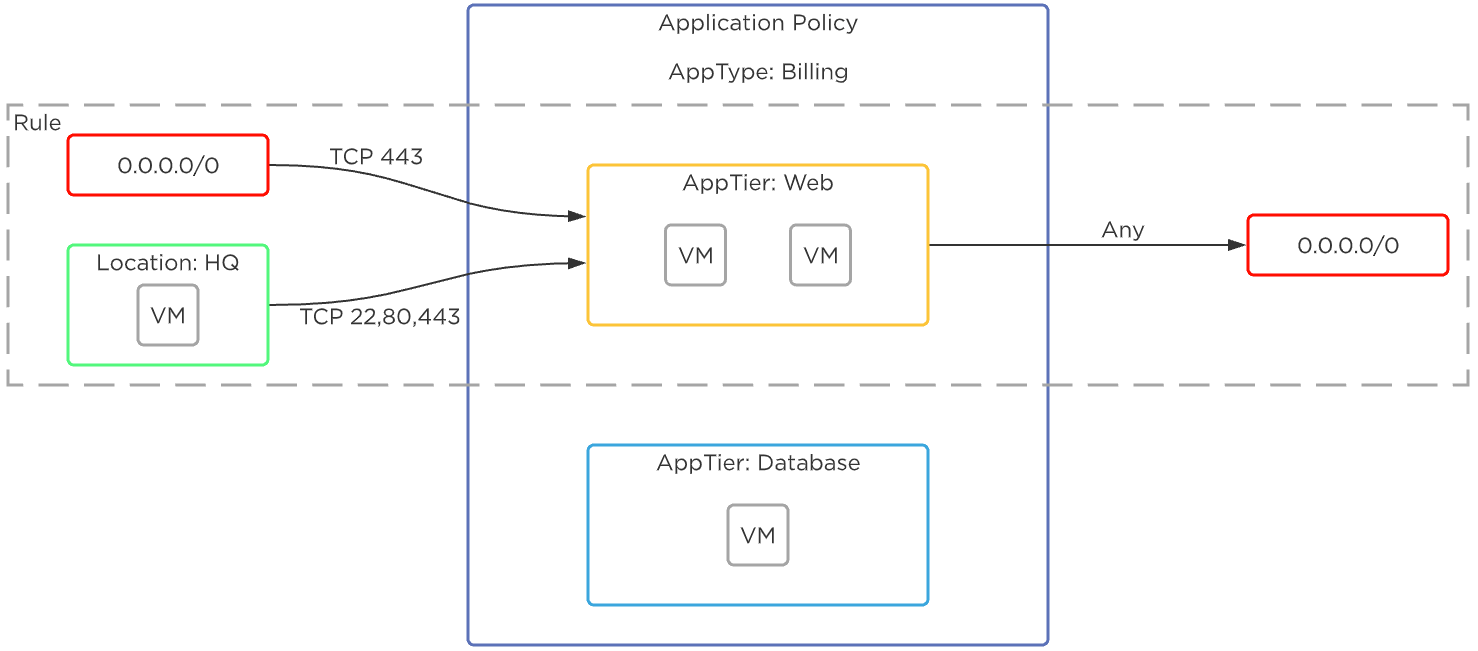

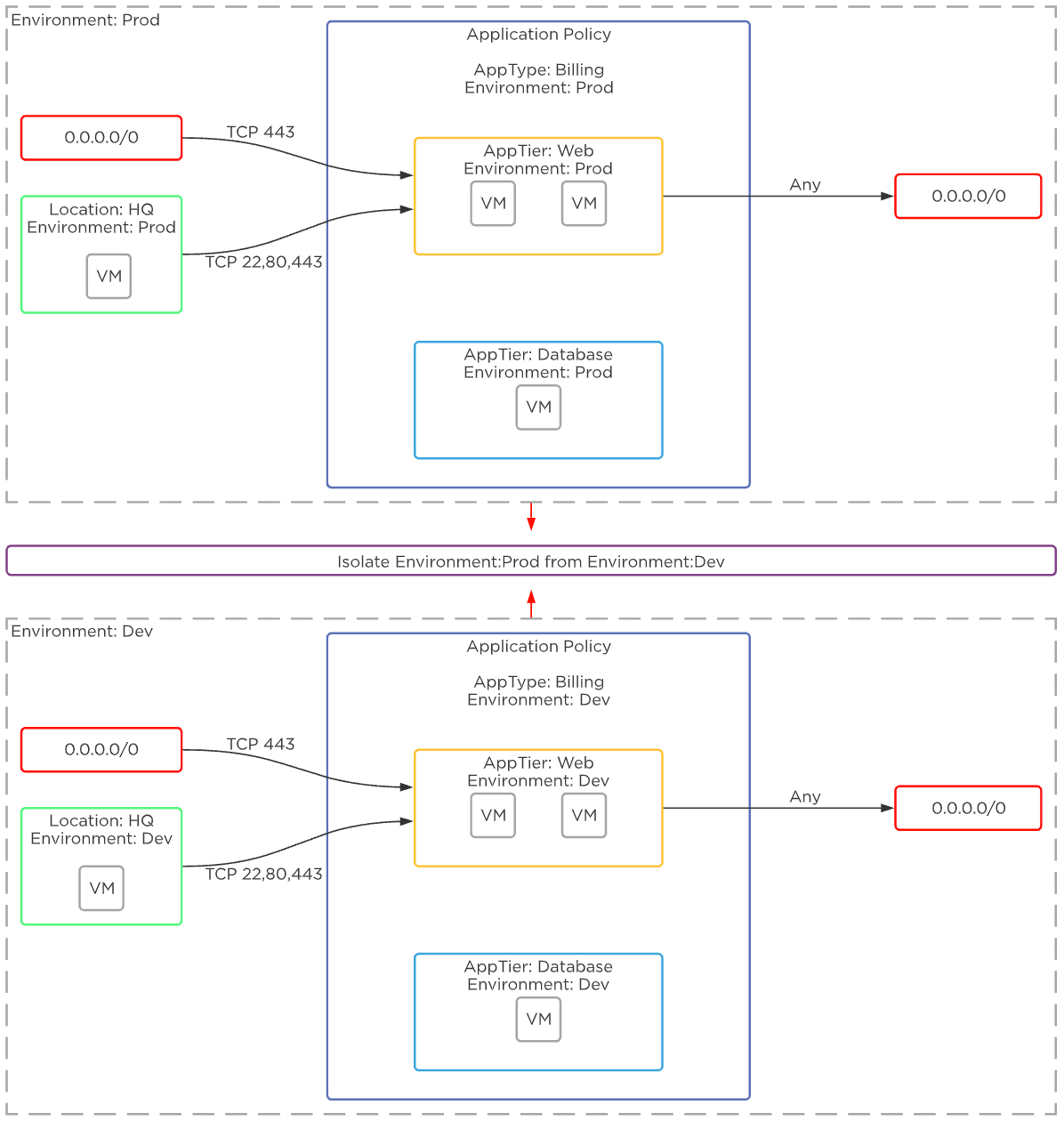

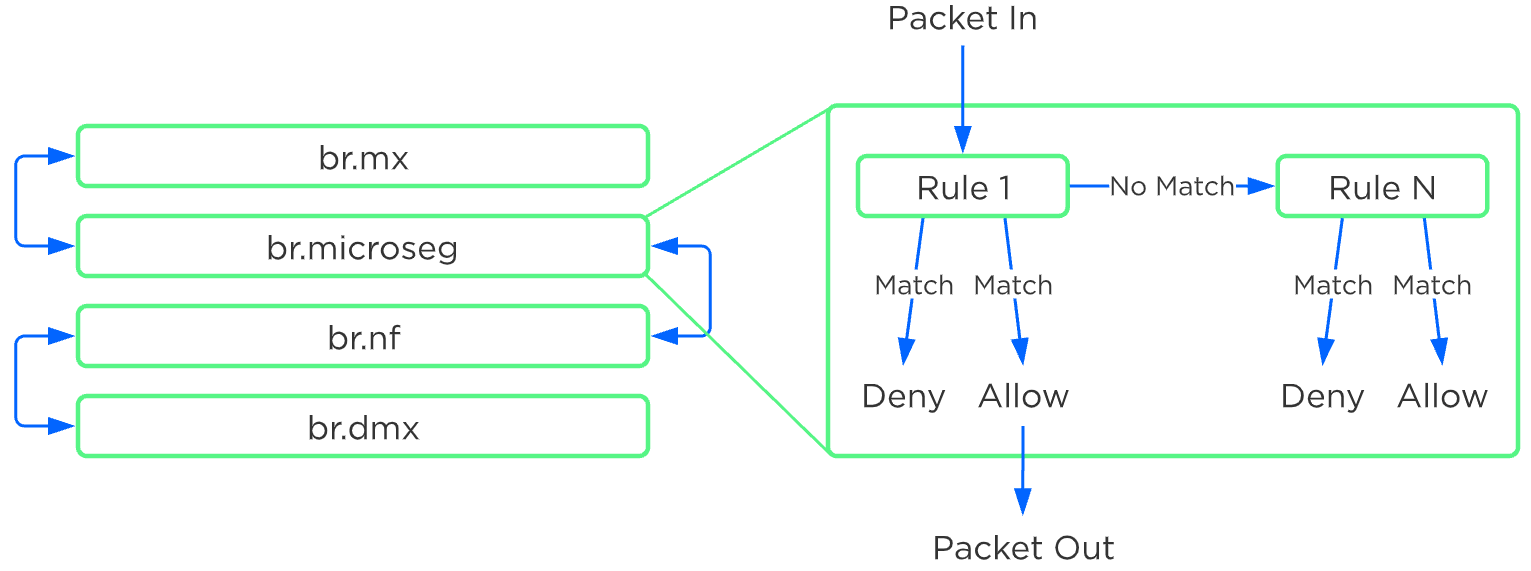

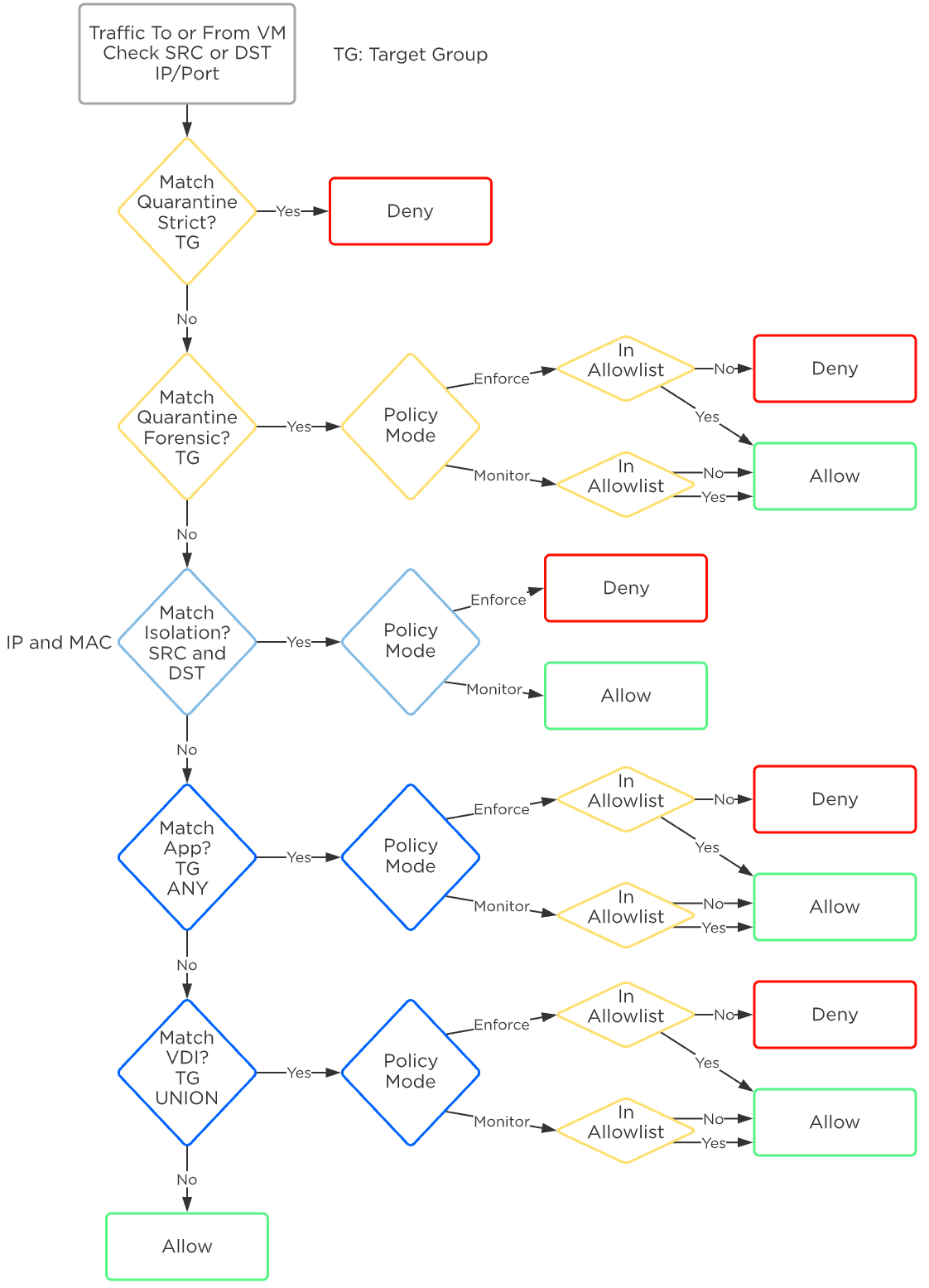

에센셜(Essentials)은 핵심 인프라를 프라이빗 클라우드처럼 사용할 수 있는 기능을 제공하는 데 중점을 둔다. Flow는 네트워크 세그멘테이션 및 보안 기능을 제공하고, Files는 파일 서비스를 제공하며, Calm은 셀프서비스, 쿼터 및 오케스트레이션 기능을 제공한다.

에센셜(Essentials) 기능은 다음을 포함한다.

- 고급 분석 및 이상 징후 탐지

- 자동화 및 오케스트레이션

- 셀프서비스 포탈 및 쿼터

- 마이크로세그멘테이션

- 파일 서비스

제품 에코시스템 - 프라이빗 클라우드 (Products Ecosystem - Private Cloud)

제품 에코시스템 - 프라이빗 클라우드 (Products Ecosystem - Private Cloud)

3단계: 하이브리드 클라우드 지원 (Enterprise: 엔터프라이즈)

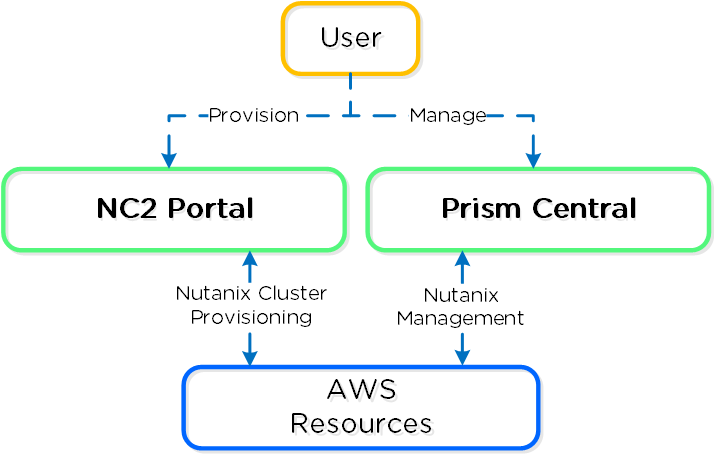

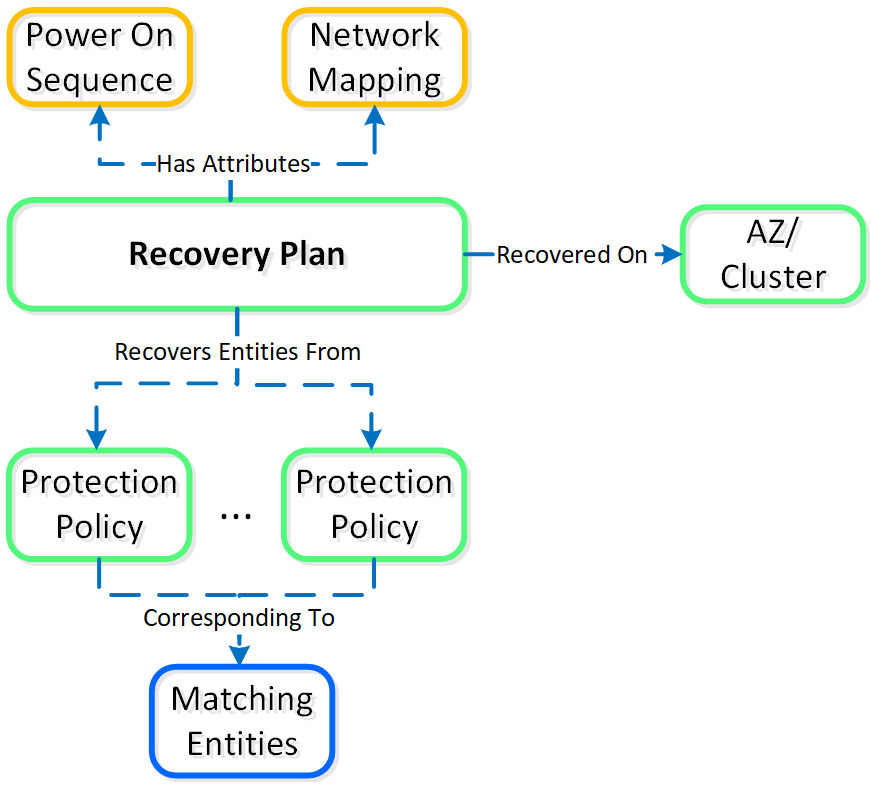

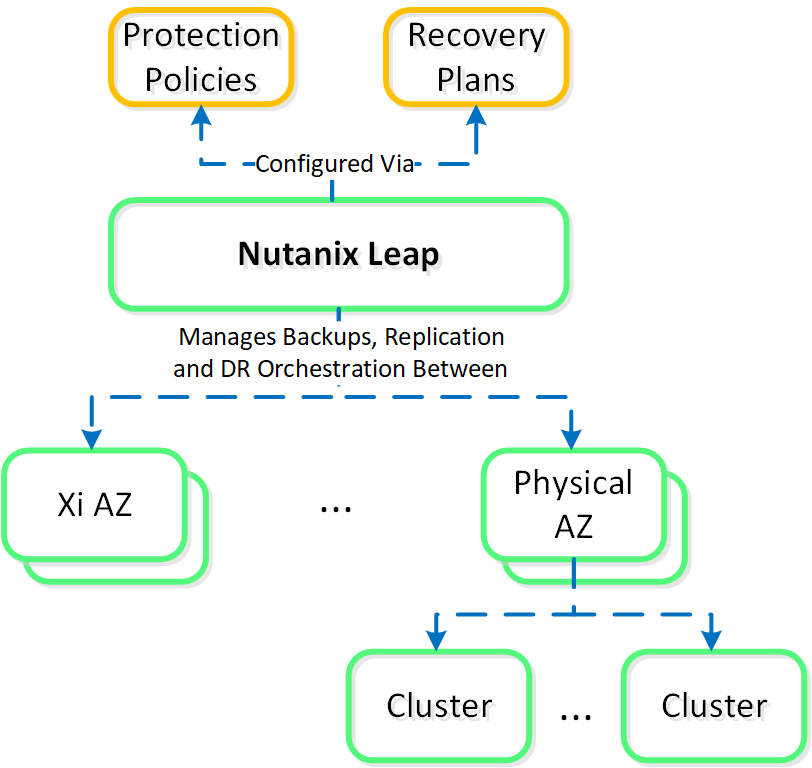

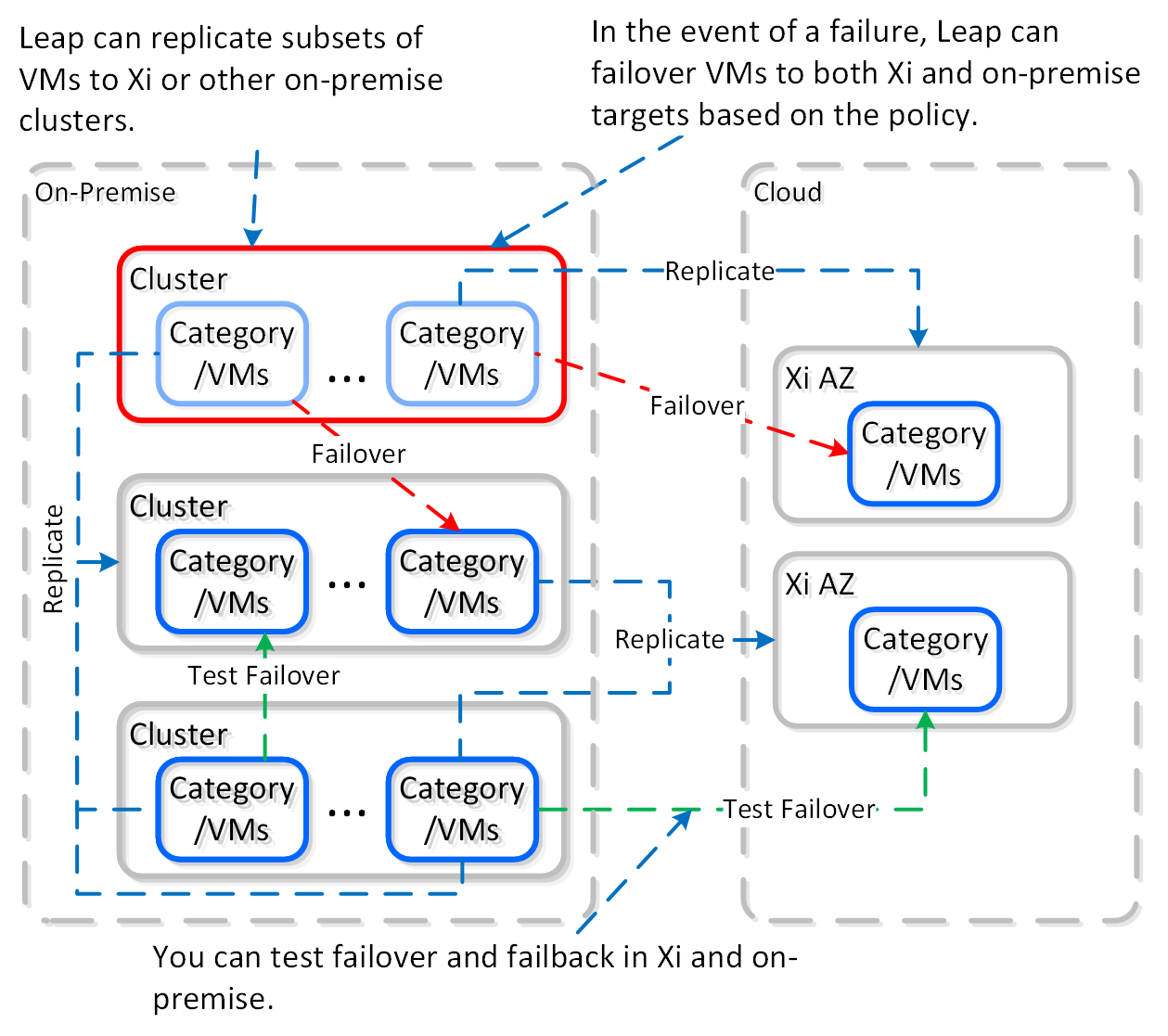

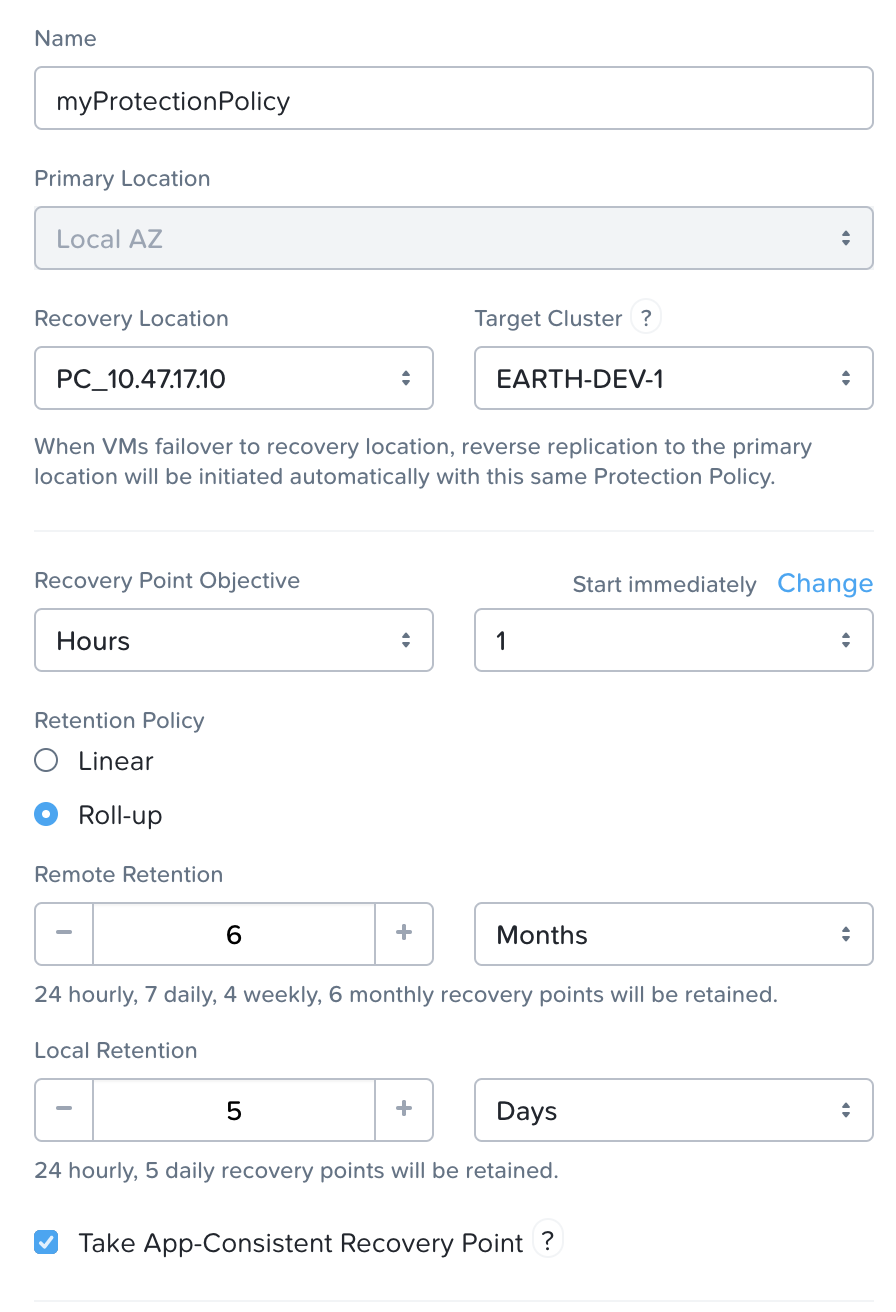

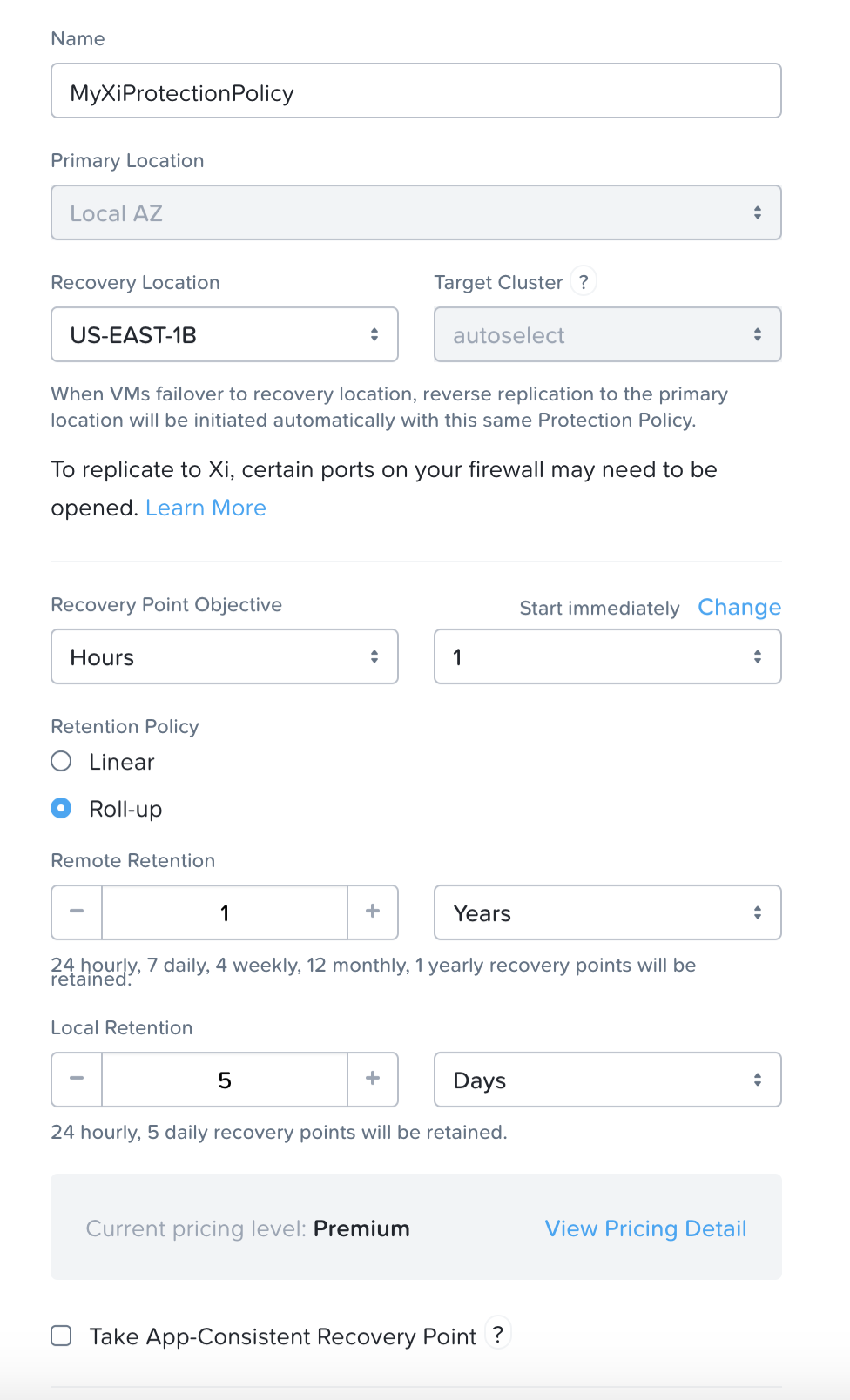

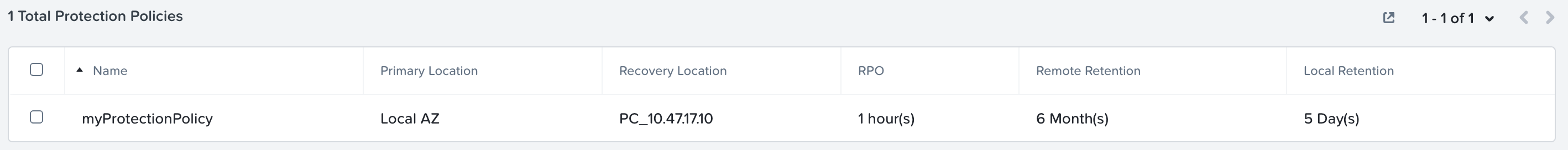

엔터프라이즈(Enterprise)는 클라우드와 클라우드 서비스 간의 워크로드 마이그레이션 기능을 제공하는 데 중점을 둔다. 여기에는 클라우드와 온-프레미스 배포에서 비용 거버넌스 및 컴플라이언스 기능을 제공하는 Beam 뿐만 아니라 Frame(DaaS), Xi Leap(DRaaS) 등과 같은 다른 클라우드 서비스가 포함된다.

엔터프라이즈(Enterprise) 기능은 다음을 포함한다.

- 정책 기반 DR / 런북 자동화

- DRaaS

- 하이브리드 클라우드 비용 거버넌스 및 컴플라이언스

- Desktops As-A-Service (DaaS)

- Database As-A-Service (RDS)

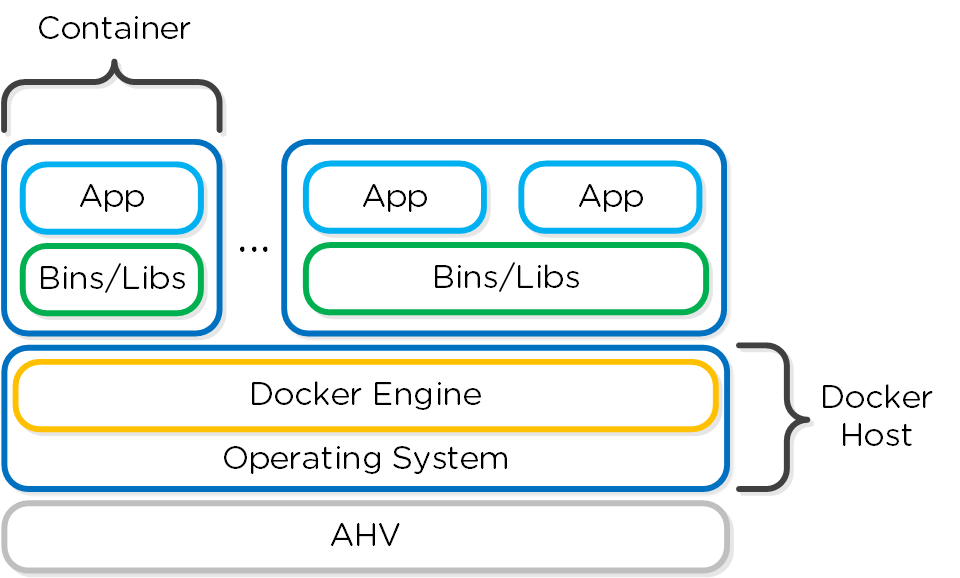

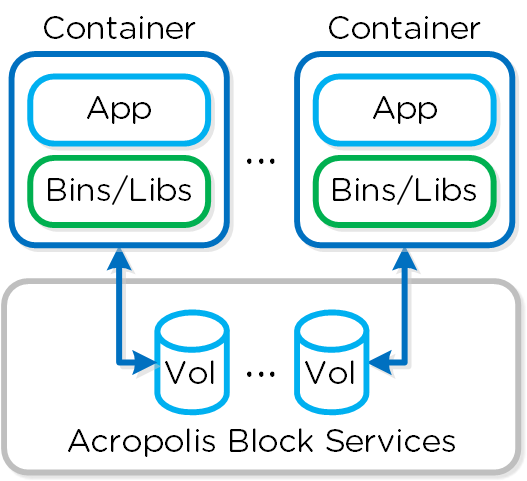

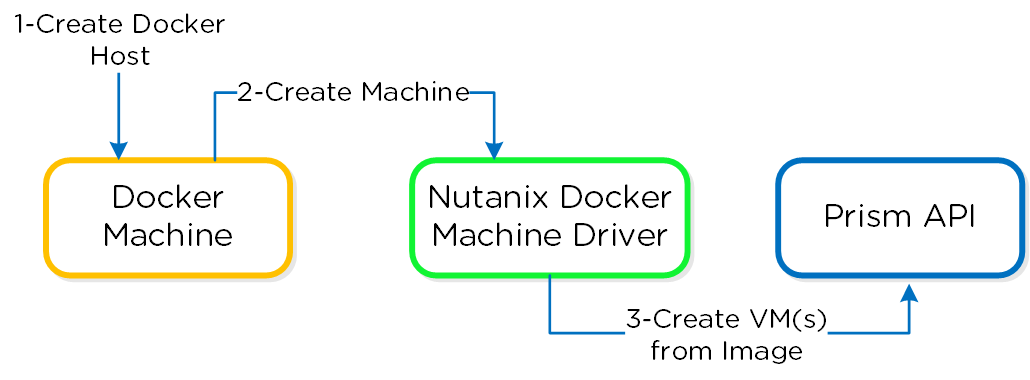

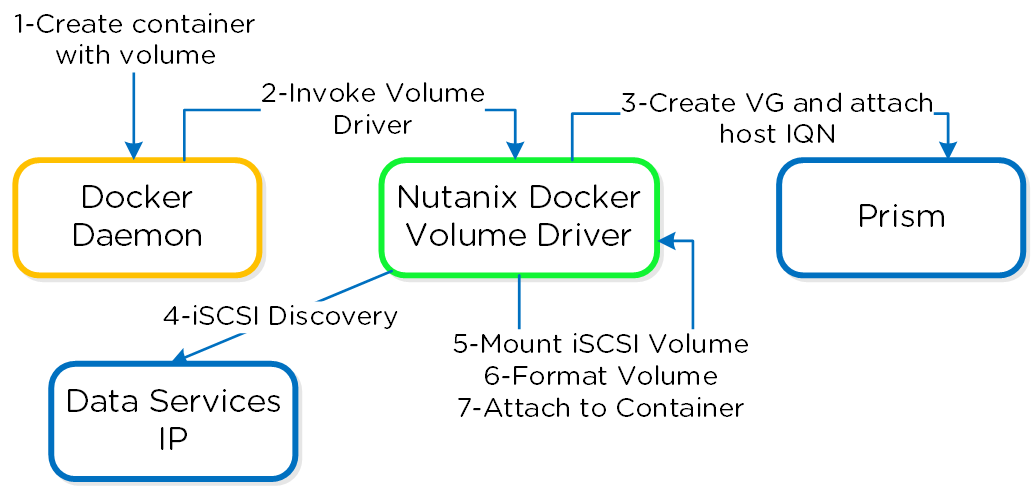

- 쿠버네티스 / 도커 서비스

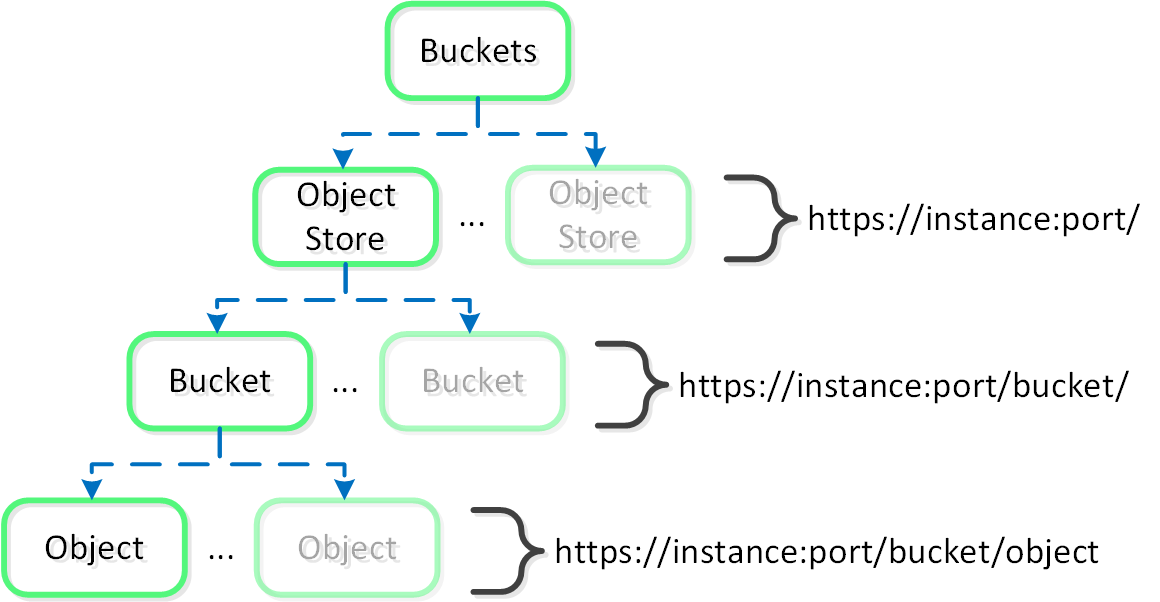

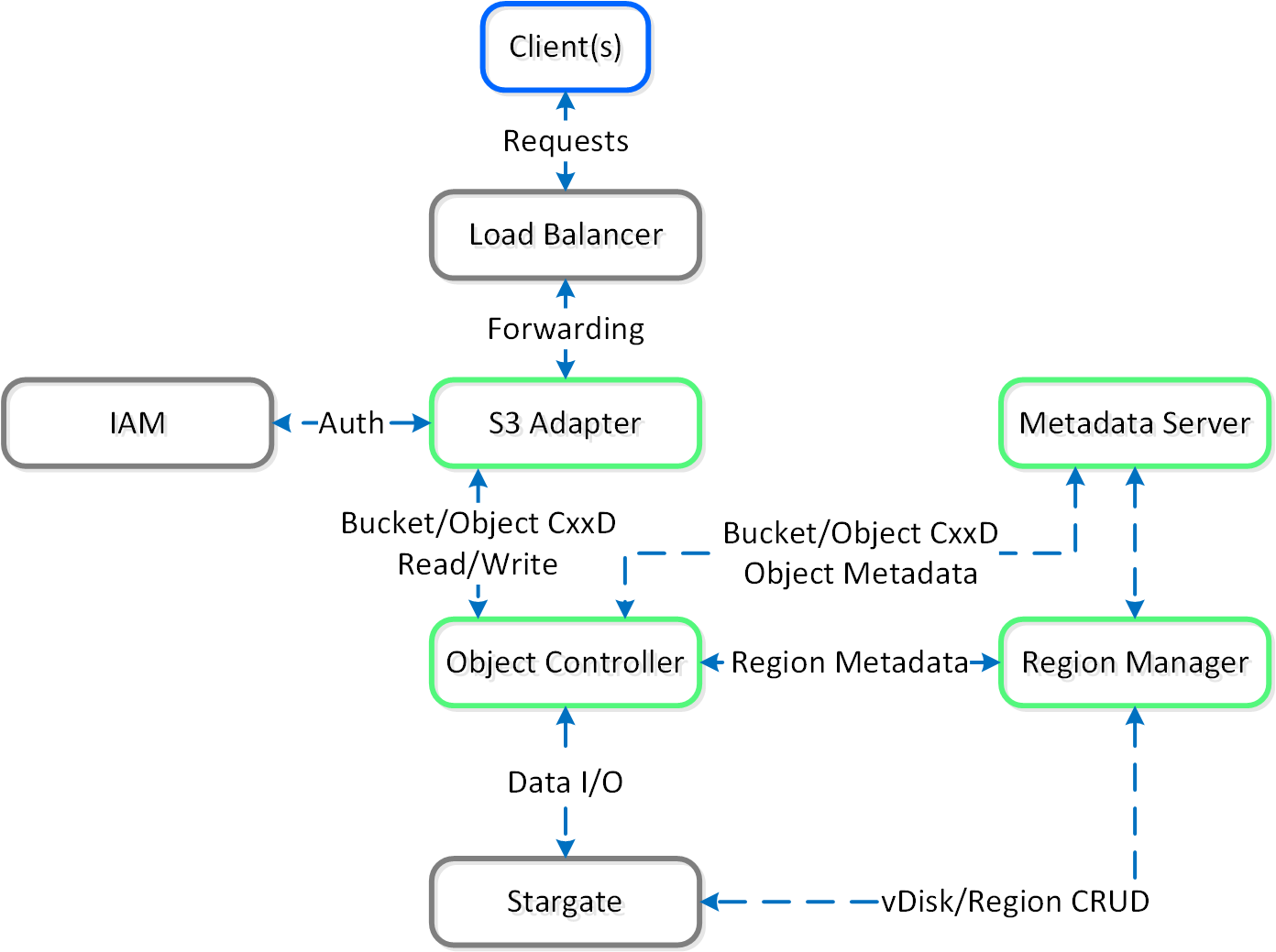

- 오브젝트 스토리지

- 블록 서비스

제품 에코시스템 - 하이브리드 클라우드 (Products Ecosystem - Hybrid Cloud)

제품 에코시스템 - 하이브리드 클라우드 (Products Ecosystem - Hybrid Cloud)

플랫폼

뉴타닉스는 현재 다음 플랫폼을 지원한다.

- 뉴타닉스 어플라이언스 (Nutanix Appliance)

- NX (Supermicro)

- OEM 어플라이언스 (OEM Appliance)

- Nutanix on HPE ProLiant DX

- Nutanix on Lenovo HX

- Nutanix on Fujitsu XF

- Nutanix on Dell XC

- Nutanix on Inspur InMerge

- 3rd 파티 서버 지원 (Third-Party Server Support)

- Nutanix on HPE Apollo

- Nutanix on Cisco UCS

- Nutanix on Intel Data Center Blocks

- Nutanix Tactical and Ruggedized platforms on Klas

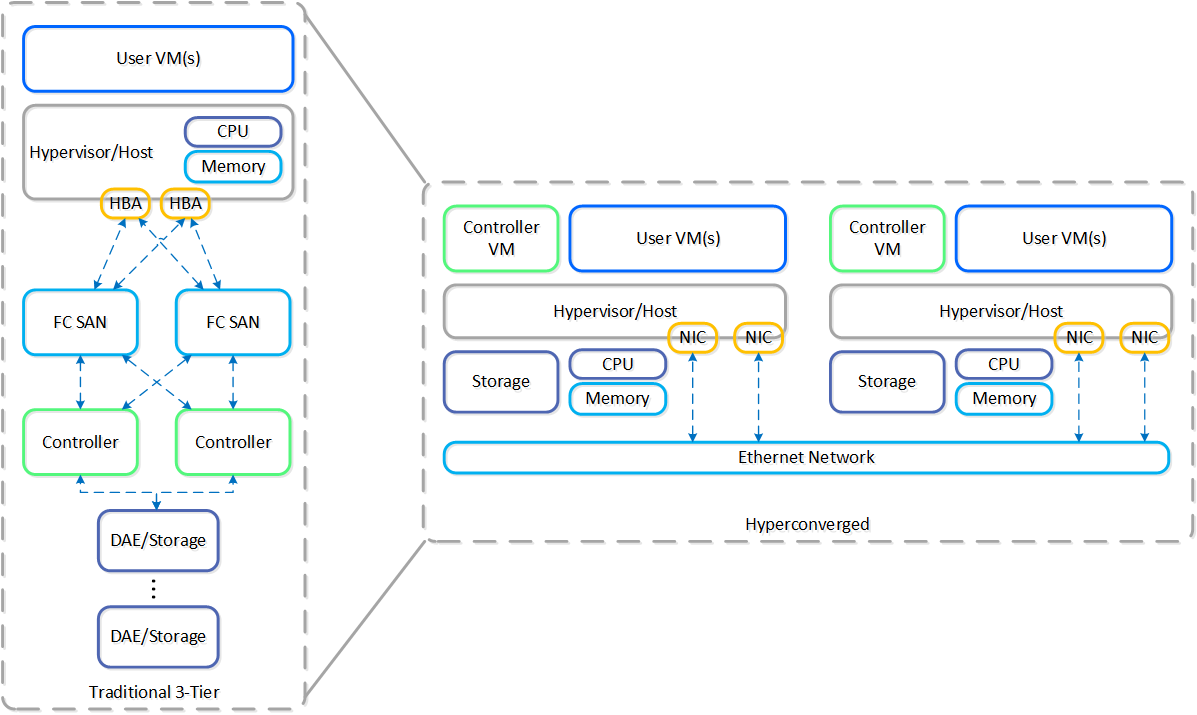

하이퍼컨버지드 플랫폼

동영상 시청을 원하시면 다음 링크를 클릭하세요: LINK

하이퍼컨버지드 시스템을 위한 몇 가지 핵심 컨스트럭트가 있다.

- 컴퓨팅 스택(e.g. 컴퓨트 + 스토리지)을 통합하고 단순화해야 한다.

- 시스템의 노드들 간에 데이터와 서비스를 분할(분산) 해야 한다.

- 중앙 집중식 스토리지와 동일한 기능(e.g. HA, 라이브 마이그레이션 등)을 제공해야 한다.

- 데이터를 가능한 한 실행(컴퓨트)과 가깝게 유지해야 한다 (레이턴시의 중요성).

- 하이퍼바이저와 무관해야 한다.

- 하드웨어와 무관해야 한다.

다음 그림은 일반적인 3-티어 스택과 하이퍼컨버지드 스택의 예를 보여준다.

3-티어 vs. HCI (3-Tier vs. HCI)

3-티어 vs. HCI (3-Tier vs. HCI)

보시다시피 하이퍼컨버지드 시스템은 다음을 수행한다.

- 컨트롤러를 가상화하여 호스트로 이동

- 소프트웨어를 통해 핵심 서비스 및 로직 제공

- 시스템의 모든 노드에 데이터 분산(분할)

- 스토리지를 컴퓨트의 로컬로 이동

뉴타닉스 솔루션은 워크로드를 실행하기 위해 로컬 컴포넌트를 활용하여 분산 플랫폼을 생성하는 "컴퓨트 + 스토리지"가 컨버지드 된 솔루션이다.

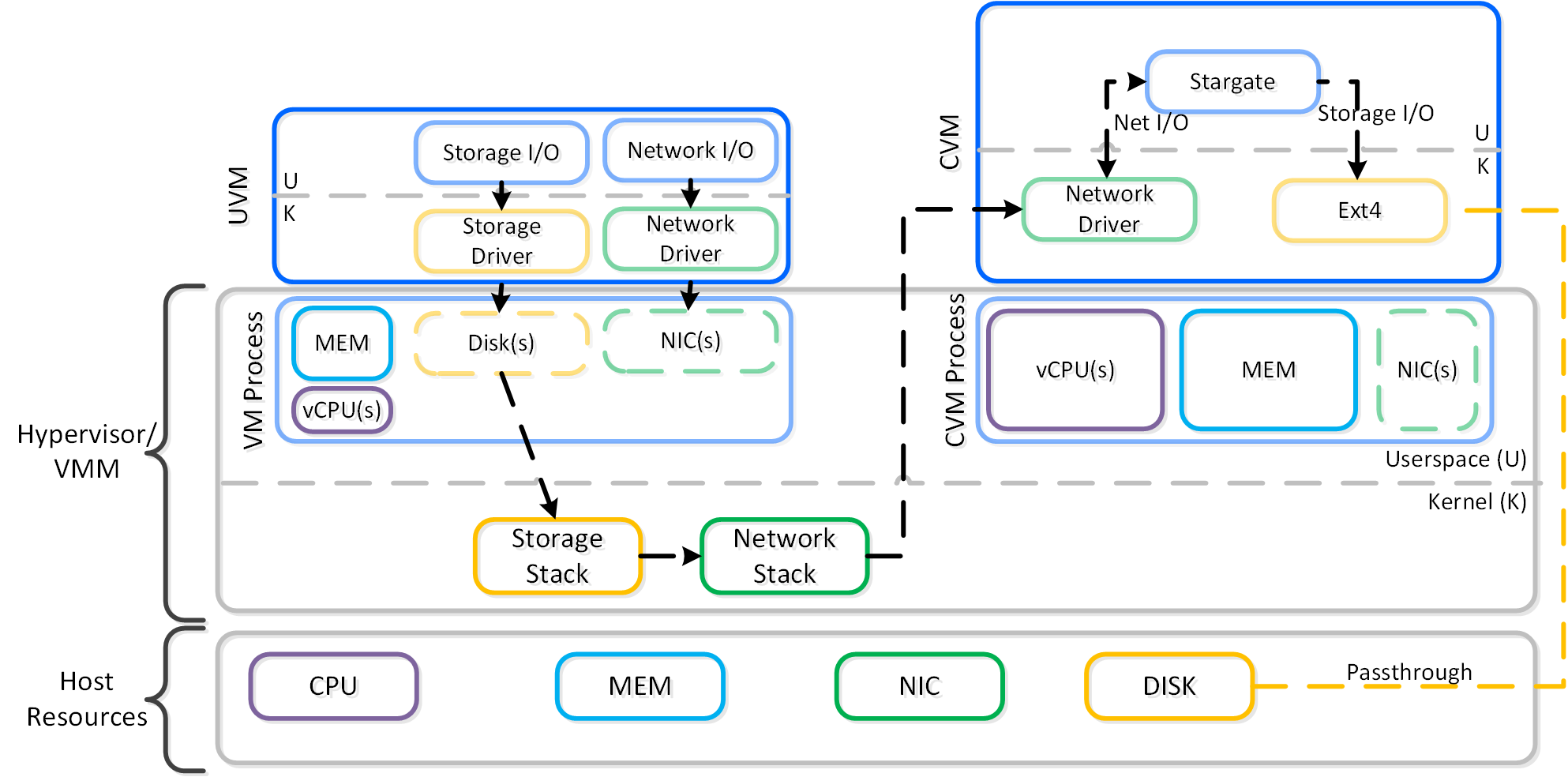

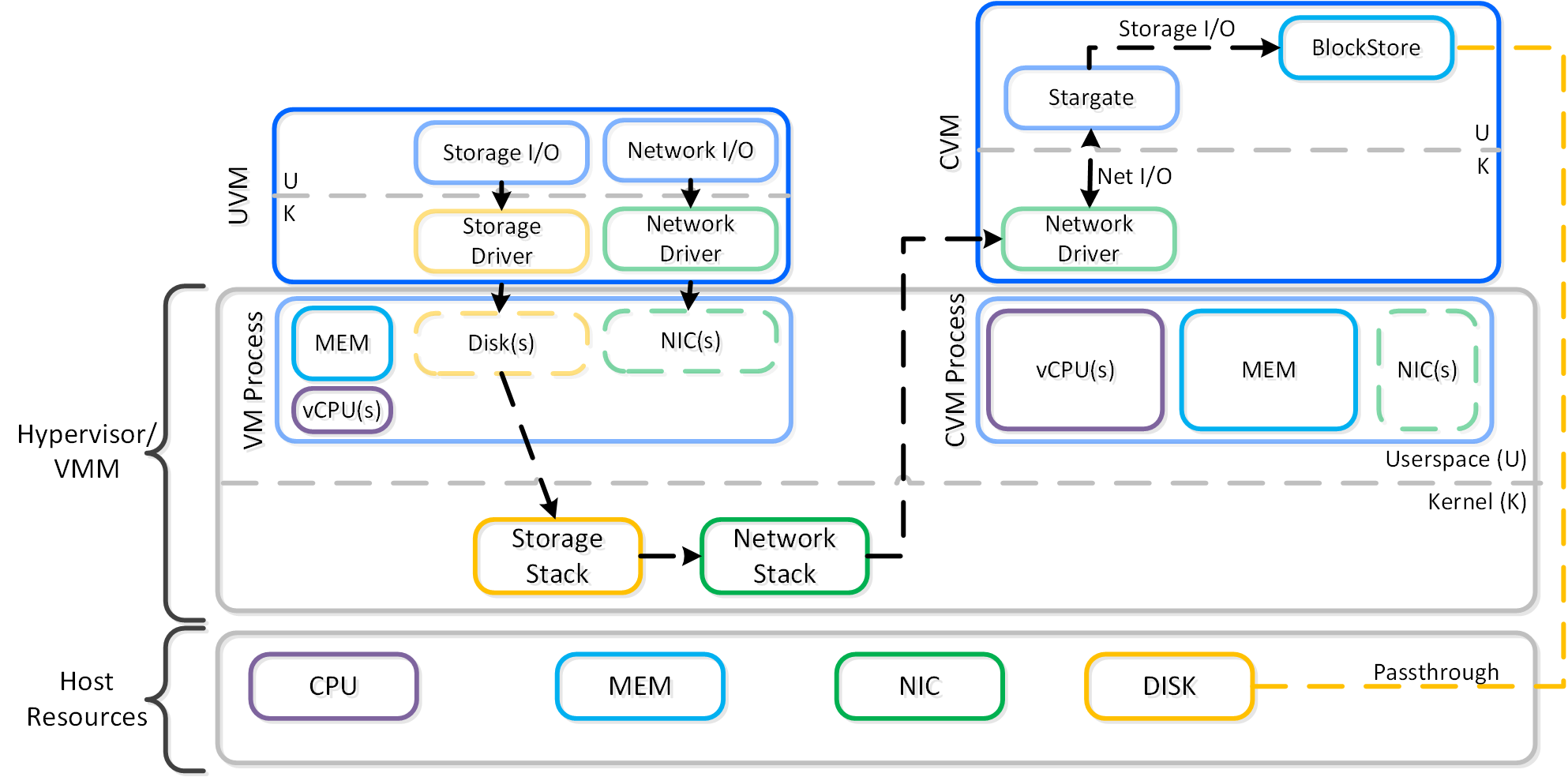

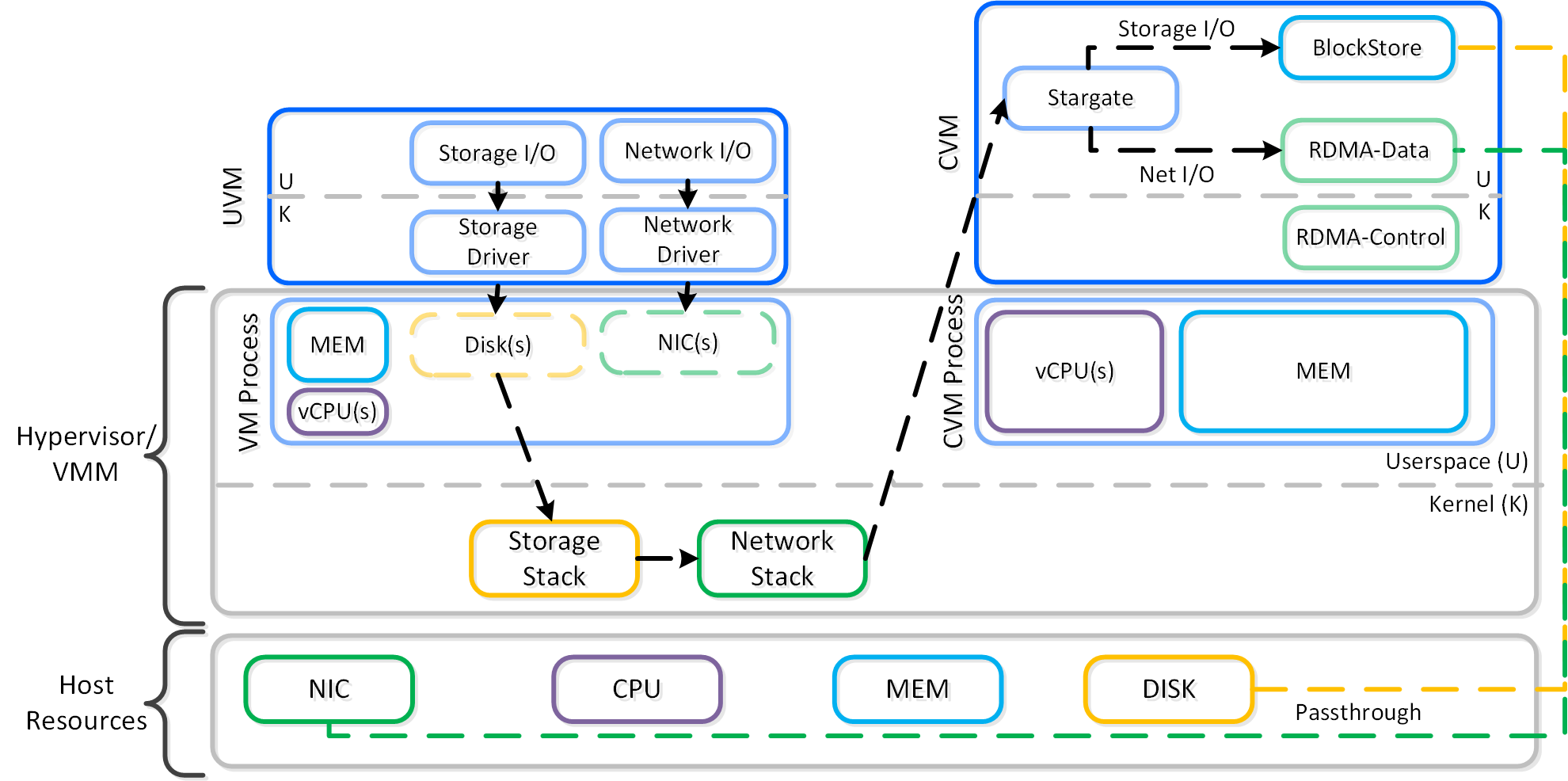

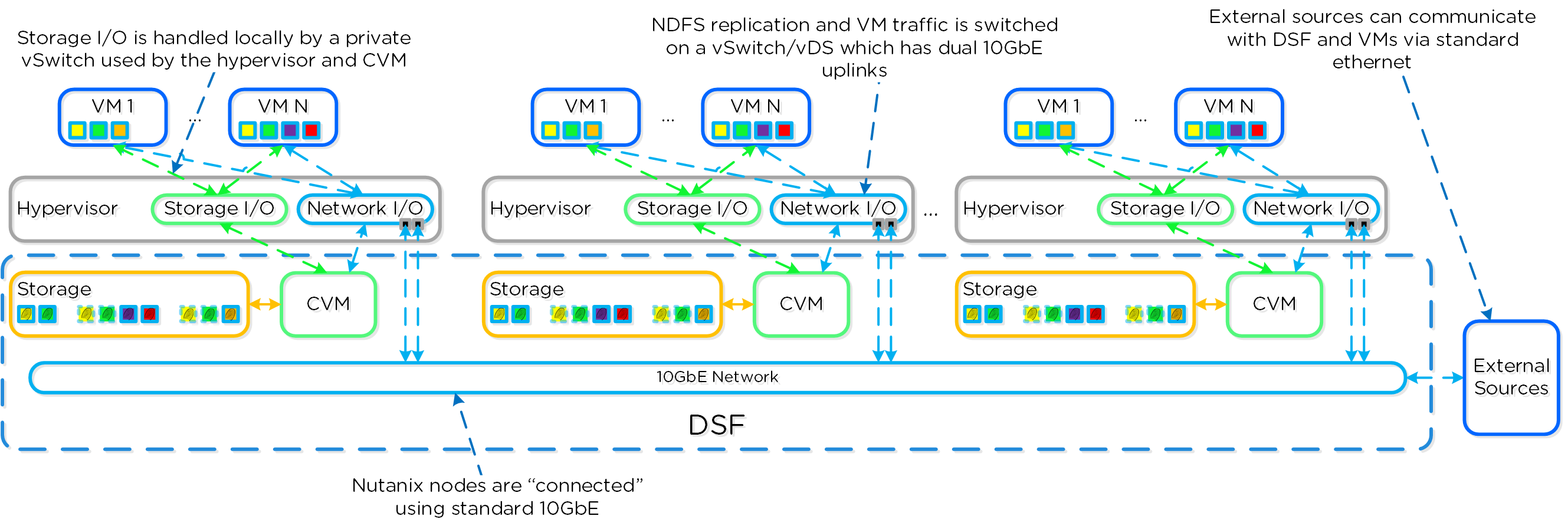

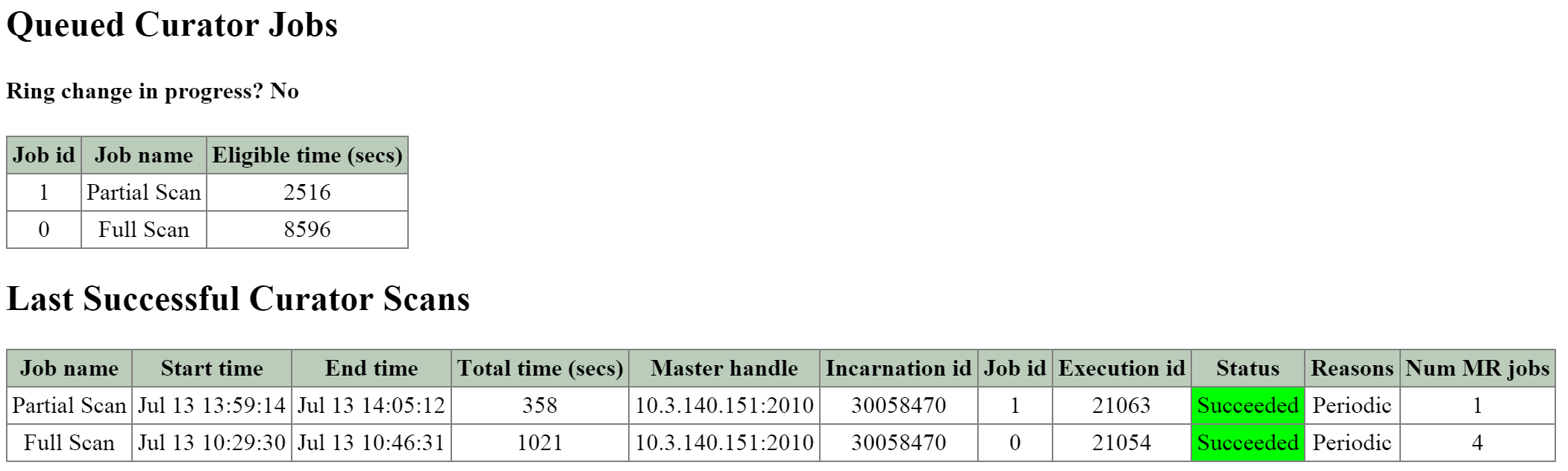

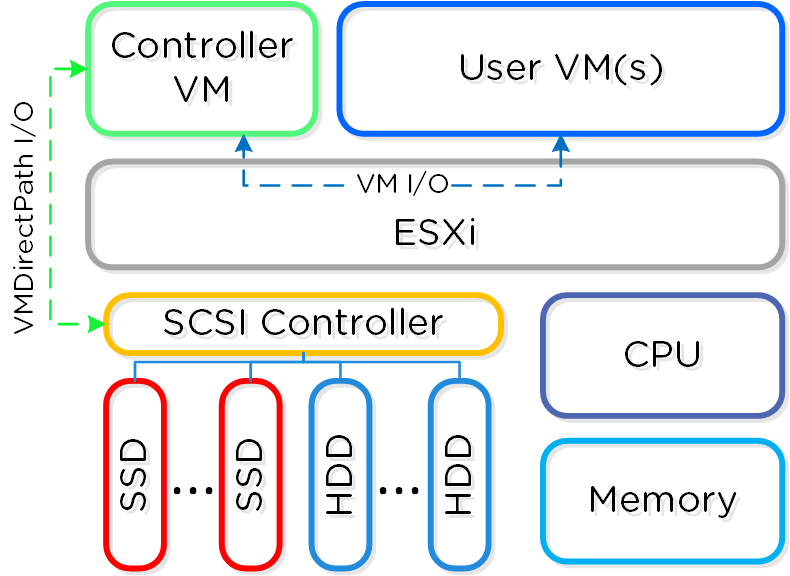

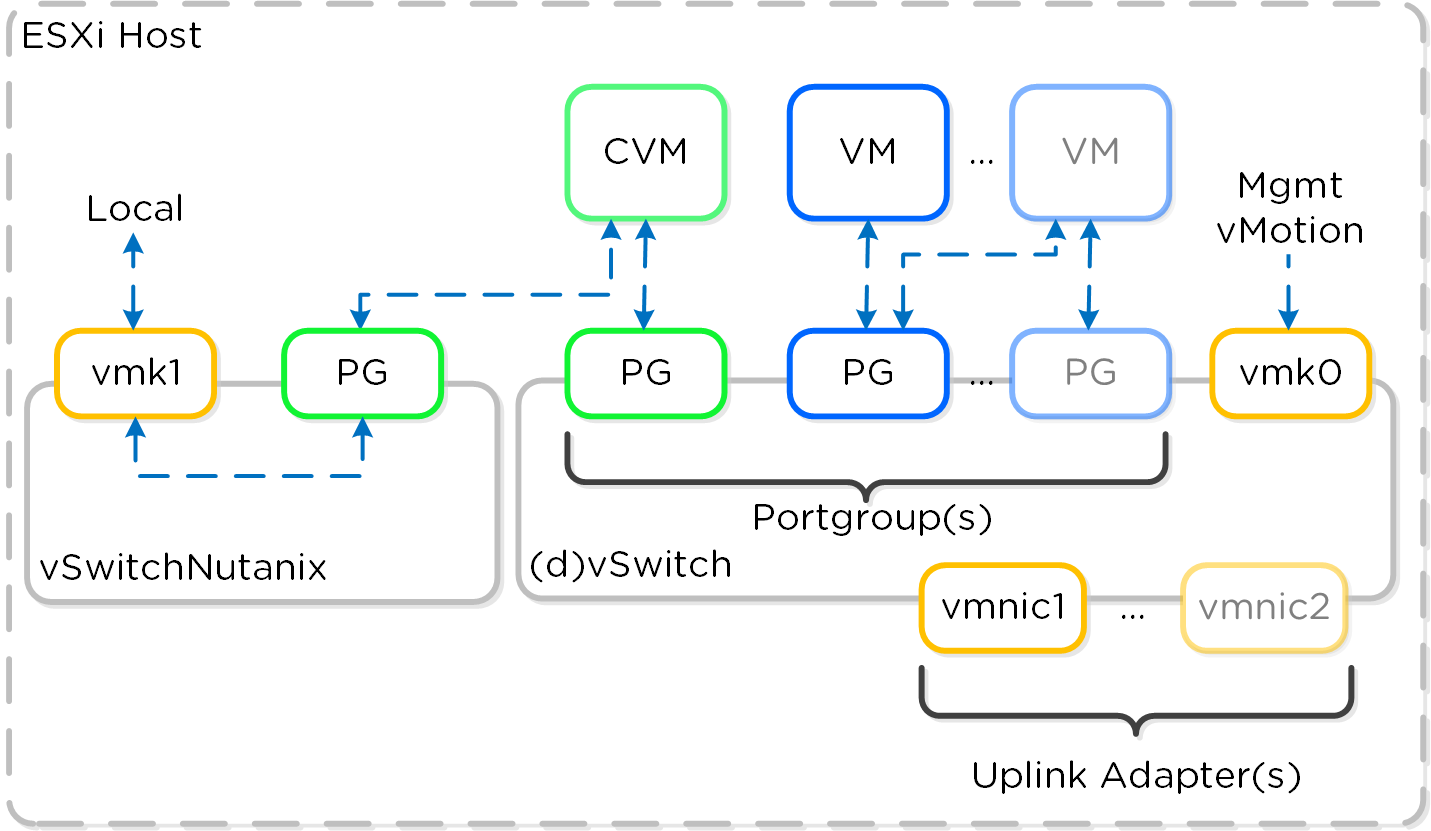

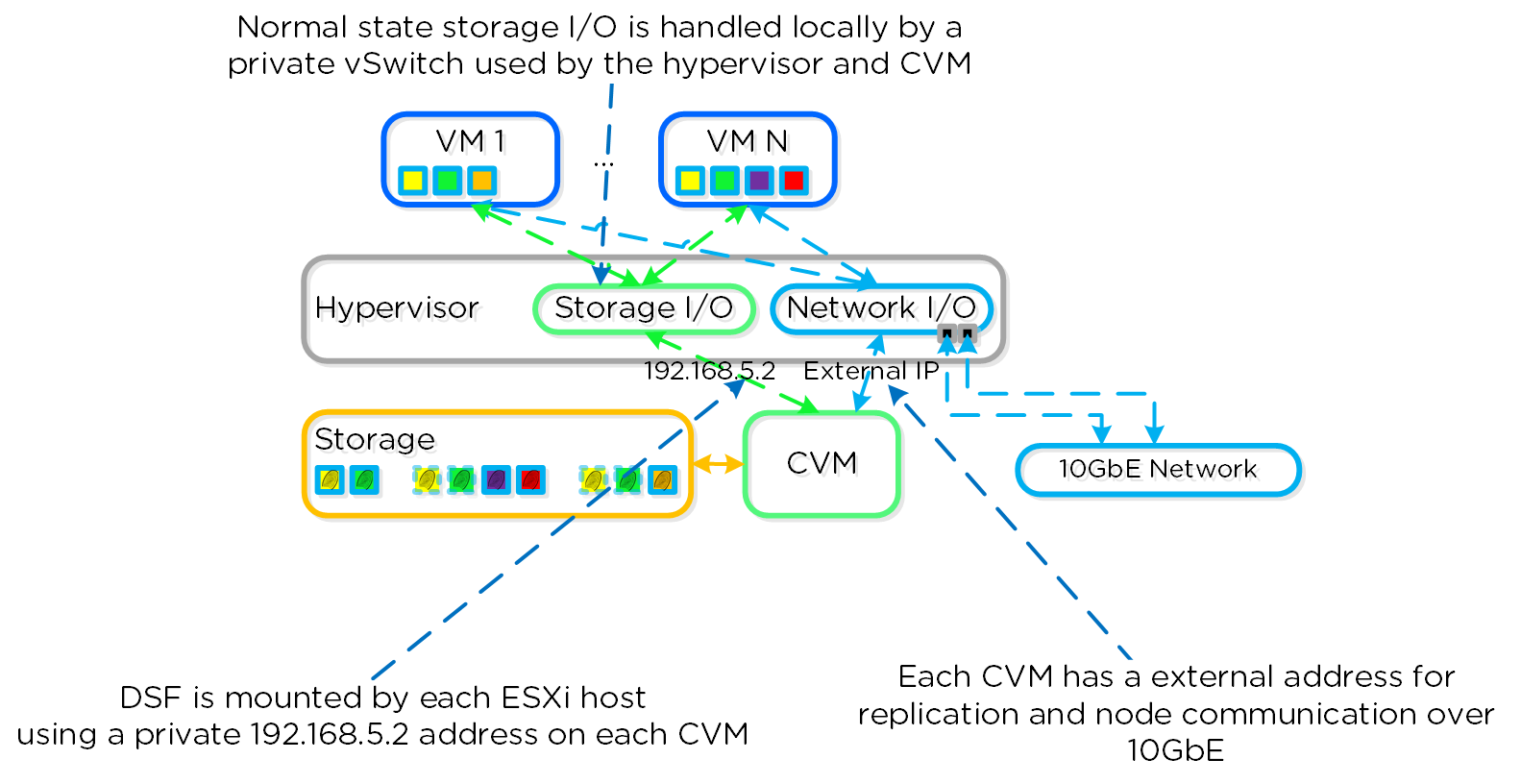

각 노드는 업계 표준 하이퍼바이저(현재 ESXi, AHV, Hyper-V) 및 뉴타닉스 컨트롤러 VM(Controller VM: CVM)을 실행한다. 뉴타닉스 CVM은 뉴타닉스 소프트웨어를 실행하고 해당 호스트에서 실행 중인 하이퍼바이저 및 모든 VM에게 모든 I/O 오퍼레이션 서비스를 제공한다.

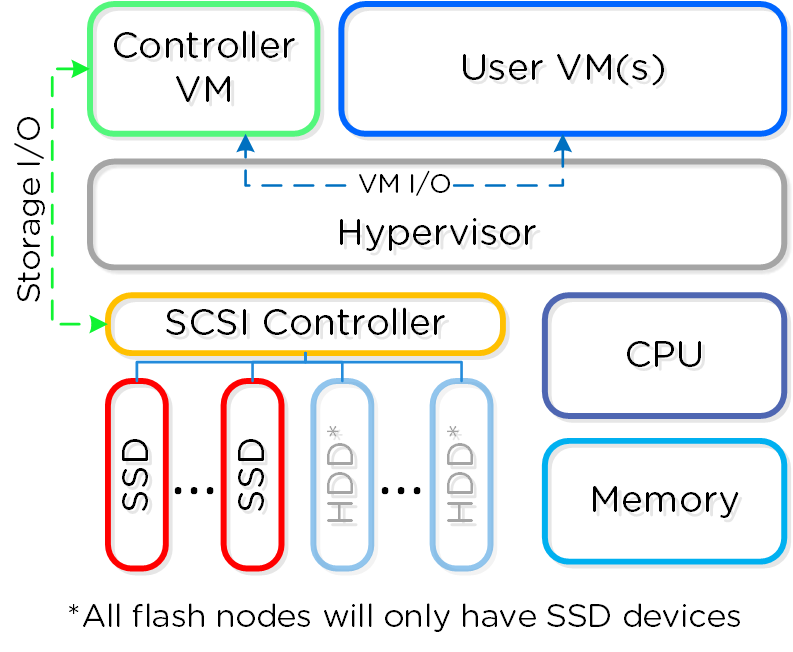

다음 그림은 일반적인 노드가 논리적으로 어떻게 보이는지에 대한 예를 제공한다.

컨버지드 플랫폼 (Converged Platform)

컨버지드 플랫폼 (Converged Platform)

뉴타닉스 CVM은 핵심 뉴타닉스 플랫폼 로직을 담당하며 다음과 같은 서비스를 처리한다.

- 스토리지 I/O 및 변환 (중복제거, 압축, Erasure Coding)

- UI / API

- 업그레이드

- DR / 복제

- 기타

NOTE: 일부 서비스/기능은 추가 헬퍼 VM을 생성하거나 MSP(Microservices Platform)를 사용한다. 예를 들어 뉴타닉스 파일(Files)은 추가 VM을 배포하는 반면 뉴타닉스 오브젝트(Objects)는 MSP 용 VM을 배포하고 이를 활용한다.

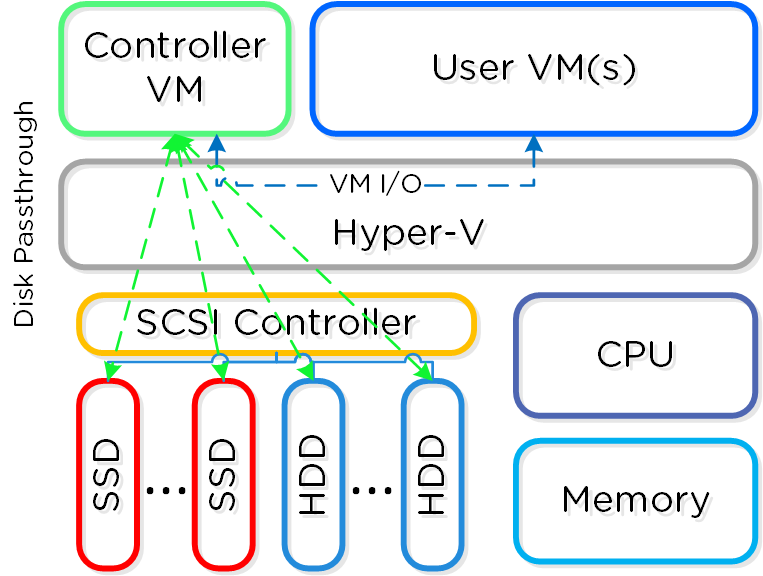

VMware vSphere를 실행하는 뉴타닉스 유닛의 경우 SSD 및 HDD 디바이스를 관리하는 SCSI 컨트롤러는 VM-Direct 경로(인텔 VT-d)를 활용하는 CVM으로 직접 전달된다. Hyper-V의 경우 스토리지 디바이스는 CVM으로 전달된다.

Note

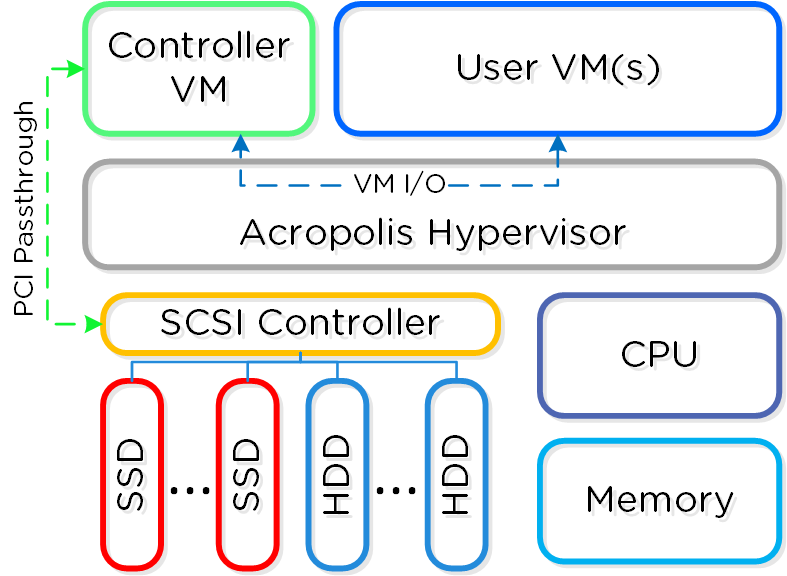

컨트롤러 가상화 (Virtualizing the Controller)

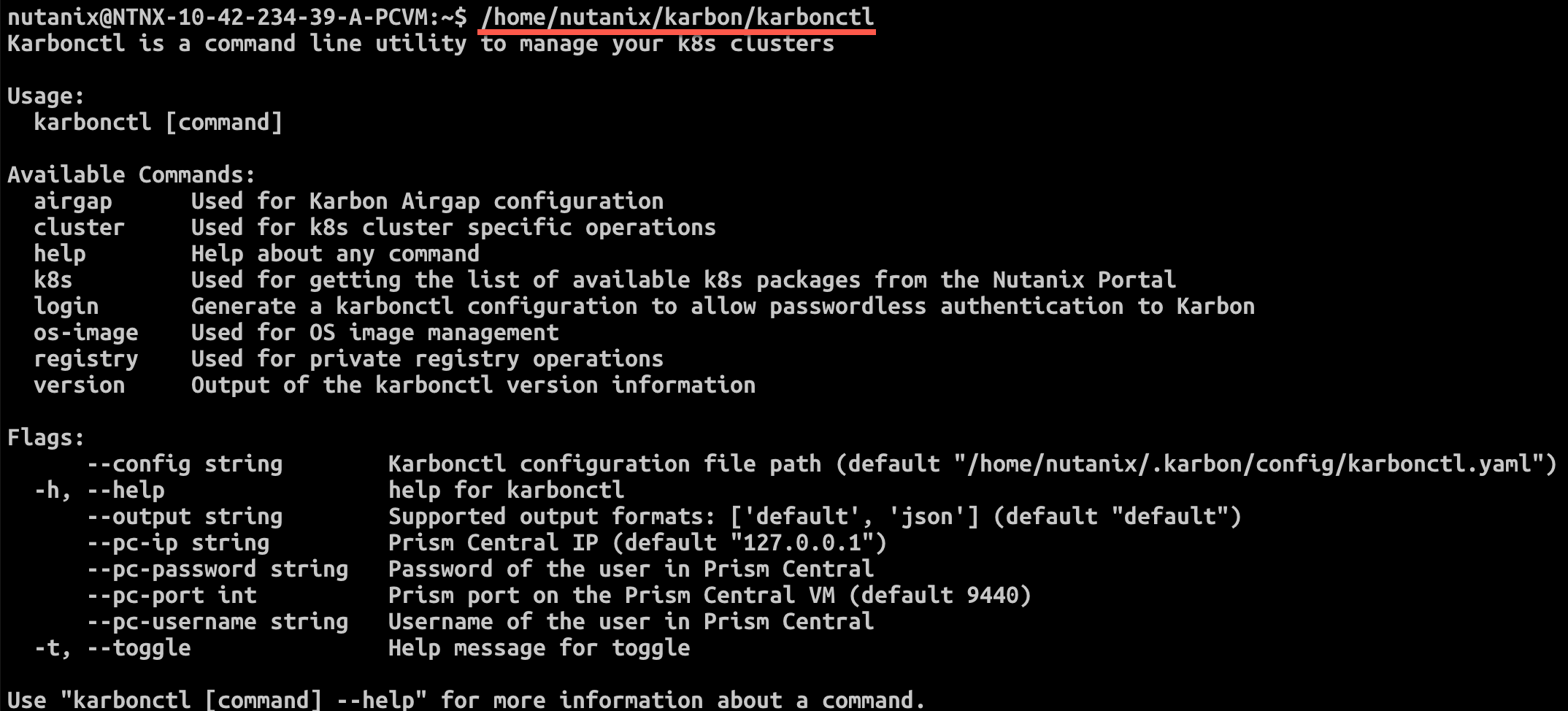

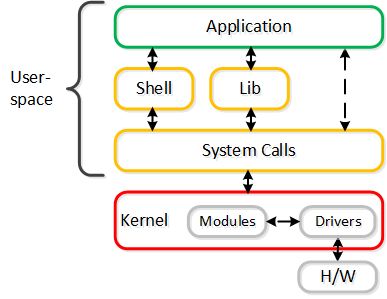

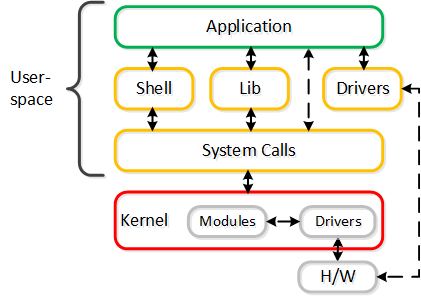

유저 스페이스에서 뉴타닉스 컨트롤러를 VM으로 실행하는 주요 이유는 크게 두 가지 핵심 영역으로 나뉜다.

- 모빌리티 (Mobility)

- 리질리언시 (Resiliency)

- 유지보수 / 업그레이드 (Maintenance / Upgrades)

- 성능 (Performance, yes really)

처음부터 우리는 우리가 단일 플랫폼 회사 이상이라는 것을 알고 있었다. 이러한 의미에서 그것이 하드웨어든 클라우드든 하이퍼바이저 벤더든 선택은 우리에게 항상 매우 중요한 일이었다.

유저 스페이스에서 VM으로 실행함으로써 뉴타닉스 소프트웨어를 기반 하이퍼바이저 및 하드웨어 플랫폼과 분리한다. 이를 통해 우리는 모든 운영 환경(온-프레미스 및 클라우드)에서 핵심 코드 베이스를 동일하게 유지하면서 다른 하이퍼바이저에 대한 지원을 신속하게 추가할 수 있었다. 추가적으로 우리에게 벤더 별 릴리스 주기에 구애받지 않는 유연성을 제공했다.

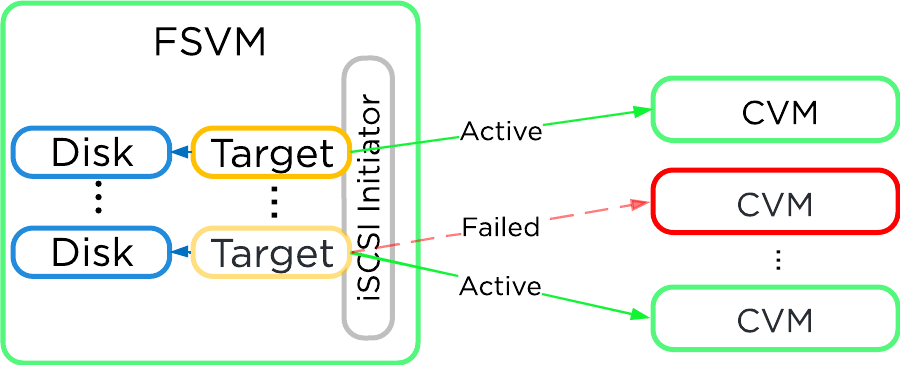

유저 스페이스에서 VM으로 실행되는 특성으로 인해 하이퍼바이저 외부에 있는 업그레이드 또는 CVM 장애와 같은 작업을 정교하게 처리할 수 있다. 예를 들어 CVM이 다운되는 치명적인 문제가 발생하더라도 전체 노드는 클러스터의 다른 CVM에서 오는 스토리지 I/O 및 서비스로 오퍼레이션을 지속한다. AOS (뉴타닉스 핵심 소프트웨어) 업그레이드 중에 해당 호스트에서 실행 중인 워크로드에 영향을 주지 않고 CVM을 재기동할 수 있다.

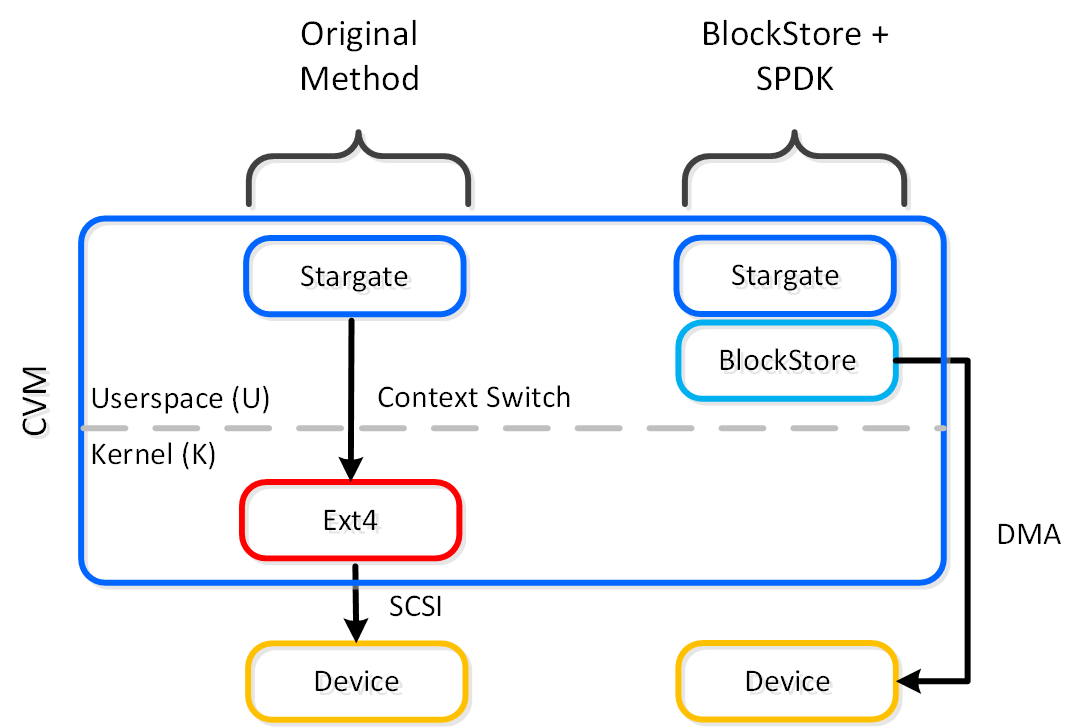

그러나, 커널에 있는 것이 훨씬 빠르지 않을까요? 간단히 말해서 아닙니다.

일반적인 토론 주제는 커널과 사용자 공간 사이의 논쟁이다. "유저 스페이스 및 커널 스페이스(User vs. Kernel Space)" 섹션을 읽을 것을 권장한다. 해당 섹션에서는 유저 및 커널 스페이스가 실제로 무엇인지, 그리고 각각의 장단점을 설명한다.

요약하자면, 운영체제(OS)에는 커널 스페이스(드라이버가 존재하는 OS 권한이 있는 코어)와 유저 스페이스(애플리케이션/프로세스가 존재하는)의 두 가지 실행 영역이 있다. 일반적으로 유저 스페이스와 커널 스페이스(일명 컨텍스트 전환) 사이를 이동하면 CPU 및 시간(~1,000ns/컨텍스트 전환) 측면에서 비용이 많이들 수 있다.

논쟁은 커널 스페이스에 있는 것이 항상 더 좋고 빠르다는 것이다. 어느 것이 맞을까요? 어쨋든지 간에 게스트 VM의 OS에는 항상 컨텍스트 스위치가 있다는 것이다.

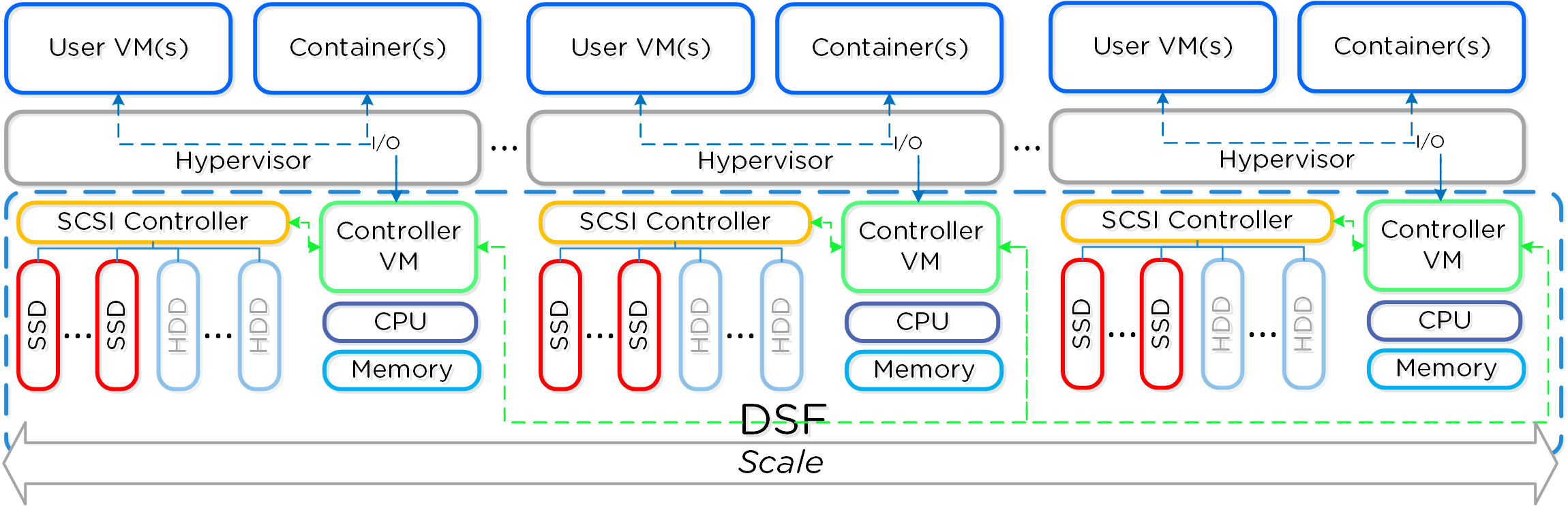

분산 시스템

분산 시스템에는 세 가지 핵심 원칙이 있다.

- SPOF가 없어야 한다.

- 규모에 관계없이 병목현상이 없어야 한다 (선형적인 확장이 가능해야 함).

- 동시 실행 기능을 활용해야 한다 (MapReduce).

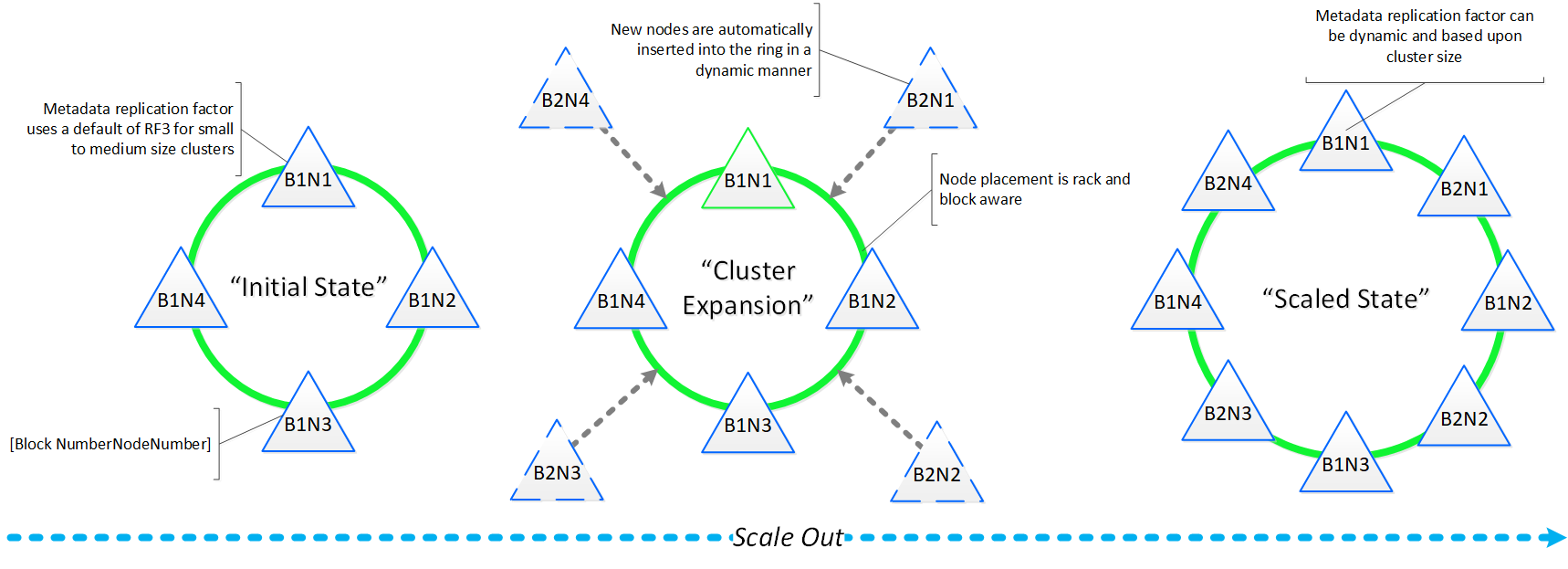

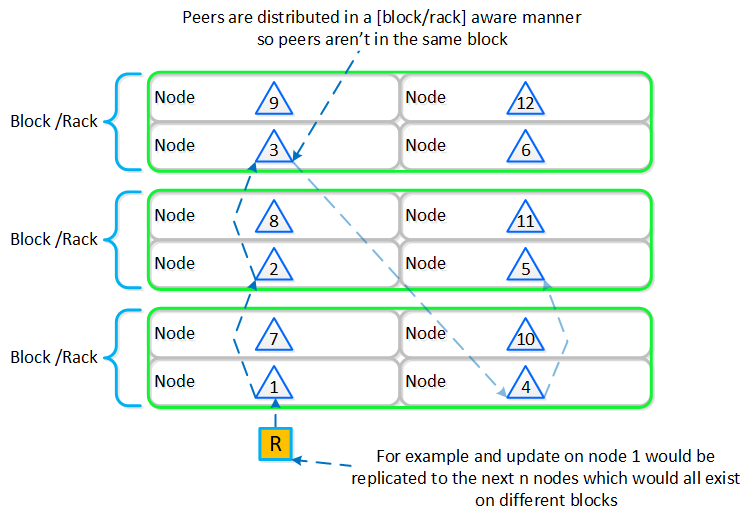

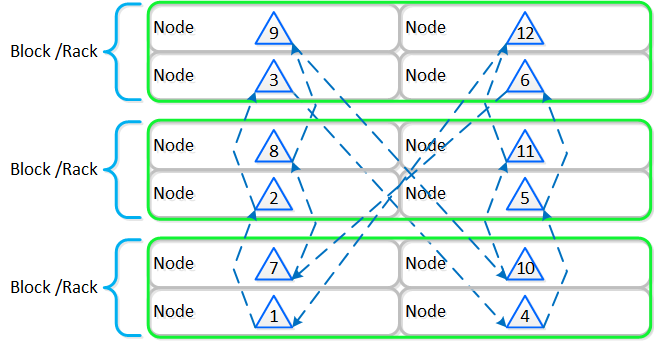

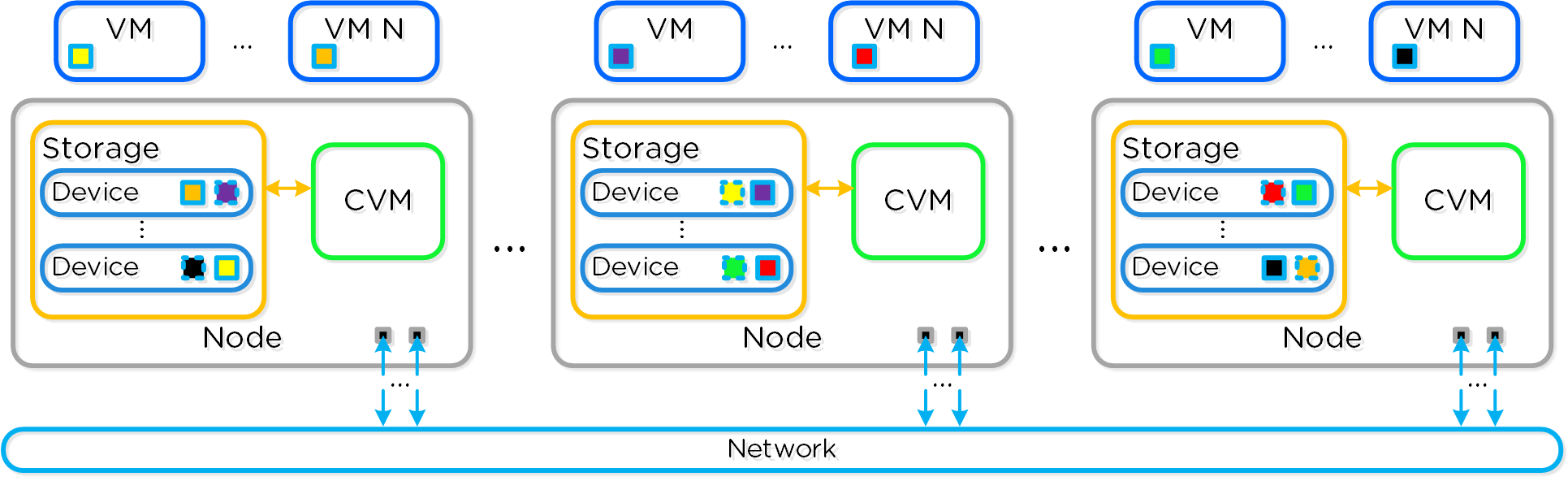

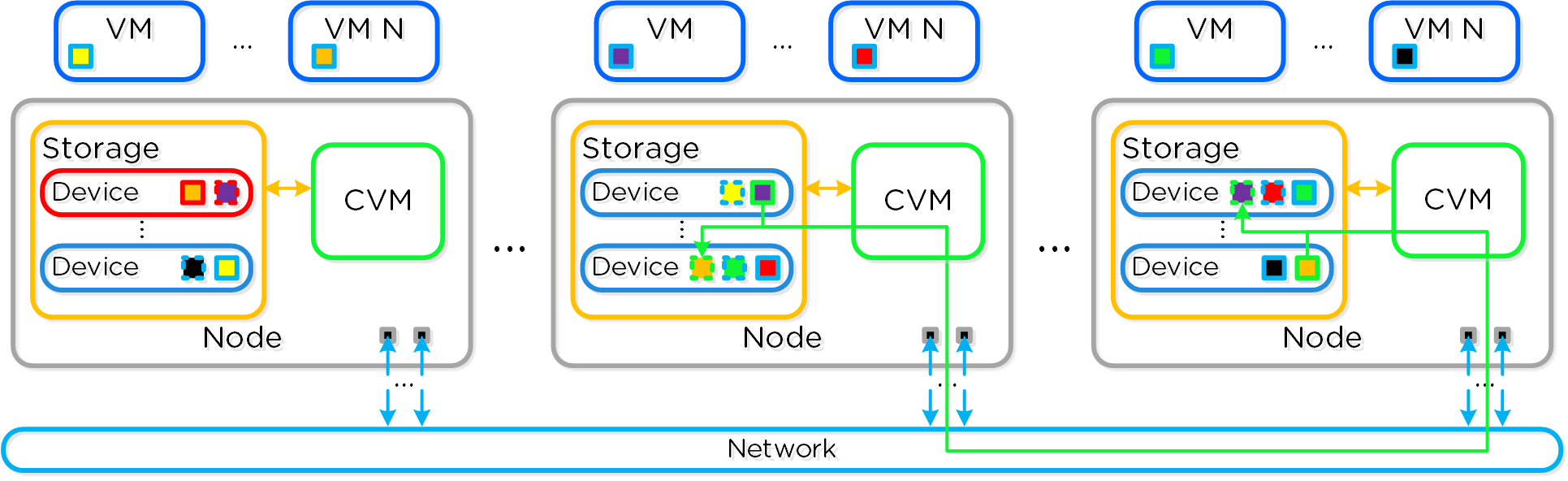

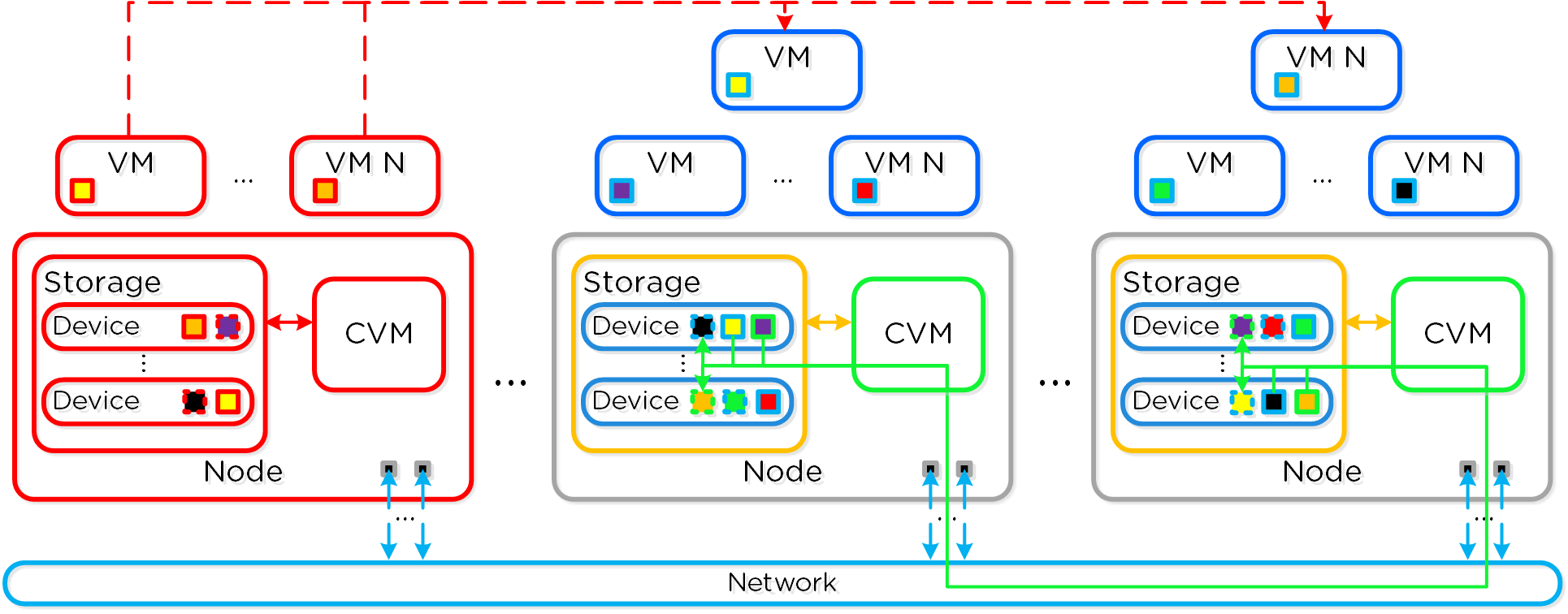

뉴타닉스 노드 그룹은 함께 프리즘 및 AOS 기능 제공을 담당하는 분산 시스템(뉴타닉스 클러스터)을 구성한다. 모든 서비스 및 컴포넌트는 고가용성 및 확장 시 선형적인 성능 제공을 위해 클러스터의 모든 CVM에 분산된다.

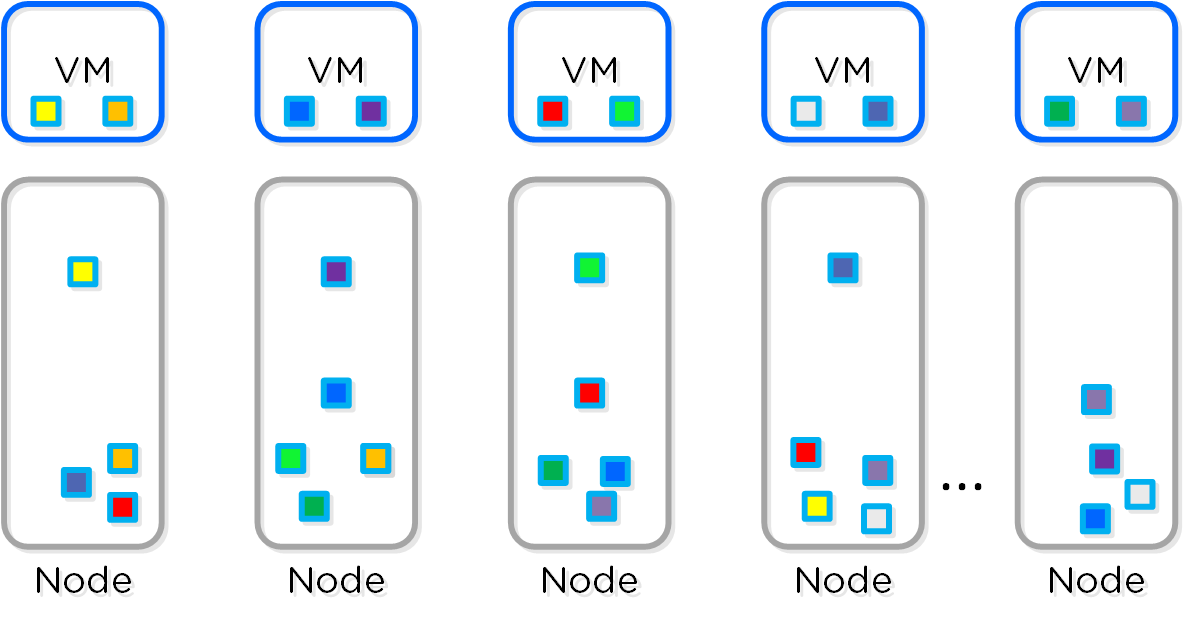

다음 그림은 이러한 뉴타닉스 노드가 뉴타닉스 클러스터를 구성하는 방법의 예를 보여준다.

뉴타닉스 클러스터 - 분산 시스템 (Nutanix Cluster - Distributed System)

뉴타닉스 클러스터 - 분산 시스템 (Nutanix Cluster - Distributed System)

이러한 기술은 메타데이터와 데이터에 동일하게 적용된다. 메타데이터와 데이터가 모든 노드와 모든 디스크 디바이스에 분산되도록 함으로써 정상적인 데이터 입력 및 재보호 중에 가능한 최고의 성능을 보장할 수 있다.

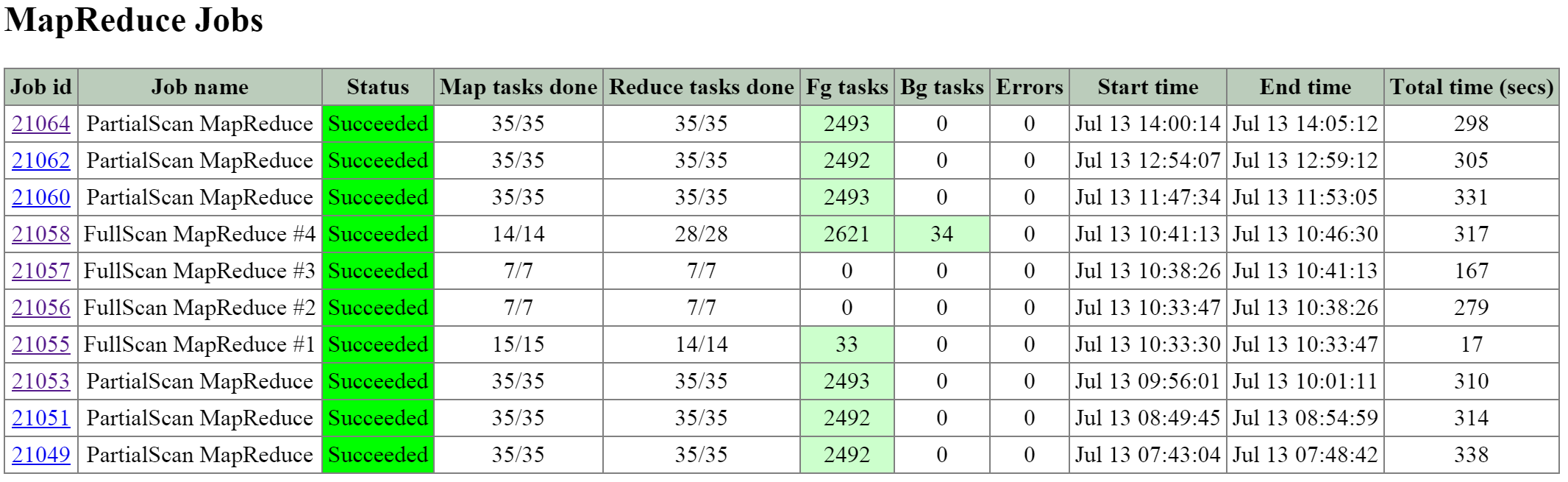

이를 통해 맵리듀스 프레임워크(Curator)는 클러스터의 모든 자원을 활용하여 액티비티를 동시에 수행할 수 있다. 샘플 액티비티에는 데이터 재보호, 압축, Erasure Coding, 중복제거 등이 포함된다.

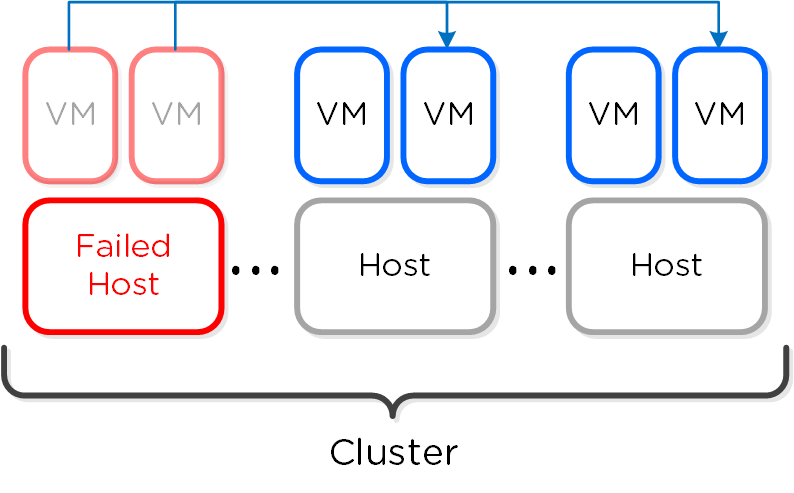

뉴타닉스 클러스터는 장애를 허용하고 수정하도록 설계되었다. 시스템은 오류를 투명하게 처리하고 수정하여 예상대로 동작을 지속한다. 사용자에게 경고가 표시되지만, 시간에 민감한 중요한 항목이 아닌 모든 작업(예: 장애 노드 교체)은 관리자의 스케줄에 따라 수행할 수 있다.

뉴타닉스 클러스터에 자원을 추가해야 하는 경우 새로운 노드를 추가하여 선형으로 클러스터를 확장할 수 있다. 기존의 3-Tier 아키텍처에서는 단순히 서버를 추가한다고 해서 스토리지 성능이 확장되지 않는다. 그러나 뉴타닉스와 같은 하이퍼컨버지드 플랫폼에서는 새로운 노드를 확장할 때 다음과 같은 자원이 동시에 확장된다.

- 하이퍼바이저/컴퓨트 노드의 수

- 스토리지 컨트롤러의 수

- 컴퓨트 및 스토리지 성능/용량

- 클러스터 전체의 오퍼레이션에 참여하는 노드의 수

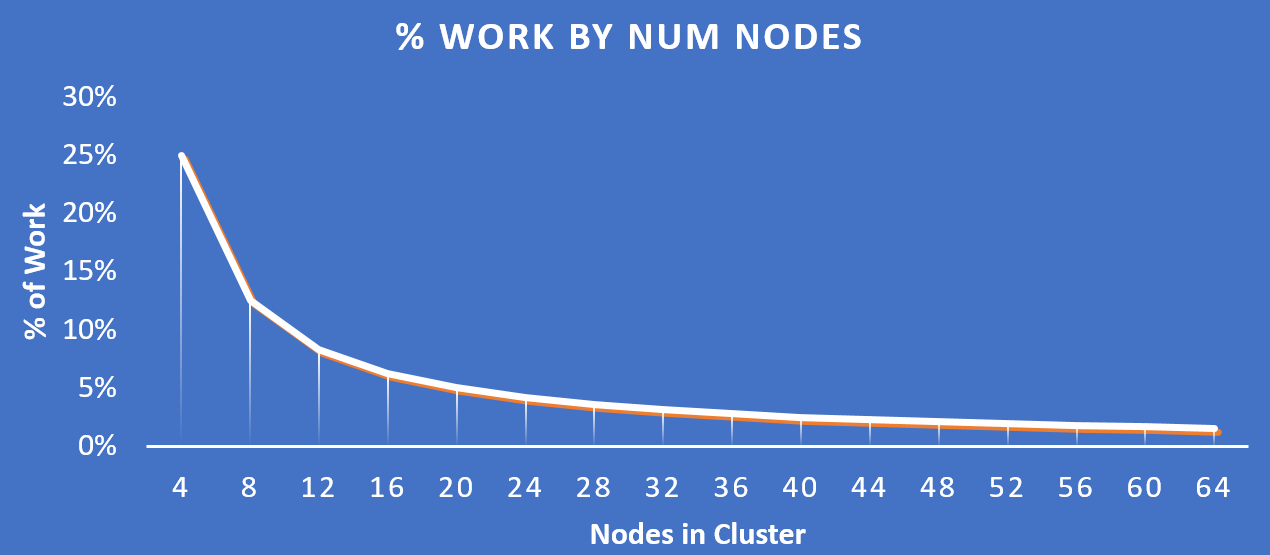

다음 그림은 클러스터의 확장에 따라 각 노드에서 처리되는 작업 비율(%)을 어떤 방식으로 현저하게 감소되는지를 보여준다.

작업 분포 - 클러스터 규모 (Work Distribution - Cluster Scale)

작업 분포 - 클러스터 규모 (Work Distribution - Cluster Scale)

Key Point: 클러스터 내의 노드 수가 증가함에 따라 (클러스터 확장), 각 노드가 작업의 일부만을 처리하기 때문에 실제로 특정 액티비티가 더 효율적으로 된다.

소프트웨어 정의

소프트웨어 정의 시스템에는 세 가지 핵심 원칙이 있다.

- 플랫폼 이동성을 제공하여야 한다 (하드웨어, 하이퍼바이저)

- 맞춤 하드웨어에 의존해서는 안 된다.

- 빠른 개발 속도를 제공해야 한다 (기능, 버그 수정, 보안 패치).

- 무어 법칙의 장점을 활용해야 한다.

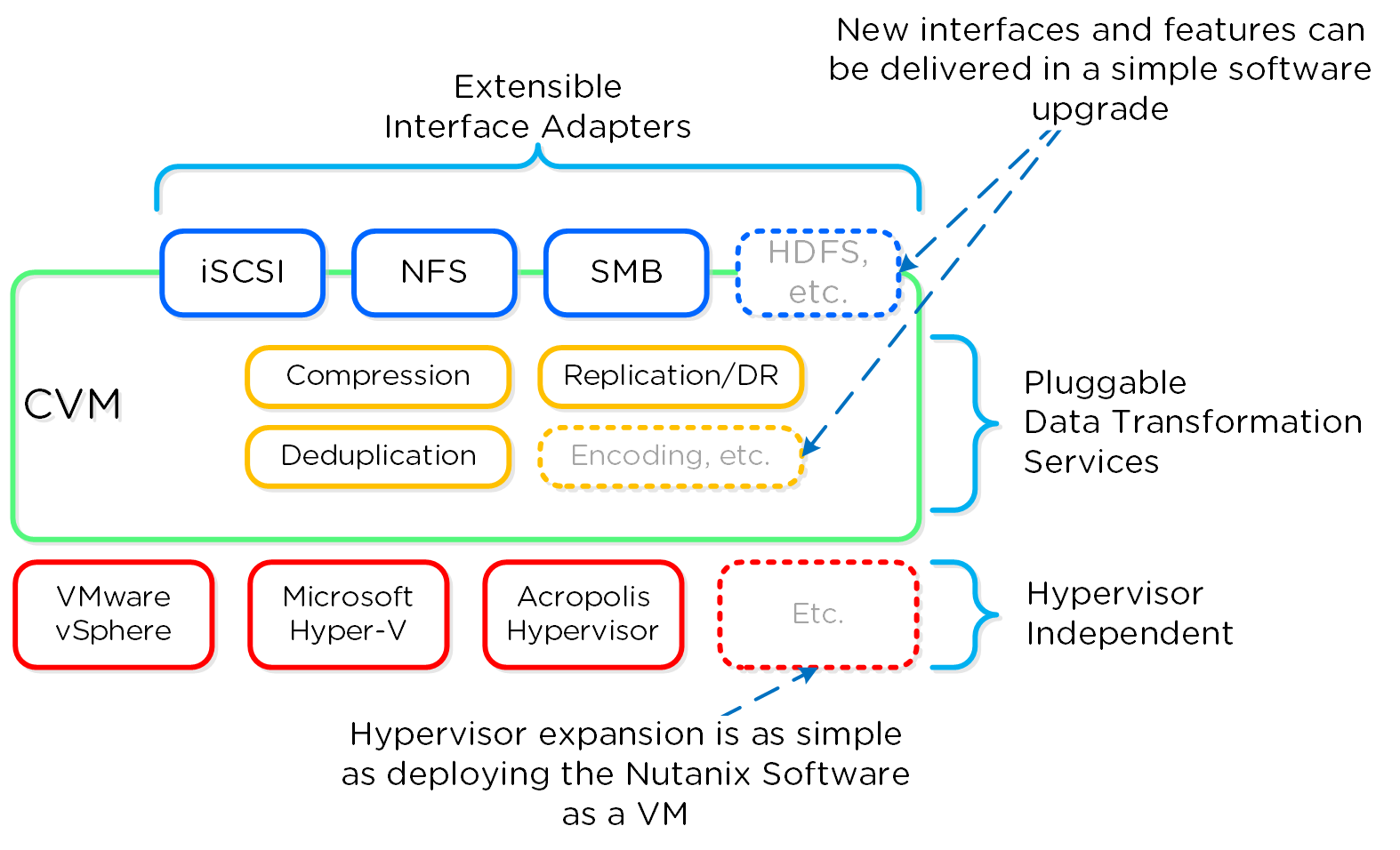

위에서 언급한 바와 같이 (아마도 여러 번) 뉴타닉스 플랫폼은 번들 된 소프트웨어 + 하드웨어 어플라이언스로 제공되는 소프트웨어 기반 솔루션이다. 컨트롤러 VM(Controller VM)은 뉴타닉스 소프트웨어 및 로직의 대부분이 있는 곳으로 처음부터 확장 가능하고 플러그인이 가능한 아키텍처로 설계되었다. 소프트웨어로 정의되고 하드웨어 오프로드 또는 구조에 의존하지 않는 주요 이점은 확장성에 있다. 모든 제품 수명주기와 마찬가지로 고급 및 새로운 기능이 항상 도입될 것이다.

맞춤형 ASIC/FPGA 또는 하드웨어 기능에 의존하지 않음으로써 뉴타닉스는 간단한 소프트웨어 업데이트를 통해 이러한 새로운 기능을 개발하고 배포할 수 있다. 즉 현재 버전의 뉴타닉스 소프트웨어를 업그레이드하여 새로운 기능(e.g. 중복제거)을 배포할 수 있다. 또한 레거시 하드웨어 모델에 새로운 세대의 기능을 배포할 수 있다. 예를 들어 이전 세대의 하드웨어 플랫폼(e.g. 2400)에서 구 버전의 뉴타닉스 소프트웨어로 워크로드를 실행하고 있다고 가정한다. 실행 중인 소프트웨어 버전은 워크로드에게 큰 도움이 될 수 있는 중복제거 기능을 제공하지 않는다. 이러한 기능을 사용하려면 워크로드가 실행되는 동안 뉴타닉스 소프트웨어 버전의 롤링 업그레이드를 수행하면 중복제거 기능을 사용할 수 있다. 정말로 그렇게 쉽다.

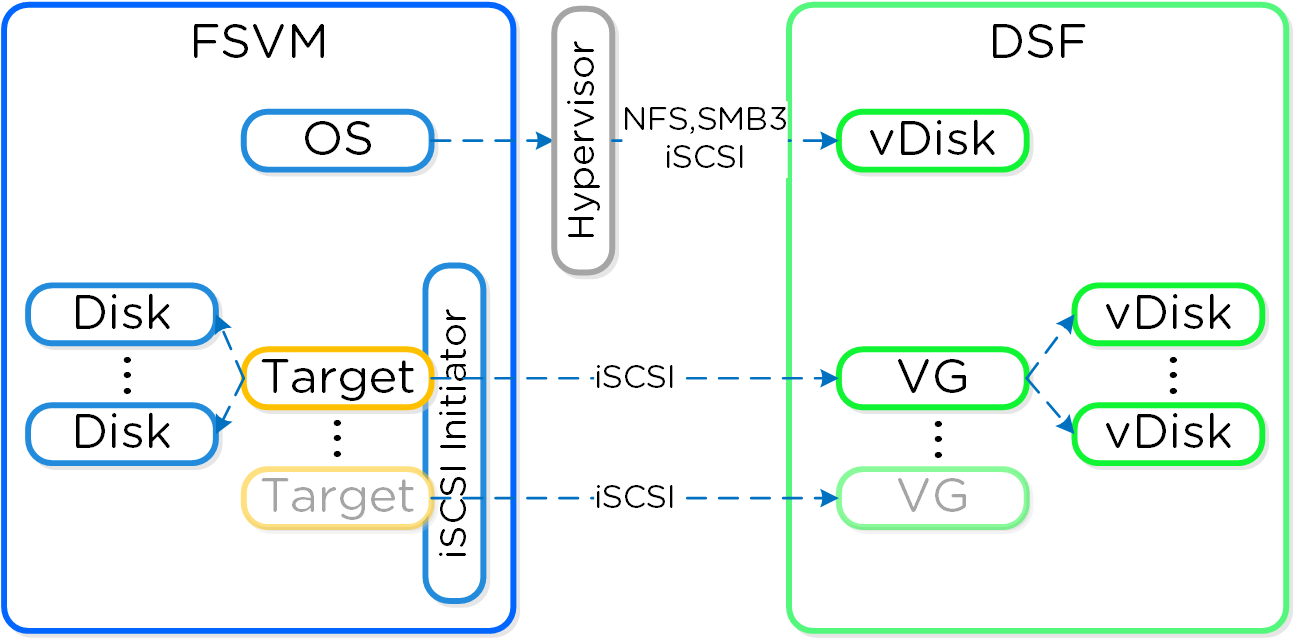

기능과 마찬가지로 DSF에 새로운 "어댑터" 또는 인터페이스를 만드는 것이 또 다른 핵심 능력이다. 제품이 처음 출시되었을 때 하이퍼바이저 I/O를 위해 단지 iSCSI만을 지원하였지만 이제는 NFS 및 SMB를 포함하도록 확장되었다. 향후에는 다양한 워크로드 및 하이퍼바이저를 (HDFS 등) 위한 새로운 어댑터를 만들 수 있다. 다시 반복하지만 이러한 모든 것은 소프트웨어 업데이트를 통해 배포될 수 있다. 이는 "최신 및 최고" 기능을 적용하기 위해 하드웨어 업그레이드 또는 일반적으로 소프트웨어 구매를 필요로 하는 대부분의 레거시 인프라와 반대되는 특징이다. 뉴타닉스를 사용하면 다르다. 모든 기능이 소프트웨어로 배포되므로 모든 하드웨어 플랫폼, 모든 하이퍼바이저에서 실행할 수 있으며 간단한 소프트웨어 업그레이드를 통해 배포될 수 있다.

디음 그림은 소프트웨어 정의 컨트롤러 프레임워크의 논리적인 표현을 보여준다.

소프트웨어 정의 컨트롤러 프레임워크 (Software-Defined Controller Framework)

소프트웨어 정의 컨트롤러 프레임워크 (Software-Defined Controller Framework)

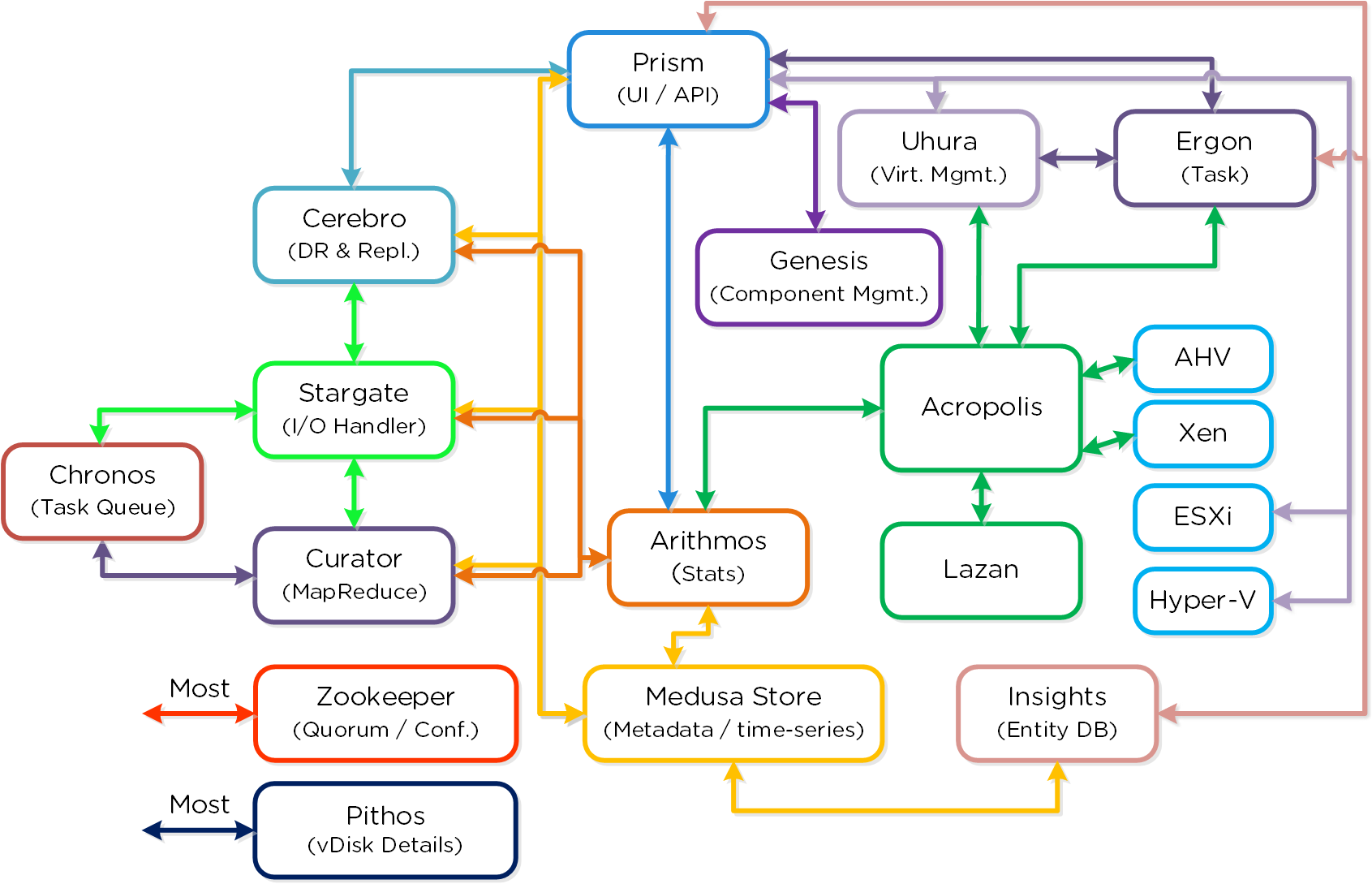

클러스터 컴포넌트

사용자 중심의 뉴타닉스 제품은 배포 및 운영이 매우 간단하다. 이것은 주로 추상화와 소프트웨어에서 많은 자동화/통합을 통해 가능하다.

다음은 메인 뉴타닉스 클러스터 컴포넌트에 대한 상세한 설명이다 (모든 것을 암기하거나 알 필요가 없으니 걱정하지 마세요).

뉴타닉스 클러스터 컴포넌트 (Nutanix Cluster Components)

뉴타닉스 클러스터 컴포넌트 (Nutanix Cluster Components)

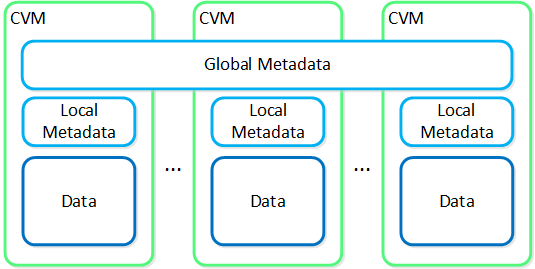

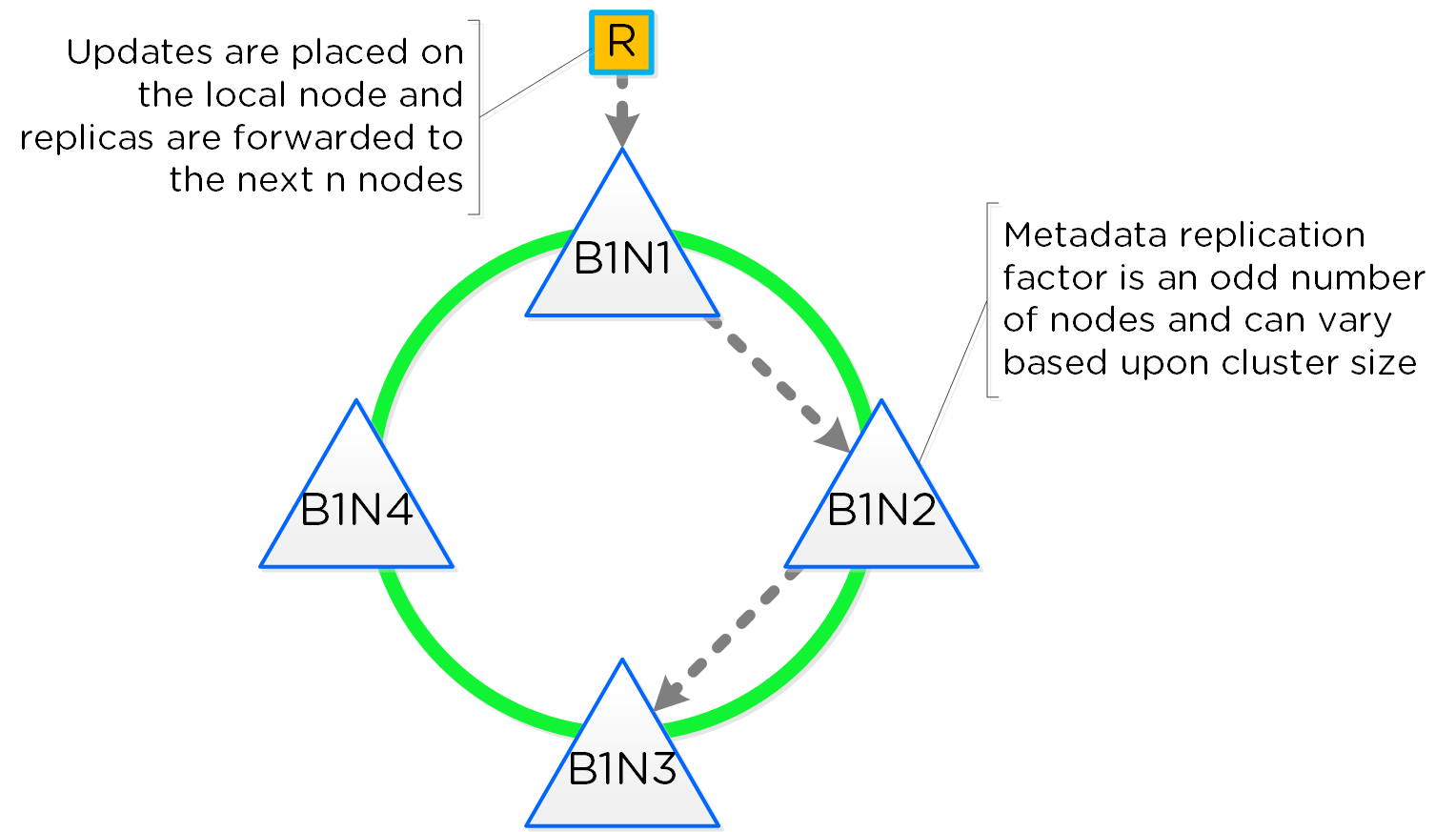

카산드라 (Cassandra)

- 주요 역할: 분산 메타데이터 스토어

- 설명: 카산드라는 크게 수정된 Apache Cassandra를 기반으로 모든 클러스터 메타데이터를 분산 링 방식으로 저장하고 관리한다. PAXOS 알고리즘이 “엄격한 일관성(Strict Consistency)”을 유지하기 위해 사용된다. 이 서비스는 클러스터의 모든 노드에서 실행된다. 카산드라는 메두사(Medusa)로 불리는 인터페이스를 통해 액세스 된다.

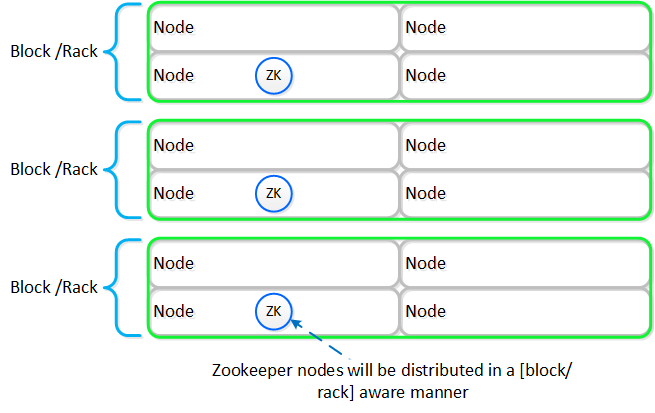

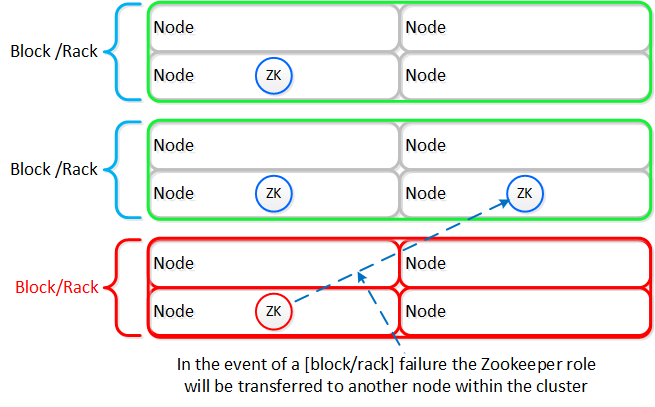

주키퍼 (Zookeeper)

- 주요 역할: 클러스터 설정 매니저

- 설명: 주키퍼는 호스트, IP 주소, 상태 등을 포함한 모든 클러스터 설정 정보를 저장하며 Apache Zookeeper를 기반으로 한다. 이 서비스는 클러스터의 세 노드에서 실행되며 그중 하나가 리더로 선출된다. 리더는 모든 요청을 받아 동료들에게 전달한다. 만약 리더가 응답하지 않으면 새로운 리더가 자동으로 선출된다. 주키퍼는 제우스(Zeus)로 불리는 인터페이스를 통해 액세스 된다.

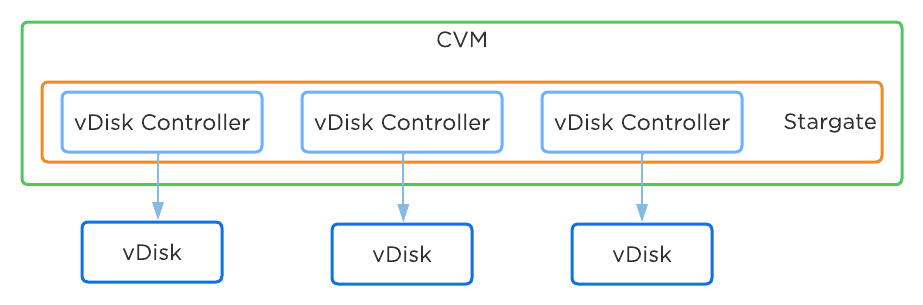

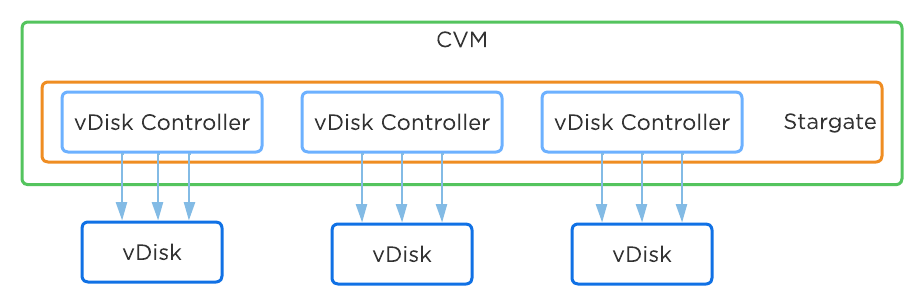

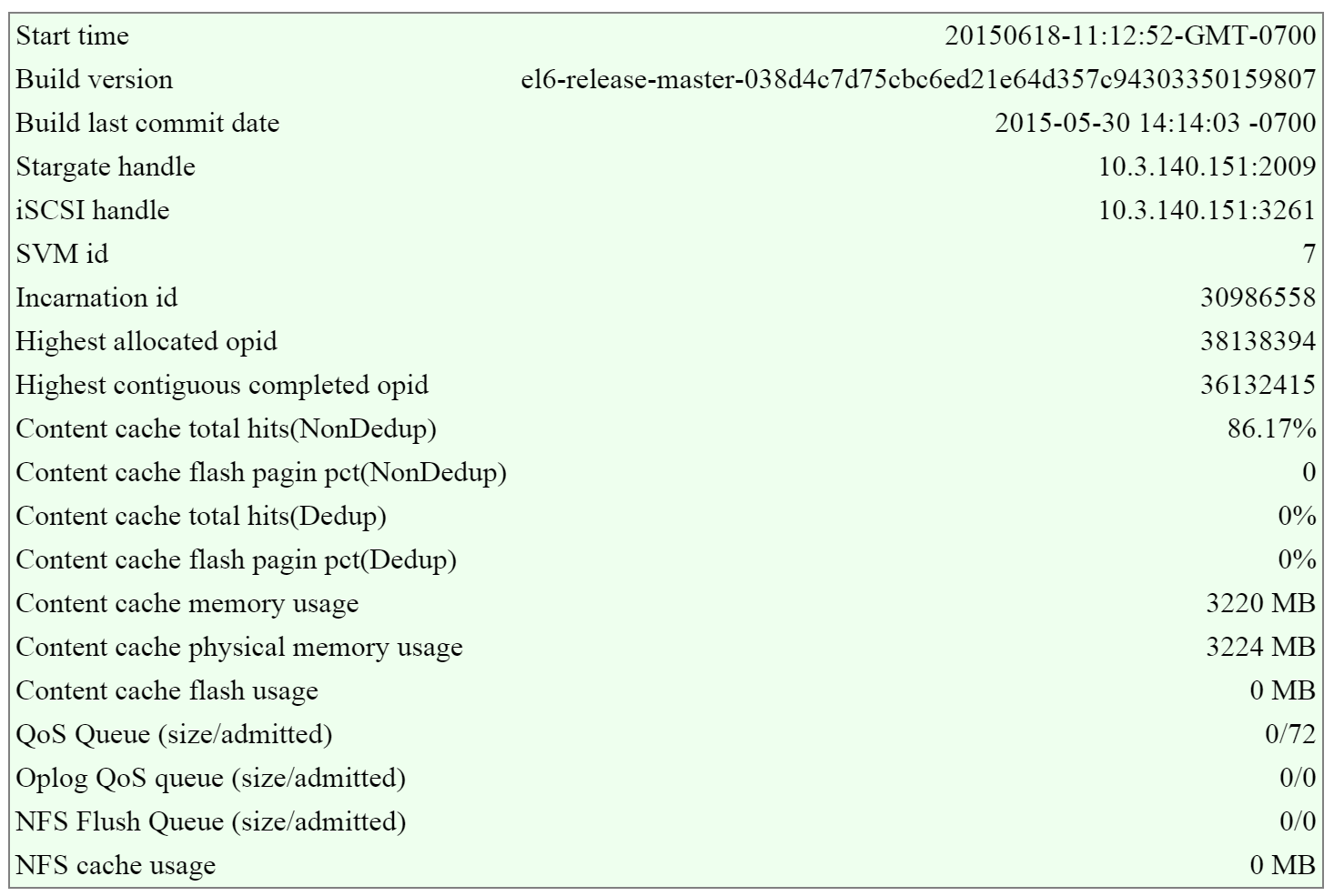

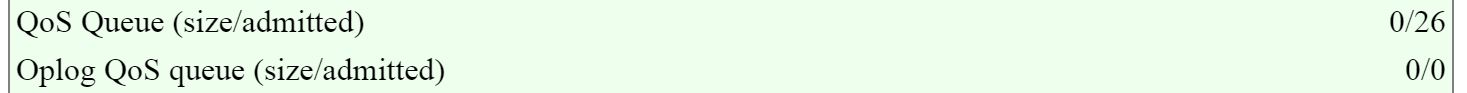

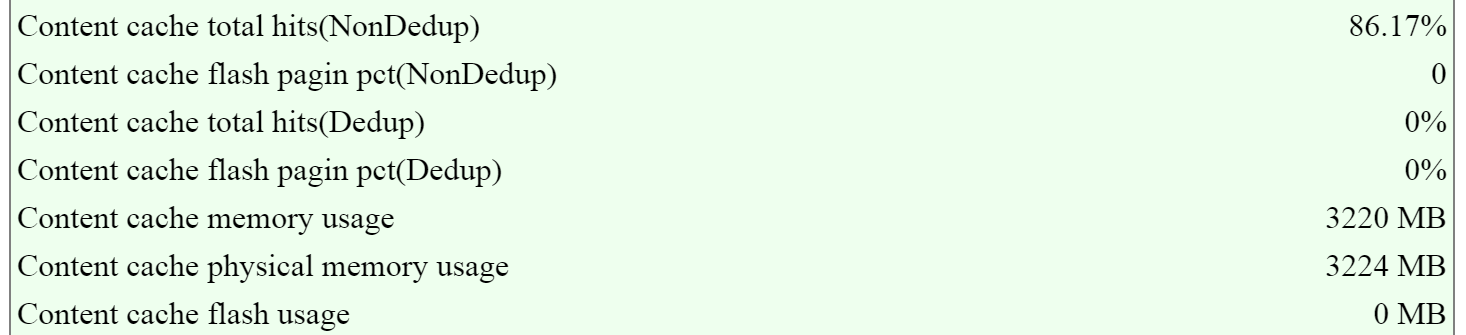

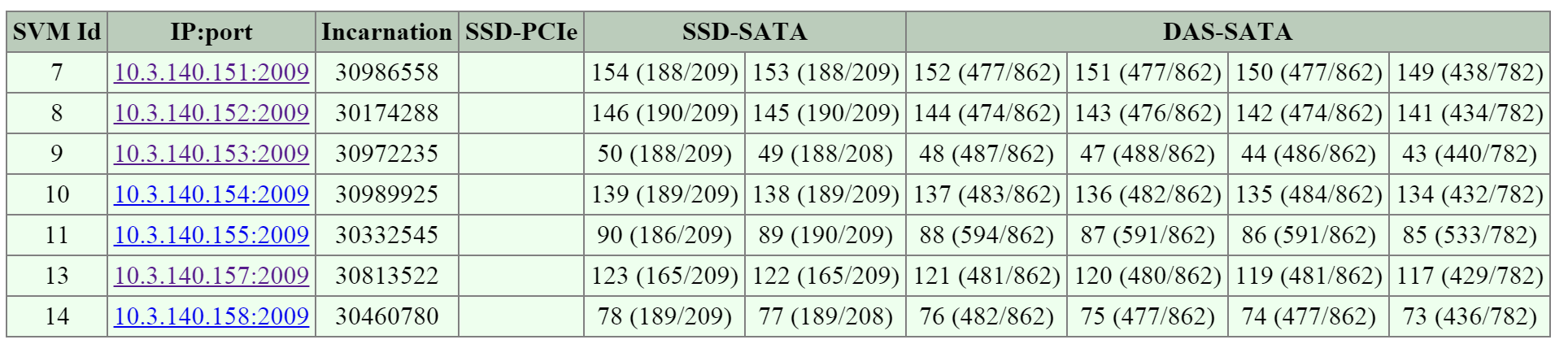

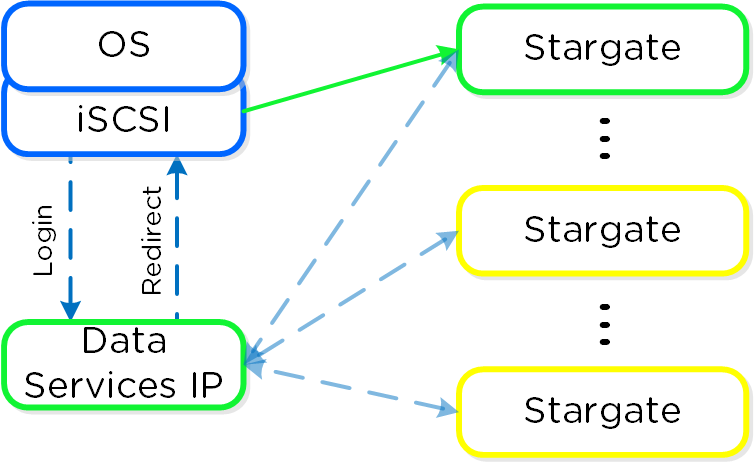

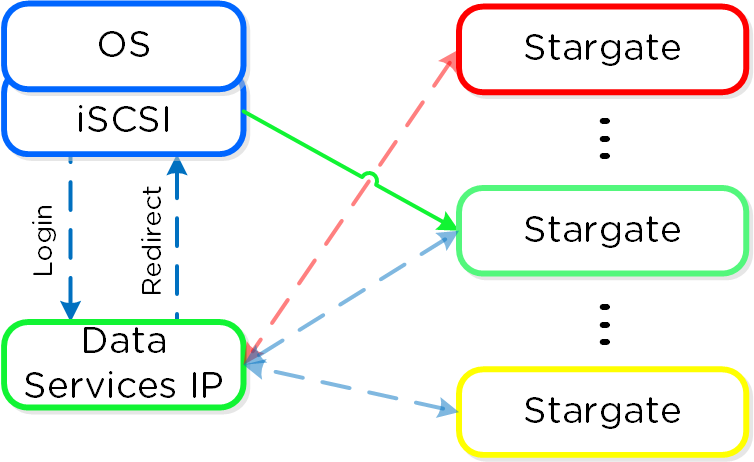

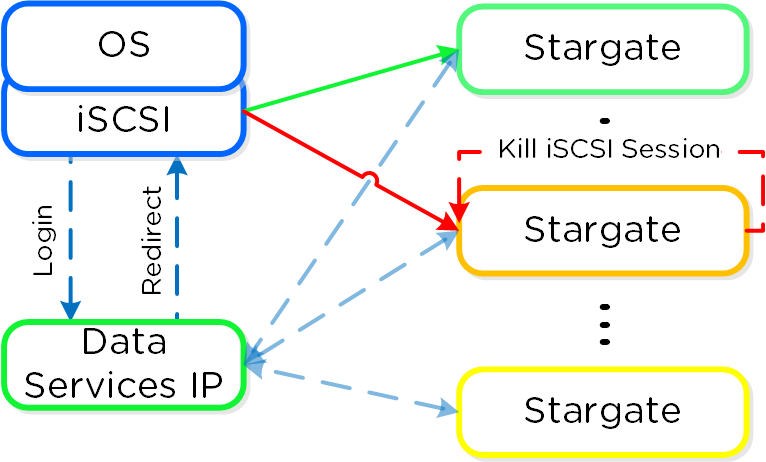

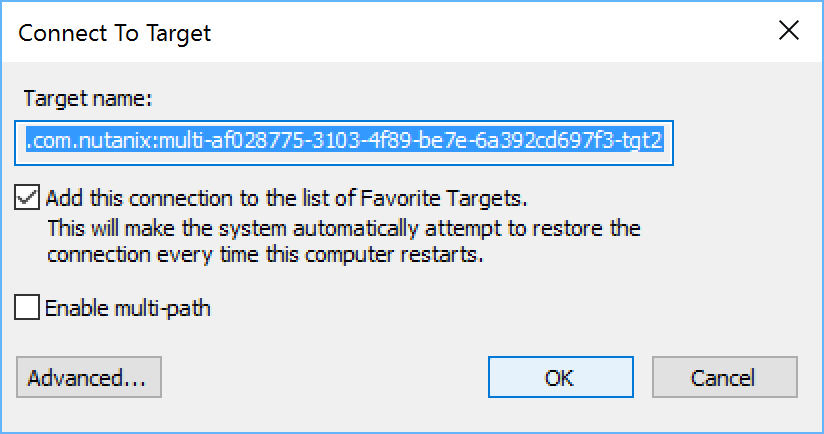

스타게이트 (Stargate)

- 주요 역할: 데이터 I/O 매니저

- 설명: 스타게이트는 모든 데이터 관리 및 I/O 오퍼레이션을 담당하며 하이퍼바이저(NFS, iSCSI, 또는 SMB를 통해)의 메인 인터페이스이다. 이 서비스는 로컬 I/O를 지원하기 위해 클러스터의 모든 노드에서 실행된다.

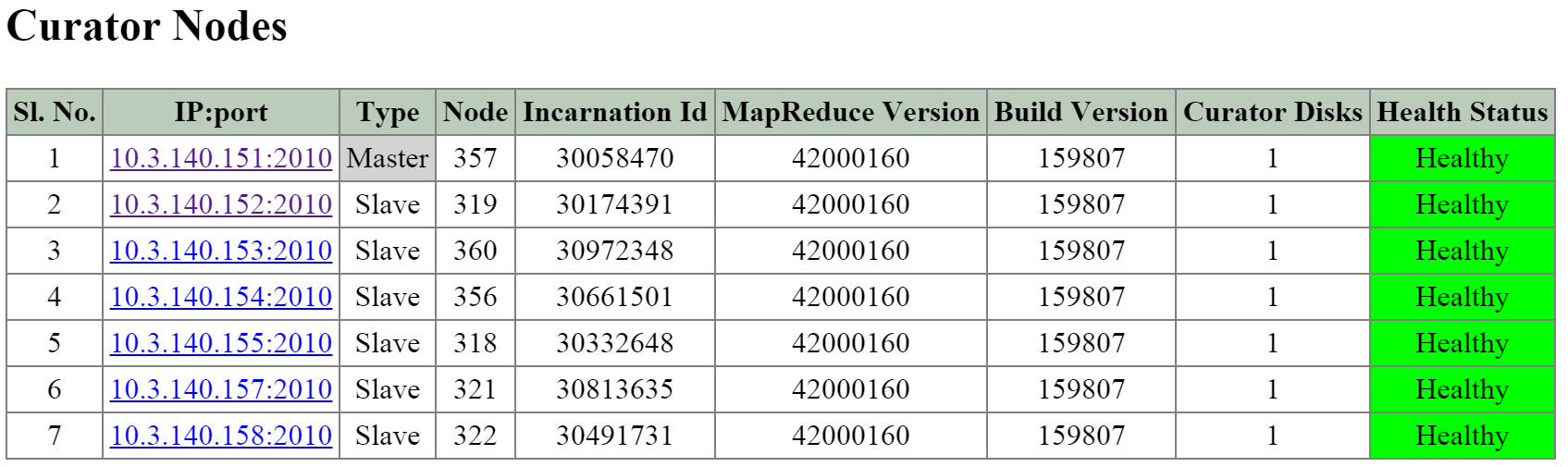

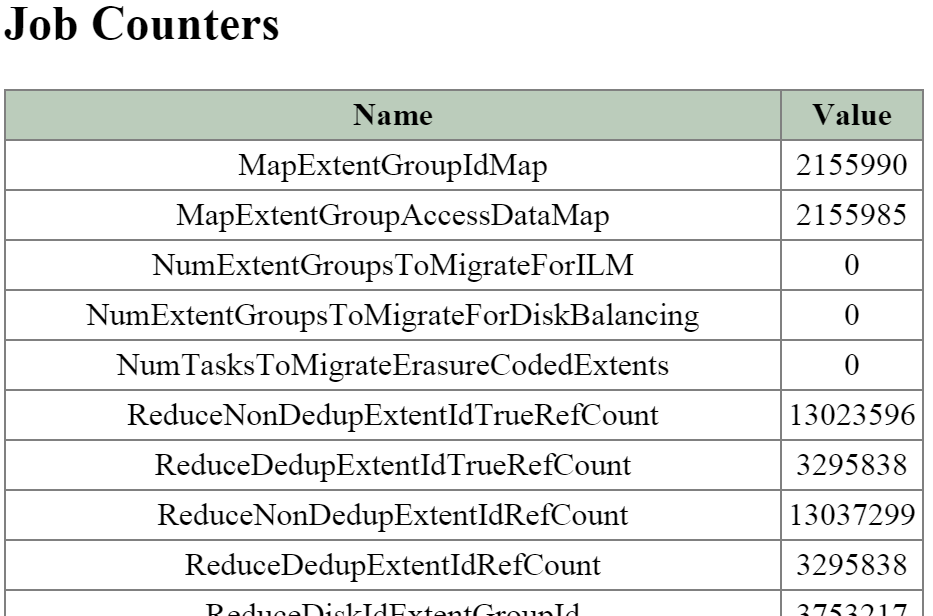

큐레이터 (Curator)

- 주요 역할: 맵 리듀스 클러스터 관리 및 정리

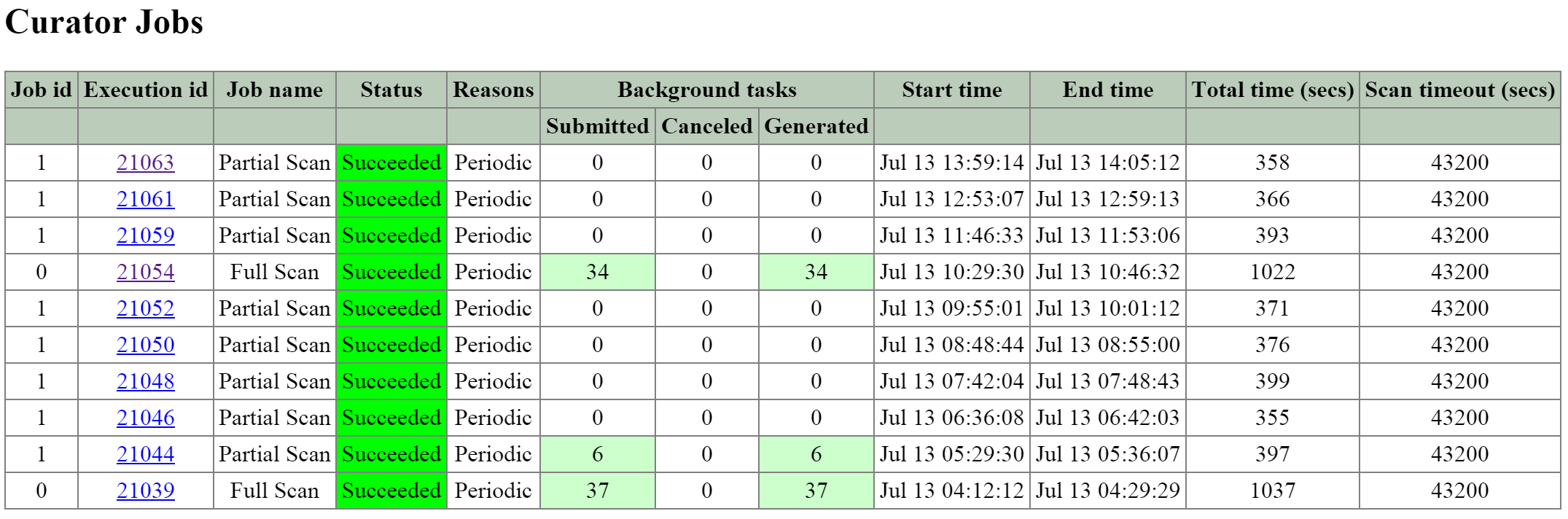

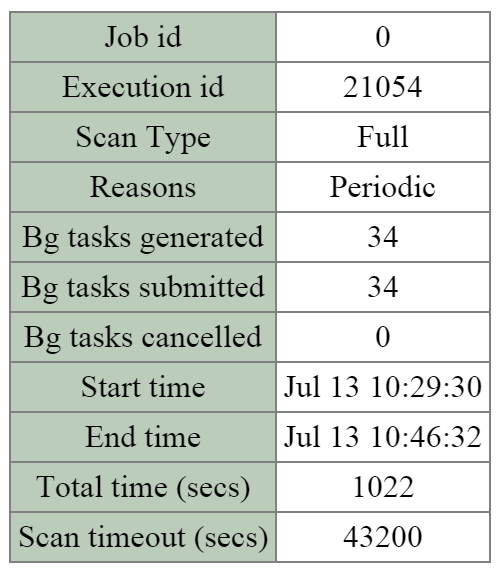

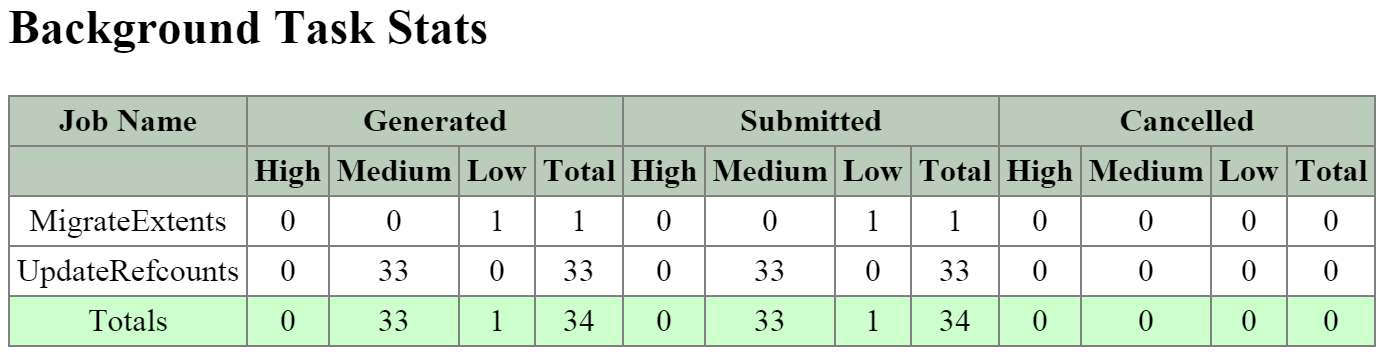

- 설명: 큐레이터는 클러스터 전체에서 작업을 관리하고 분산하는 역할을 담당하며 디스크 밸런싱, 사전 예방적 스크러빙 등과 같은 많은 작업을 수행한다. 큐레이터는 모든 노드에서 실행되며 태스크(Task) 및 잡(Job) 위임을 담당하는 선출된 큐레이터 리더(Leader)에 의해 제어된다. 큐레이터에는 두 가지 스캔 유형이 있는데, 전체 스캔(Full Scan)은 6시간 주기로, 부분 스캔(Partial Scan)은 1시간 주기로 발생한다.

프리즘 (Prism)

- 주요 기능: UI 및 API

- 설명: 프리즘은 컴포넌트 및 관리자가 뉴타닉스 클러스터를 설정하고 모니터링할 수 있는 관리 게이트웨이이다. 여기에는 nCLI, HTML5 UI 및 REST API가 포함된다. 프리즘은 클러스터의 모든 노드에서 실행되며 클러스터의 모든 컴포넌트와 같이 선출된 리더를 사용한다.

제네시스 (Genesis)

- 주요 역할: 클러스터 컴포넌트 및 서비스 매니저

- 설명: 제네시스는 각 노드에서 실행되는 프로세스로 초기 설정뿐만 아니라 모든 서비스 상호작용(시작/중지 등)을 담당한다. 제네시스는 클러스터와 독립적으로 실행되는 프로세스로 클러스터 설정/실행을 요구하지 않는다. 제네시스가 실행되기 위한 유일한 요구 사항은 주키퍼가 기동되어 실행 중이어야 한다는 것이다. cluster_init 및 cluster_status 페이지는 제네시스에 의해 출력된다.

크로노스 (Chronos)

- 주요 역할: 잡 및 태스크 스케줄러

- 설명: 크로노스는 큐레이터 스캔 및 노드 간의 스케줄링/스로틀링의 결과로 발생되는 잡 및 태스크를 인계받는다. 크로노스는 모든 노드에서 실행되며 태스크 및 잡 위임을 담당하고 큐레이터 리더와 동일한 노드에서 실행되는 선출된 크로노스 리더에 의해 제어된다.

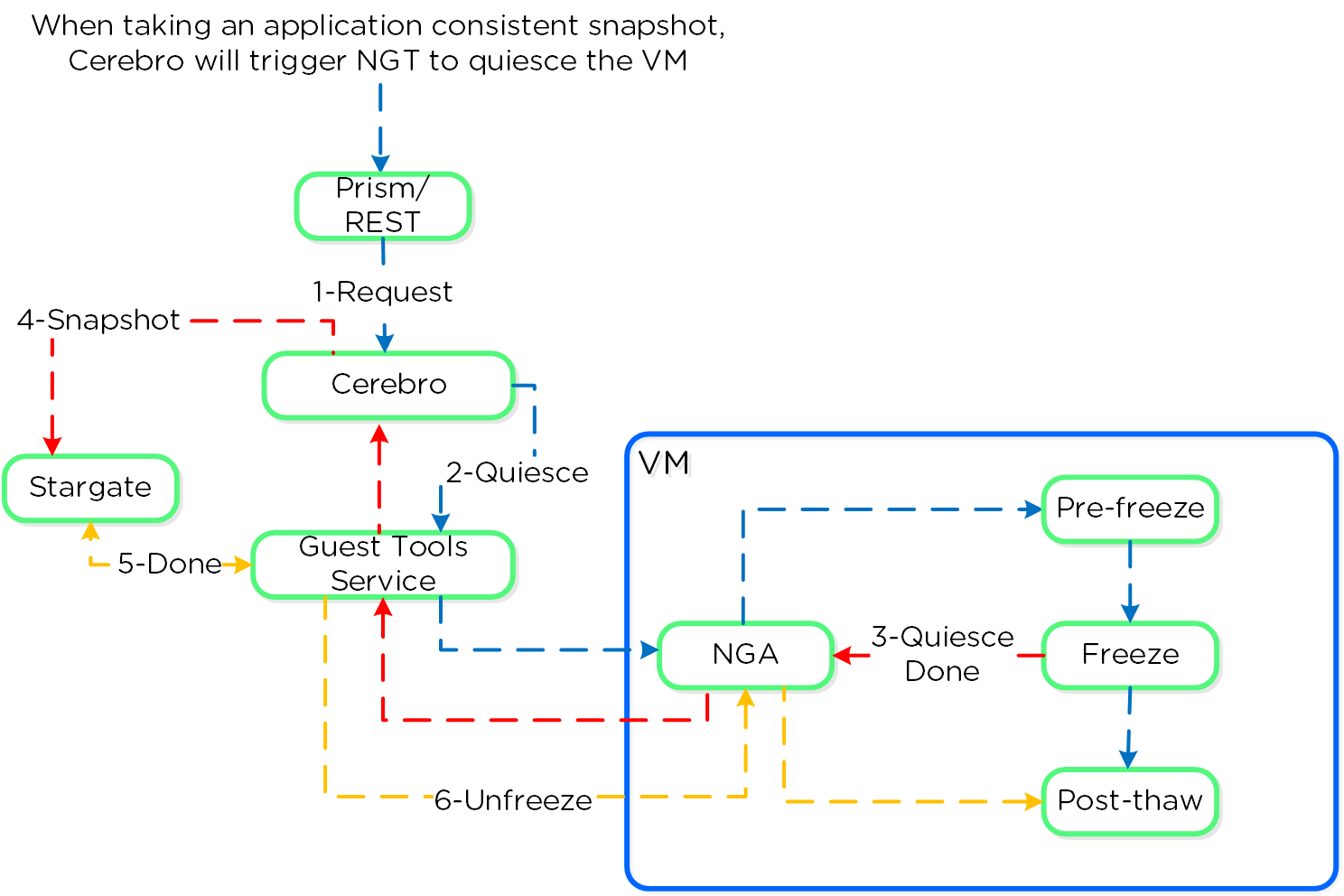

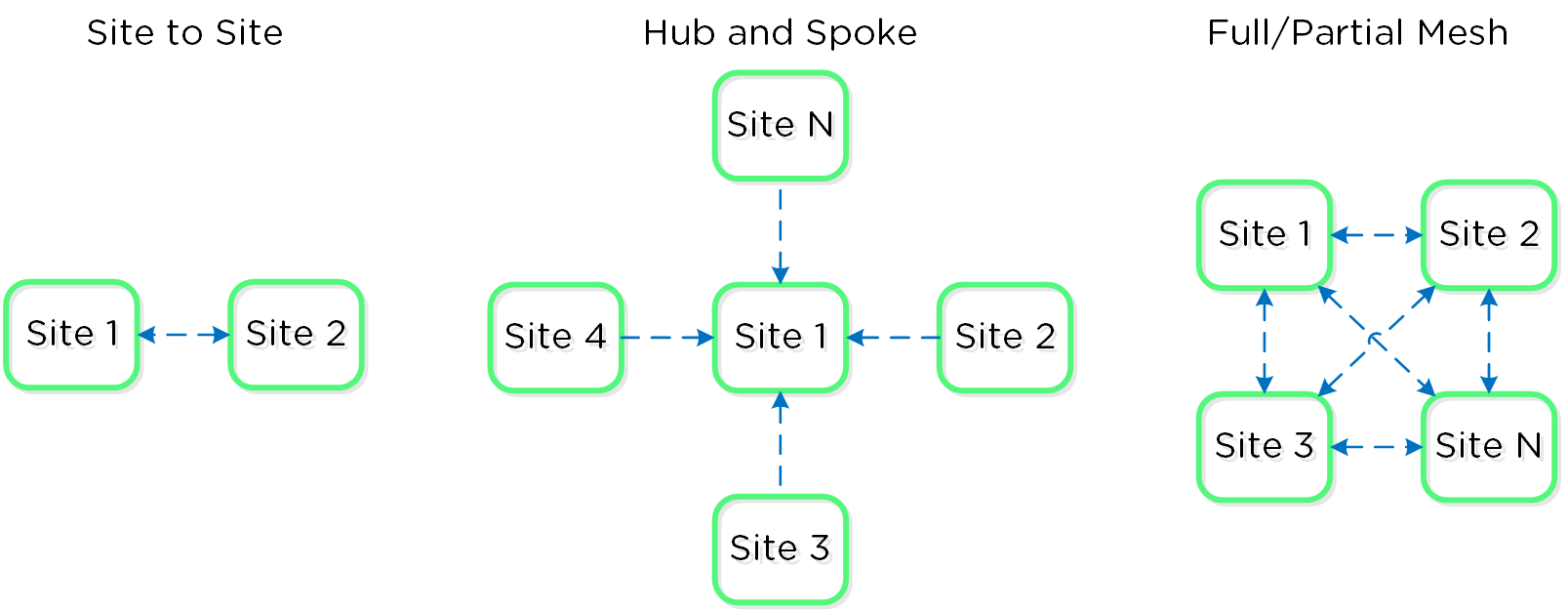

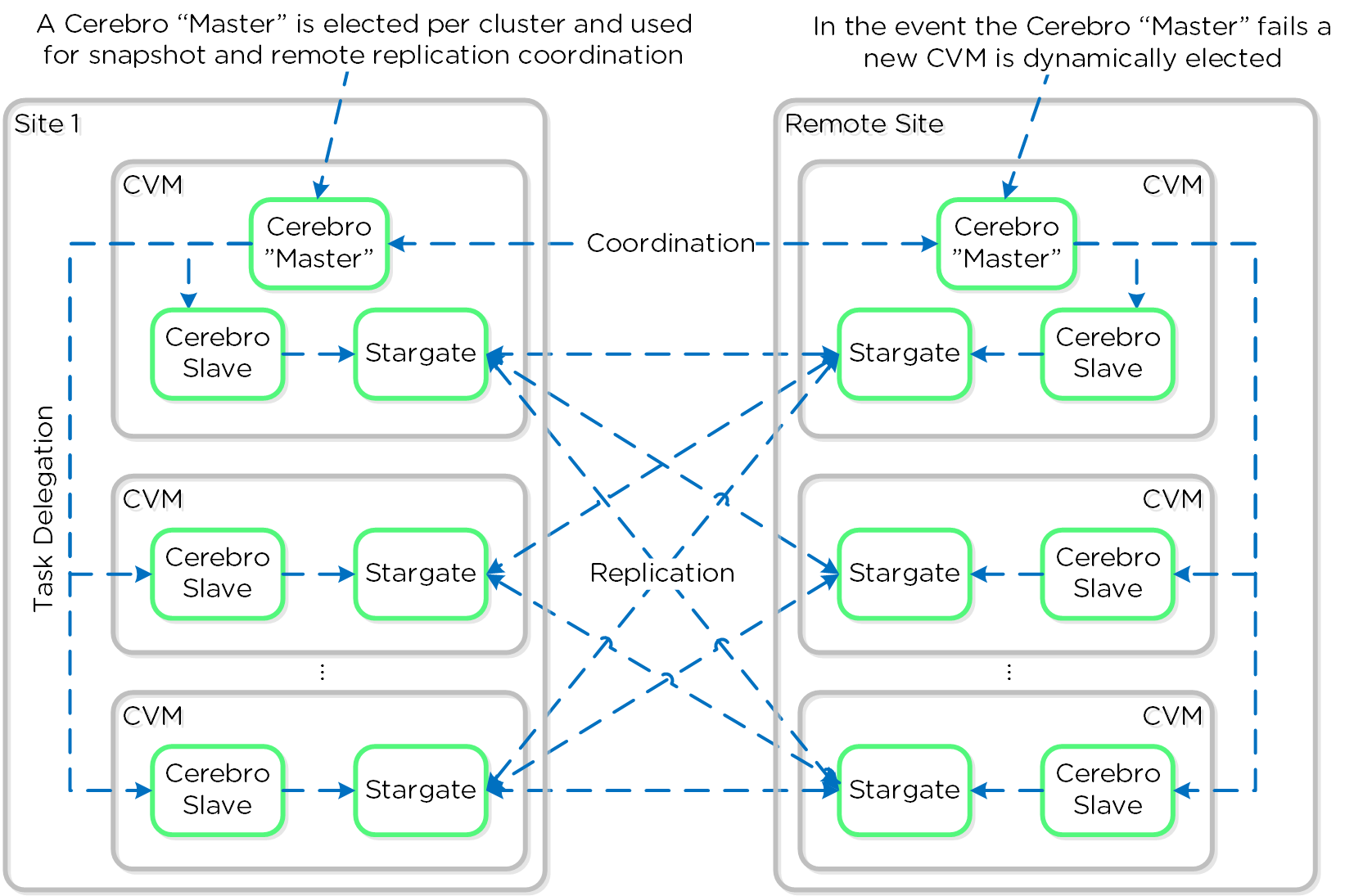

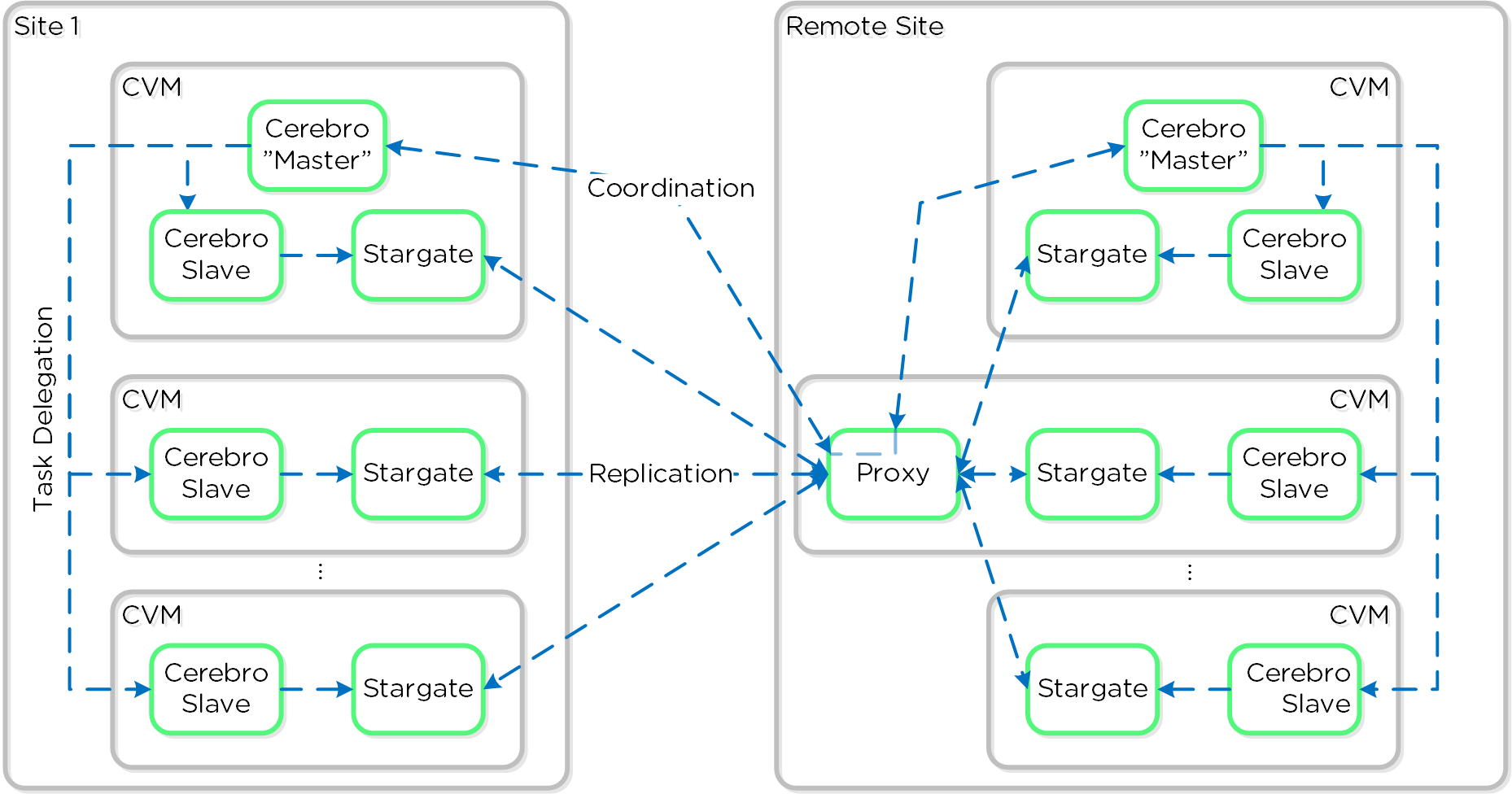

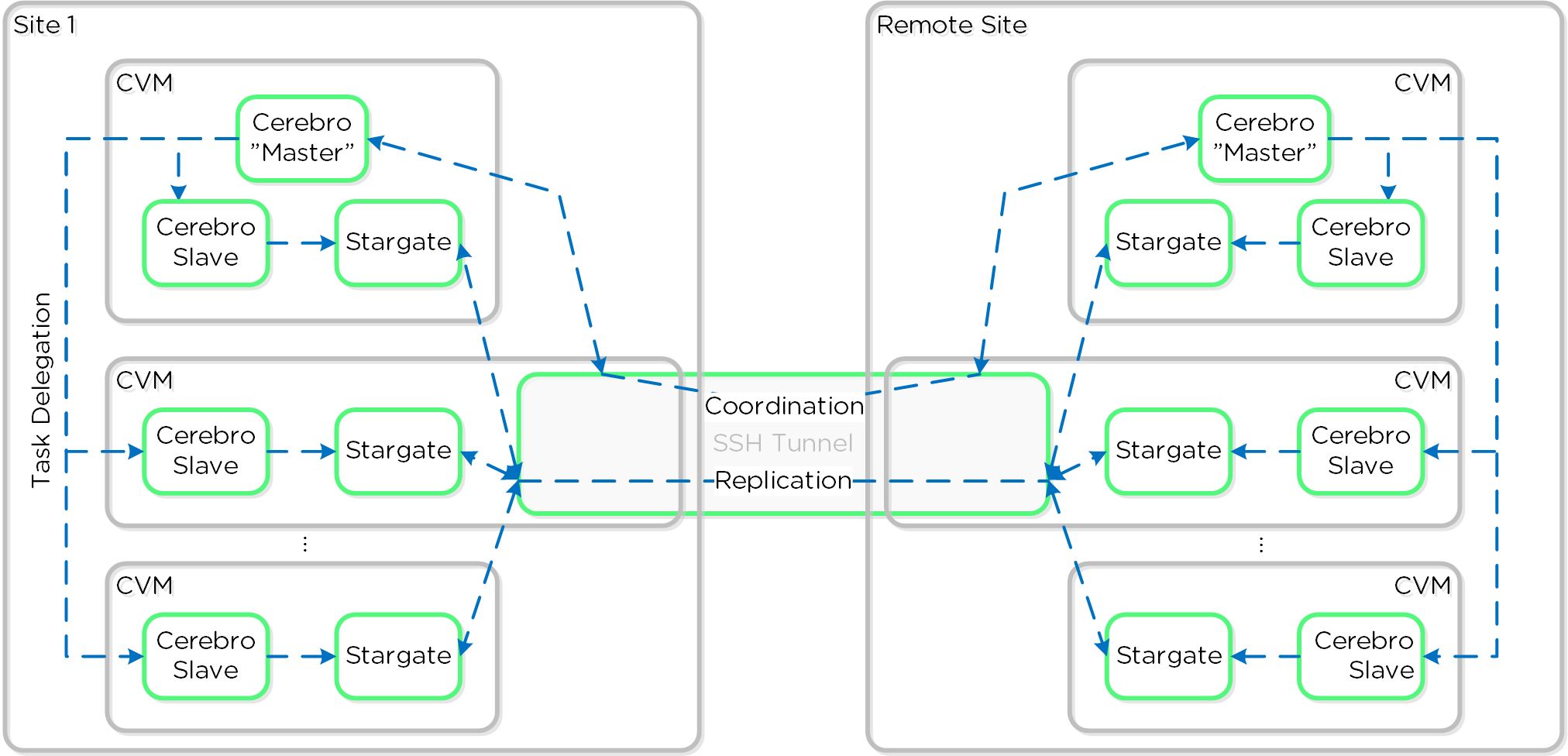

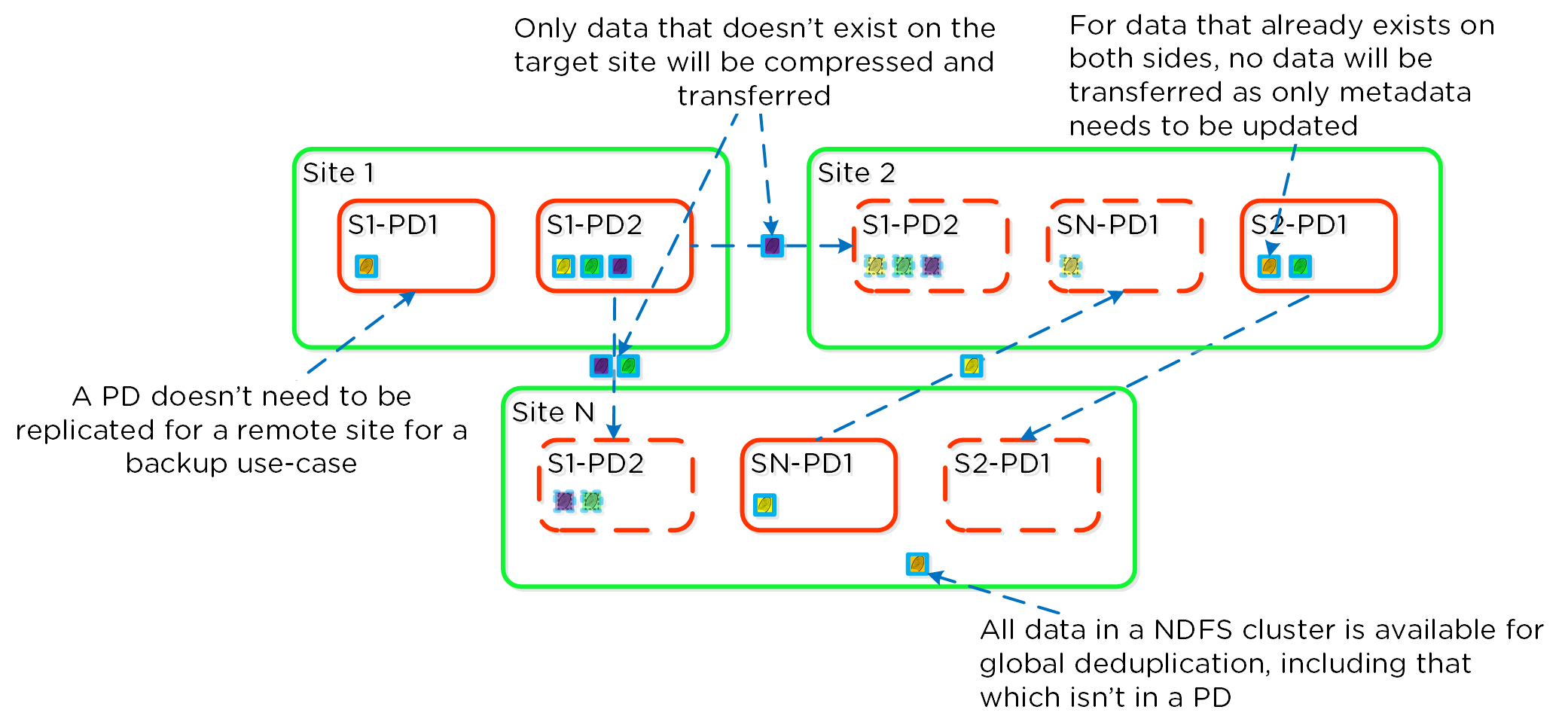

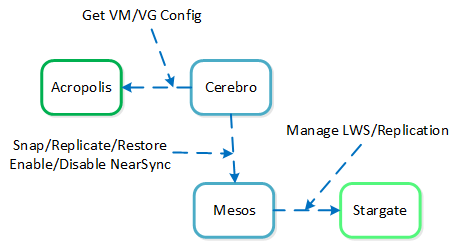

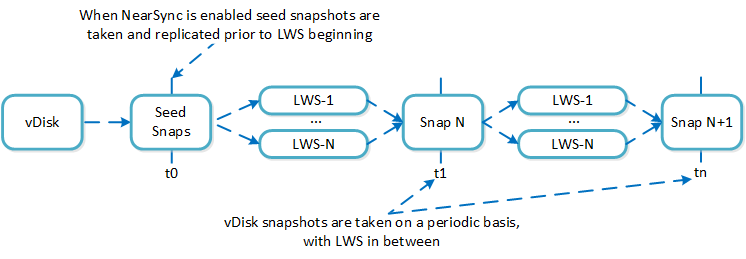

세레브로 (Cerebro)

- 주요 역할: 복제/DR 매니저

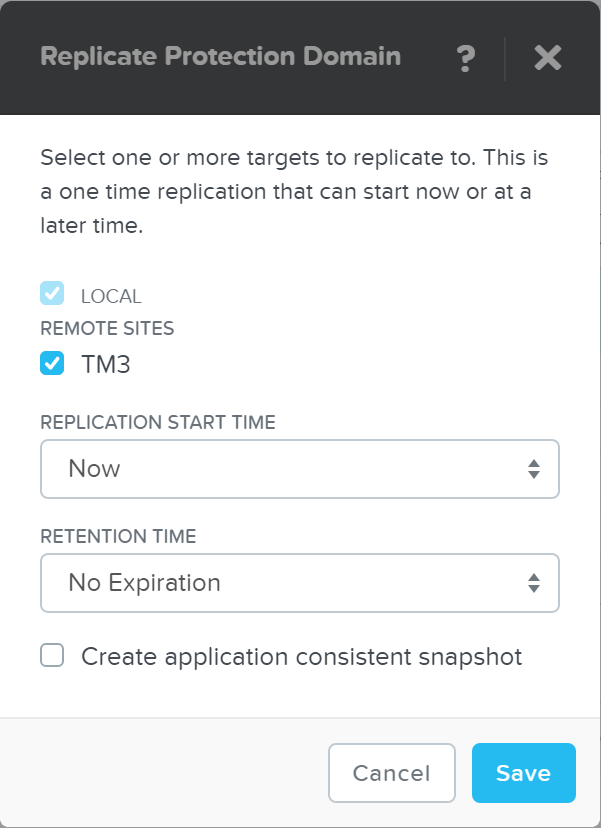

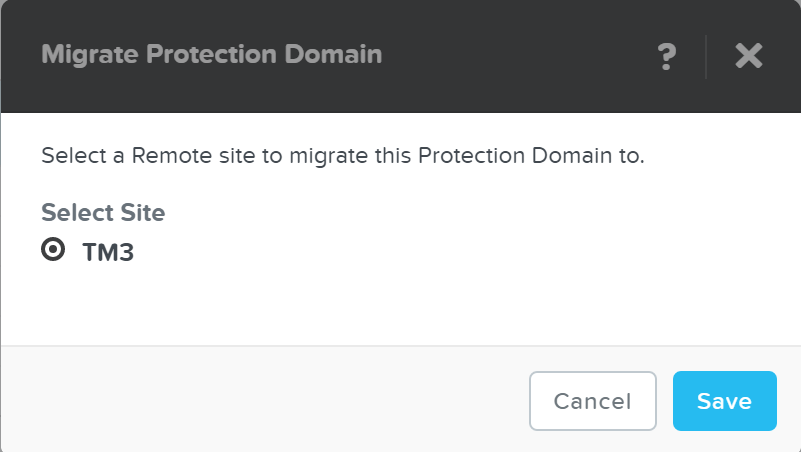

- 설명: 세레브로는 DSF의 복제 및 DR 기능을 담당한다. 여기에는 스냅샷 스케줄링, 원격 사이트로의 복제, 사이트 마이그레이션/페일오버가 포함된다. 세레브로는 클러스터의 모든 노드에서 실행되며 모든 노드가 원격 클러스터/사이트로의 복제에 참여한다.

피토스 (Pithos)

- 주요 역할: vDisk 설정 매니저

- 설명: 피토스는 vDisk (DSF에서 파일) 설정 데이터를 담당한다. 피토스는 모든 노드에서 실행되며 카산드라를 기반으로 구현되었다.

무중단 업그레이드

Book of Prism의 '뉴타닉스 소프트웨어 업그레이드' 및 '하이퍼바이저 업그레이드' 섹션에서 AOS 및 하이퍼바이저 버전 업그레이드를 수행하는 데 사용되는 단계를 강조하였다. 본 섹션에서는 다양한 유형의 업그레이드를 무중단 방식으로 수행할 수 있는 기술에 대해 다룬다.

AOS 업드레이드

AOS 업그레이드의 경우 수행되는 몇 가지 핵심 단계가 있다.

1 - 업그레이드 사전 검사

업그레이드 사전 검사 중에 다음 항목이 검증된다. NOTE: 업그레이드를 계속하려면 이 작업이 성공적으로 완료되어야 한다.

- AOS, 하이퍼바이저 버전 간의 버전 호환성 확인

- 클러스터 헬스 체크 (클러스터 상태, 여유 공간) 및 컴포넌트 체크 (e.g. 메두사, 스타게이트, 주키퍼 등)

- 모든 CVM과 하이퍼바이저 간의 네트워크 연결 확인

2 - 업그레이드 소프트웨어를 두 노드에 업로드

업그레이드 사전 검사가 완료되면 시스템은 업그레이드 소프트웨어 바이너리를 클러스터의 두 노드에 업로드한다. 이것은 폴트-톨러런스를 위해 수행되는데 하나의 CVM이 재부팅하면 다른 CVM이 다른 소프트웨어를 가져올 수 있도록 한다.

3 - 업그레이드 소프트웨어 단계

소프트웨어가 두 CVM에 업로드되면 모든 CVM은 병렬로 업그레이드를 준비한다.

CVM에는 AOS 버전 용으로 두 개의 파티션이 있다.

- 활성 파티션 (Active Partition) - 현재 실행 중인 버전

- 수동 파티션 (Passive Partition) - 업그레이드가 준비되는 곳

AOS 업그레이드가 발생하면 비횔성 파티션에서 업그레이드를 수행한다. 업그레이드 토큰이 수신되면 업그레이드된 파티션을 액티브 파티션으로 표시하고 CVM을 업그레이드된 버전으로 재부팅한다. 이는 bootbank / altbootbank와 유사하다.

NOTE: 업그레이드 토큰은 노드 간에 반복적으로 전달된다. 이를 통해 한 번에 하나의 CVM만 재부팅한다. CVM이 재부팅되고 안정되면(서비스 상태 및 통신 확인) 모든 CVM이 업그레이드될 때까지 토큰을 다음 CVM으로 전달할 수 있다.

Note

업그레이드 오류 처리 (Upgrade Error Handling)

일반적인 질문은 업그레이드가 성공적이지 않거나 부분적으로 프로세스에 이슈가 있으면 무슨 일이 발생하는가에 대한 것이다.

일부 업그레이드 이슈가 발생할 경우 업그레이드는 중지되고 진행되지 않는다. NOTE: 업그레이드가 실제로 시작되기 전에 업그레이드 사전 검사에서 대부분의 문제를 발견할 수 있기 때문에 이는 매우 드문 경우이다. 그러나 업그레이드 사전 검사가 성공하고 실제 업그레이드 중에 일부 문제가 발생할 경우 클러스터에서 실행 중인 워크로드 및 사용자 I/O에 아무런 영향을 미치지 않는다.

뉴타닉스 소프트웨어는 지원되는 업그레이드 버전 간에 혼합 모드로 무기한 동작하도록 설계되었다. 예를 들어 클러스터가 x.y.foo를 실행 중이고 x.y.bar로 업그레이드하는 경우 시스템은 두 버전 모두에서 CVM을 무기한 실행할 수 있다. 이것은 실제로 업그레이드 프로세스 중에 발생한다.

예를 들어 x.y.foo로 실행 중인 4노드 클러스터를 x.y.bar로 업그레이드를 시작한 경우 첫 번째 노드를 업그레이드하면 첫 번째 노드는 x.y.bar가 실행되고 다른 노드는 x.y.foo가 실행된다. 이 프로세스는 계속 진행되고 CVM은 업그레이드 토큰을 받을 때 x.y.bar로 재부팅된다.

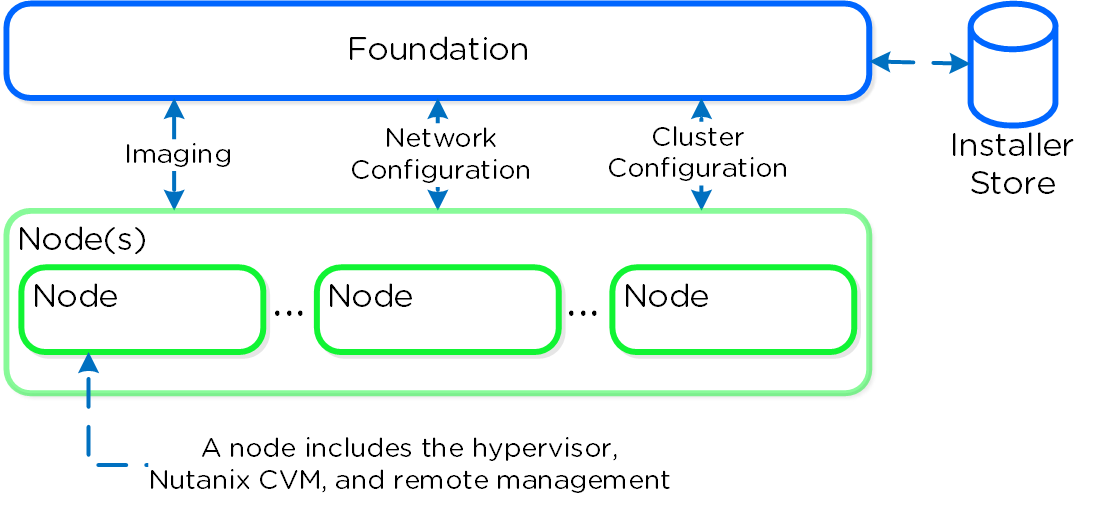

파운데이션 (이미징)

파운데이션 이미징 아키텍처

파운데이션(Foundation)은 뉴타닉스 클러스터의 부트스트래핑, 이미징 및 배포를 위해 활용되는 뉴타닉스 제공 툴이다. 이미징 프로세스는 선택한 하이퍼바이저뿐만 아니라 원하는 버전의 AOS 소프트웨어를 설치한다.

기본적으로 뉴타닉스 노드는 AHV가 사전 설치되어 제공되므로 다른 하이퍼바이저 유형을 활용하려면 파운데이션을 사용하여 노드를 원하는 하이퍼바이저로 재이미징해야 한다. NOTE: 일부 OEM 제품은 원하는 하이퍼바이저로 공장에서 직접 배송된다.

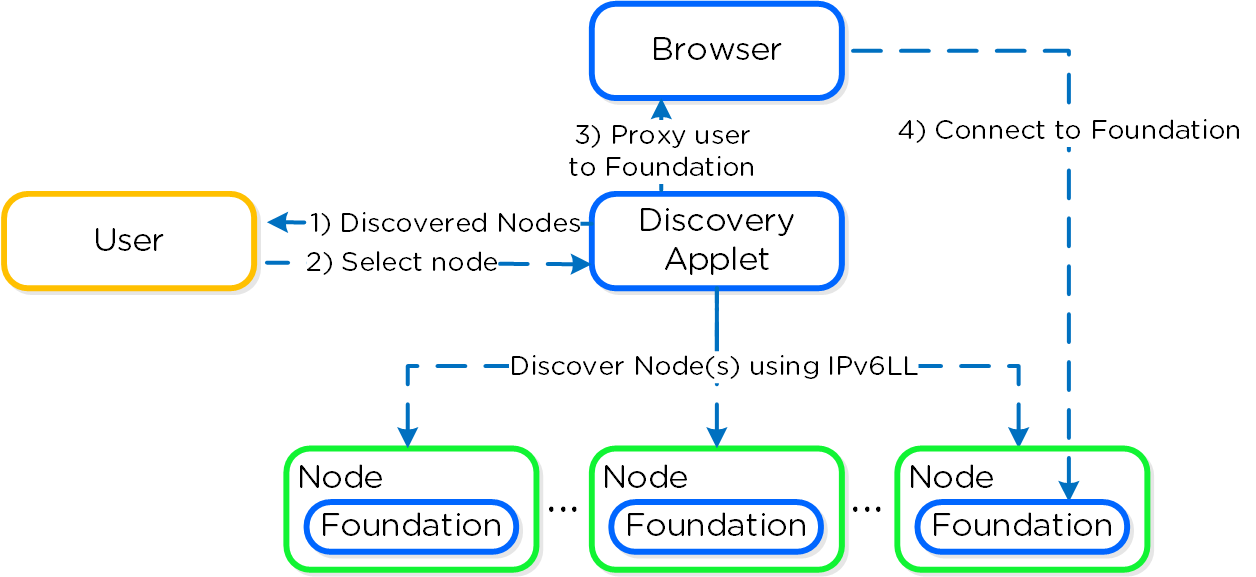

파운데이션 아키텍처의 하이-레벨 뷰는 다음 그림과 같다.

파운데이션 - 아키텍처 (Foundation - Architecture)

파운데이션 - 아키텍처 (Foundation - Architecture)

AOS 4.5 버전부터 파운데이션은 설정을 단순화하기 위해 CVM에 내장되어 있다. 인스톨러 스토어(Installer Store)는 업로드된 이미지를 저장하기 위한 디렉토리로 이미징이 필요할 때 클러스터 확장뿐만 아니라 초기 이미징을 위해 사용된다.

파운데이션 디스커버리 애플릿(여기에서 찾을 수 있음: HERE)은 노드를 검색하고 사용자가 연결할 노드를 선택할 수 있도록 한다. 사용자가 연결할 노드를 선택하면 애플릿은 localhost:9442 IPv4를 CVM의 8000번 포트에서 IPv6 링크 로컬 주소에 프록시한다.

애플릿 아키텍처의 하이-레벨 뷰는 다음 그림과 같다.

파운데이터션 - 애플릿 아키텍처 (Foundation - Applet Architecture)

파운데이터션 - 애플릿 아키텍처 (Foundation - Applet Architecture)

NOTE: 디스커버리 애플릿(Discovery Applet)은 노드에서 실행되는 파운데이션 서비스의 검색 및 프록시의 수단일 뿐이다. 모든 이미징 및 설정은 애플릿이 아닌 파운데이션 서비스에 의해 처리된다.

Note

Pro tip

타깃 뉴타닉스 노드(e.g. WAN을 통해)와 다른 네트워크를 사용하는 경우(L2) IPv4 주소가 할당된 CVM의 파운데이션 서비스에 직접 연결할 수 있다 (디스커버리 애플릿을 사용하는 대신에).

직접 연결을 위해 <CVM_IP>:8000/gui/index.html을 사용한다.

입력 (Inputs)

파운데이션 툴은 설정을 위해 다음과 같은 입력 값을 가진다 (아래). 일반적인 배포에는 노드 당 3개의 IP 주소가 필요하다 (하이퍼바이저, CVM, 원격 관리(e.g. IPMI, iDRAC 등)). 노드 별 주소 외에 클러스터 가상 IP와 데이터 서비스 IP를 설정하는 것이 좋다.

- 클러스터 (Cluster)

- 이름 (Name)

- IP*

- NTP*

- DNS*

- CVM

- CVM 당 IP (IP per CVM)

- 넷마스크 (Netmask)

- 게이트웨이 (Gateway)

- 메모리 (Memory)

- 하이퍼바이저 (Hypervisor)

- 하이퍼바이저 호스트 당 IP (IP per hypervisor host)

- 넷마스크 (Netmask)

- 게이트웨이 (Gateway)

- DNS*

- 호스트 이름의 접두사 (Hostname prefix)

- IPMI*

- 노드 당 IP (IP per node)

- 넷마스크 (Netmask)

- 게이트웨이 (Gateway)

NOTE: “*”로 표시된 항목은 선택 사항이지만 매우 권장됨

시스템 이미징 및 배포 (System Imaging and Deployment)

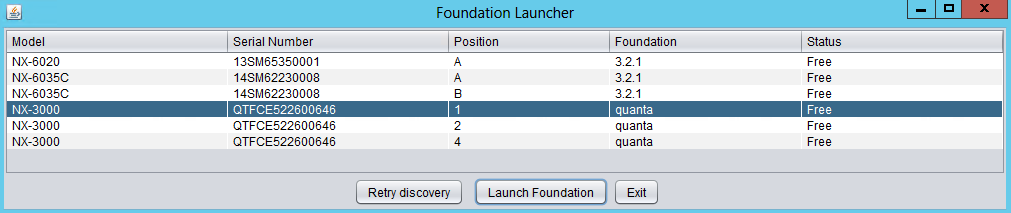

첫 번째 단계는 디스커버리 애플릿을 통해 수행할 수 있는 파운데이션 UI에 연결하는 것이다 (동일 L2에 있는 경우 노드 IP는 필요 없음).

파운데이션 - 디스커버리 애플릿 (Foundation - Discovery Applet)

파운데이션 - 디스커버리 애플릿 (Foundation - Discovery Applet)

원하는 노드를 찾을 수 없는 경우 동일 L2 네트워크에 있는지 확인한다.

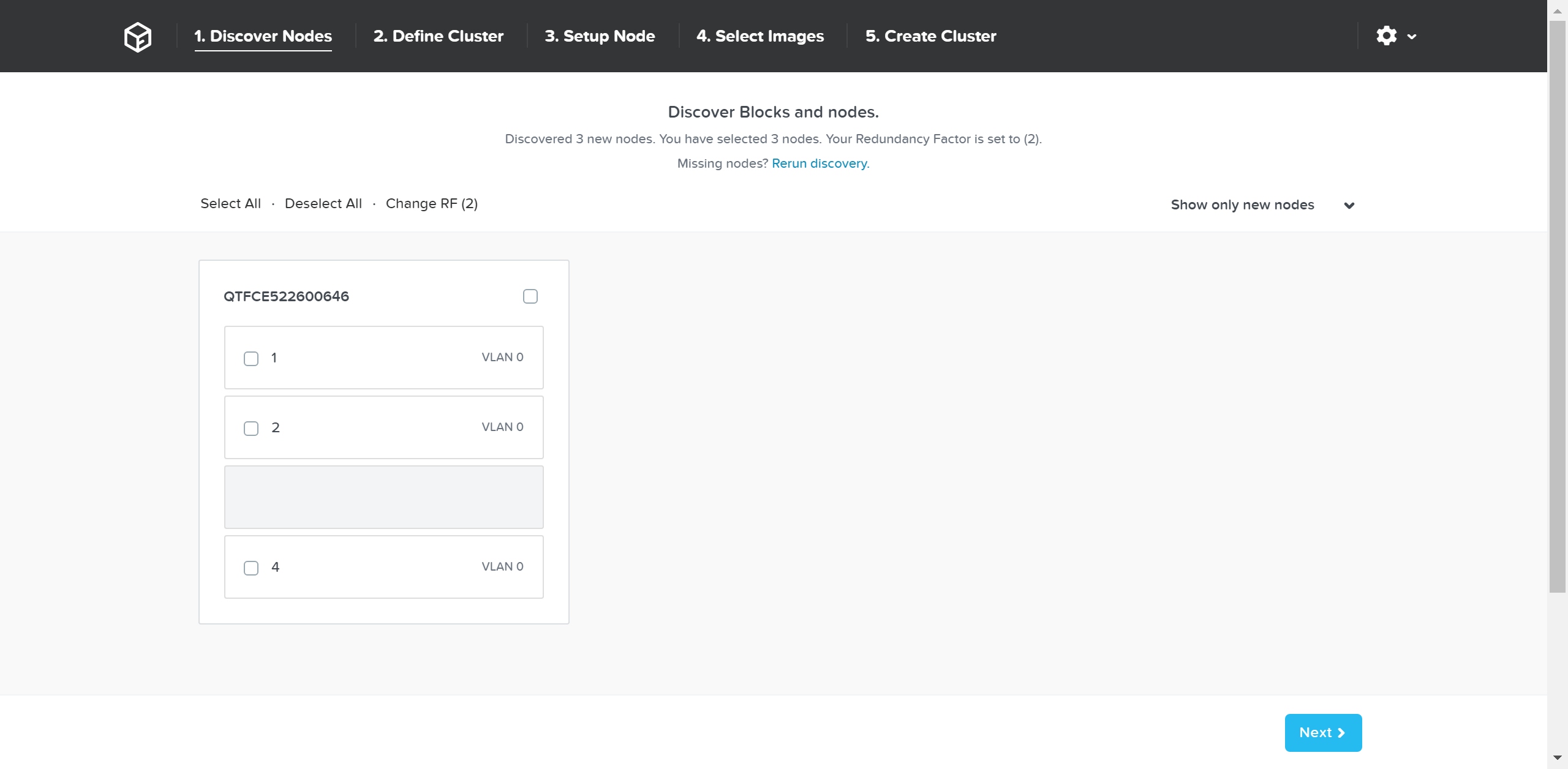

선택한 노드의 파운데이션 인스턴스에 연결하면 메인 파운데이션 UI가 나타난다.

파운데이션 - 디스커버리 페이지 (Foundation - Discovery Page)

파운데이션 - 디스커버리 페이지 (Foundation - Discovery Page)

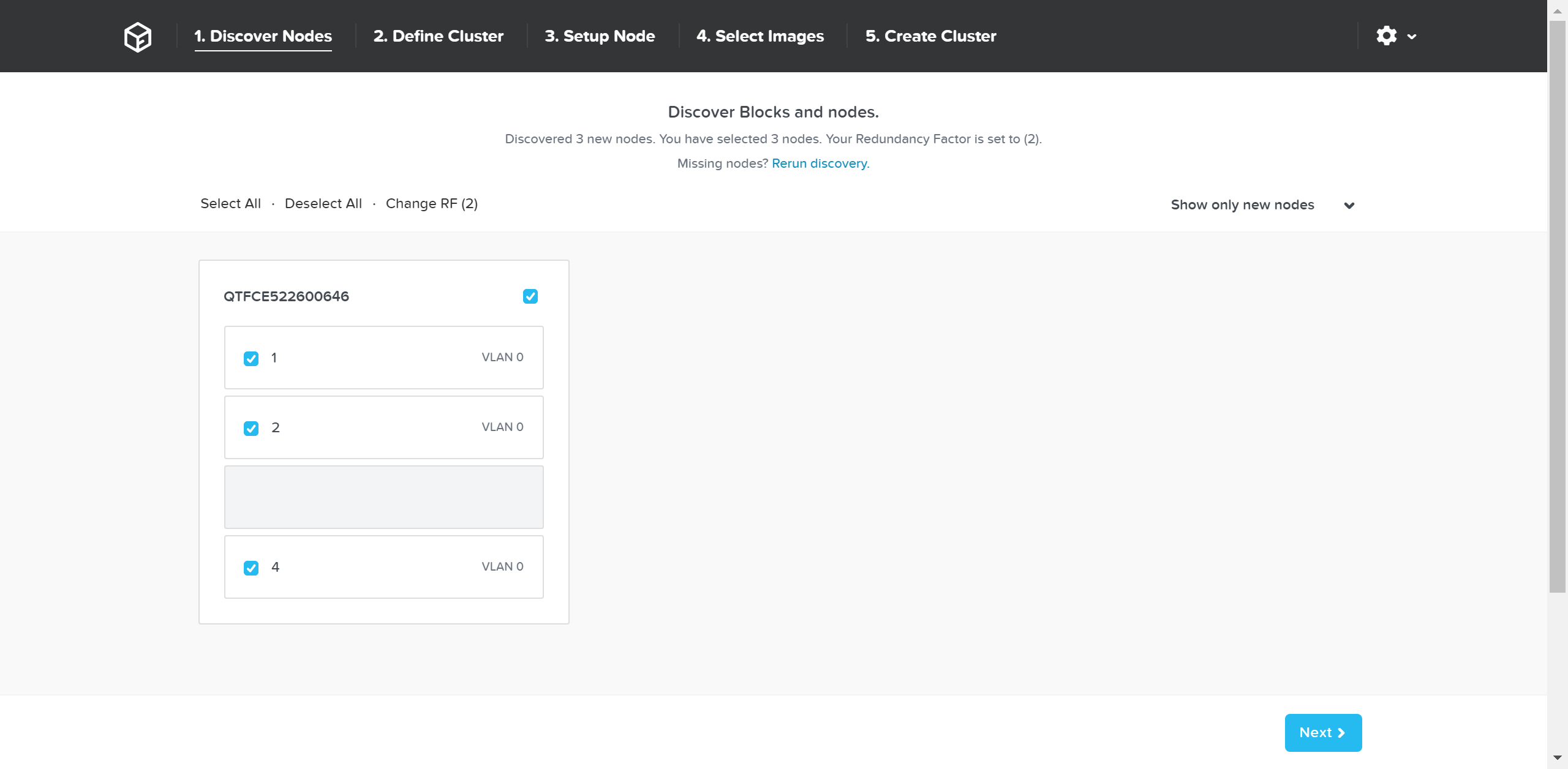

검색된 모든 노드와 해당 섀시가 표시된다. 클러스터를 구성할 노드를 선택하고 “Next” 버튼을 클릭한다.

파운데이션 - 노드 선택 (Foundation - Node Selection)

파운데이션 - 노드 선택 (Foundation - Node Selection)

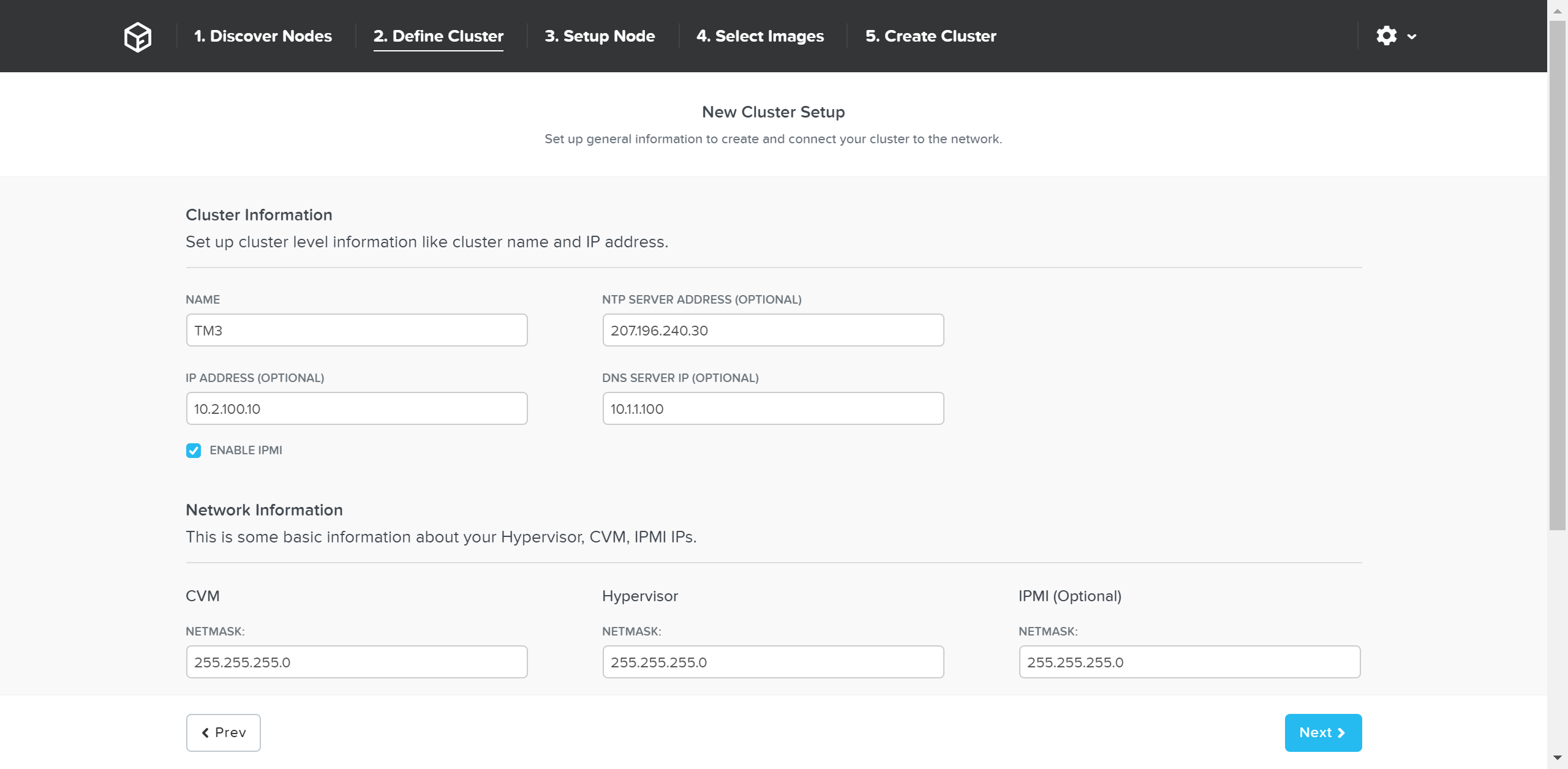

다음 페이지는 클러스터 및 네트워크 입력을 요구한다.

파운데이션 - 클러스터 정보 (Foundation - Cluster Information)

파운데이션 - 클러스터 정보 (Foundation - Cluster Information)

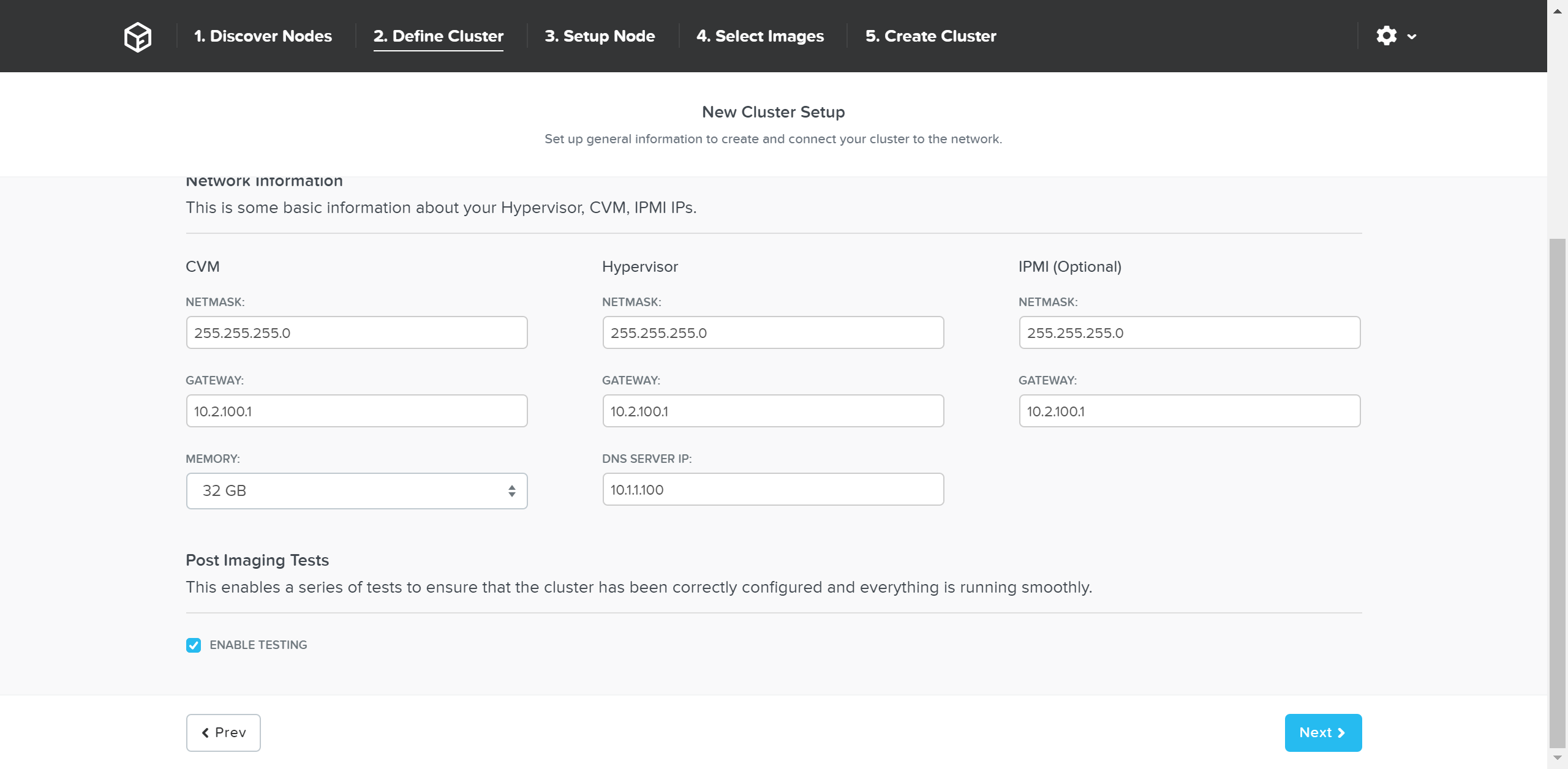

파운데이션 - 네트워크 정보 (Foundation - Network Information)

파운데이션 - 네트워크 정보 (Foundation - Network Information)

세부 정보를 입력한 후에 “Next” 버튼을 클릭한다.

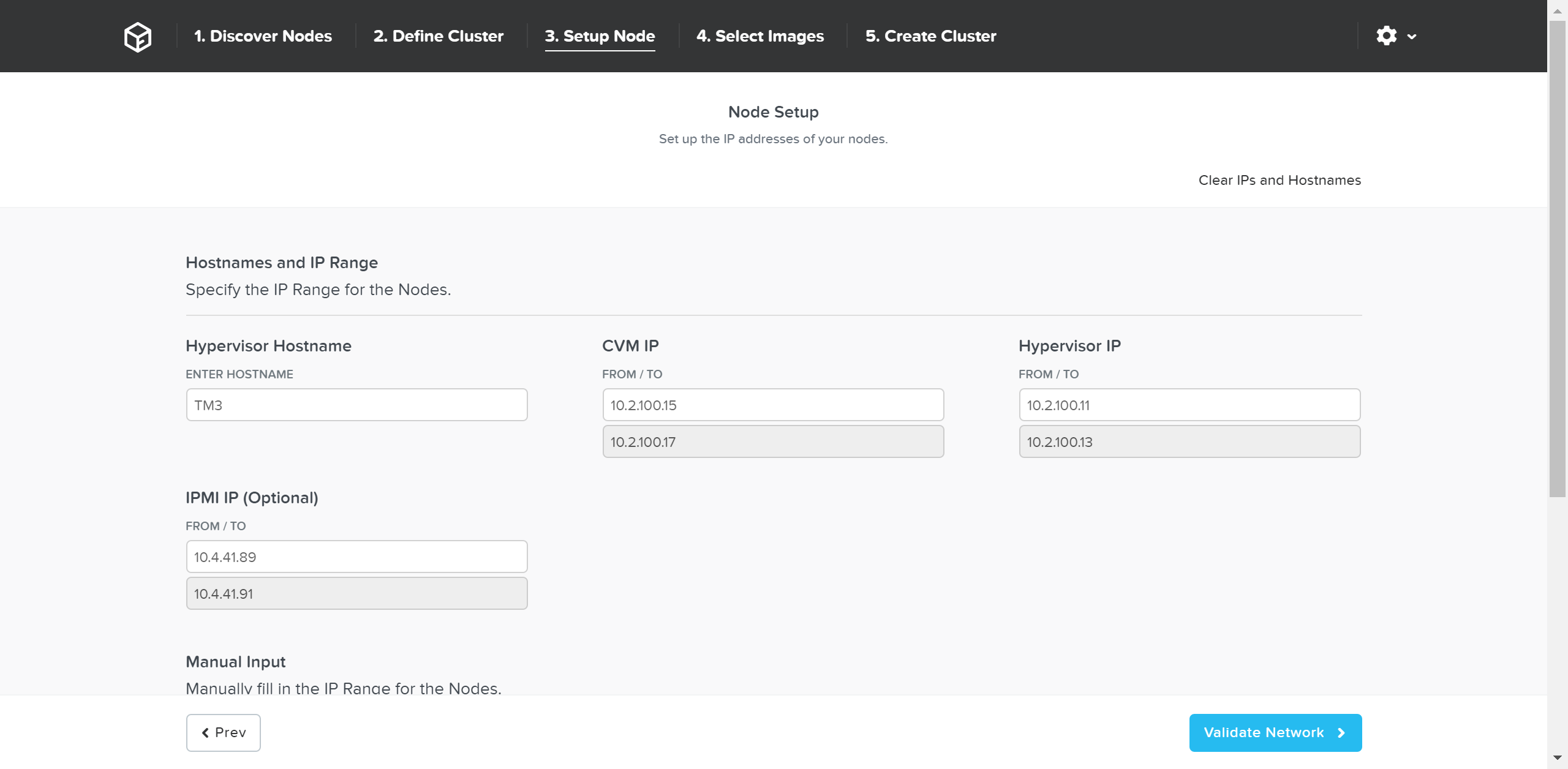

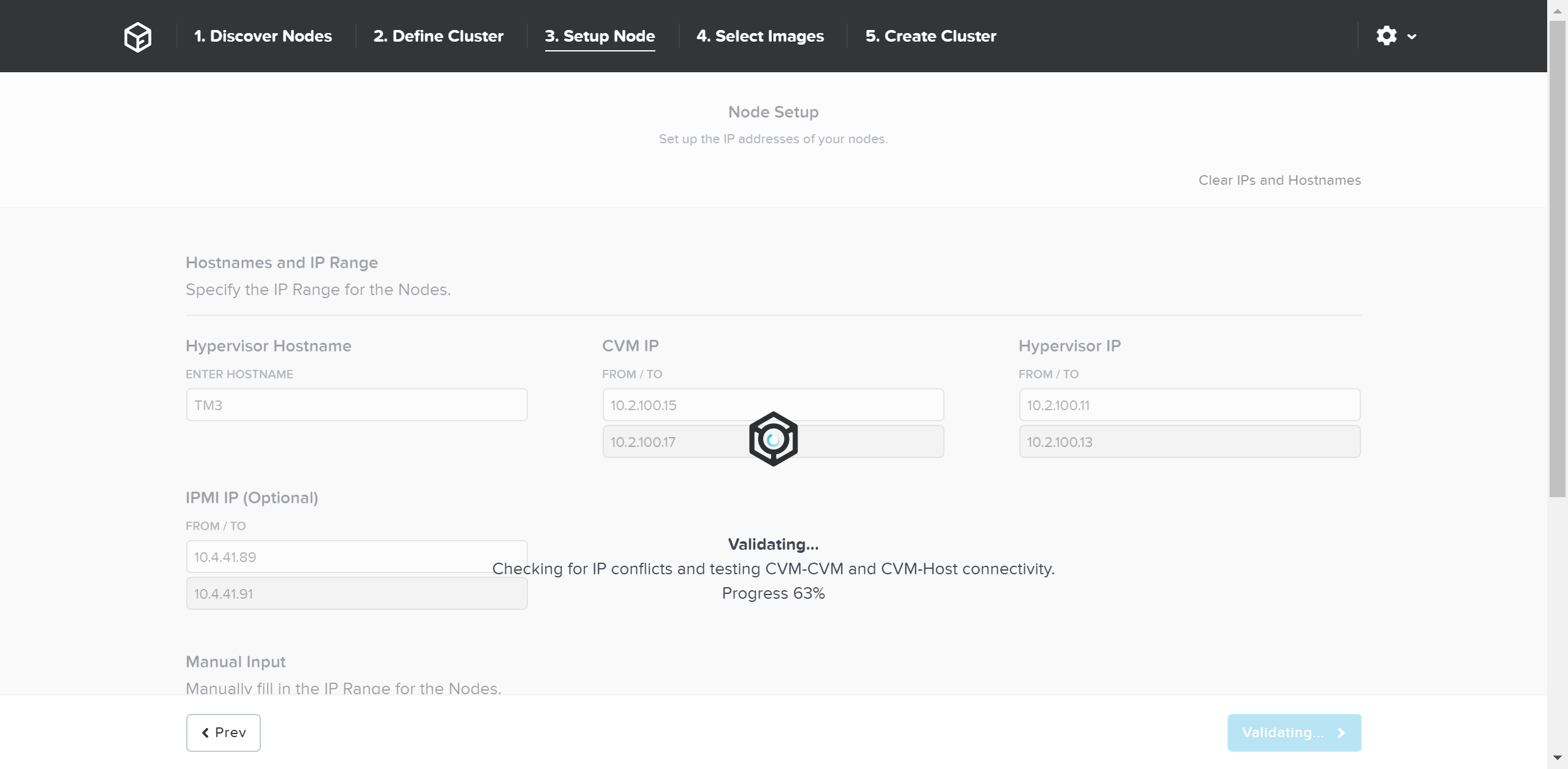

다음으로 노드 세부 정보와 IP 주소를 입력한다.

파운데이션 - 노드 설정 (Foundation - Node Setup)

파운데이션 - 노드 설정 (Foundation - Node Setup)

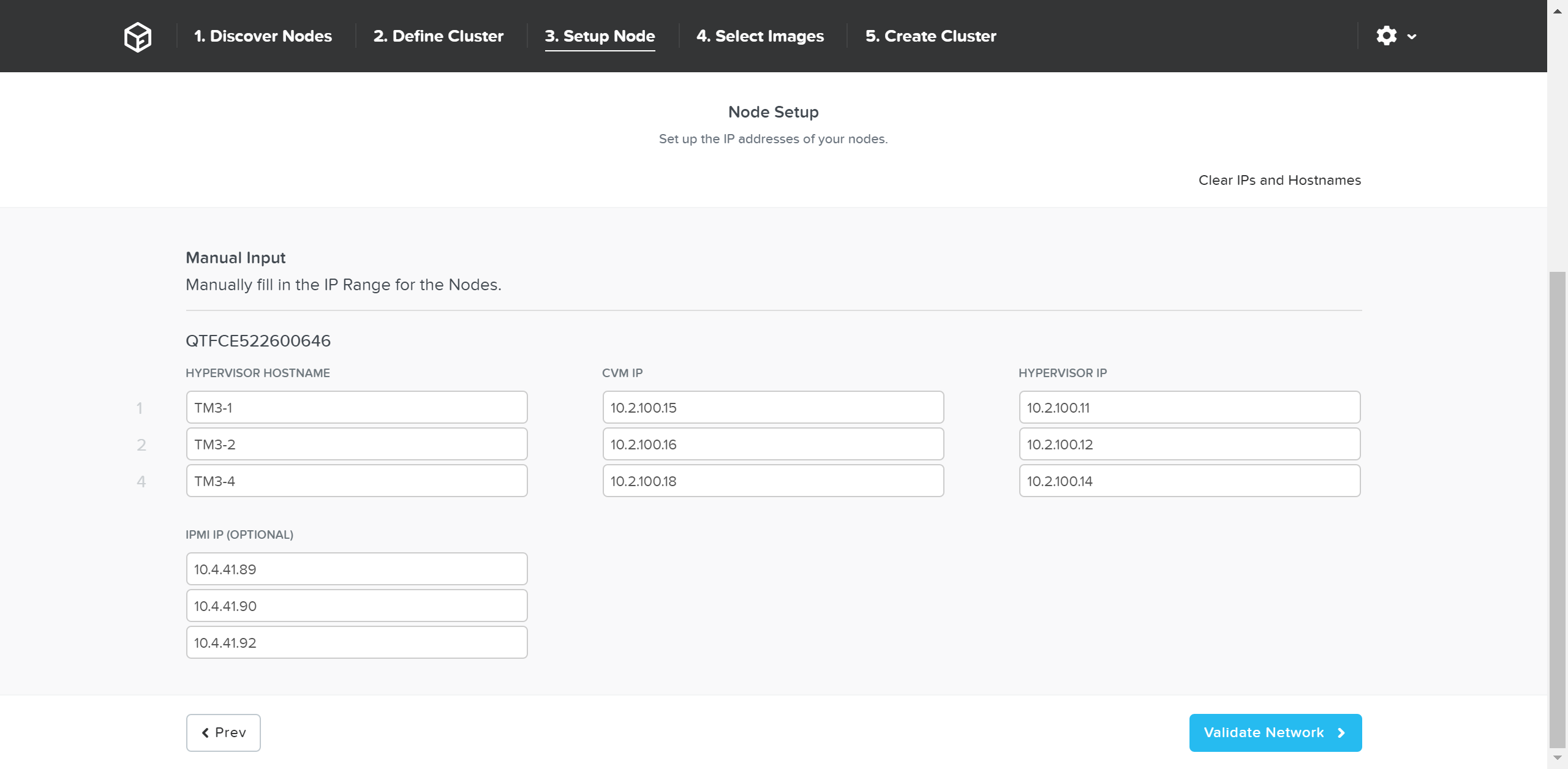

필요한 경우 호스트 이름과 IP 주소를 수동으로 재정의할 수 있다.

파운데이션 - 호스트 이름 및 IP (Foundation - Hostname and IP)

파운데이션 - 호스트 이름 및 IP (Foundation - Hostname and IP)

네트워크 설정을 검증하고 진행하려면 “Validate Network” 버튼을 클릭한다. 이를 통해 IP 주소 충돌을 체크하고 연결을 보장한다.

파운데이션 - 네트워크 검증 (Foundation - Network Validation)

파운데이션 - 네트워크 검증 (Foundation - Network Validation)

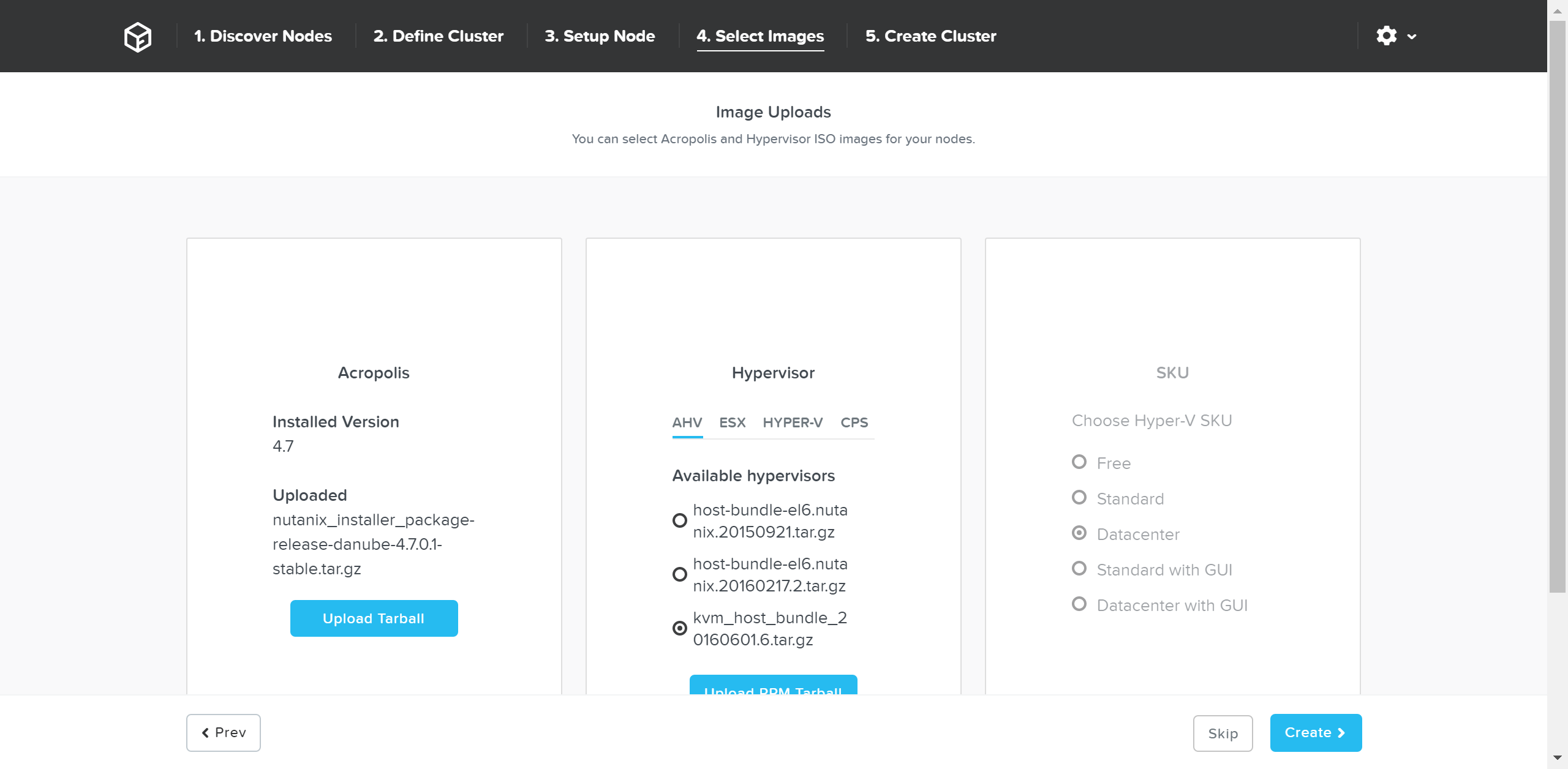

네트워크 검증이 성공적으로 완료되면 이제 원하는 이미지를 선택한다.

AOS를 현재 CVM에 있는 것보다 최신 버전으로 업그레이드하려면 포털에서 다운로드하고 Tarball을 업로드한다. 원하는 AOS 이미지를 얻은 후에 하이퍼바이저를 선택한다.

AHV의 경우 이미지는 AOS 이미지에 내장되어 있다. 다른 하이퍼바이저인 경우, 원하는 하이퍼바이저 이미지를 업로드해야 한다. NOTE: AOS와 하이퍼바이저 버전이 호환성 매트릭스(LINK)에 있는지 확인한다.

원하는 이미지가 있으면 “Create” 버튼을 클릭한다.

파운데이션 - 이미지 선택 (Foundation - Select Images)

파운데이션 - 이미지 선택 (Foundation - Select Images)

이미징이 필요하지 않은 경우 “Skip”을 클릭하여 이미징 프로세스를 건너뛸 수 있다. 이렇게 하면 하이퍼바이저 및 뉴타닉스 클러스터를 재이미징하지 않고 단지 클러스터만(e.g. IP 주소 등) 설정한다 .

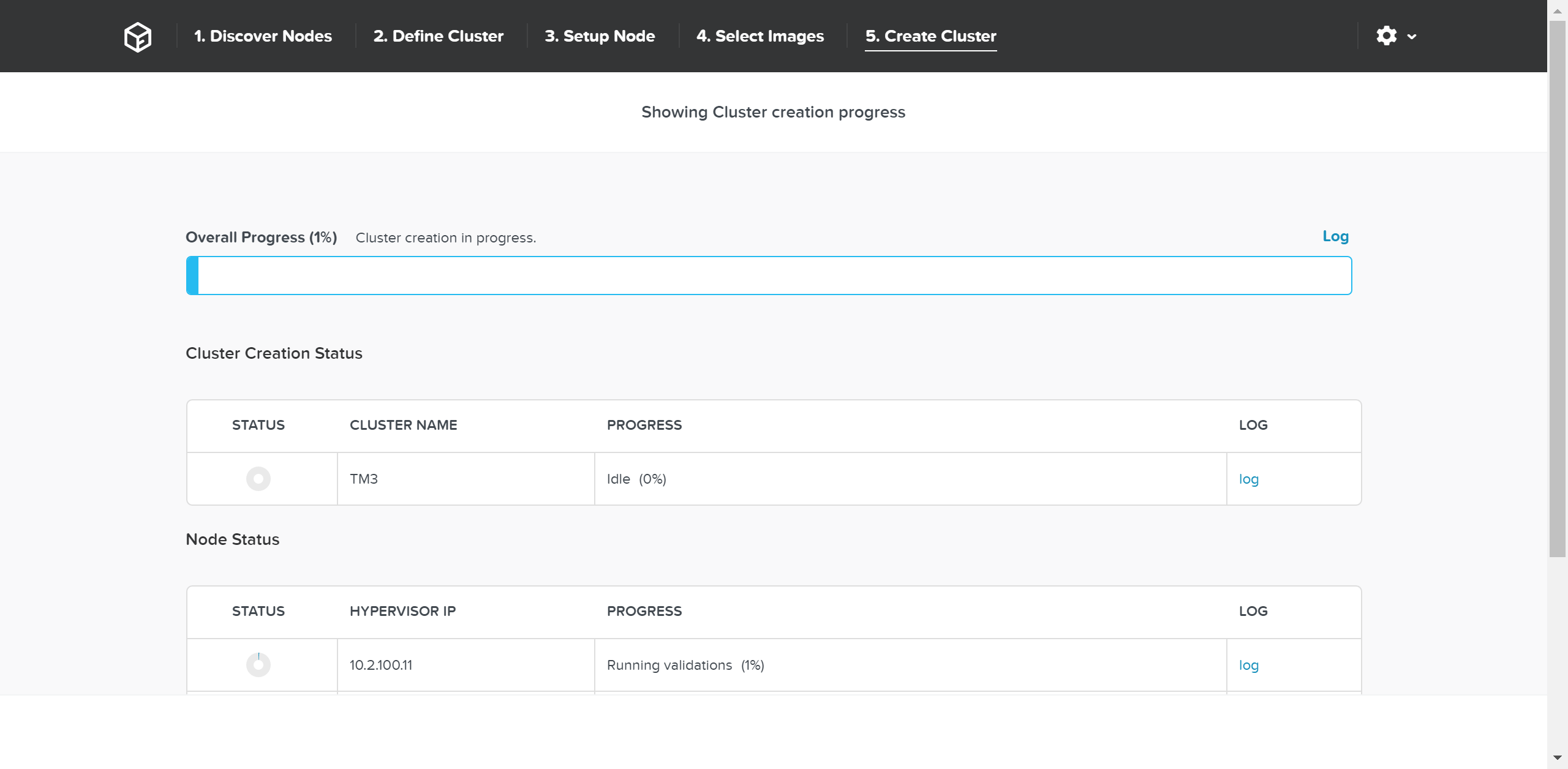

그런 다음 파운데이션은 이미징 (필요한 경우) 및 클러스터 생성 프로세스를 진행한다.

파운데이션 - 클러스터 생성 프로세스 (Foundation - Cluster Creation Process)

파운데이션 - 클러스터 생성 프로세스 (Foundation - Cluster Creation Process)

클러스터 생성이 성공하면 완료 화면이 나타난다.

파운데이션 - 클러스터 생성 완료 (Foundation - Cluster Creation Complete)

파운데이션 - 클러스터 생성 완료 (Foundation - Cluster Creation Complete)

이제 임의의 CVM 또는 클러스터 가상 IP에 로그인하여 뉴타닉스 플랫폼을 사용할 수 있다.

드라이브 분해

본 섹션에서는 다양한 스토리지 디바이스(성능(NVMe/SSD) / 용량(SSD/HDD))가 뉴타닉스 플랫폼에 의해 어떻게 분할되고, 파티션되고, 활용되는지를 다룬다. NOTE: 사용된 모든 용량은 Base10 Gigabyte (GB)가 아닌 Base2 Gibibyte (GiB)를 기반으로 한다. 파일 시스템을 위한 드라이브 포맷팅 및 관련된 오버헤드를 고려하였다.

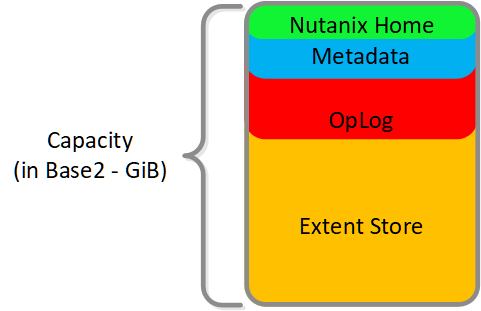

성능 디바이스

성능 디바이스는 노드에서 최고 성능의 디바이스이다. 성능 디바이스는 NVME 또는 NVME와 SSD의 혼합으로 구성될 수 있다. 성능 디바이스는 위에 자세히 설명된 몇 가지 주요 아이템을 저장한다.

- 뉴타닉스 홈 (CVM 코어)

- 메타데이터 (카산드라 / AES 스토리지)

- OpLog (영구 쓰기 버퍼)

- 익스텐트 스토어 (영구 스토리지)

다음 그림은 뉴타닉스 노드의 성능 디바이스(Performance Devices)에 대한 스토리지 분할의 예를 보여준다.

성능 드라이브 분해 (Performance Drive Breakdown)

성능 드라이브 분해 (Performance Drive Breakdown)

그래픽과 비율은 실제 크기에 맞게 그려지지 않았다. Remaining GiB GiB 용량은 탑-다운 방식으로 계산한다. 예를 들어, OpLog 계산에 사용될 Remaining GiB는 포맷된 SSD 용량에서 뉴타닉스 홈과 카산드라를 차감한 이후의 것이다.

뉴타닉스 홈(Nutanix Home)은 가용성을 보장하기 위해 처음 두 개의 SSD에 미러링되며 두 디바이스에 60GiB의 용량이 할당되어 있다.

AOS 5.0에서 카산드라는 SSD 당 15GiB의 초기 예약으로 노드의 여러 SSD(현재 최대 4개)에 분할된다 (메타데이터 사용이 증가하는 경우 일부 스타케이트 SSD를 활용할 수 있음). 듀얼 SSD 시스템에서 메타데이터는 SSD 간에 미러링된다. SSD 당 메타데이터 예약은 15GiB(듀얼 SSD의 경우 30GiB, 4+ SSD의 경우 60GiB)이다.

AOS 5.0 이전에는 카산드라가 기본적으로 첫 번째 SSD에 있었고, SSD에 장애가 발생하면 CVM이 다시 시작되고 카산드라 스토리지가 두 번째에 있었다. 이 경우 SSD 당 메타데이터 예약은 처음 두 디바이스에 대해 30GiB이다.

OpLog는 모든 SSD 디바이스에 노드 당 최대 12개까지 분배된다(Gflag : max_ssds_for_oplog). NVMe 디바이스를 사용할 수 있는 경우 OpLog는 SATA SSD 대신 NVME 디바이스에 배치된다.

디스크 당 OpLog 예약은 다음 공식을 사용하여 계산할 수 있다: MIN (((Max cluster RF / 2) * 400 GiB) / numDevForOplog), ((Max cluster RF / 2) * 25 %) x Remaining GiB). NOTE: OpLog 사이징은 AOS 4.0.1부터 동적으로 수행되므로 익스텐트 스토어(Extent Store) 부분이 동적으로 커질 수 있다. 사용된 값은 완전히 활용된 OpLog를 가정한다.

예를 들어, 1TB인 SSD 디바이스가 8개인 RF2(FT1) 클러스터에서 계산된 결과는 다음과 같다.

- MIN(((2/2)*400 GiB)/ 8), ((2/2)*25%) x ~900GiB) == MIN(50, 225) == 디바이스 당 OpLog에 50GiB가 예약됨

RF3(FT2) 클러스터의 경우는 다음과 같다.

- MIN(((3/2)*400 GiB)/ 8), ((3/2)*25%) x ~900GiB) == MIN(75, 337) == 디바이스 당 OpLog에 75GiB가 예약됨

1TB인 4개의 NVMe와 8개의 SSD 디바이스가 있는 RF2(FT1) 클러스터의 경우 결과는 다음과 같다.

- MIN(((2/2)*400 GiB)/ 4), ((2/2)*25%) x ~900GiB) == MIN(100, 225) == 디바이스 당 OpLog에 100GiB가 예약됨

익스텐트 스토어(Extent Store) 용량은 다른 모든 예약이 고려된 후 남은 용량이다.

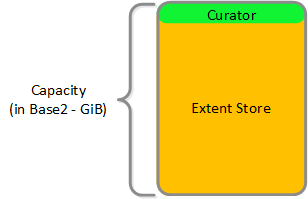

HDD 디바이스

HDD 디바이스는 기본적으로 대용량의 스토리지로 사용되기 때문에 분할이 훨씬 간단하다.

- 큐레이터 예약 (큐레이터 스토리지)

- 익스텐트 스토어 (영구 스토리지)

HDD 드라이브 분해 (HDD Drive Breakdown)

HDD 드라이브 분해 (HDD Drive Breakdown)

Book of Prism

prism - /’prizɘm/ - noun - control plane

데이터센터 운영을 위한 원클릭 관리 및 인터페이스.

아름답고 공감적이며 직관적인 제품을 만드는 것이 뉴타닉스 플랫폼의 핵심이며 뉴타닉스가 진지하게 고민하는 것이다. 본 섹션에서 설계 방법론과 설계 반복 과정에 대해 다룬다.

뉴타닉스 비지오 스텐실은 다음 링크에서 다운로드할 수 있다: http://www.visiocafe.com/nutanix.htm

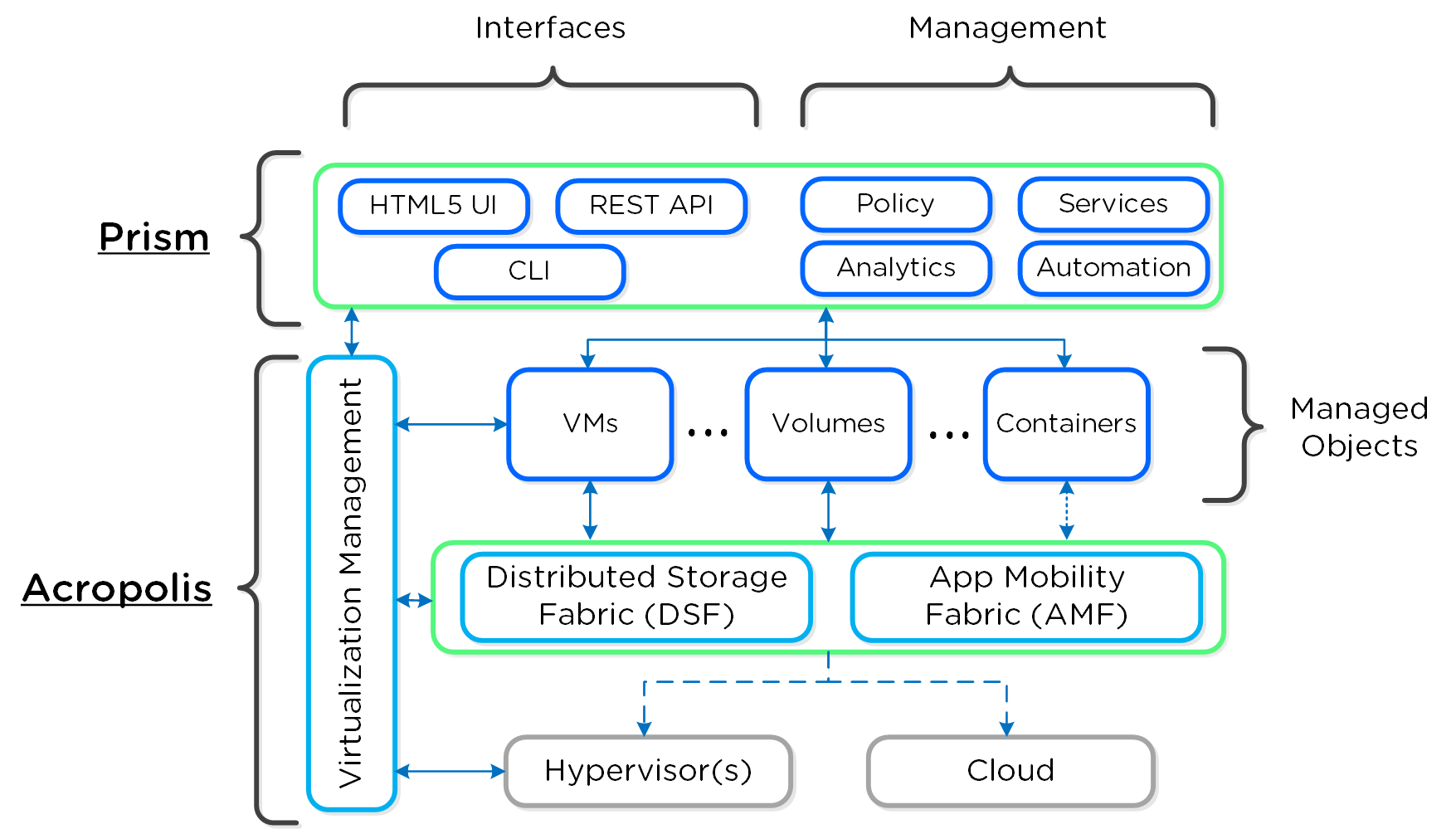

프리즘 아키텍처

프리즘은 분산 리소스 관리 플랫폼으로, 사용자는 로컬 또는 클라우드에서 호스팅되는 뉴타닉스 환경에서 오브젝트 및 서비스를 관리하고 모니터링 할 수 있다.

이러한 기능은 두 가지 주요 카테고리로 구분된다.

- 인터페이스 (Interfaces)

- HTML5 UI, REST API, CLI, PowerShell CMDlets 등

- 관리 기능 (Management Capabilities)

- 플랫폼 관리, VM/컨테이너 CRUD, 정책 정의 및 규정 준수, 서비스 디자인 및 상태, 분석 및 모니터링

다음 그림은 뉴타닉스 플랫폼의 일부로서 프리즘의 개념적 특성을 보여준다.

하이-레벨 프리즘 아키텍처 (High-Level Prism Architecture)

하이-레벨 프리즘 아키텍처 (High-Level Prism Architecture)

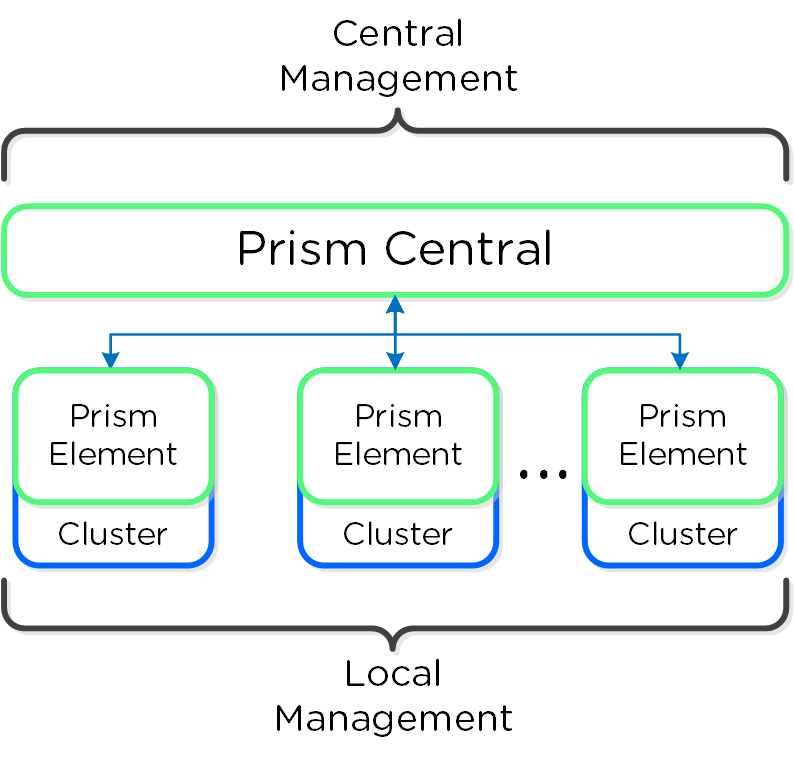

프리즘은 두 가지 메인 컴포넌트로 나뉜다.

- 프리즘 센트럴 (Prism Central: PC)

- 여러 개의 뉴타닉스 클러스터를 관리하기 위한 멀티 클러스터 매니저로 단일 중앙 집중식 관리 인터페이스를 제공한다. 프리즘 센트럴은 AOS 클러스터 (실행 가능) 이외에도 배포할 수 있는 선택적인 소프트웨어 어플라이언스(VM)이다.

- 1-to-Many 클러스터 매니저

- 프리즘 엘리먼트 (Prism Element: PE)

- 로컬 클러스터 관리 및 오퍼레이션을 담당하는 로컬 클러스터 매니저이다. 모든 뉴타닉스 클러스터에는 프리즘 엘리먼트가 내장되어 있다.

- 1-to-1 클러스터 매니저

프리즘 센트럴과 프리즘 엘리먼트의 개념적 관계는 다음 그림과 같다.

프리즘 아키텍처 (Prism Architecture)

프리즘 아키텍처 (Prism Architecture)

Note

Pro tip

대규모 또는 분산 배포(e.g. 1개 이상의 클러스터 또는 여러 개의 사이트)인 경우 오퍼레이션을 단순화하고 모든 클러스터/사이트에 대해 단일 관리 UI를 제공하기 위해 프리즘 센트럴의 사용을 권고한다.

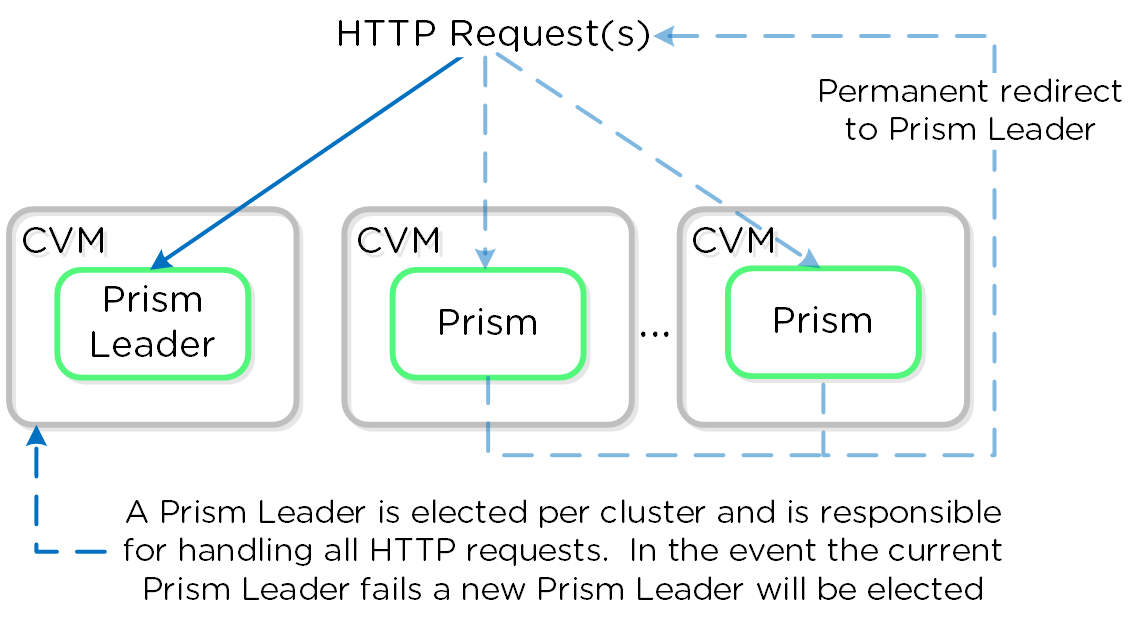

프리즘 서비스

프리즘 서비스는 HTTP 요청의 처리를 담당하는 선출된 프리즘 리더와 함께 모든 CVM에서 실행된다. 리더를 갖는 다른 컴포넌트와 유사하게 프리즘 리더에 장애가 발생하면 새로운 리더가 선출된다. 프리즘 리더가 아닌 CVM이 HTTP 요청을 받으면, HTTP 응답 상태 코드인 “301’을 사용하여 현재 프리즘 리더로 영구적으로 리다이렉트한다.

다음은 프리즘 서비스의 개념과 HTTP 요청 처리 방법을 나타낸 것이다.

프리즘 서비스 – 요청 처리 (Prism Services - Request Handling)

프리즘 서비스 – 요청 처리 (Prism Services - Request Handling)

Note

프리즘 포트 (Prism Ports)

프리즘은 포트 80과 9440에서 수신 대기하며, 만약 HTTP 트래픽이 80번 포트로 들어오면 해당 요청은 9440 포트에서 HTTPS로 리다이렉트된다.

클러스터 가상 IP를 사용할 때(권장) 현재 프리즘 리더가 항상 호스트 한다. 프리즘 리더가 실패하면 클러스터 가상 IP는 새로 선출된 프리즘 리더가 맡게 되며 오래된 ARP 캐시 엔트리를 삭제하기 위해 Gratuitous ARP(gARP)가 사용된다. 이 시나리오에서는 클러스터 가상 IP를 사용하여 프리즘에 액세스할 때마다, 클러스터 가상 IP가 이미 프리즘 리더이므로 리다이렉션이 필요하지 않다.

Note

Pro tip

임의의 CVM에서 다음 명령을 실행하여 현재 프리즘 리더를 확인할 수 있다:

curl localhost:2019/prism/leader

인증 및 접근 제어 (RBAC)

인증 (Authentication)

프리즘은 현재 다음 인증 공급자와의 통합을 지원한다.

- 프리즘 엘리먼트 (Prism Element: PE)

- 로컬

- 액티브 디렉토리

- LDAP

- 프리즘 센트럴 (Prism Central: PC)

- 로컬

- 액티브 디렉토리

- LDAP

- SAML 인증 (IDP)

Note

SAML / 2FA

SAML 인증을 사용하면 프리즘을 SAML과 호환되는 외부 ID 제공 업체(e.g. Okta, ADFS 등)와 통합할 수 있다.

또한 이러한 공급자가 프리즘에 로그인하는 사용자를 지원하는 MFA(Multi-Factor Authentication) / 2FA(Two-Factor Authentication) 기능을 활용할 수 있다.

접근 제어 (Access Control)

내용 추가 예정입니다.

내비게이션 (Navigation)

프리즘은 상당히 직선적이고 사용하기 쉽지만, 몇 가지 메인 페이지와 기본적인 사용법을 다룬다.

프리즘 센트럴(배포된 경우에)은 설정 단계에서 지정한 IP 또는 해당 DNS 엔트리를 이용하여 액세스할 수 있다. 프리즘 엘리먼트는 프리즘 센트럴(특정 클러스터 클릭)을 통해 액세스하거나 뉴타닉스 CVM 또는 클러스터 가상 IP(선호)로 내비게이션 하여 액세스할 수 있다.

페이지가 로드되면 프리즘 또는 액티브 디렉토리 크리덴셜을 사용하여 로그인할 로그인 페이지가 나타난다.

프리즘 로그인 페이지 (Prism Login Page)

프리즘 로그인 페이지 (Prism Login Page)

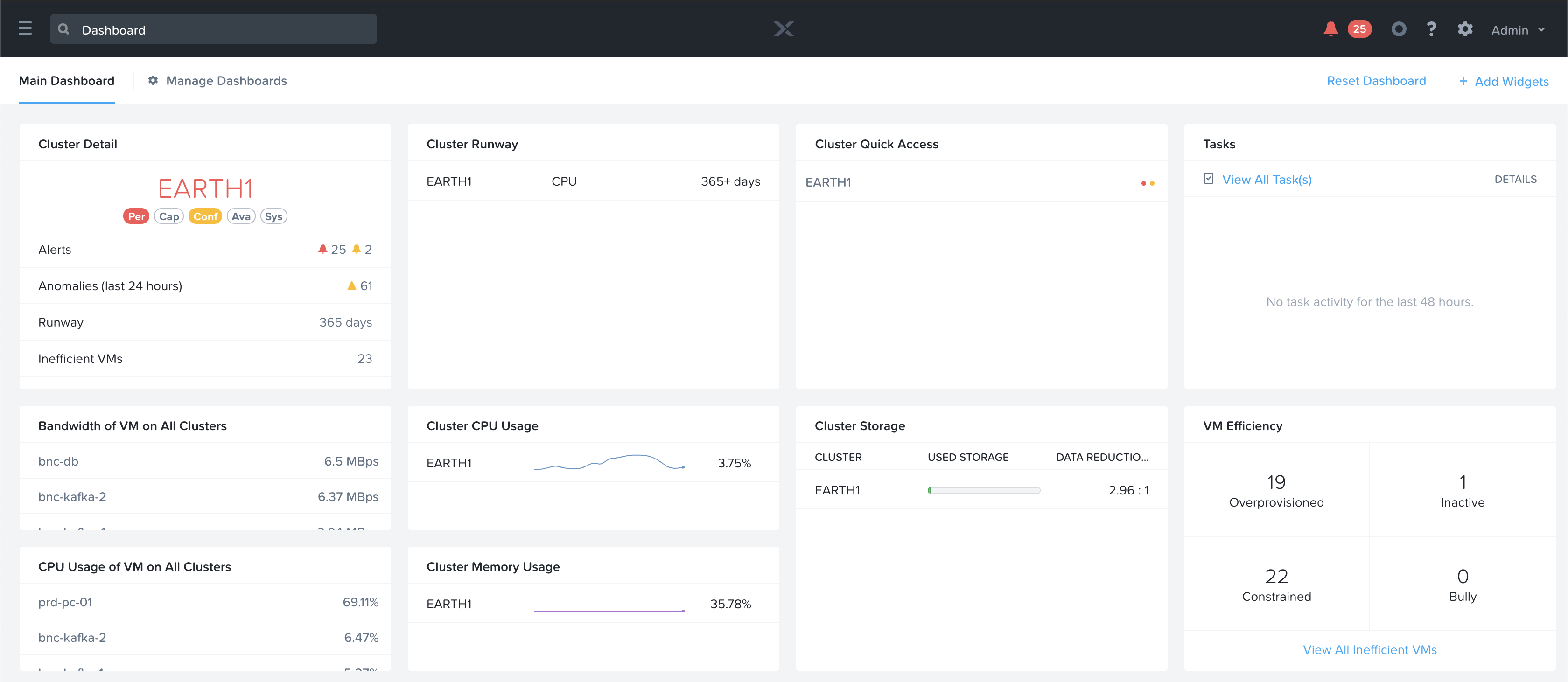

로그인이 성공하면 프리즘 센트럴에서는 관리 클러스터, 프리즘 엘리먼트에서는 로컬 클러스터에 대한 개요 정보를 제공하는 대시보드 페이지로 이동된다.

프리즘 센트럴 및 프리즘 엘리먼트에 대해서는 다음 섹션에서 보다 자세히 다룬다.

프리즘 센트럴 (Prism Central)

그림은 여러 개의 클러스터를 모니터링/관리할 수 있는 샘플 프리즘 센트럴 대시보드를 보여준다.

프리즘 센트럴 - 대시보드 (Prism Central - Dashboard)

프리즘 센트럴 - 대시보드 (Prism Central - Dashboard)

여기에서 환경의 전반적인 상태를 모니터링하고 경고 또는 관심 항목이 있는 경우 좀 더 자세히 파악할 수 있다.

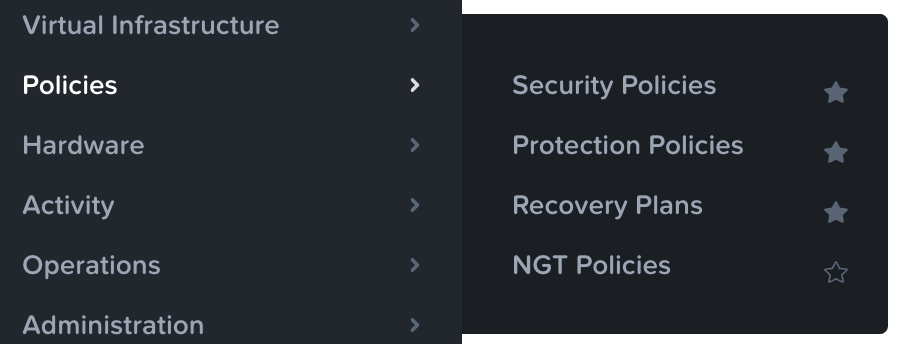

프리즘 센트럴은 다음과 같은 메인 페이지가 있다 (NOTE: 검색은 내비게이션을 위한 선호/권고하는 방법):

- Home Page

- 서비스 상태, 용량 계획, 성능, 태스크 등에 대한 자세한 정보를 포함하는 환경 전반 모니터링 대시보드. 이들 중 어느 항목에 대한 추가 정보를 얻으려면 관심 아이템을 클릭한다.

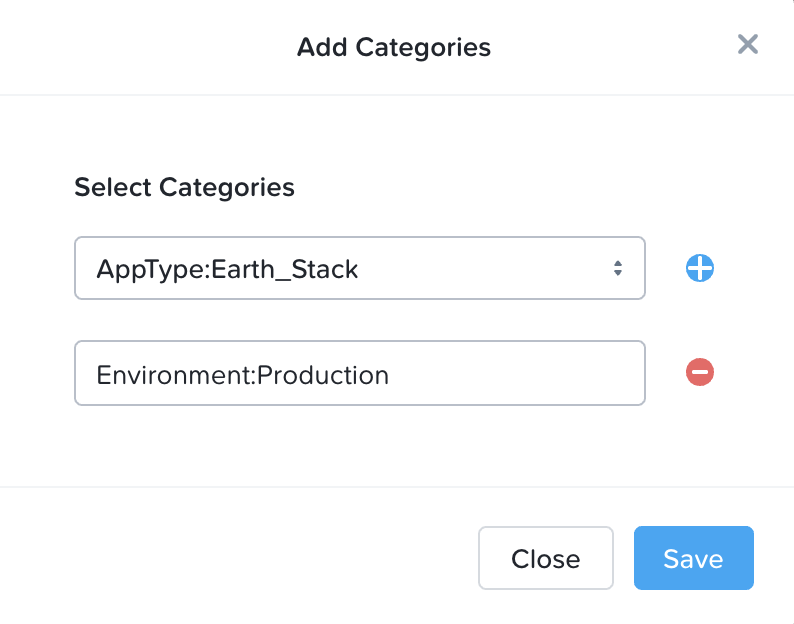

- Virtual Infrastructure

- 가상 엔티티 (e.g. VMs, 컨테이너, 이미지, 카테고리 등)

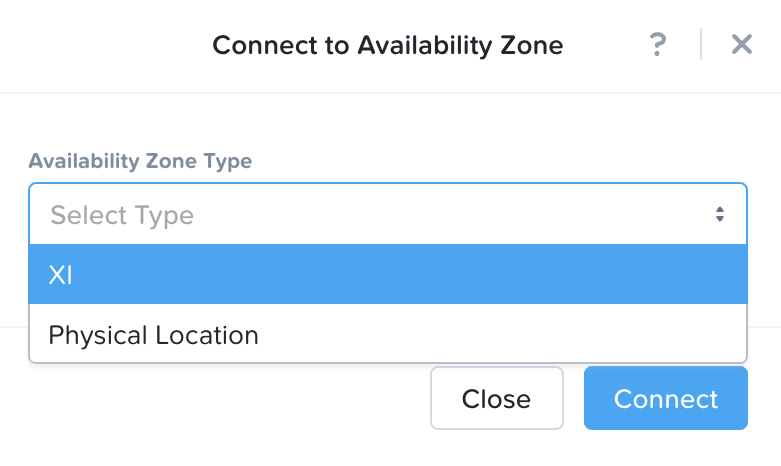

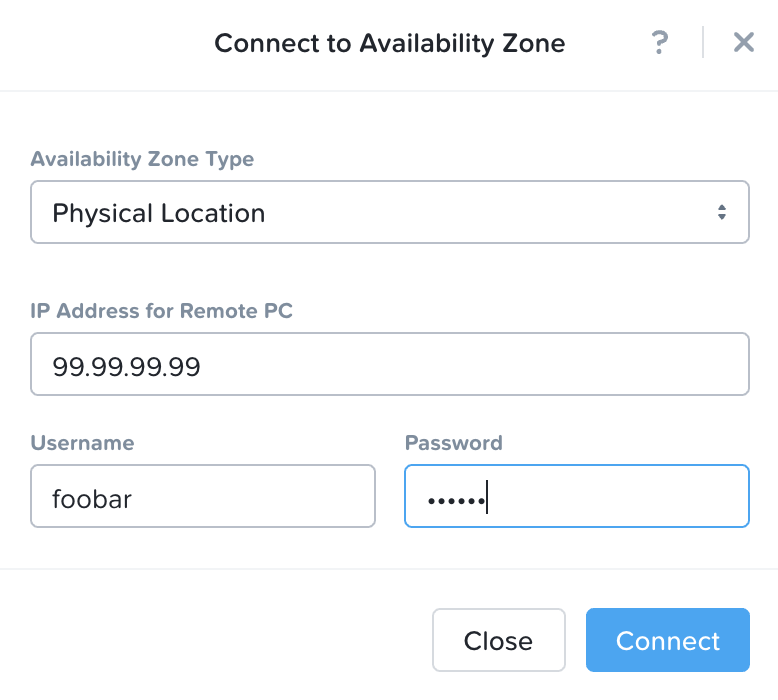

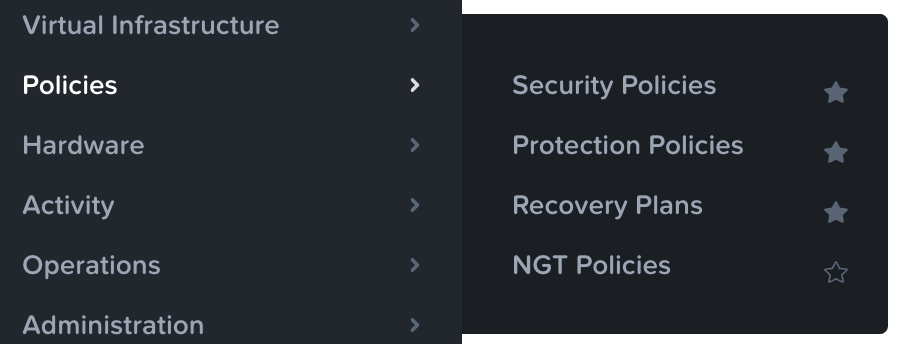

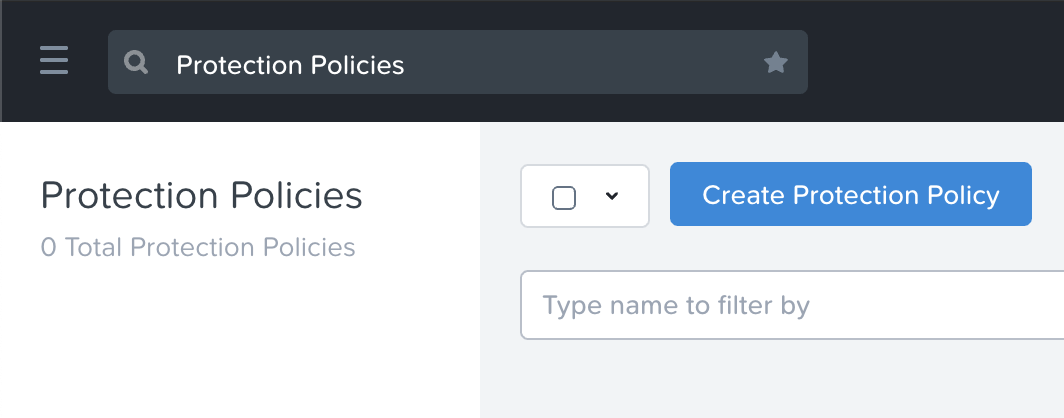

- Policies

- 정책 관리 및 생성 (e.g. 보안 (FLOW), 보호 (백업/복제), 복구 (DR), NGT)

- Hardware

- 물리적 디바이스 관리 (e.g. 클러스터, 호스트, 디스크, GPU)

- Activity

- 환경 전반에 걸친 경고, 이벤트 및 태스크

- Operations

- 오퍼레이션 대시보드, 보고 및 액션 (X-Play)

- Administration

- 환경 구성 관리 (e.g. 사용자, 그룹, 역할, 가용성 영역)

- Services

- 부가 서비스 관리 (e.g. Calm, Karbon)

- Settings

- 프리즘 센트럴 설정

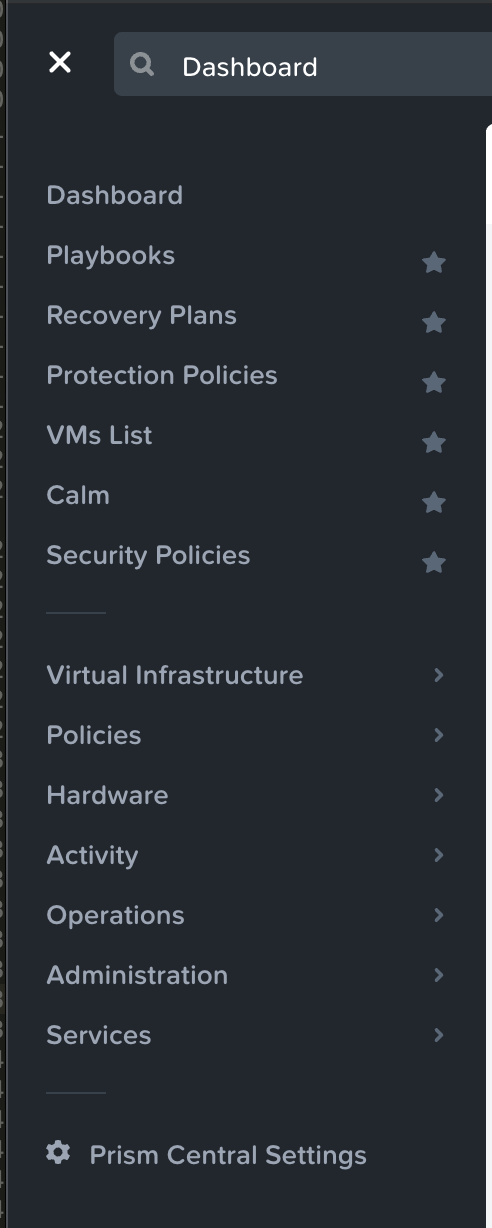

메뉴에 액세스하려면 햄버거 아이콘을 클릭한다.

프리즘 센트럴 - 햄버거 (Prism Central - Hamburger)

프리즘 센트럴 - 햄버거 (Prism Central - Hamburger)

메뉴가 펼쳐져 사용 가능한 옵션이 표시된다.

프리즘 센트럴 - 메뉴 바 (Prism Central - Menu Bar)

프리즘 센트럴 - 메뉴 바 (Prism Central - Menu Bar)

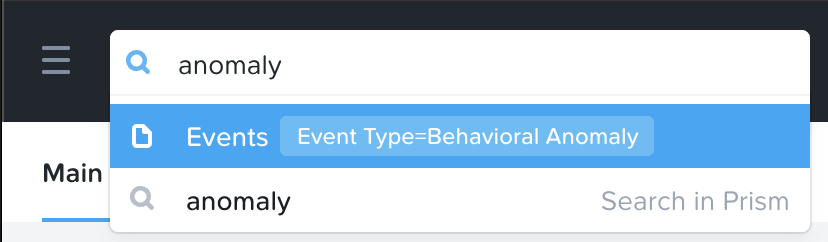

검색 (Search)

검색은 이제 프리즘 센트럴 UI 내비게이션을 위한 기본 메커니즘이다 (메뉴는 계속 사용할 수 있음).

검색 창을 통해 내비게이션 하려면 메뉴 아이콘 옆의 왼쪽 상단 모서리에 있는 검색 창을 사용할 수 있다.

프리즘 센트럴 - 검색 (Prism Central - Search)

프리즘 센트럴 - 검색 (Prism Central - Search)

Note

검색 시맨틱 (Search Semantics)

PC 검색은 시맨틱을 활용할 수 있게 한다. 몇 가지 예는 다음과 같다.

| Rule | Example |

|---|---|

| Entity type | vms |

| Entity type + metric perspective (io, cpu, memory) | vms io |

| Entity type + alerts | vm alerts |

| Entity type + alerts + alert filters | vm alerts severity=critical |

| Entity type + events | vm events |

| Entity type + events + event filters | vm events classification=anomaly |

| Entity type + filters (both metric and attribute) | vm “power state”=on |

| Entity type + filters + metric perspective (io, cpu, memory) | vm “power state”=on io |

| Entity type + filters + alerts | vm “power state”=on alerts |

| Entity type + filters + alerts + (alert filters) | vm “power state”=on alerts severity=critical |

| Entity type + filters + events | vm “power state”=on events |

| Entity type + filters + events + event filters | vm “power state”=on events classification=anomaly |

| Entity instance (name, ip address, disk serial etc) | vm1, 10.1.3.4, BHTXSPWRM |

| Entity instance + Metric perspective (io, cpu, memory) | vm1 io |

| Entity instance + alerts | vm1 alerts |

| Entity instance + alerts + alert filters | vm1 alerts severity=critical |

| Entity instance + events | vm1 events |

| Entity instance + events + event filters | vm1 events classification=anomaly |

| Entity instance + pages | vm1 nics, c1 capacity |

| Parent instance + entity type | c1 vms |

| Alert title search | Disk bad alerts |

| Page name search | Analysis, tasks |

상기 예제는 시맨틱의 일부분에 지나지 않는다. 시맨틱에 익숙해지기 위한 가장 좋은 방법은 실제로 해보는 것이다.

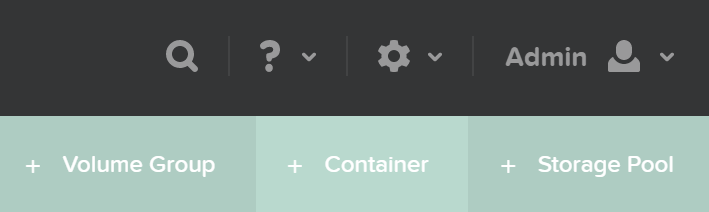

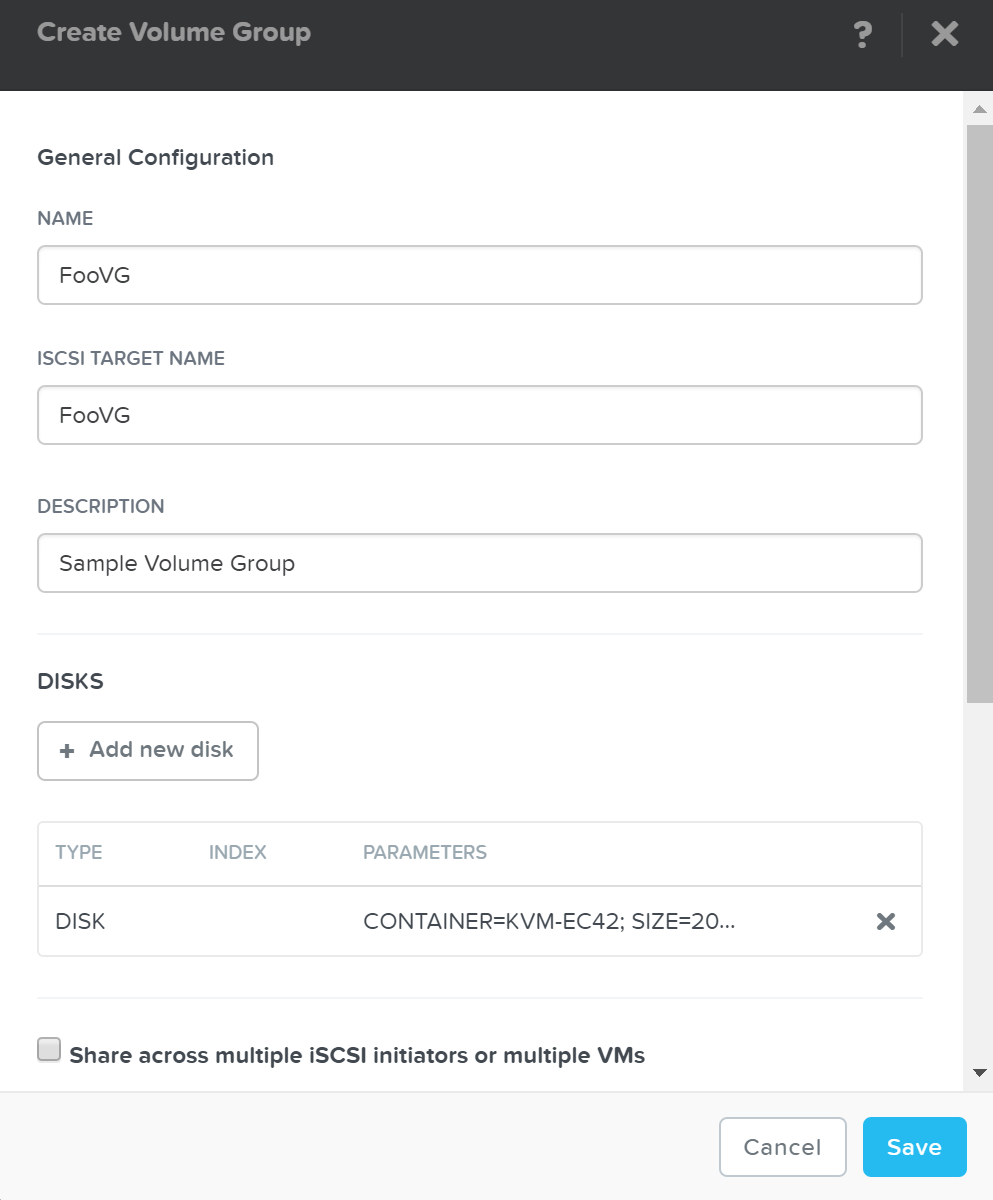

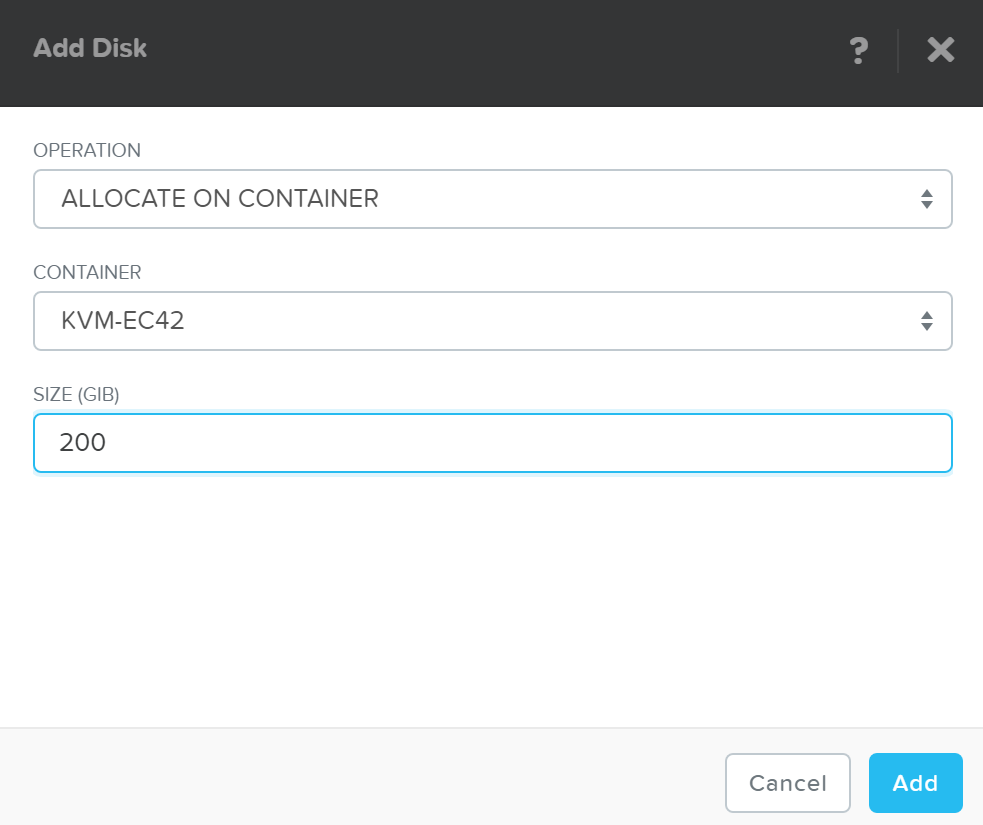

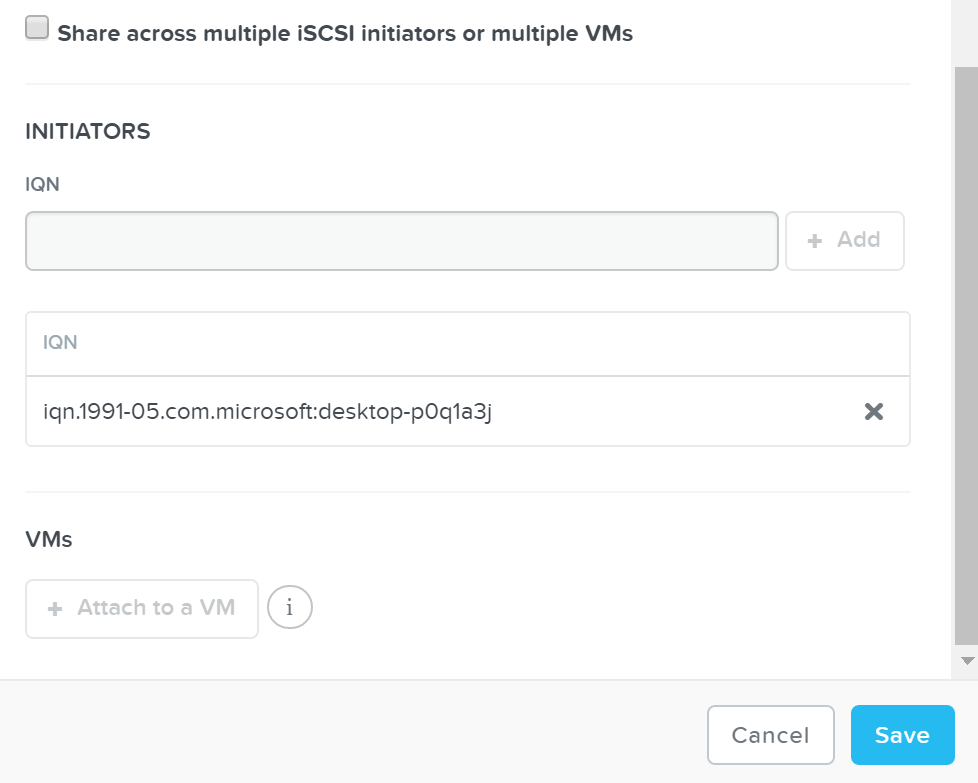

프리즘 엘리먼트 (Prism Element)

프리즘 엘리먼트는 다음 메인 페이지를 포함한다.

- Home Page

- 경고, 용량, 성능, 헬스, 태스크 등에 대한 자세한 정보를 포함한 로컬 클러스터 모니터링 대시보드. 이들 중 어느 하나에 대한 추가 정보를 얻으려면 관심 항목을 클릭한다.

- Health Page

- 환경, 하드웨어, 관리 오브젝트 헬스 및 상태 정보. 또한, NCC 헬스 체크 상태를 포함한다.

- VM Page

- 전체 VM 관리, 모니터링 및 CRUD (AOS)

- Storage Page

- 컨테이너 관리, 모니터링 및 CRUD

- Hardware Page

- 서버, 디스크 및 네트워크 관리, 모니터링 및 헬스. 클러스터 확장과 노드 및 디스크 제거를 포함한다.

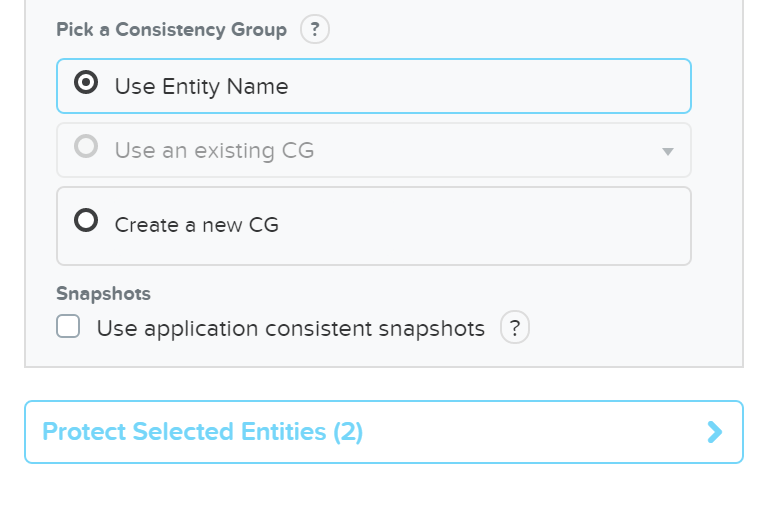

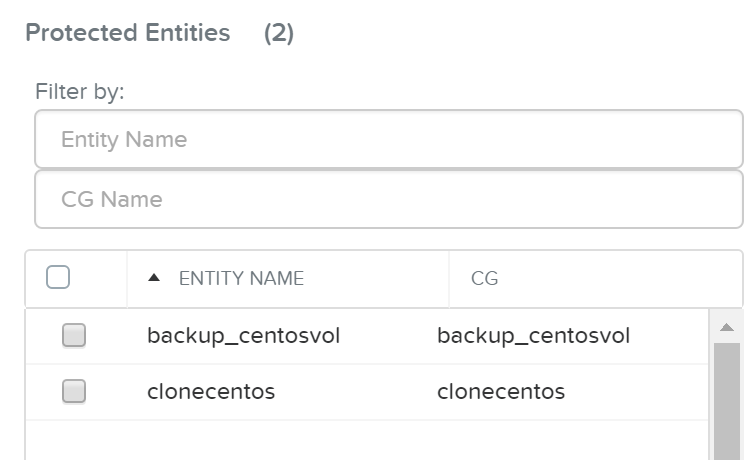

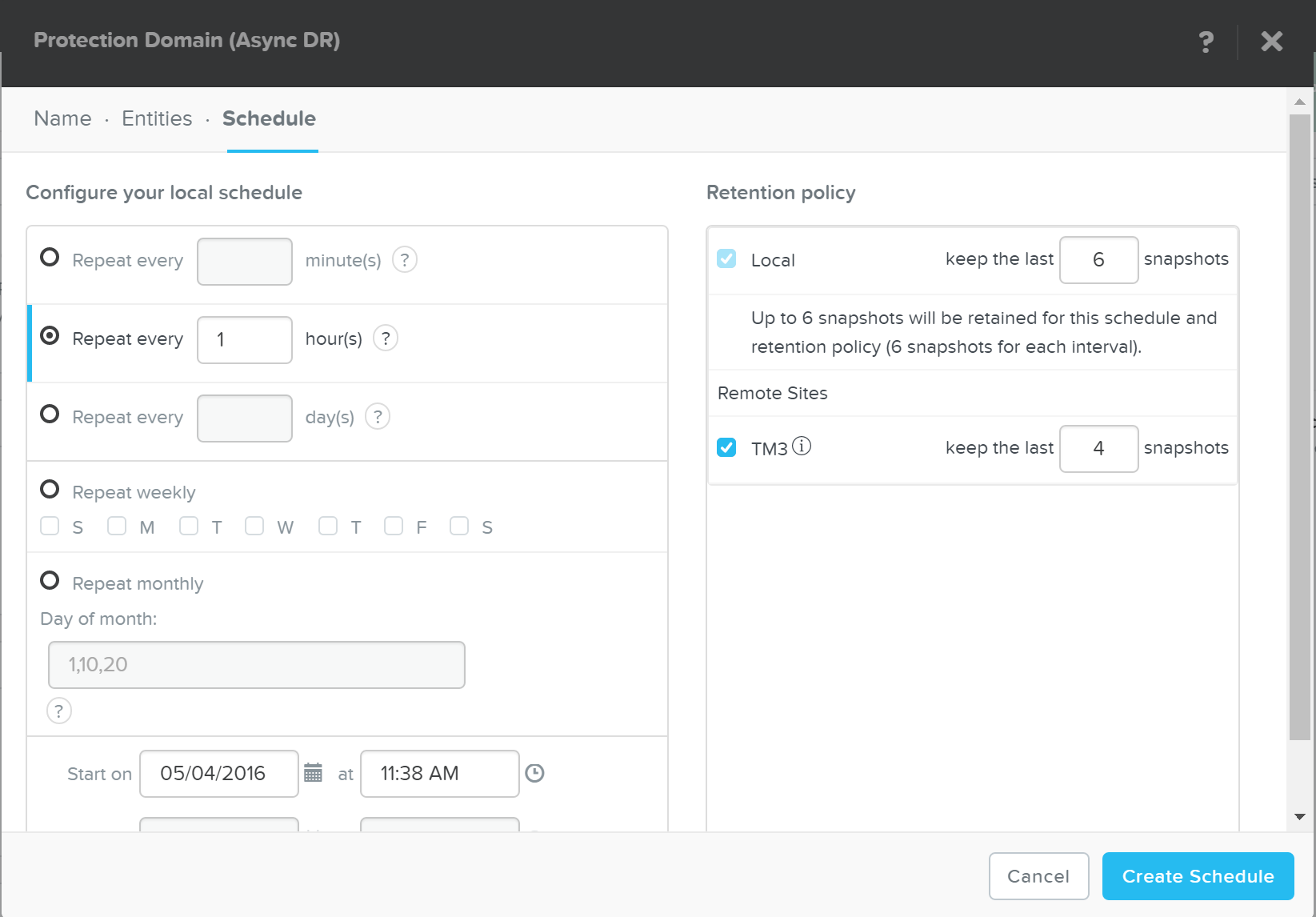

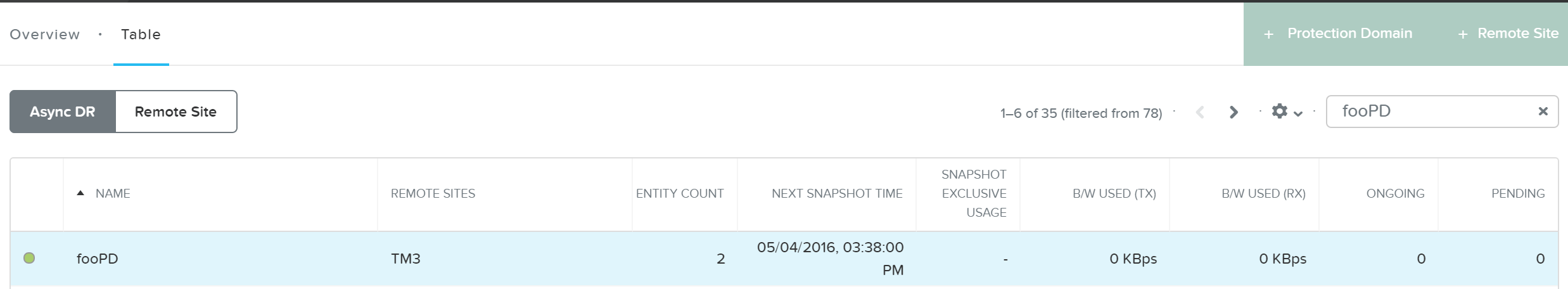

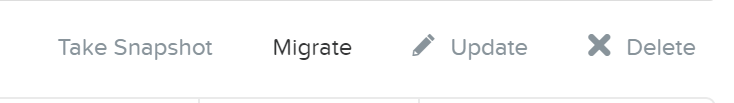

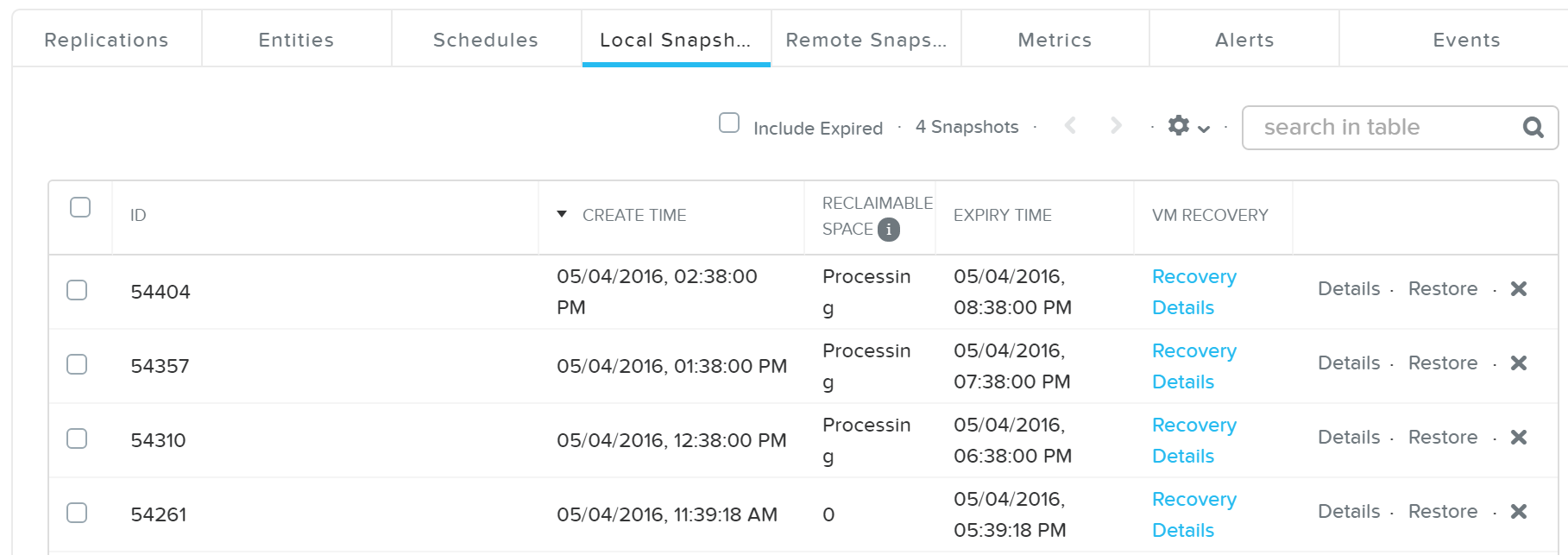

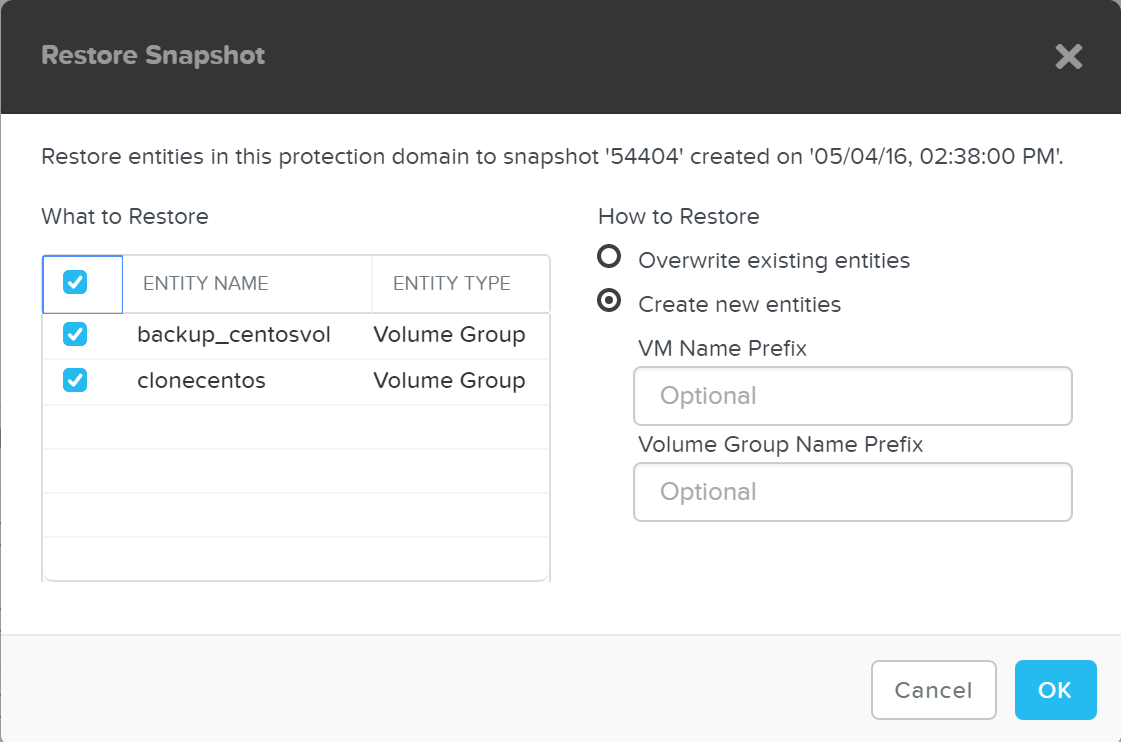

- Data Protection Page

- DR, 클라우드 커넥트 및 메트로 가용성 설정, PD 오브젝트, 스냅샷, 복제 및 복원 관리

- Analysis Page

- 이벤트와 상관관계가 있는 클러스터 및 관리 오브젝트에 대한 자세한 성능 분석

- Alerts Page

- 로컬 클러스터 및 환경 경고

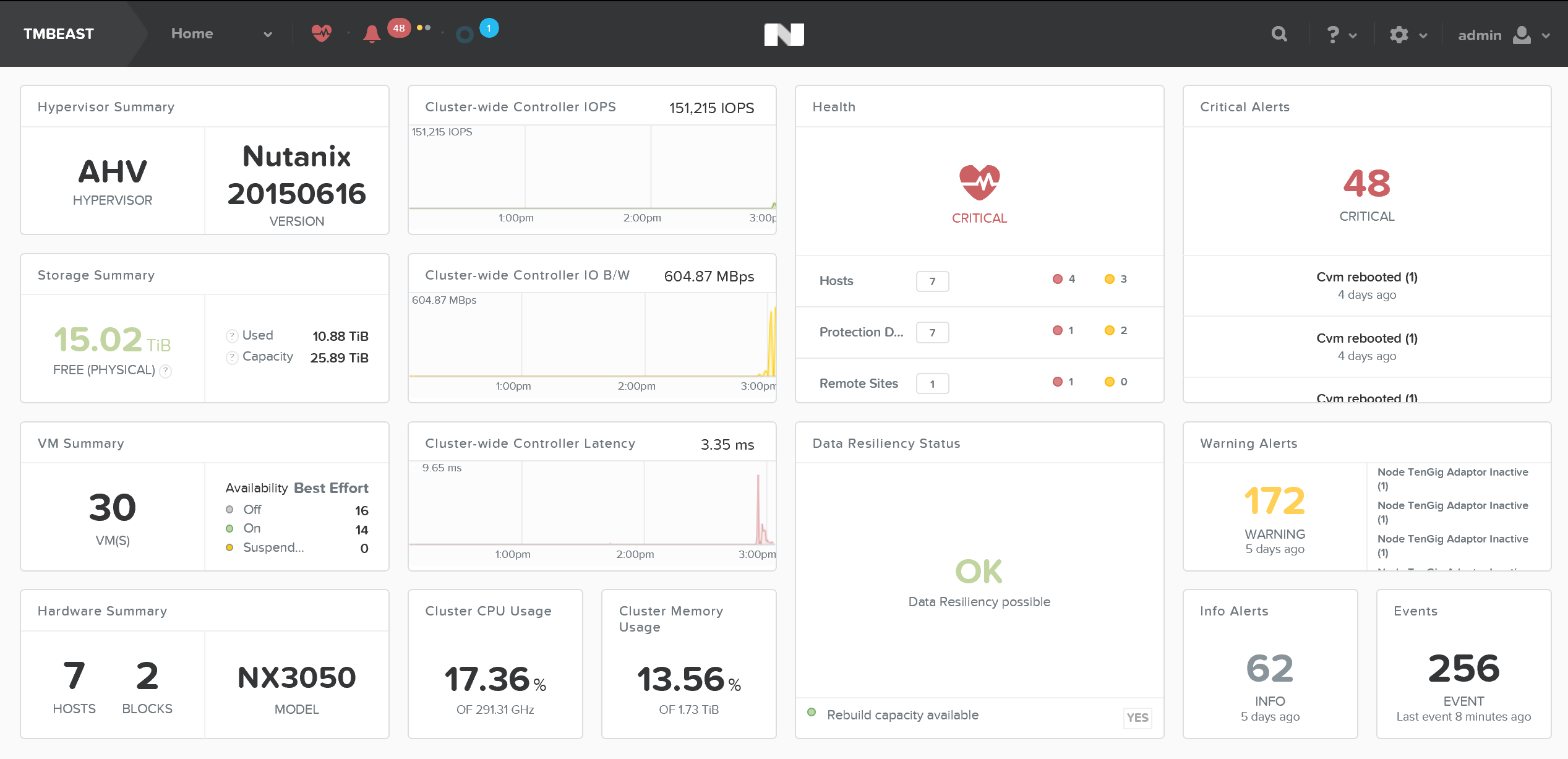

홈 페이지는 경고, 서비스 상태, 용량, 성능, 태스크 등에 대한 자세한 정보를 제공한다. 이들 중 어느 하나에 대한 추가 정보를 얻으려면 관심 항목을 클릭한다.

그림은 로컬 클러스터 세부 정보가 표시되는 샘플 프리즘 엘리먼트 대시보드를 보여준다.

프리즘 엘리먼트 - 대시보드 (Prism Element - Dashboard)

프리즘 엘리먼트 - 대시보드 (Prism Element - Dashboard)

Note

키보드 단축키 (Keyboard Shortcuts)

접근성 및 사용 용이성은 프리즘에서 가장 중요이다. 최종 사용자의 작업을 단순화하기 위해 사용자가 키보드로 모든 작업을 수행할 수 있도록 단축키가 추가되었다.

다음은 몇 가지 주요 단축키의 특징이다.

뷰 변경 (페이지 컨텍스트 인식)

- O - Overview View

- D - Diagram View

- T - Table View

액티비티 및 이벤트

- A - Alerts

- P - Tasks

드롭 다운 및 메뉴 (화살표 키를 사용하여 선택항목 이동)

- M - Menu drop-down

- S - Settings (gear icon)

- F - Search bar

- U - User drop down

- H - Help

기능 및 사용법

다음 섹션에서 몇 가지 일반적인 장애 처리 시나리오와 함께 대표적인 프리즘 사용법에 대해 설명한다.

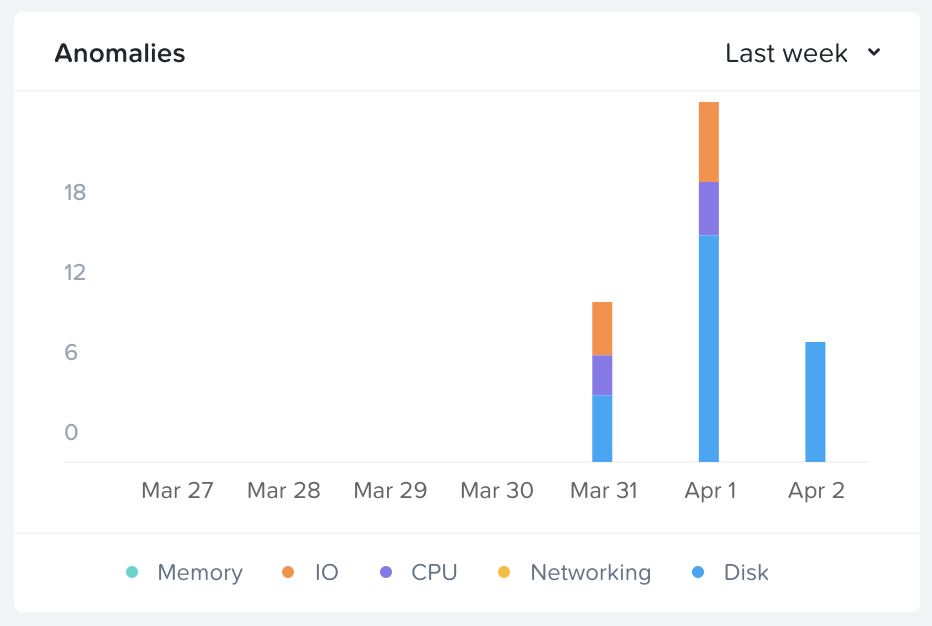

이상 징후 탐지

IT 운영의 세계에는 많은 노이즈가 있다. 전통적으로 시스템은 많은 경고, 이벤트 및 통지를 생성하며, 종종 운영자는 a) 노이즈에서 손실되었기 때문에 중요한 경고를 보지 못하거나 또는 b) 경고/이벤트를 무시할 수 있다.

뉴타닉스 이상 징후 탐지 기능을 사용하면 시스템은 시계열 데이터(e.g. CPU 사용량, 메모리 사용량, 레이턴시 등)의 계절적 추세를 모니터링하고 예상 값의 "밴드(Band)"를 설정할 수 있다. "밴드" 범위를 벗어나는 값에 대해서만 이벤트/경고를 발생시킨다. 모든 엔티티 또는 이벤트 페이지에서 이상 징후 이벤트/경고를 볼 수 있다.

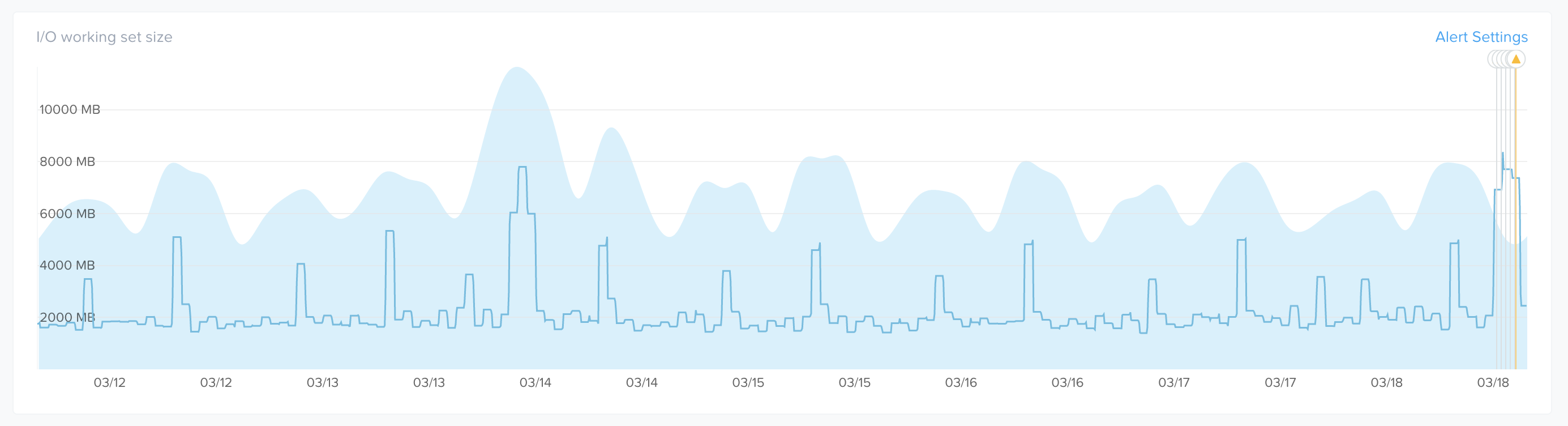

다음 차트는 이러한 시스템에서 일부 대규모 배치 처리를 수행할 때 발생하는 많은 I/O 및 디스크 사용량의 이상 징후를 보여준다.

프리즘 - 이상 징후 차트 (Prism - Anomaly Chart)

프리즘 - 이상 징후 차트 (Prism - Anomaly Chart)

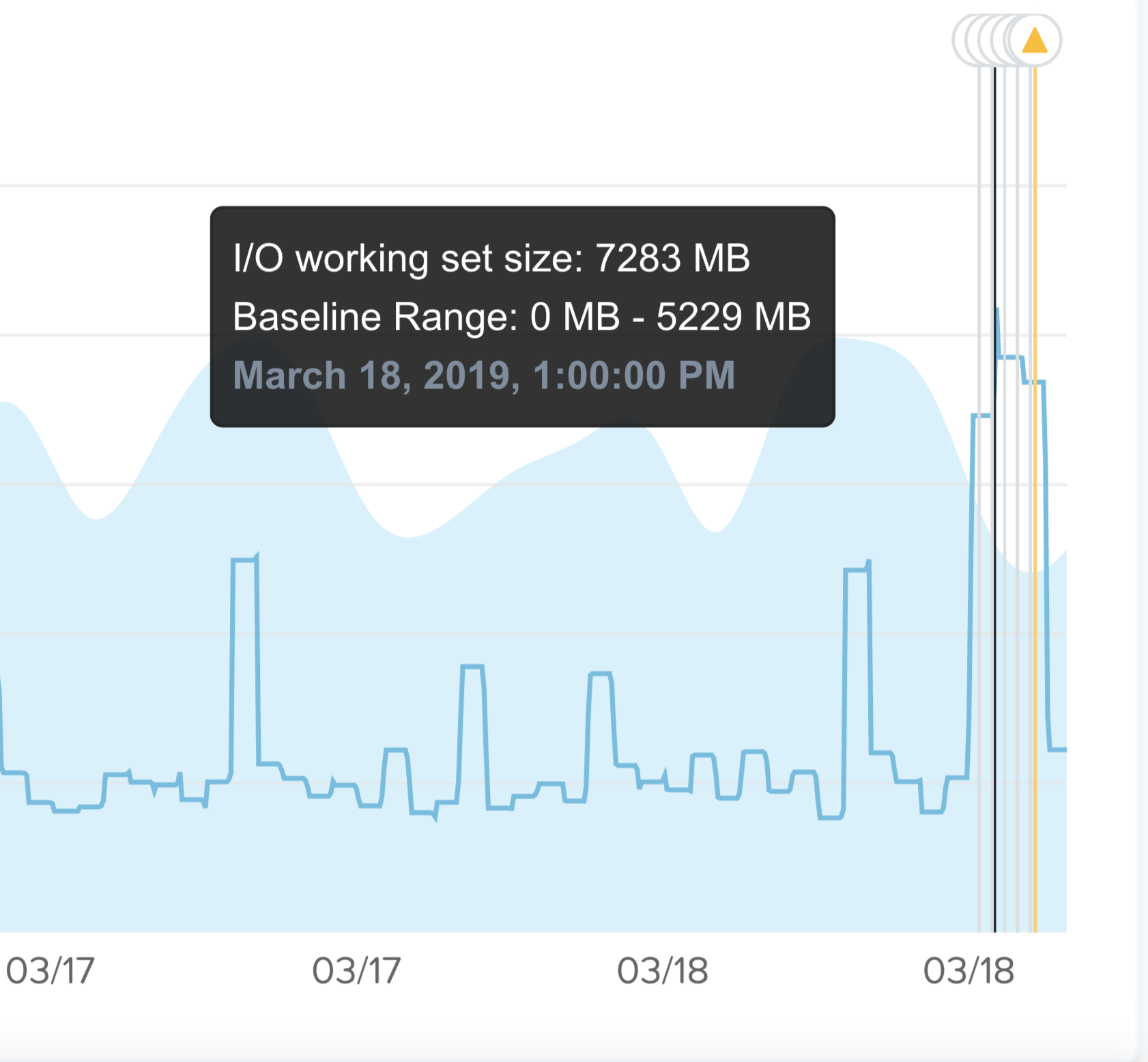

다음 이미지는 샘플 메트릭과 설정된 "밴드(band)"에 대한 시계열 값을 보여준다.

프리즘 - 이상 징후 밴드 (Prism - Anomaly Band)

프리즘 - 이상 징후 밴드 (Prism - Anomaly Band)

이것은 "정상"상태에 대한 경고를 원하지 않기 때문에 불필요한 경고를 감소시킨다. 예를 들어 데이터베이스 시스템은 캐싱 등으로 인해 정상적으로 95% 이상의 메모리 사용률로 실행된다. 이 경우에 뭔가 잘못될(e.g. 데이터베이스 서비스 다운) 수 있기 때문에 이상 징후일 가능성이 10%라고 말한다.

또 다른 예는 일부 배치 워크로드가 주말에 어떻게 실행되는지이다. 예를 들어 근무 주간에는 I/O 대역폭이 낮을 수 있지만, 일부 배치 프로세스(e.g. 백업, 보고서 등)가 실행되는 주말에 I/O가 급격히 증가할 수 있다. 시스템은 이것의 계절성을 감지하고 주말 동안에 밴드를 올린다.

여기에서 값이 예상되는 밴드를 벗어났기 때문에 이상 징후 이벤트가 발생했음을 알 수 있다.

프리즘 - 이상 징후 이벤트 (Prism - Anomaly Event)

프리즘 - 이상 징후 이벤트 (Prism - Anomaly Event)

이상 징후에 대한 또 다른 관심 주제는 계절성이다. 예를 들어 소매업자는 휴일 기간 동안의 수요가 연중 다른 기간 또는 월 마감 동안 보다 높다는 것을 알 수 있다.

이상 징후 탐지는 이러한 계절성을 설명하며 다음 기간을 활용하여 미시적(일별) 및 거시적(분기별) 추세를 비교한다.

- 일별 (Daily)

- 주별 (Weekly)

- 월별 (Monthly)

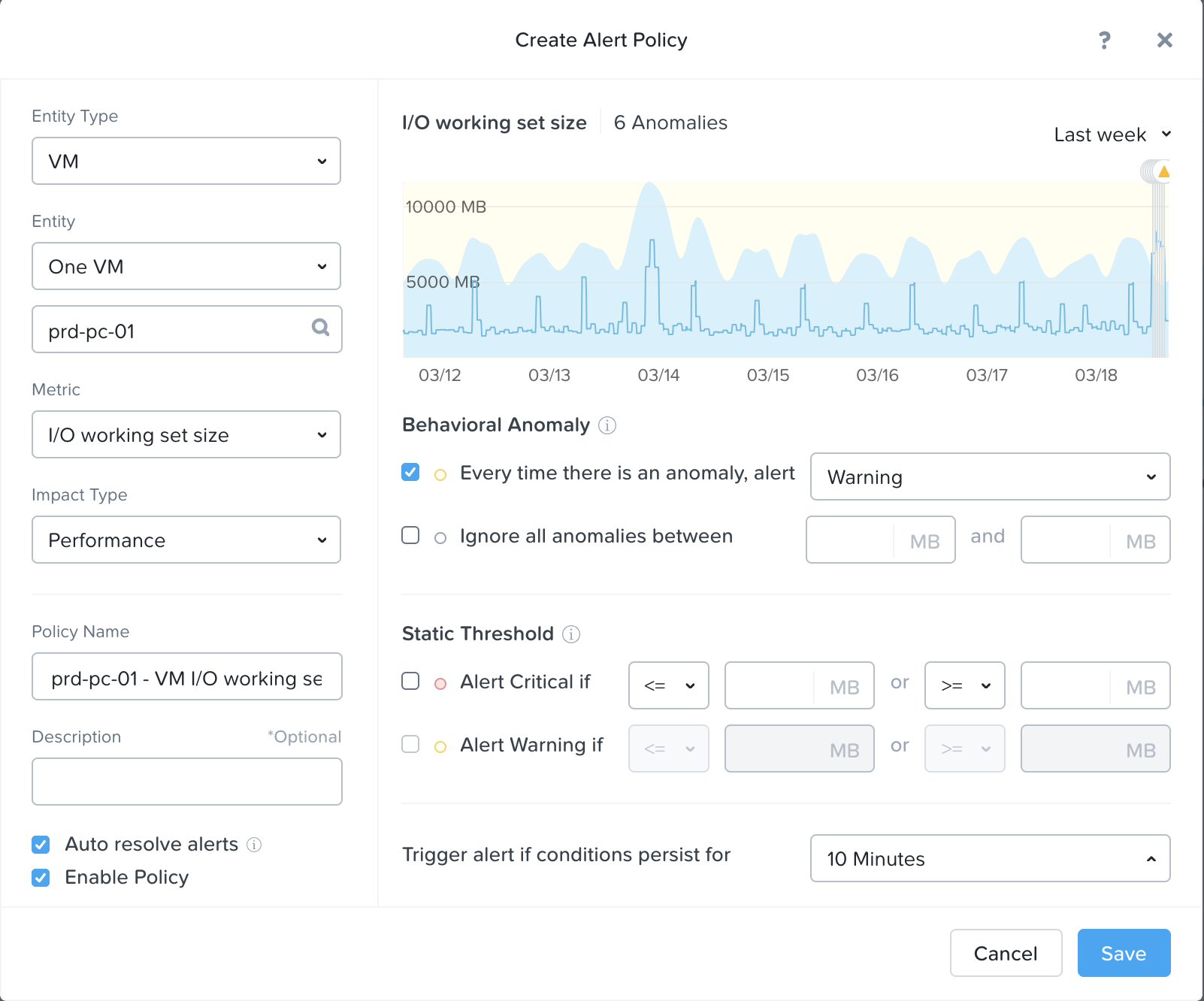

사용자는 맞춤 경고 또는 정적 임계 값을 설정할 수 있다.

프리즘 - 이상 징후 커스텀 이벤트 (Prism - Anomaly Custom Event)

프리즘 - 이상 징후 커스텀 이벤트 (Prism - Anomaly Custom Event)

Note

이상 징후 탐지 알고리즘 (Anomaly Detection Algorithm)

뉴타닉스는 밴드를 결정하기 위해 '일반화된 극한의 학생 편차 테스트(Generalized Extreme Studentized Deviate Test)'라는 방법을 활용한다. 이것을 이해하는 간단한 방법은 값이 알고리즘에 의해 설정된 상한과 하한 사이에 있는 신뢰 구간과 유사하다.

알고리즘은 계절성 및 예상되는 밴드를 계산하기 위해 3배의 세분화된 데이터(e.g. 일별, 주별, 월별 등)가 필요하다. 예를 들어 각각의 계절성을 반영하기 위해 다음과 같은 양의 데이터가 필요하다.

- 일별 (Daily): 3일

- 주별 (Weekly): 3주 (21일)

- 월별 (Monthly): 3개월 (90일)

트위터는 이것을 어떻게 활용하는지에 대한 좋은 자료를 가지고 있는데, 로직에 대한 보다 자세한 설명은 다음 링크 참조: LINK

뉴타닉스 소프트웨어 업그레이드

뉴타닉스 소프트웨어 업그레이드를 수행하는 것은 매우 간단하고 무중단(non-disruptive) 프로세스이다.

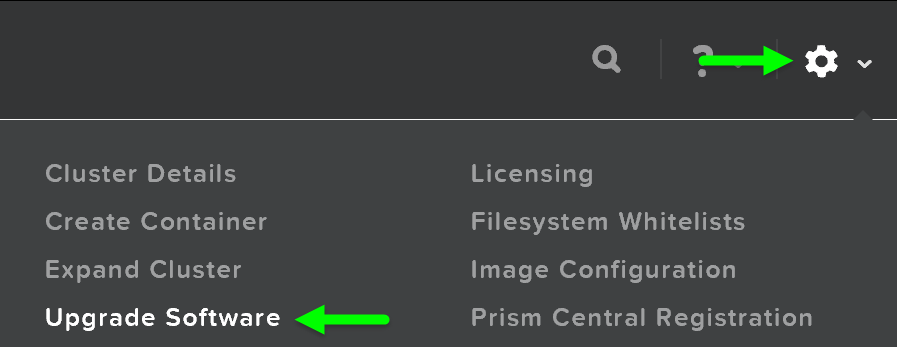

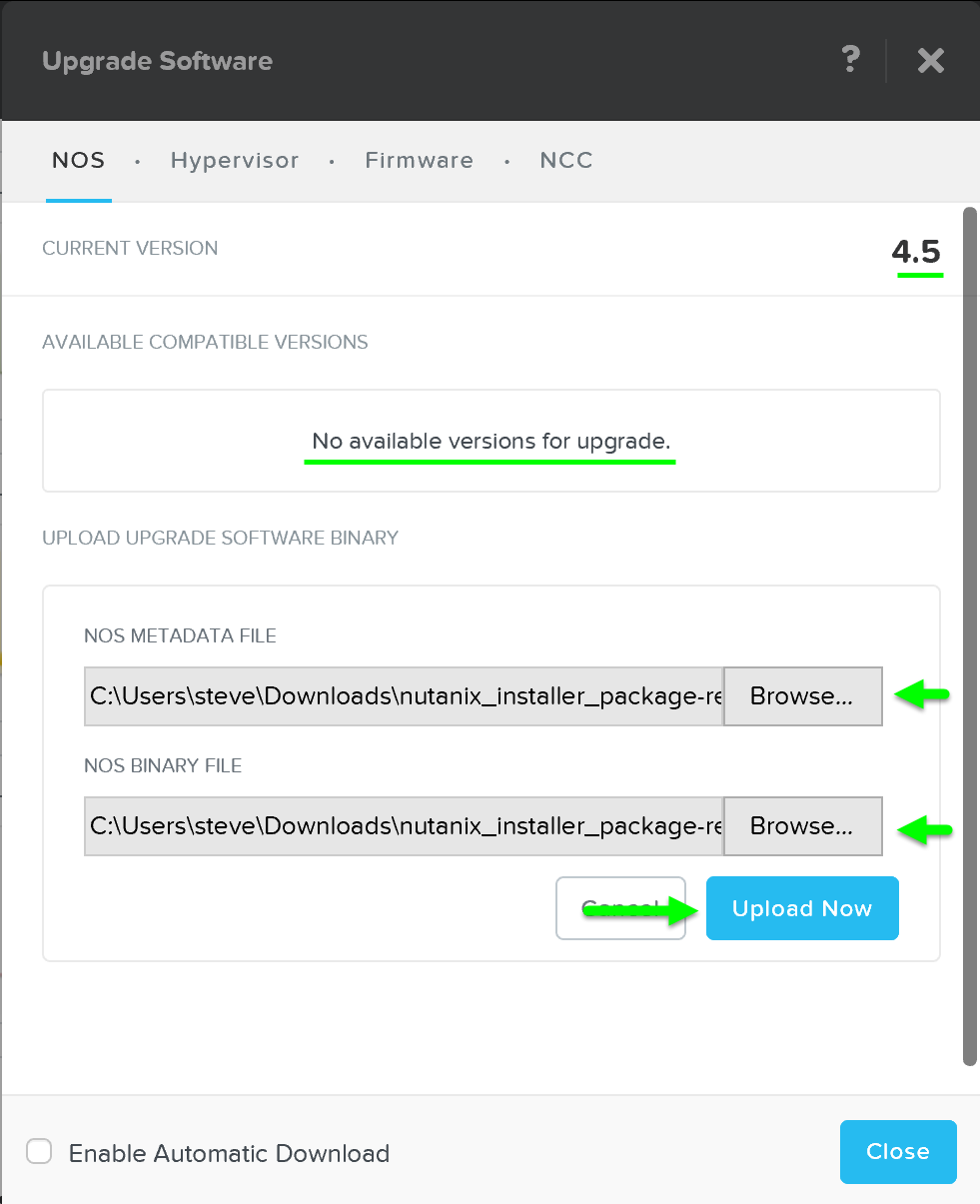

시작하려면 프리즘에 로그인하고 오른쪽 상단의 기어 아이콘(설정)을 클릭하거나 'S'를 누르고 “Upgrade Software”를 선택한다.

프리즘 – 설정 – 업그레이드 소프트웨어 (Prism - Settings - Upgrade Software)

프리즘 – 설정 – 업그레이드 소프트웨어 (Prism - Settings - Upgrade Software)

그러면 “Upgrade Software” 다이얼로그 박스가 나타나고 현재 소프트웨어 버전과 사용 가능한 업그레이드 버전이 표시된다. AOS 바이너리 파일을 수동으로 업로드하는 것도 가능하다.

그런 다음 클라우드에서 업그레이드 버전을 다운로드하거나 수동으로 버전을 업로드할 수 있다.

업그레이드 소프트웨어 – 메인 (Upgrade Software - Main)

업그레이드 소프트웨어 – 메인 (Upgrade Software - Main)

Note

CVM에서 소프트웨어 업로드 (Upload software from the CVM)

경우에 따라 소프트웨어를 다운로드하고 CVM 자체에서 업로드 할 수도 있다. 예를 들어, 빌드를 CVM에 로컬로 다운로드하는 데 사용할 수 있다.

먼저 CVM에 SSH로 접속하고 프리즘 리더를 찾는다:

curl localhost:2019/prism/leader

프리즘 리더에 SSH로 접속하고 소프트웨어 번들 및 메타데이터 JSON을 다운로드한다.

다음 명령을 실행하여 소프트웨어를 프리즘에 "업로드" 한다:

ncli software upload file-path=PATH_TO_SOFTWARE meta-file-path=PATH_TO_METADATA_JSON software-type=SOFTWARE_TYPE

다음은 프리즘 센트럴에 대한 예를 보여준다:

ncli software upload file-path=/home/nutanix/tmp/leader-prism_central.tar meta-file-path=/home/nutanix/tmp/leader-prism_central-metadata.json software-type=prism_central_deploy

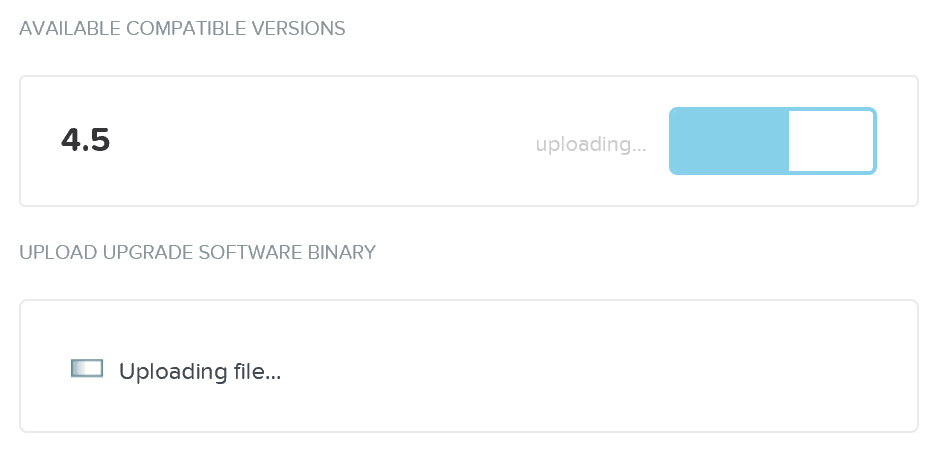

그런 다음 업그레이드 소프트웨어를 뉴타닉스 CVM에 업로드한다.

업그레이드 소프트웨어 – 업로드 (Upgrade Software - Upload)

업그레이드 소프트웨어 – 업로드 (Upgrade Software - Upload)

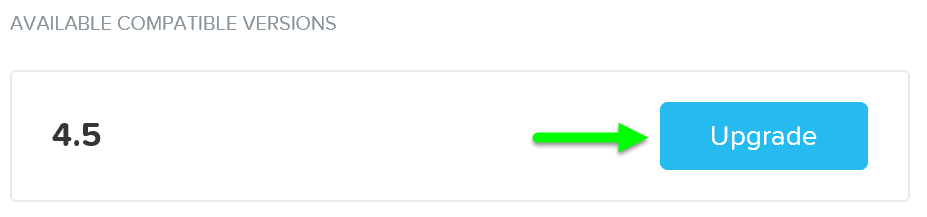

소프트웨어가 로드된 후 “Upgrade”를 클릭하여 업그레이드 프로세스를 시작한다.

업그레이드 소프트웨어 – 업그레이드 정합성 체크 (Upgrade Software - Upgrade Validation)

업그레이드 소프트웨어 – 업그레이드 정합성 체크 (Upgrade Software - Upgrade Validation)

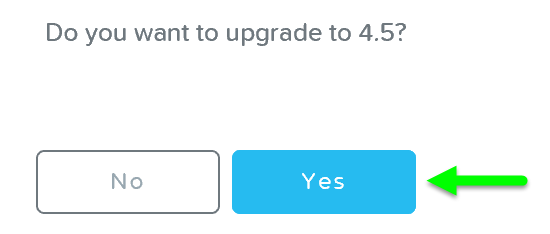

그러면 “확인” 다이얼로그 박스가 나타난다.

업그레이드 소프트웨어 – 업그레이드 확인 (Upgrade Software - Confirm Upgrade)

업그레이드 소프트웨어 – 업그레이드 확인 (Upgrade Software - Confirm Upgrade)

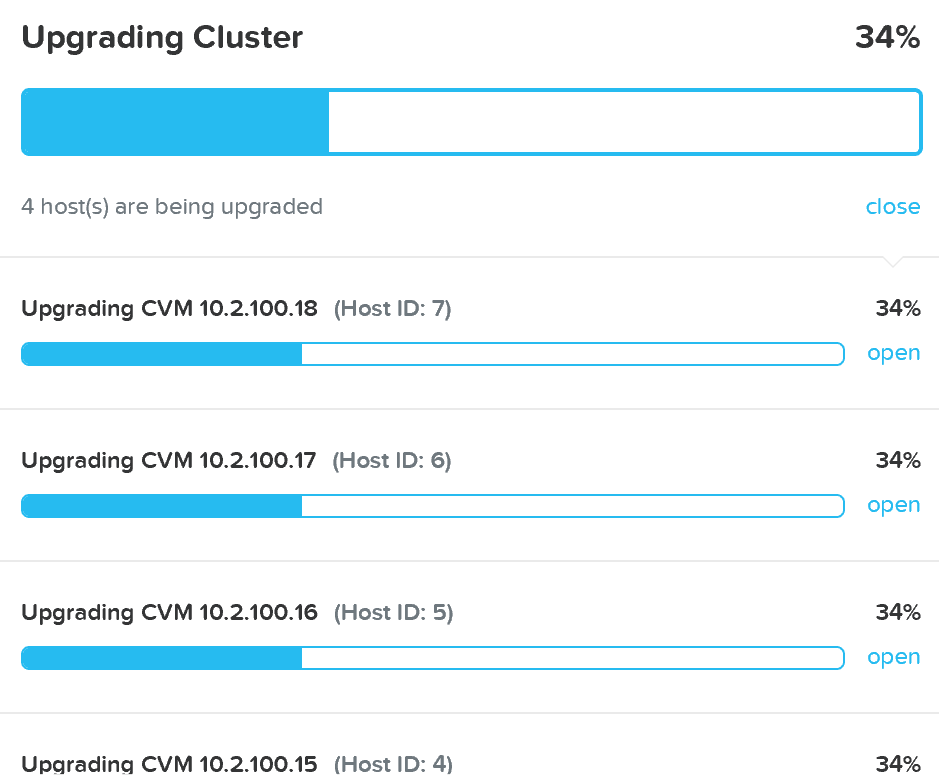

업그레이드는 업그레이드 사전 검사부터 시작하여 롤링 방식으로 소프트웨어 업그레이드를 시작한다.

업그레이드 소프트웨어 – 업그레이드 작업 수행 (Upgrade Software - Execution)

업그레이드 소프트웨어 – 업그레이드 작업 수행 (Upgrade Software - Execution)

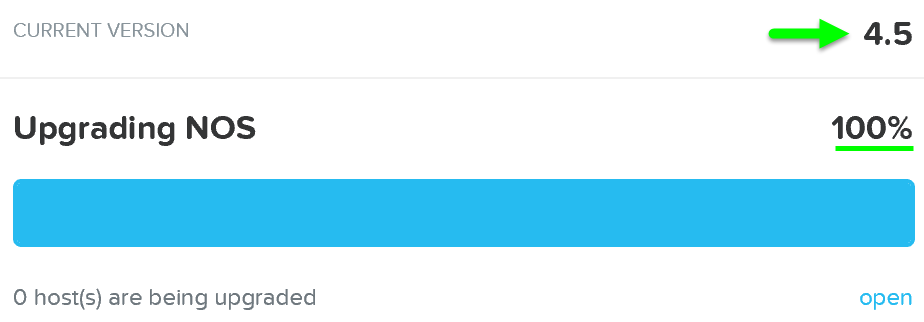

업그레이드가 완료되면 업데이트된 상태가 표시되고 모든 새로운 기능에 액세스할 수 있다.

업그레이드 소프트웨어 – 업그레이드 작업 완료 (Upgrade Software - Complete)

업그레이드 소프트웨어 – 업그레이드 작업 완료 (Upgrade Software - Complete)

Note

Note

현재 프리즘 리더가 업그레이드될 때 프리즘 세션이 잠시 중단된다. 실행 중인 모든 VM 및 서비스는 영향을 받지 않는다.

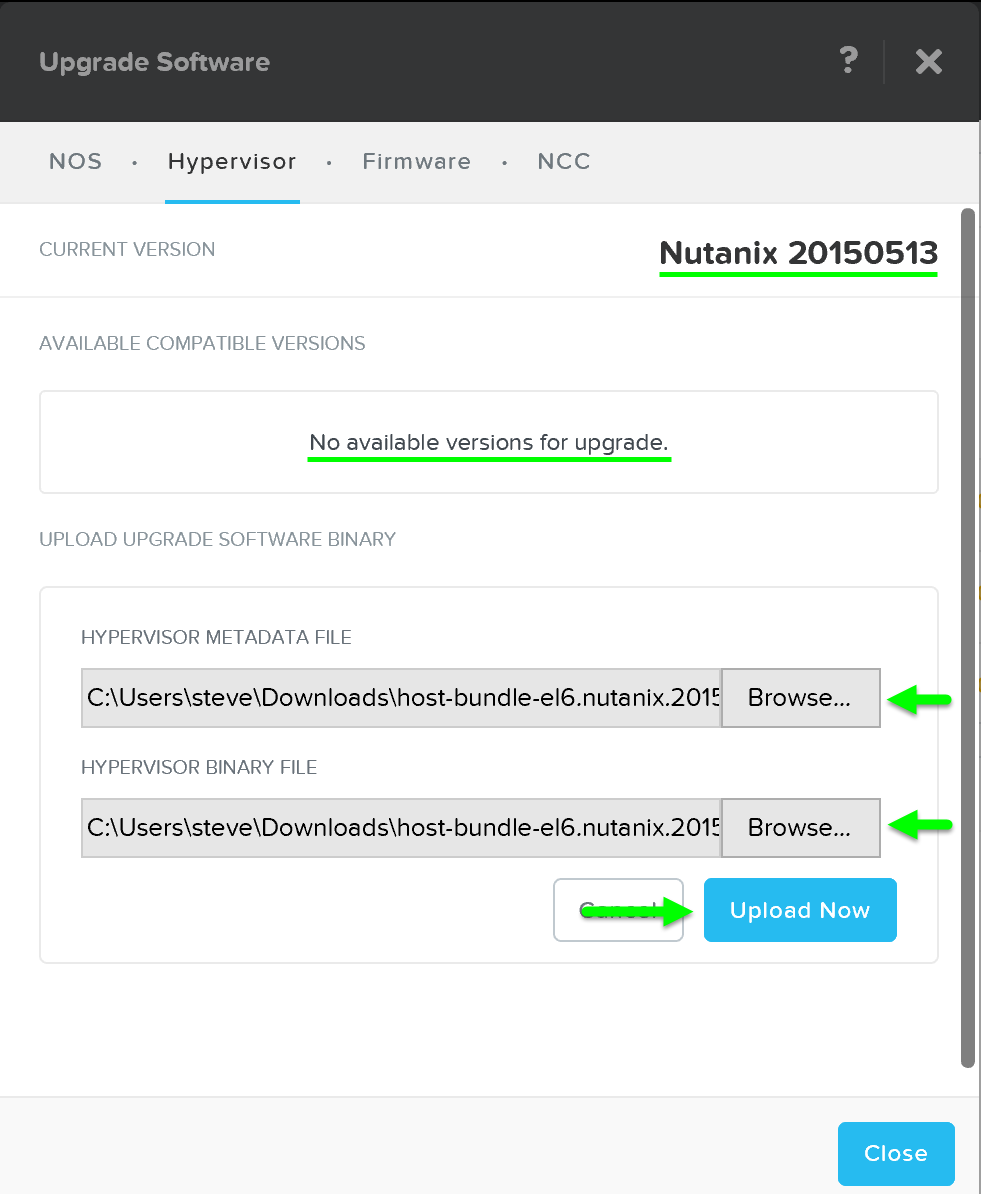

하이퍼바이저 업그레이드

뉴타닉스 소프트웨어 업그레이드와 마찬가지로 하이퍼바이저 업그레이드는 프리즘을 통해 롤링 방식으로 완전히 자동화될 수 있다.

시작하려면 위의 비슷한 단계에 따라 “Upgrade Software” 다이얼로그 박스를 열고 'Hypervisor'를 선택한다.

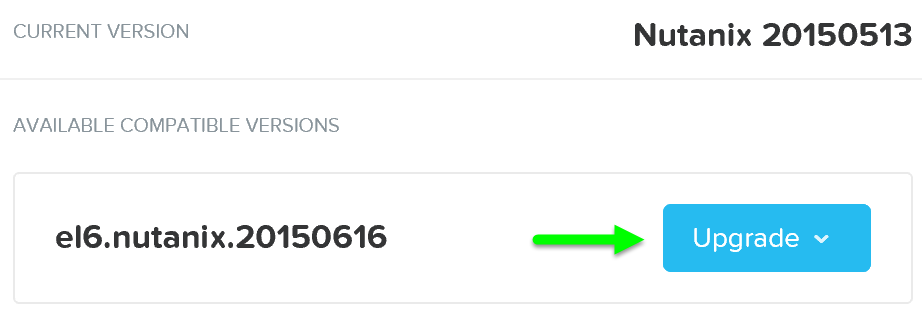

그런 다음 클라우드에서 하이퍼바이저 업그레이드 버전을 다운로드하거나 수동으로 버전을 업로드할 수 있다.

업그레이드 하이퍼바이저 – 메인 (Upgrade Hypervisor - Main)

업그레이드 하이퍼바이저 – 메인 (Upgrade Hypervisor - Main)

그런 다음 업그레이드 소프트웨어를 하이퍼바이저에 로드한다. 소프트웨어가 로드된 후 'Upgrade'를 클릭하여 업그레이드 프로세스를 시작한다.

업그레이드 하이퍼바이저 – 업그레이드 정합성 체크 (Upgrade Hypervisor - Upgrade Validation)

업그레이드 하이퍼바이저 – 업그레이드 정합성 체크 (Upgrade Hypervisor - Upgrade Validation)

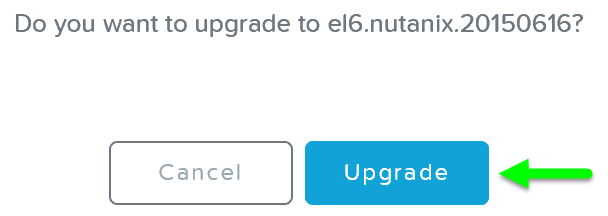

그러면 “확인” 다이얼로그 박스가 나타난다.

업그레이드 하이퍼바이저 – 업그레이드 확인 (Upgrade Hypervisor - Confirm Upgrade)

업그레이드 하이퍼바이저 – 업그레이드 확인 (Upgrade Hypervisor - Confirm Upgrade)

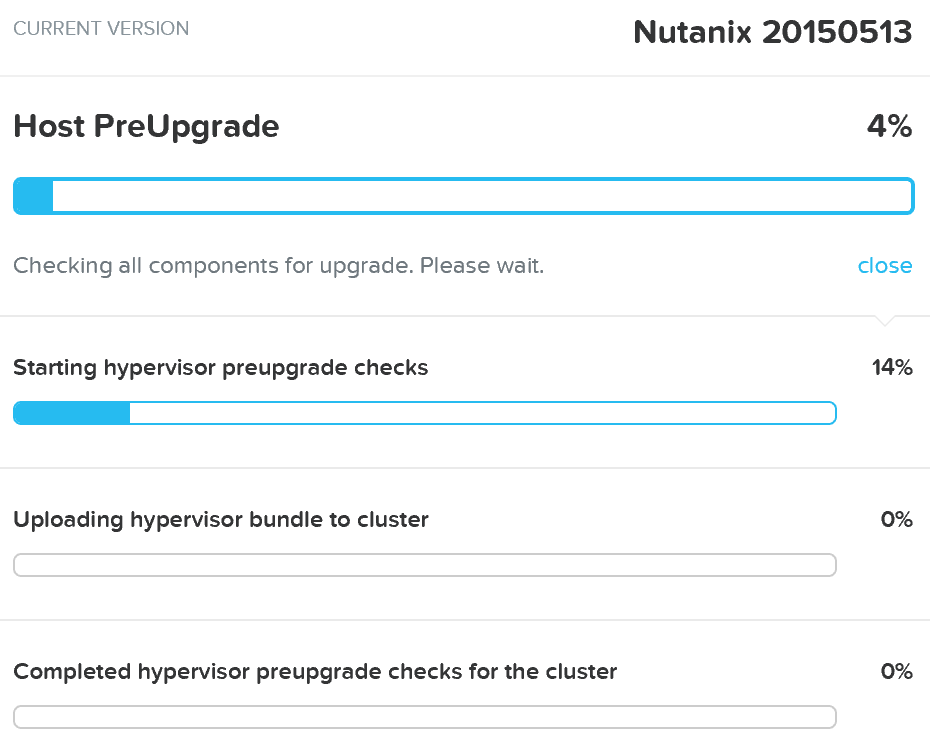

그러면 시스템은 호스트 업그레이드 사전 검사를 수행하고 하이퍼바이저 업그레이드를 클러스터에 업로드한다.

업그레이드 하이퍼바이저 – 업그레이드 사전 검사 (Upgrade Hypervisor - Pre-upgrade Checks)

업그레이드 하이퍼바이저 – 업그레이드 사전 검사 (Upgrade Hypervisor - Pre-upgrade Checks)

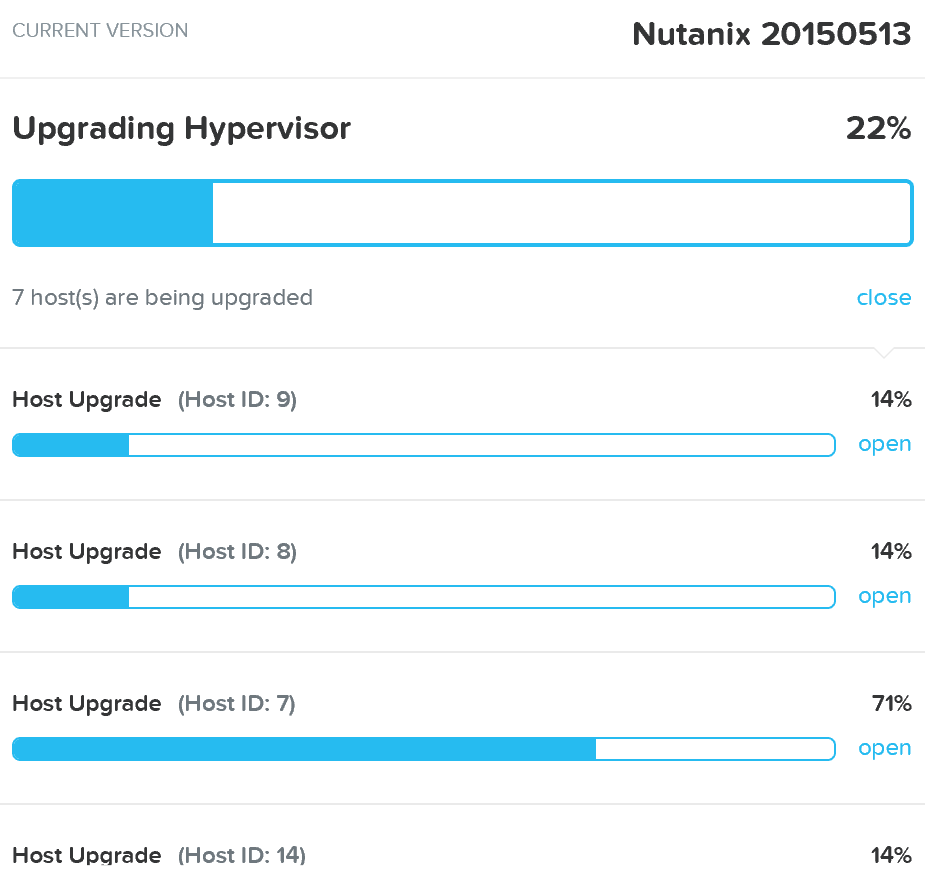

업그레이드 사전 검사가 완료되면 롤링 방식으로 하이퍼바이저 업그레이드가 진행된다.

업그레이드 하이퍼바이저 – 업그레이드 작업 수행 (Upgrade Hypervisor - Execution)

업그레이드 하이퍼바이저 – 업그레이드 작업 수행 (Upgrade Hypervisor - Execution)

뉴타닉스 소프트웨어 업그레이드의 롤링 특성과 마찬가지로 각 호스트는 실행 중인 VM에 영향을 주지 않고 롤링 방식으로 업그레이드된다. VM은 현재 호스트에서 라이브 마이그레이션되고, 호스트는 업그레이드된 다음 재부팅된다. 이 프로세스는 클러스터의 모든 호스트를 업그레이드할 때까지 각 호스트에서 반복된다.

Note

Pro tip

뉴타닉스 CVM에서 “host_upgrade –-status”를 실행하여 클러스터 전체 업그레이드 상태를 확인할 수 있다. 호스트 별 상세 상태는 “~/data/logs/host_upgrade.out”에 기록된다.

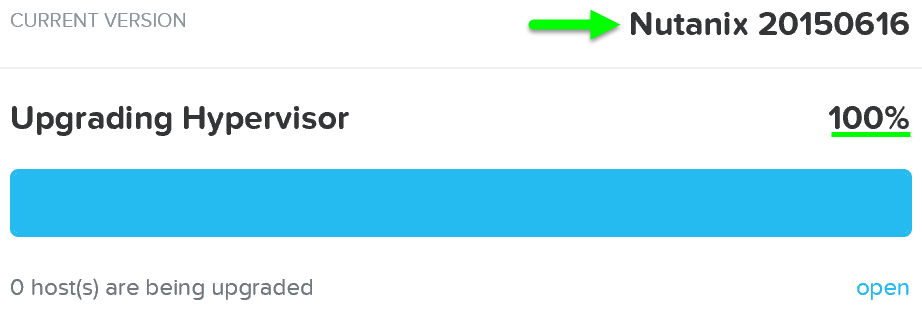

업그레이드가 완료되면 업데이트된 상태가 표시되고 모든 새로운 기능에 액세스할 수 있다.

업그레이드 하이퍼바이저 – 업그레이드 작업 완료 (Upgrade Hypervisor - Complete)

업그레이드 하이퍼바이저 – 업그레이드 작업 완료 (Upgrade Hypervisor - Complete)

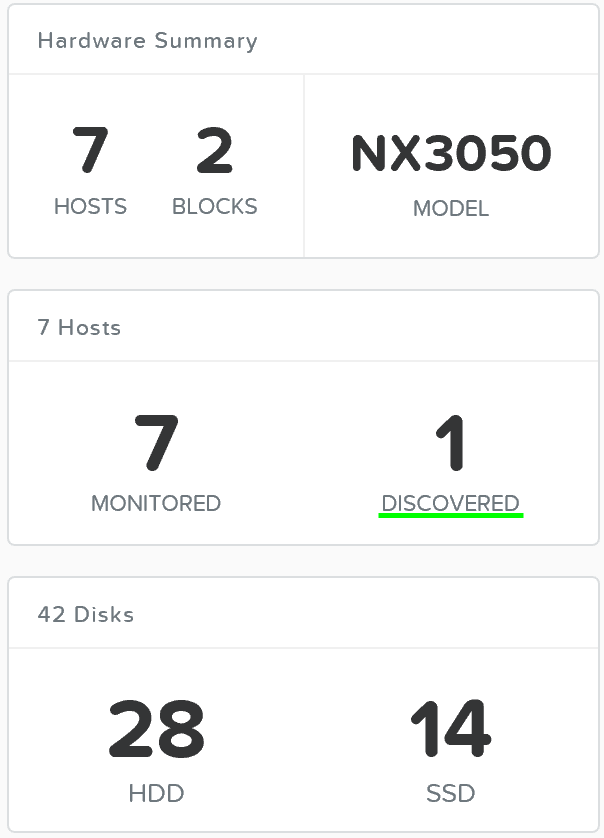

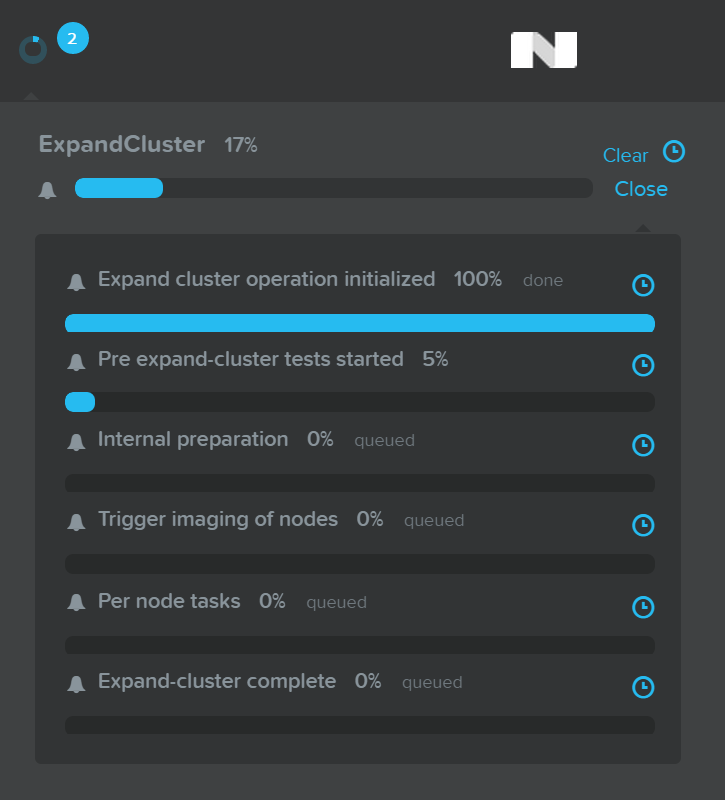

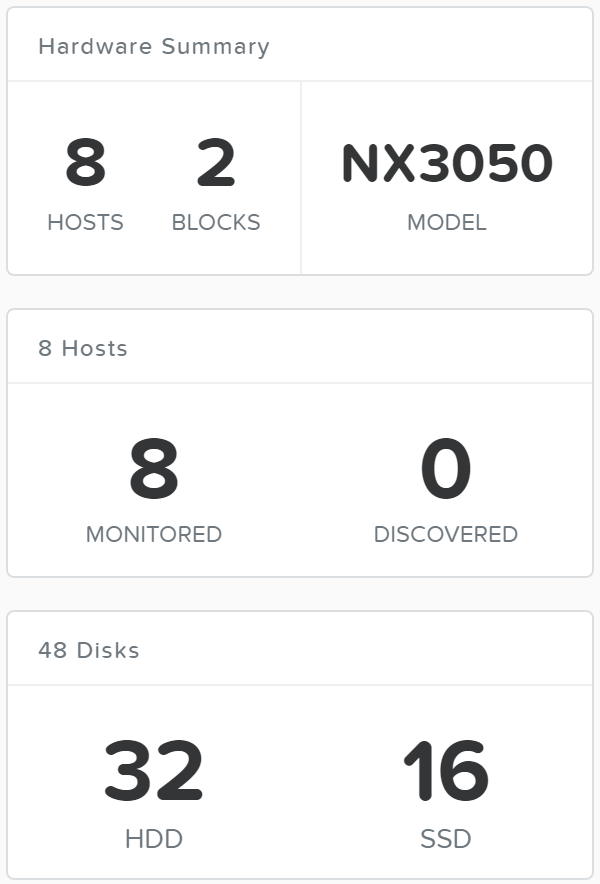

클러스터 확장 (노드 추가)

클러스터 확장 (Cluster Expansion)

클러스터 확장 (Cluster Expansion)

뉴타닉스 클러스터를 동적으로 확장할 수 있는 능력은 뉴타닉스 플랫폼의 핵심 기능이다. 뉴타닉스 클러스터를 확장하려면 노드를 랙에 장착하고 케이블을 연결한 후에 전원을 켠다. 노드 전원을 켜면 현재 클러스터는 mDNS를 사용하여 노드를 검색한다.

그림은 검색된 노드가 1개인 예제 7노드 클러스터를 보여준다.

노드 추가 – 검색 (Add Node - Discovery)

노드 추가 – 검색 (Add Node - Discovery)

여러 개의 노드를 동시에 검색하여 클러스터에 추가할 수 있다.

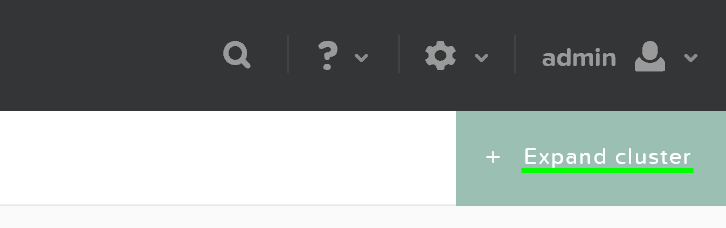

노드가 검색되면 “Hardware” 페이지의 오른쪽 상단에서 있는 “Expand Cluster”를 클릭하여 확장을 시작할 수 있다.

하드웨어 페이지 - 클러스터 확장 (Hardware Page - Expand Cluster)

하드웨어 페이지 - 클러스터 확장 (Hardware Page - Expand Cluster)

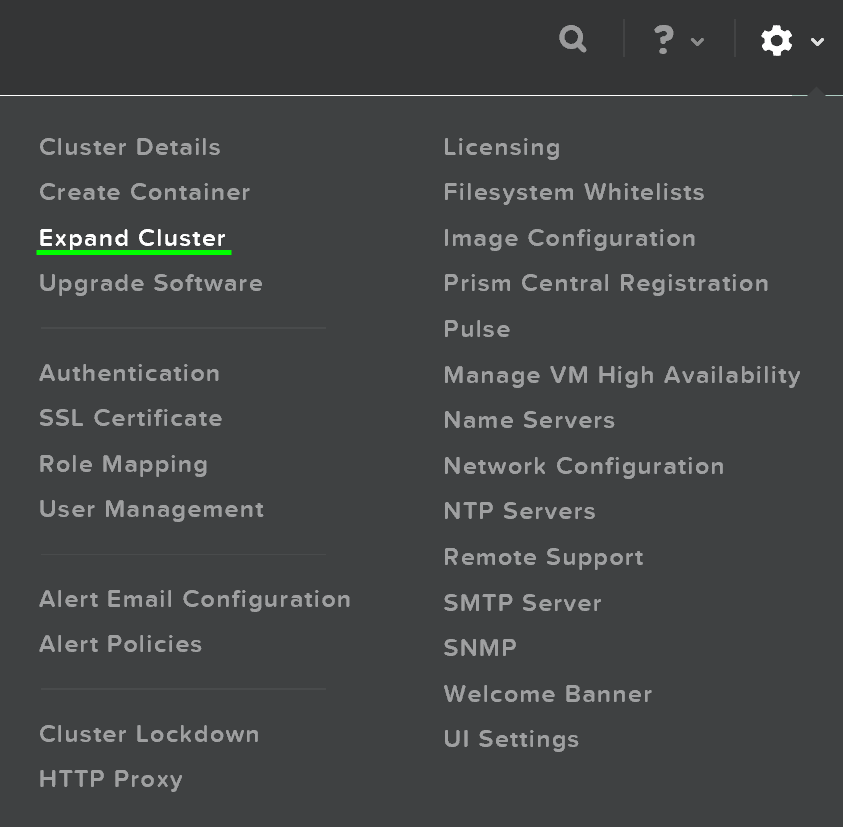

또한 모든 페이지에서 설정 아이콘을 클릭하여 클러스터 확장 프로세스를 시작할 수 있다.

설정 메뉴 – 클러스터 확장 (Gear Menu - Expand Cluster)

설정 메뉴 – 클러스터 확장 (Gear Menu - Expand Cluster)

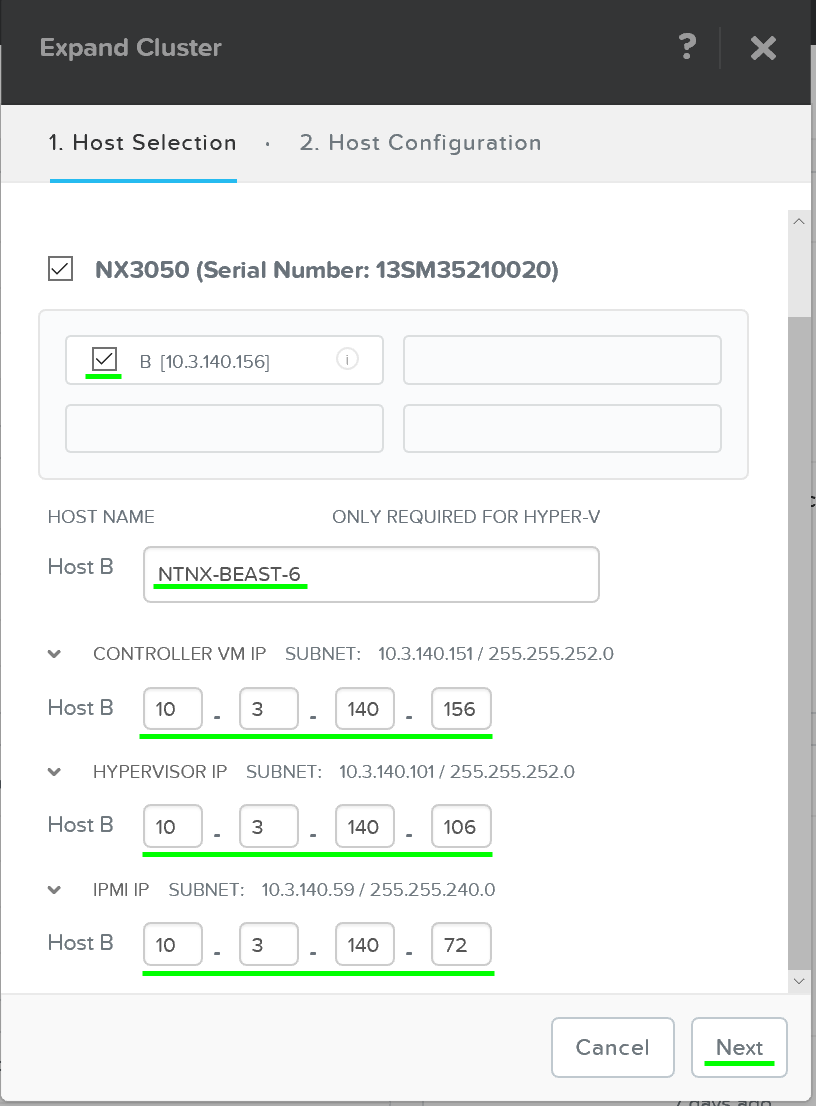

그러면 추가할 노드를 선택하고 컴포넌트의 IP 정보를 설정할 수 있는 확장 클러스터 메뉴가 시작된다.

클러스터 확장 – 호스트 선택 (Expand Cluster - Host Selection)

클러스터 확장 – 호스트 선택 (Expand Cluster - Host Selection)

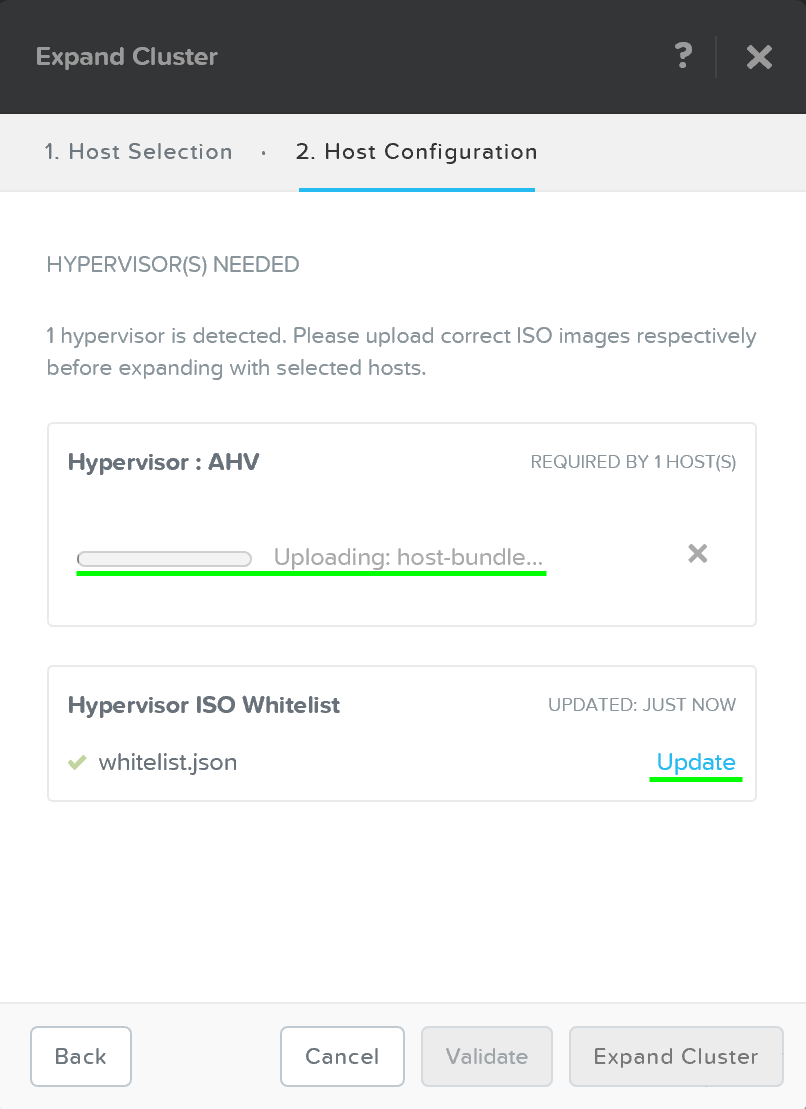

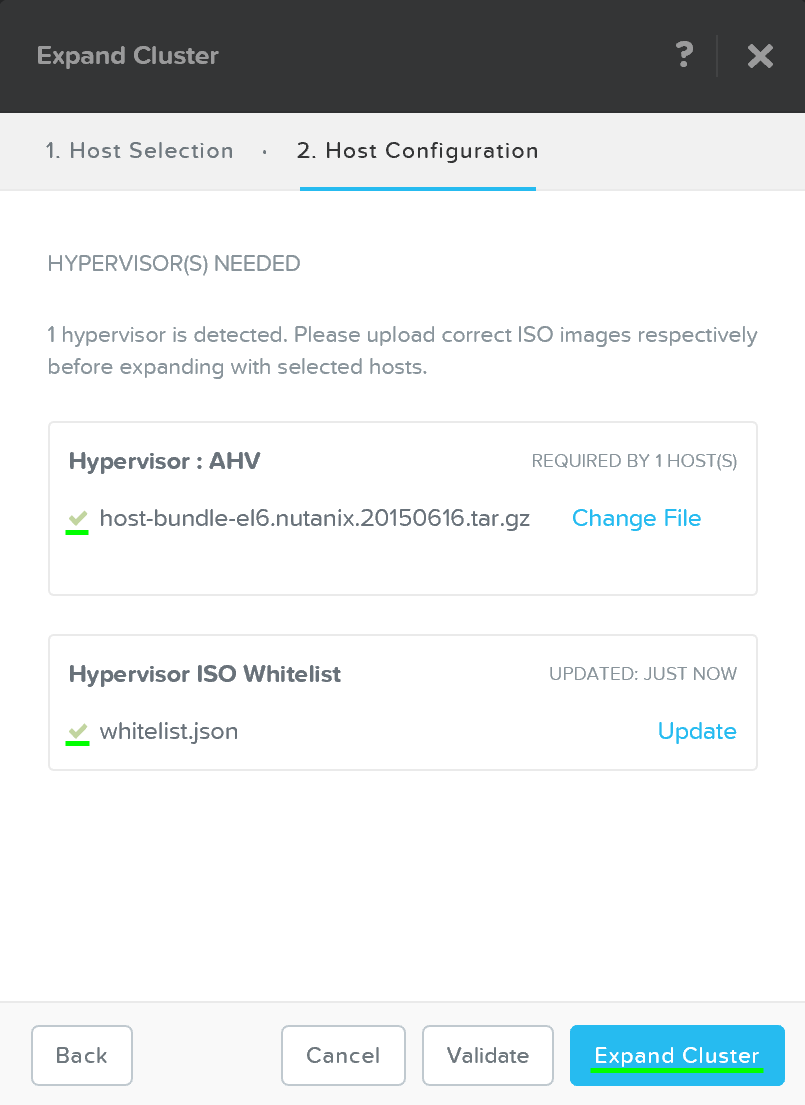

호스트를 선택하면 추가될 노드의 이미지를 만드는 데 사용될 하이퍼바이저 이미지를 업로드하라는 메시지가 표시된다. AHV 또는 이미지가 파운데이션 인스톨러 스토어에 이미 있는 경우에는 업로드가 필요하지 않다.

클러스터 확장 – 호스트 설정 (Expand Cluster - Host Configuration)

클러스터 확장 – 호스트 설정 (Expand Cluster - Host Configuration)

업로드가 완료되면 “Expand Cluster”를 클릭하여 이미징 및 확장 프로세스를 시작한다.

클러스터 확장 – 작업 시작 (Expand Cluster - Execution)

클러스터 확장 – 작업 시작 (Expand Cluster - Execution)

잡(Job)이 제출되고 해당 태스크 아이템이 나타난다.

클러스터 확장 – 작업 수행 (Expand Cluster - Execution)

클러스터 확장 – 작업 수행 (Expand Cluster - Execution)

자세한 태스크 상태는 태스크를 확장하여 볼 수 있다.

클러스터 확장 – 상세 작업 상태 (Expand Cluster - Execution)

클러스터 확장 – 상세 작업 상태 (Expand Cluster - Execution)

이미징 및 노드 추가 프로세스가 완료되면 업데이트된 클러스터 크기와 자원을 확인할 수 있다.

클러스터 확장 – 노드 추가 작업 완료 (Expand Cluster - Execution)

클러스터 확장 – 노드 추가 작업 완료 (Expand Cluster - Execution)

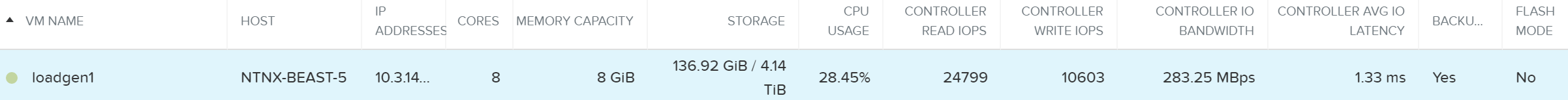

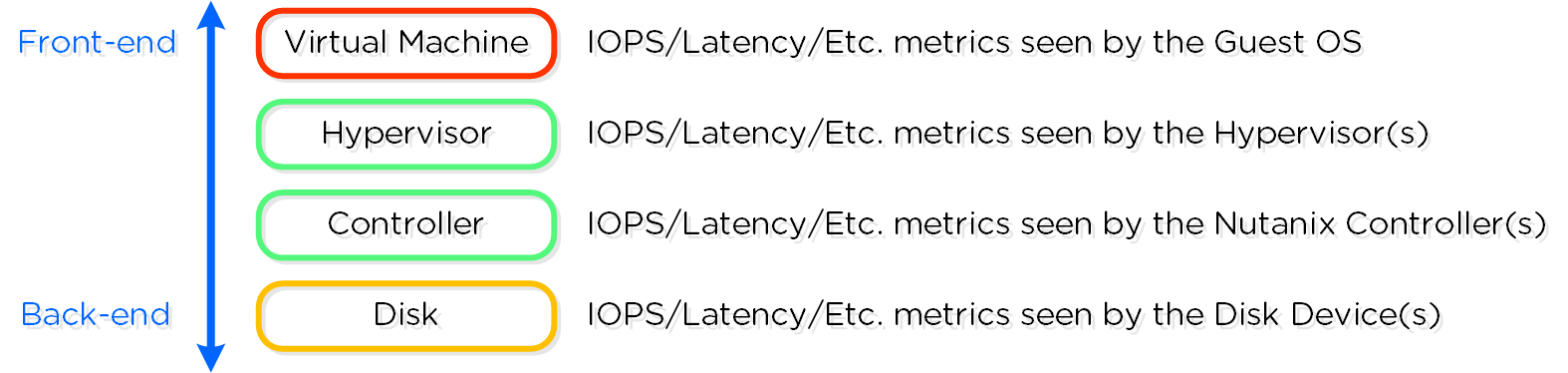

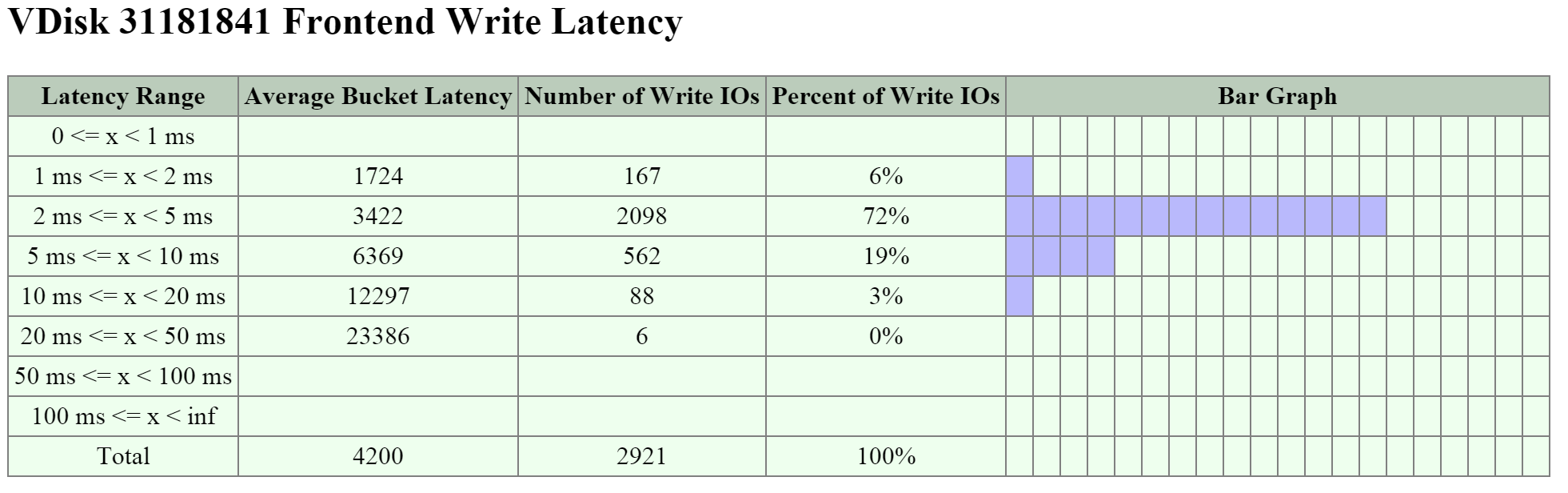

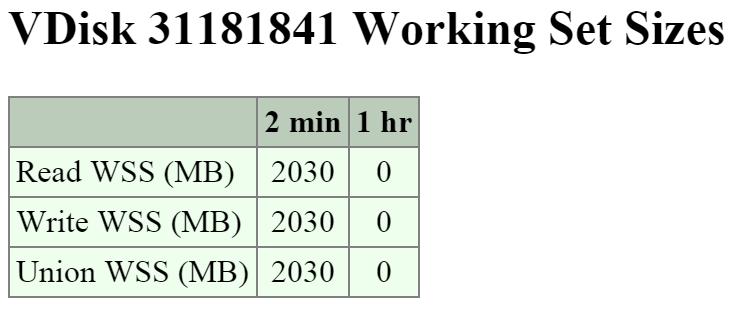

I/O 메트릭스

병목현상을 파악하는 것은 성능 문제 해결 프로세스의 매우 중요한 부분이다. 이 프로세스를 돕기 위해 뉴타닉스는 VM 페이지에 "I/O 메트릭스(I/O Metrics)" 섹션을 도입했다.

레이턴시는 여러 변수(큐 깊이, I/O 크기, 시스템 조건, 네트워크 속도 등)에 따라 달라진다. 이 페이지는 I/O 크기, 레이턴시, 소스 및 패턴에 대한 통찰력을 제공하는 것을 목표로 한다.

새로운 섹션을 사용하려면 VM 페이지로 이동하여 테이블에서 원하는 VM을 선택한다. 여기에서 높은 수준의 사용량 메트릭스를 확인할 수 있다.

VM 페이지 - 상세 (VM Page - Details)

VM 페이지 - 상세 (VM Page - Details)

'I/O Metrics' 탭은 테이블 아래 섹션에서 찾을 수 있다.

VM 페이지 - I/O 메트릭스 탭 (VM Page - I/O Metrics Tab)

VM 페이지 - I/O 메트릭스 탭 (VM Page - I/O Metrics Tab)

'I/O Metrics' 탭을 선택하면 상세 뷰가 표시된다. 본 섹션에서 이 페이지를 세분화하고 그것을 어떻게 사용하는지를 설명한다.

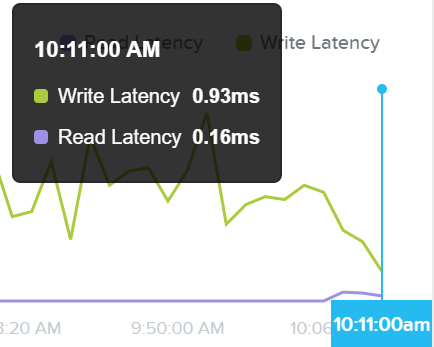

첫 번째 뷰는 지난 3시간 동안의 평균 레이턴시를 보여주는 “Avg I/O Latency” 섹션이다. 기본적으로 가장 최근에 보고된 값이 해당 시점에 상응하는 세부 메트릭스와 함께 표시된다.

플롯 위로 마우스를 가져가면 과거 레이턴시 값을 볼 수 있고 플롯의 시간을 클릭하여 아래와 같은 세부 메트릭스를 볼 수 있다.

I/O 메트릭스 - 레이턴시 플롯 (I/O Metrics - Latency Plot)

I/O 메트릭스 - 레이턴시 플롯 (I/O Metrics - Latency Plot)

이것은 갑작스러운 스파이크가 보일 때 유용할 수 있다. 스파이크가 보이고 추가 조사가 필요하면 스파이크를 클릭하고 아래의 세부 정보를 분석한다.

I/O 메트릭스 - 레이턴시 플롯 (I/O Metrics - Latency Plot)

I/O 메트릭스 - 레이턴시 플롯 (I/O Metrics - Latency Plot)

레이턴시가 모두 정상이면 추가 분석을 진행할 필요가 없다.

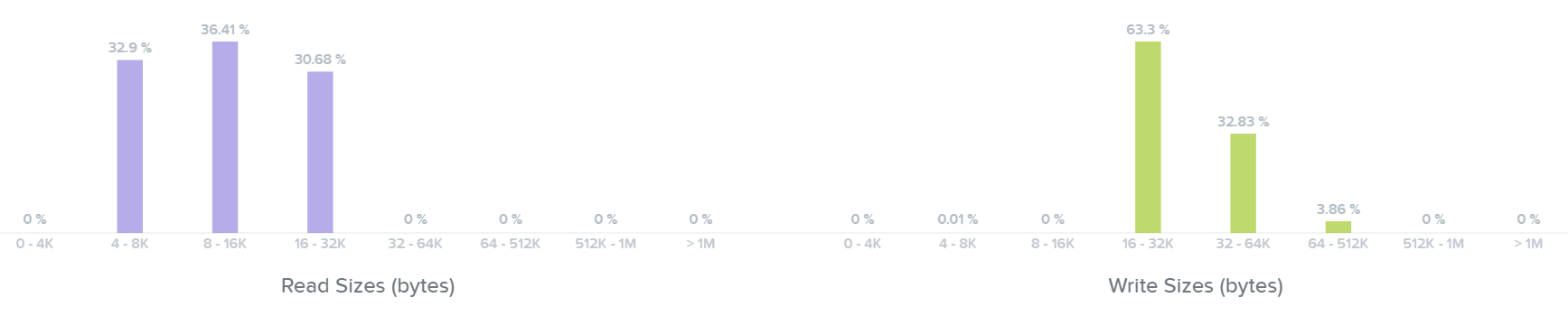

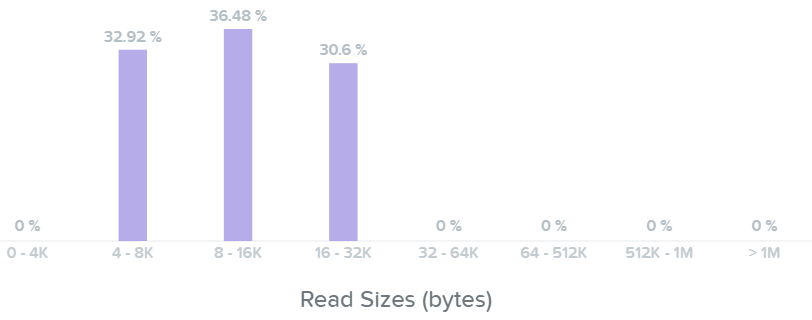

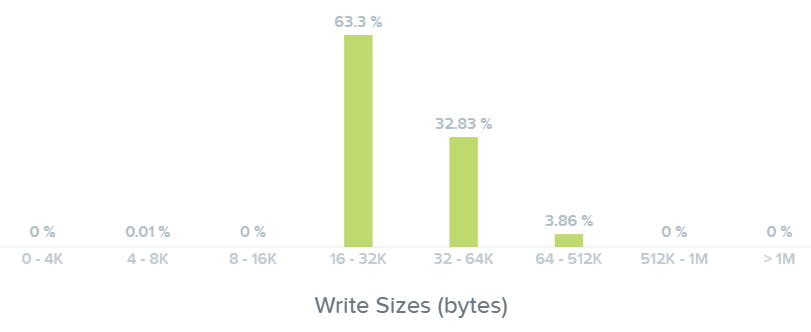

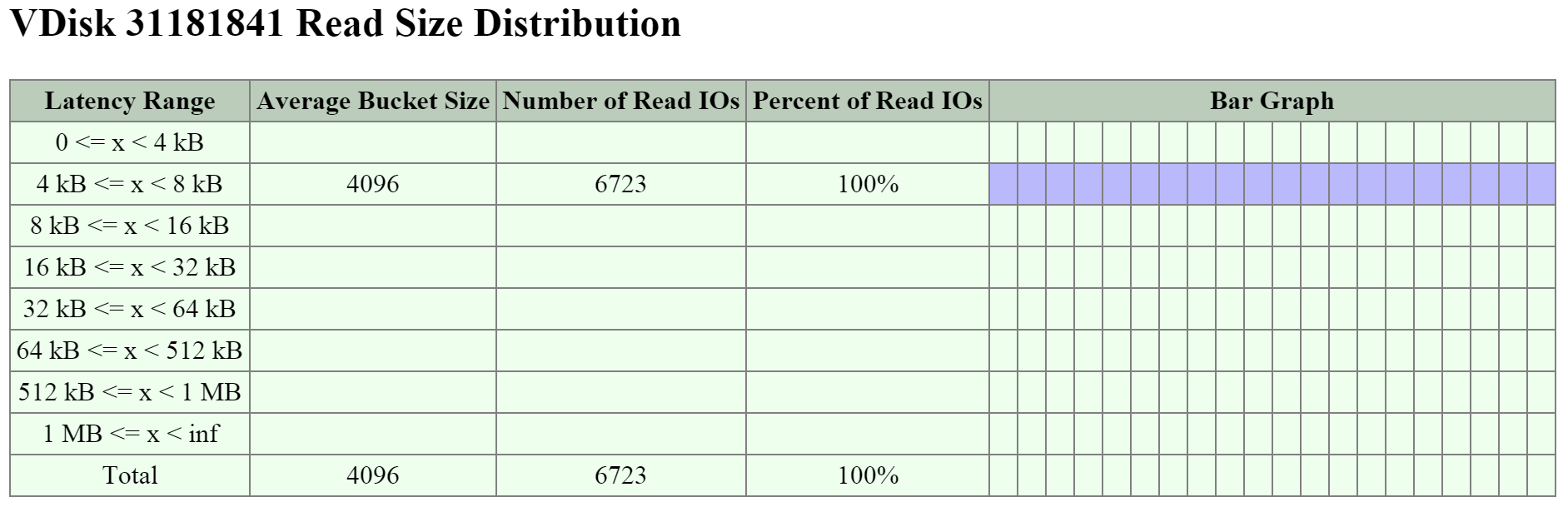

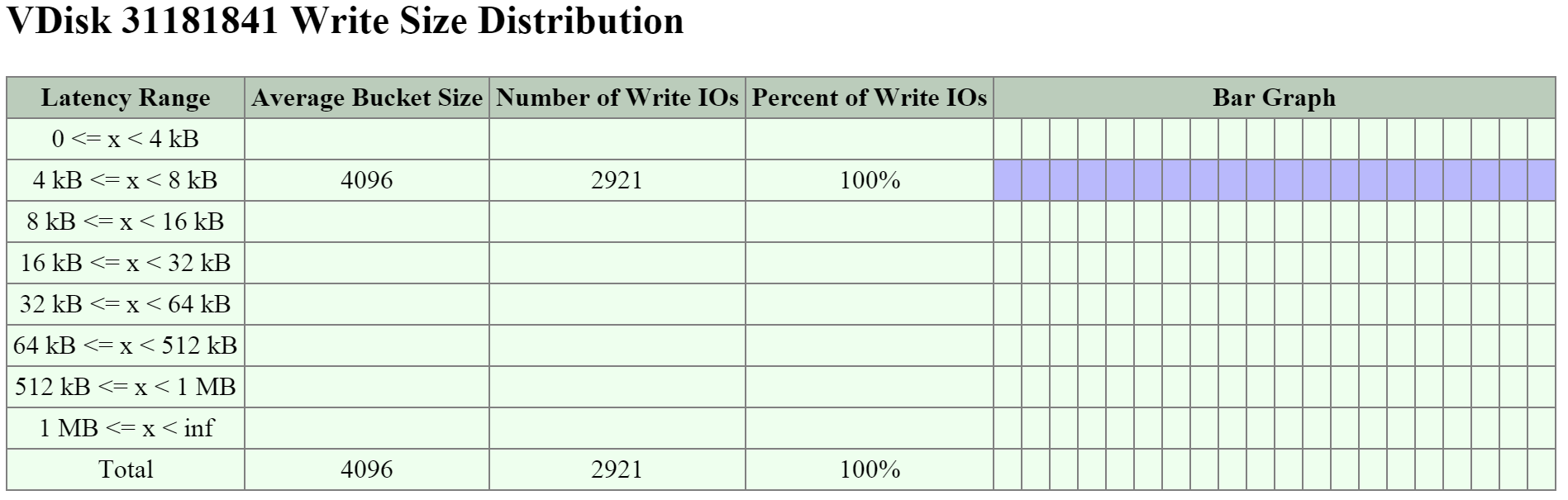

다음 섹션은 읽기 및 쓰기 I/O에 대한 I/O 크기 막대 그래프를 보여준다.

I/O 메트릭스 - I/O 크기 막대 그래프 (I/O Metrics - I/O Size histogram)

I/O 메트릭스 - I/O 크기 막대 그래프 (I/O Metrics - I/O Size histogram)

여기에서 읽기 I/O 범위가 크기 기준으로 4K에서 32K까지인 것을 볼 수 있다.

I/O 메트릭스 - 읽기 I/O 크기 막대 그래프 (I/O Metrics - Read I/O Size histogram)

I/O 메트릭스 - 읽기 I/O 크기 막대 그래프 (I/O Metrics - Read I/O Size histogram)

여기에서 쓰기 I/O 범위가 크기 기준으로 16K에서 64K까지이며 최대 512K까지인 것을 볼 수 있다.

I/O 메트릭스 - 쓰기 I/O 크기 막대 그래프 (I/O Metrics - Write I/O Size histogram)

I/O 메트릭스 - 쓰기 I/O 크기 막대 그래프 (I/O Metrics - Write I/O Size histogram)

Note

Pro tip

레이턴시에서 스파이크를 보았을 때 첫 번째로 확인해야 할 것은 I/O 크기이다. 일반적으로 큰 I/O(64K~1MB)가 작은 I/O(4K~32K) 보다 레이턴시가 더 높다.

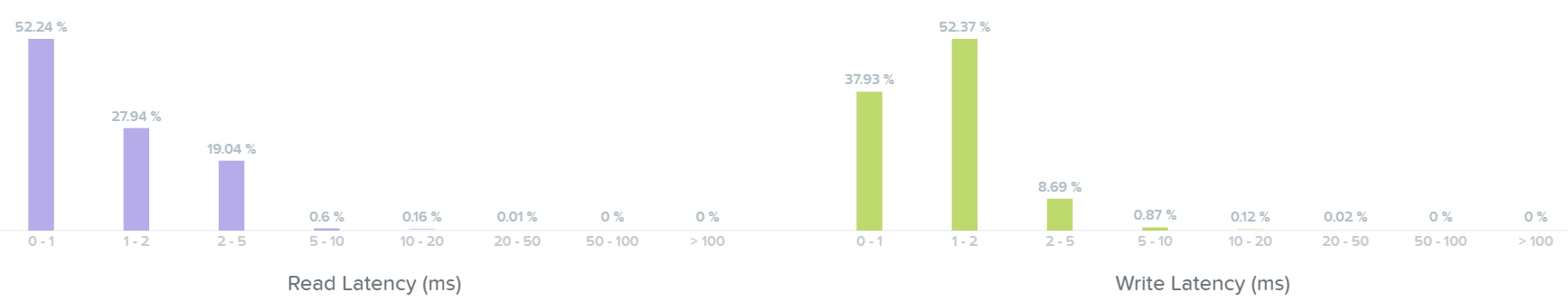

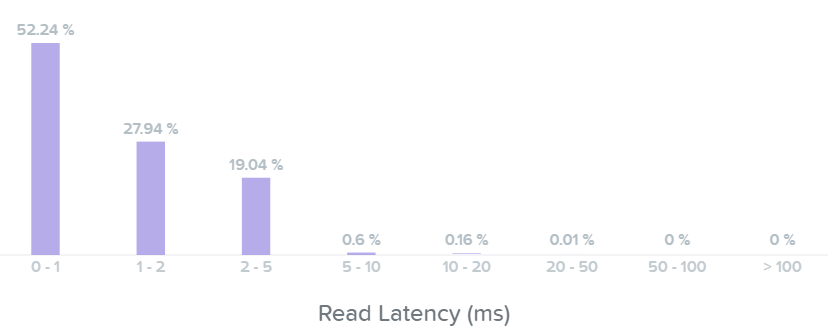

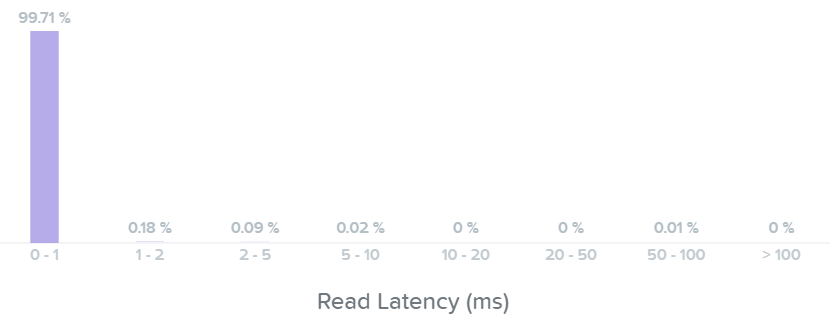

다음 섹션에서는 읽기 및 쓰기 I/O에 대한 I/O 레이턴시 막대 그래프를 보여준다.

I/O 메트릭스 – 레이턴시 막대 그래프 (I/O Metrics - Latency histogram)

I/O 메트릭스 – 레이턴시 막대 그래프 (I/O Metrics - Latency histogram)

읽기 레이턴시 막대 그래프를 보면 대부분의 읽기 I/O가 최대 2~5ms 이하의 sub-ms(<1ms)인 것을 볼 수 있다.

I/O 메트릭스 – 읽기 레이턴시 막대 그래프 (I/O Metrics - Read Latency histogram)

I/O 메트릭스 – 읽기 레이턴시 막대 그래프 (I/O Metrics - Read Latency histogram)

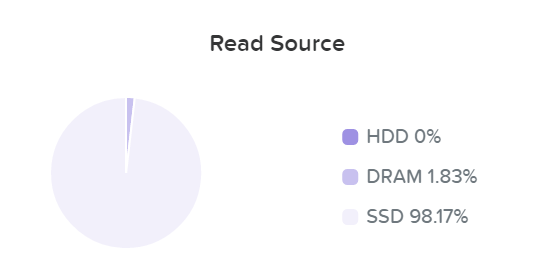

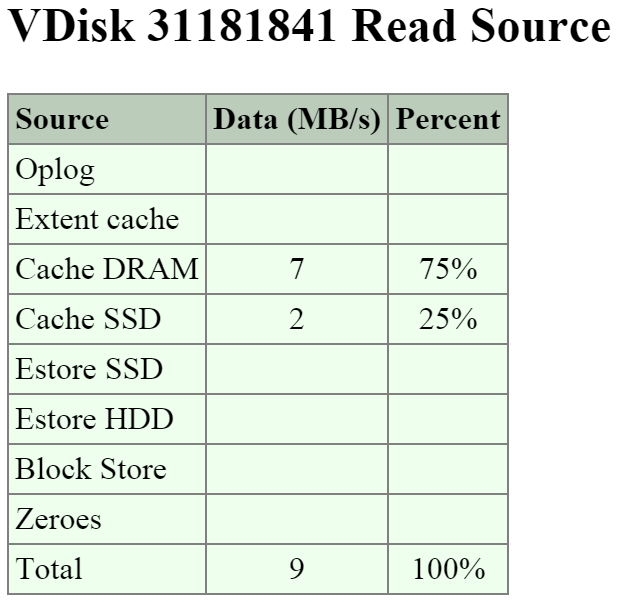

아래의 "읽기 소스"를 살펴보면 대부분의 I/O가 SSD 계층에서 서비스되는 것을 볼 수 있다.

I/O 메트릭스 - SSD에서 읽기 (I/O Metrics - Read Source SSD)

I/O 메트릭스 - SSD에서 읽기 (I/O Metrics - Read Source SSD)

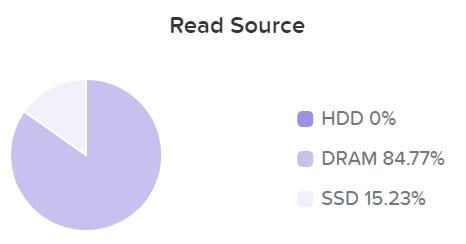

데이터가 읽힐 때 데이터는 실시간으로 유니파이드 캐시로 적재된다 (“I/O 경로 및 캐시” 섹션 참조). 여기에서 데이터가 캐시에 저장되어 있고 DRAM에서 서비스되는 것을 볼 수 있다.

I/O 메트릭스 - DRAM에서 읽기 (I/O Metrics - Read Source DRAM)

I/O 메트릭스 - DRAM에서 읽기 (I/O Metrics - Read Source DRAM)

기본적으로 모든 읽기 I/O 레이턴시가 sub-ms(< 1ms)인 것을 볼 수 있다.

I/O 메트릭스 - 읽기 레이턴시 막대 그래프 (I/O Metrics - Read Latency histogram)

I/O 메트릭스 - 읽기 레이턴시 막대 그래프 (I/O Metrics - Read Latency histogram)

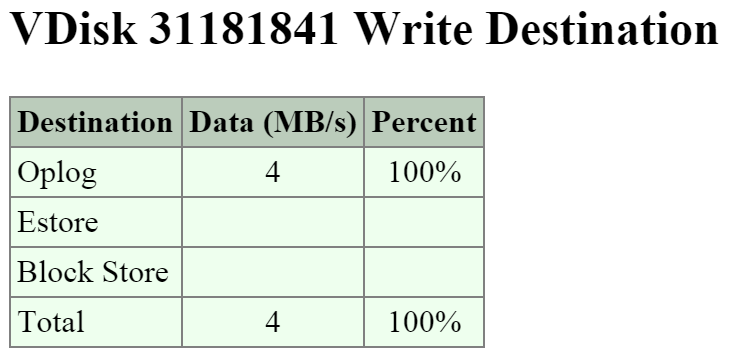

여기에서 대부분의 쓰기 I/O 레이턴시가 1~2ms인 것을 볼 수 있다.

I/O 메트릭스 - 쓰기 레이턴시 막대 그래프 (I/O Metrics - Write Latency histogram)

I/O 메트릭스 - 쓰기 레이턴시 막대 그래프 (I/O Metrics - Write Latency histogram)

Note

Pro tip

읽기 레이턴시에서 스파이크가 보이고 I/O 크기가 크지 않다면 읽기 I/O가 어디에서 서비스되고 있는지를 확인하여야 한다. HDD에서 초기 읽기는 DRAM 캐시보다 레이턴시가 높지만 캐시에 저장된 이후의 모든 읽기는 DRAM에서 서비스되므로 레이턴시가 향상된 것을 볼 수 있다.

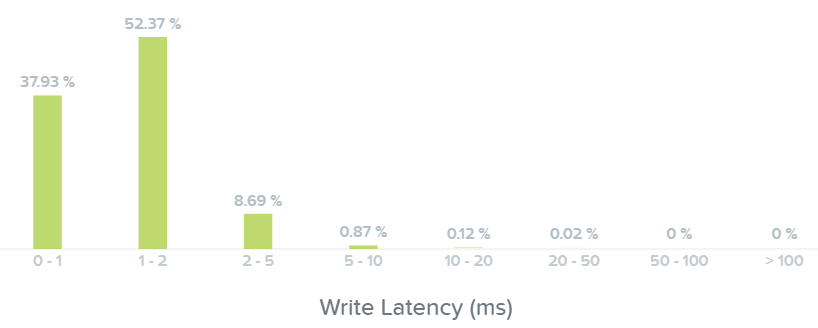

마지막 섹션에서는 I/O 패턴과 랜덤 대 순차가 얼마나 되는지를 보여준다.

I/O 메트릭스 – RW 랜덤 데이터 vs 순차 데이터 (I/O Metrics - RW Random vs. Sequential)

I/O 메트릭스 – RW 랜덤 데이터 vs 순차 데이터 (I/O Metrics - RW Random vs. Sequential)

일반적으로 I/O 패턴은 애플리케이션 또는 워크로드에 따라 다르다 (e.g. VDI는 주로 랜덤 데이터인 반면에 하둡은 기본적으로 순차 데이터임). 다른 워크로드는 두 가지가 혼합되어 있다. 예를 들어 데이터베이스에서 입력 및 일부 조회는 랜덤일 수 있지만 ETL 중에는 순차이다.

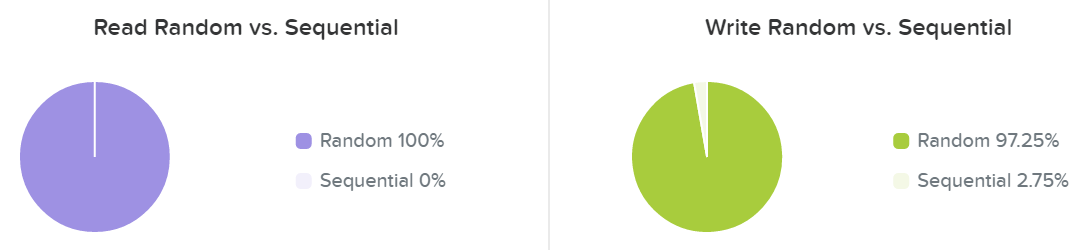

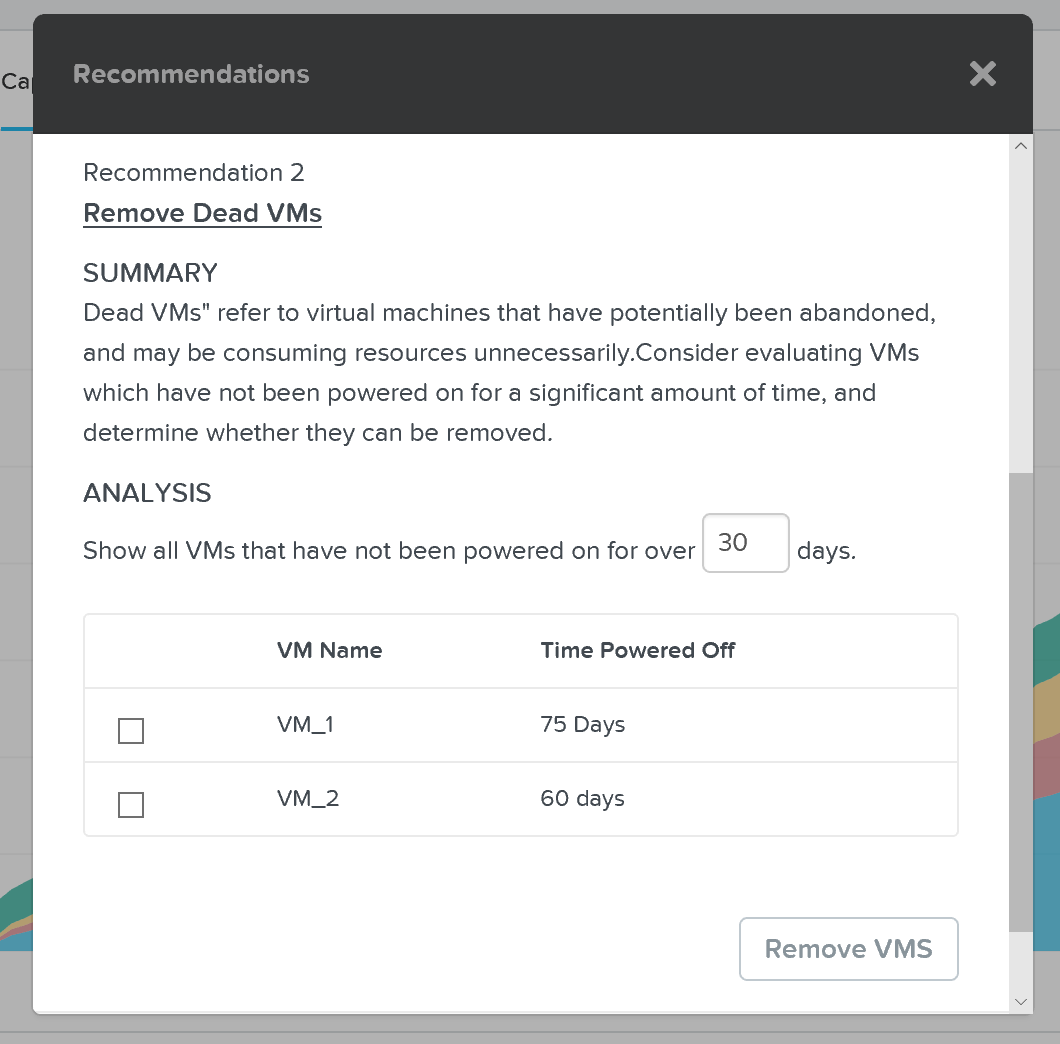

용량 계획

자세한 용량 계획 세부 정보를 얻으려면 프리즘 센트럴의 'Cluster Runway' 섹션에서 특정 클러스터를 클릭하면 자세한 내용을 불 수 있다.

프리즘 센트럴 – 용량 계획 (Prism Central - Capacity Planning)

프리즘 센트럴 – 용량 계획 (Prism Central - Capacity Planning)

이 뷰는 클러스터 런웨이에 대한 자세한 정보를 제공하며 가장 제약된 자원(제한 자원)을 식별한다. 또한 상위 자원 소비자가 무엇인지에 대한 자세한 정보는 물론 클러스터 확장을 위한 추가 용량 또는 이상적인 노드 유형을 정리할 수 있는 몇 가지 잠재적 옵션을 얻을 수 있다.

프리즘 센트럴 – 용량 계획 – 권고 사항 (Prism Central - Capacity Planning - Recommendations)

프리즘 센트럴 – 용량 계획 – 권고 사항 (Prism Central - Capacity Planning - Recommendations)

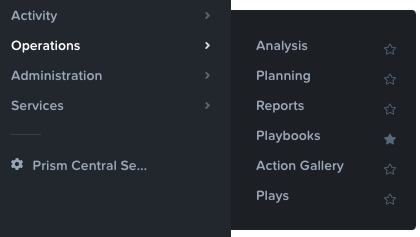

X-Play

우리가 일상 활동에 대해 생각할 때, 우리가 자동화를 많이 하면 할수록 좋다. 우리는 일상생활의 반복적인 업무에서 자동화를 끊임없이 하고 있으며, 기술을 통해 다른 분야에서도 똑같이 자동화를 할 수 있다. 프리즘 프로 X-Play를 사용하면 프리즘을 통해 일반적인 활동을 자동화할 수 있다. 그러나, 제품을 설명하기 전에 먼저 우리가 하려는 일을 다루고자 한다.

이벤트 기반의 자동화는 다음과 같은 방식으로 동작한다.

event(s) → logic → action(s)

이 시나리오에는 일련의 액션을 트리거하는 일종의 이벤트(또는 캐스캐이딩 이벤트)가 발생한다. 이와 관련된 좋은 예는 IFTTT로, 이벤트를 가져 와서 일부 논리('if this then that'와 같은 방식)를 적용한 다음 액션을 수행한다.

예를 들어, 일반적으로 우리는 외출하기 전에 집의 전등을 끈다. 시스템이 모든 전등을 자동으로 끄도록 트리거하는 이벤트를 프로그래밍할 수 있다면(e.g. 외출 / 모든 전등 소등), 생활이 보다 편리해질 것이다.

이를 IT 운영 활동과 비교하면 유사한 패턴을 볼 수 있다. 이벤트가 발생하면(e.g. VM에 더 많은 디스크 공간이 필요함) 일련의 액션을 수행한다 (e.g. 티켓 생성, 스토리지 추가, 티켓 닫기 등). 이러한 반복적인 액티비티는 자동화의 가치를 극대화하고 우리가 좀 더 가치 있는 일에 집중할 수 있게 하는 아주 좋은 예이다.

X-Play를 사용하면 일련의 이벤트/경고가 발생하였을 때 시스템이 이를 가로채어 일련의 액션을 수행할 수 있다.

X-Play를 사용하려면 프리즘 센트럴의 'Operations -> Plays' 메뉴로 이동한다.

X-Play - 내비게이션 (X-Play - Navigation)

X-Play - 내비게이션 (X-Play - Navigation)

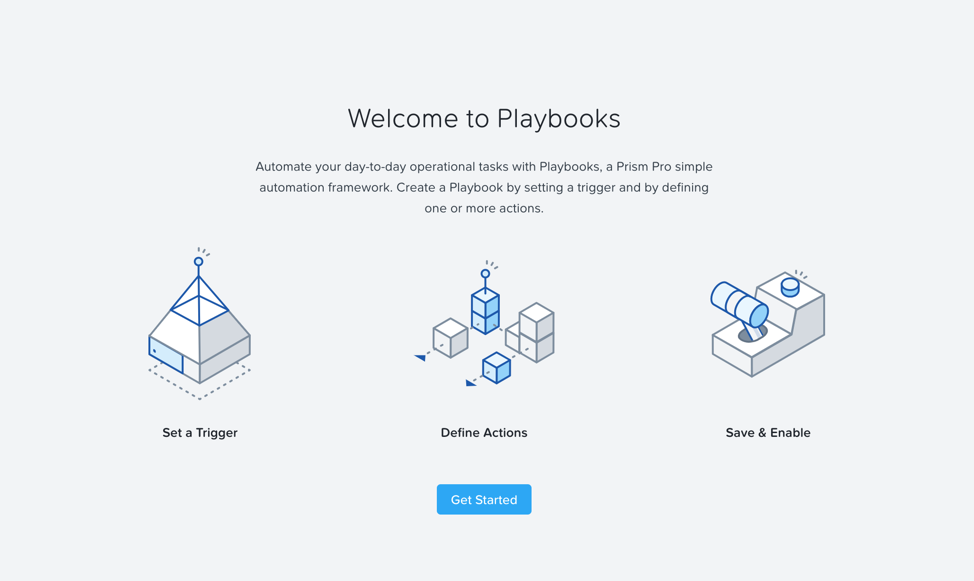

X-Play 메인 페이지가 나타난다.

X-Play - 플레이북 개요 (X-Play - Playbooks Overview)

X-Play - 플레이북 개요 (X-Play - Playbooks Overview)

'Get Started'를 클릭하여 현재 Plays를 보거나 새로운 Plays를 생성한다.

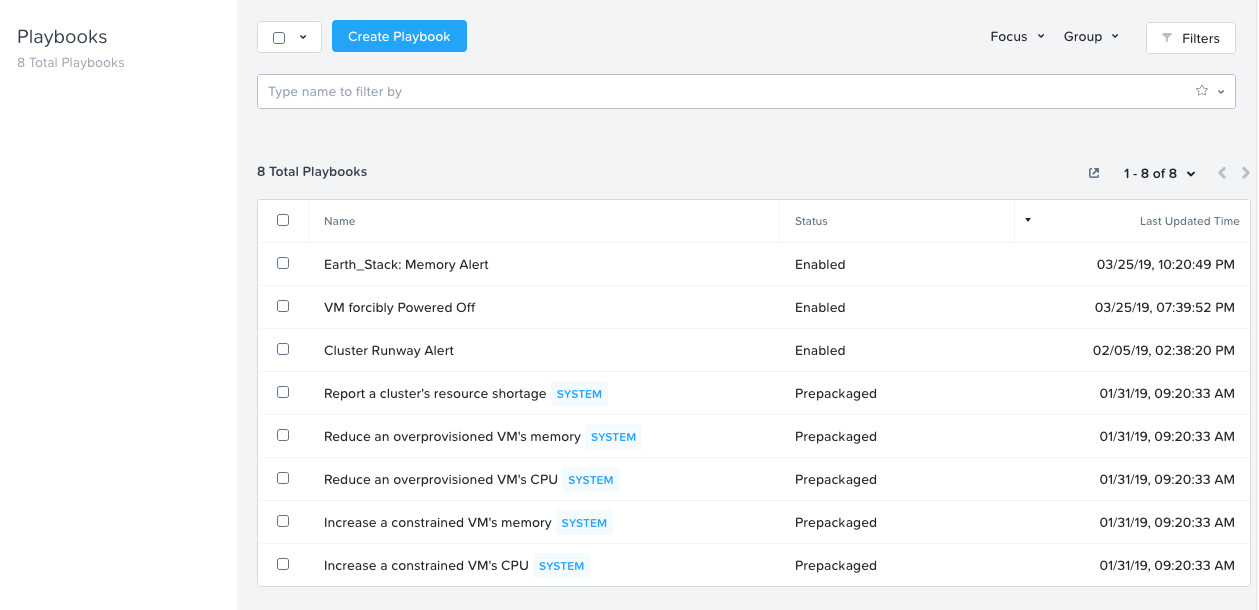

X-Play - 플레이북 (X-Play - Playbooks)

X-Play - 플레이북 (X-Play - Playbooks)

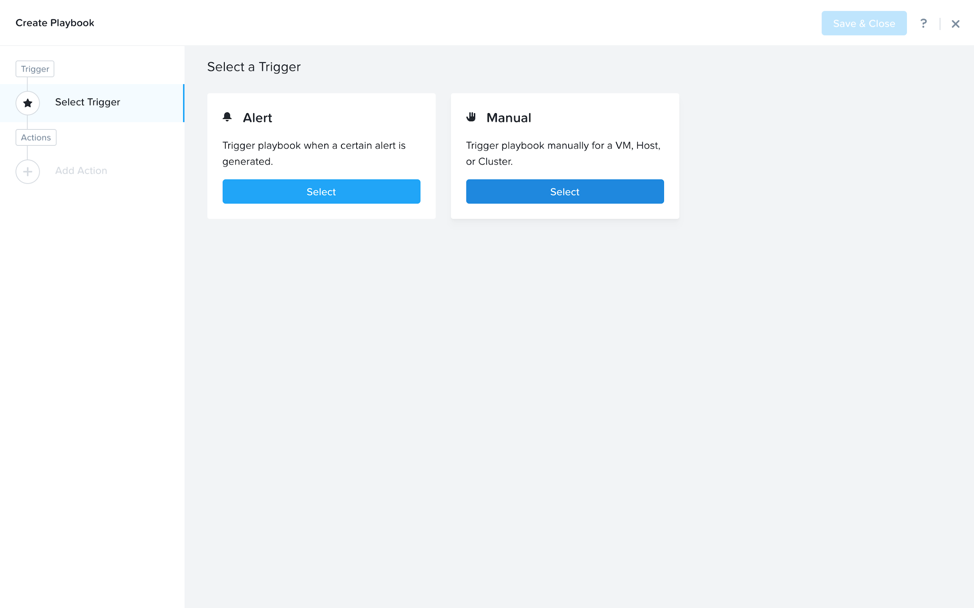

여기에서 먼저 트리거를 정의하여 새로운 플레이북을 생성할 수 있다.

X-Play - 트리거 (X-Play - Trigger)

X-Play - 트리거 (X-Play - Trigger)

다음은 사용자 정의 경고에 기반한 트리거의 예를 보여준다.

X-Play - 트리거 - 사용자 정의 경고 (X-Play - Trigger - Custom Alert)

X-Play - 트리거 - 사용자 정의 경고 (X-Play - Trigger - Custom Alert)

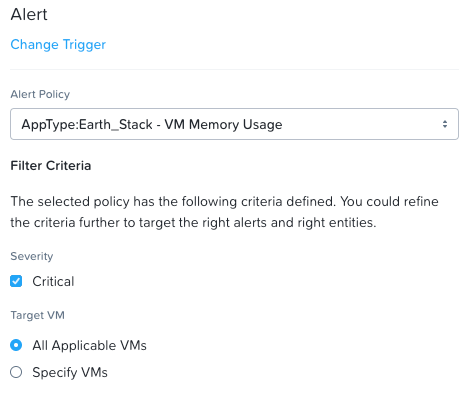

트리거가 정의한 후에 일련의 액션을 설정할 수 있다. 다음은 몇 가지 샘플 액션을 보여준다.

X-Play- 액션 (X-Play - Actions)

X-Play- 액션 (X-Play - Actions)

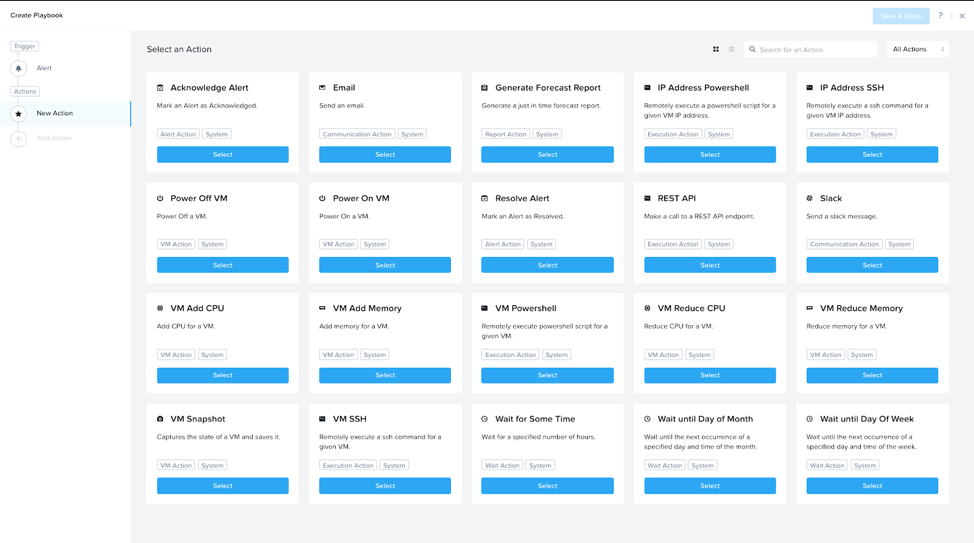

그런 다음 액션의 세부 사항을 입력한다. 다음은 샘플 REST API 호출을 보여준다.

X-Play - 샘플 REST 액션 (X-Play - Sample REST Action)

X-Play - 샘플 REST 액션 (X-Play - Sample REST Action)

Note

REST API 액션 및 외부 시스템 (Actions and External Systems)

X-Play는 이메일 전송, 슬랙 메시지 전송 및 REST API 호출 수행 등과 같은 다양한 기본 작업을 제공한다.

이것은 CMDB 또는 다른 티케팅/자동화 도구와 같은 외부 시스템과의 인터페이스를 고려할 때 매우 중요하다. REST API 액션을 사용하여 티켓 생성/해결, 다른 워크플로우 시작 등을 수행할 수 있다. 이는 모든 시스템을 동기화할 수 있는 매우 강력한 옵션이다.

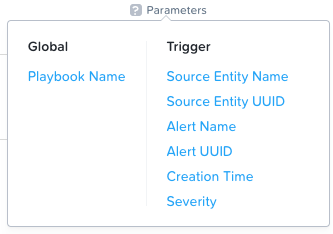

엔티티/이벤트 특정 세부 사항의 경우 이벤트, 엔티티 및 기타에 대한 세부 사항을 제공하는 'parameter' 변수를 사용할 수 있다.

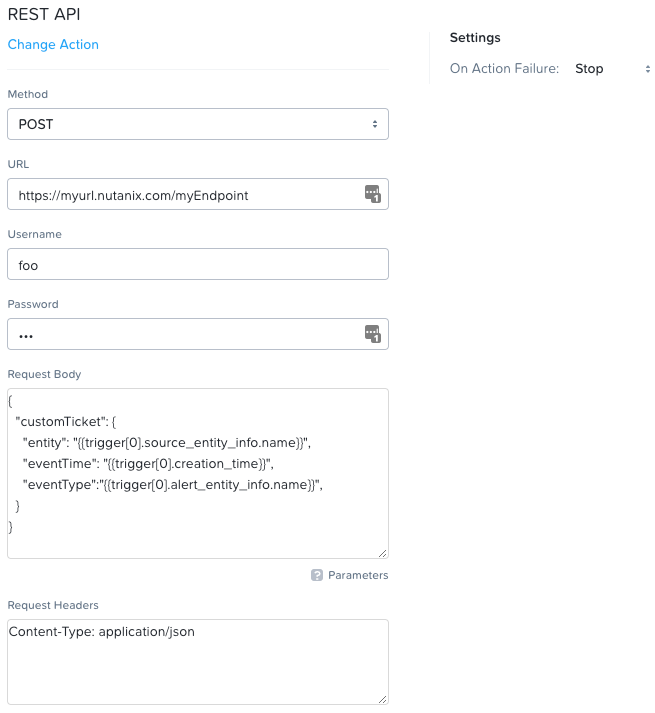

X-Play - 액션 파라미터 (X-Play - Action Parameters)

X-Play - 액션 파라미터 (X-Play - Action Parameters)

완료되면 Play를 저장한다. Plays는 정의된 대로 실행한다.

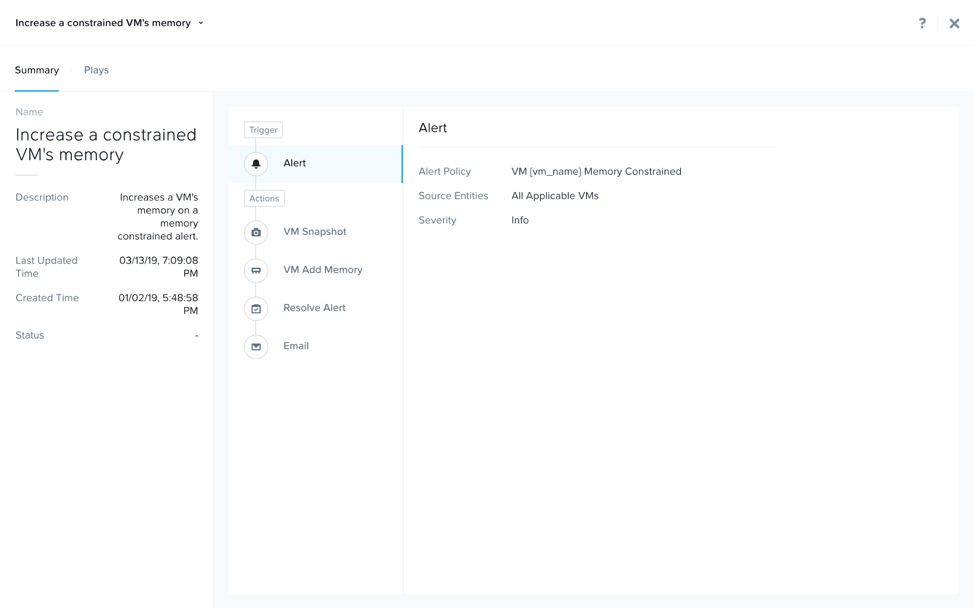

다음은 수행된 여러 개의 액션을 갖는 샘플 플레이를 보여준다:

X-Play - 샘플 플래이북 (X-Play - Sample Playbook)

X-Play - 샘플 플래이북 (X-Play - Sample Playbook)

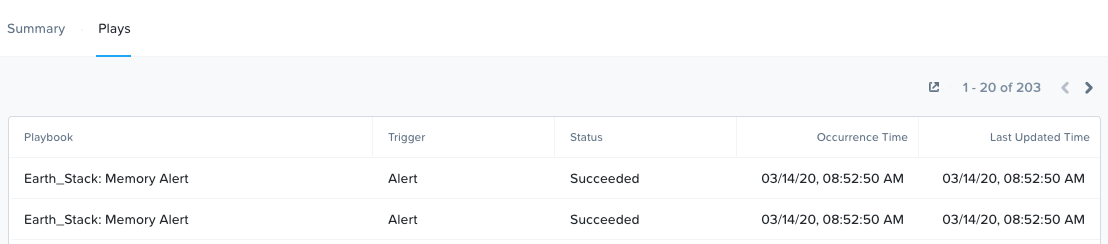

'Plays' 탭에는 Plays 실행 시간과 상태가 표시된다.

X-Play - Plays 실행 (X-Play - Plays Executed)

X-Play - Plays 실행 (X-Play - Plays Executed)

모든 것을 자동화할 수 있다는 것을 기억하세요!

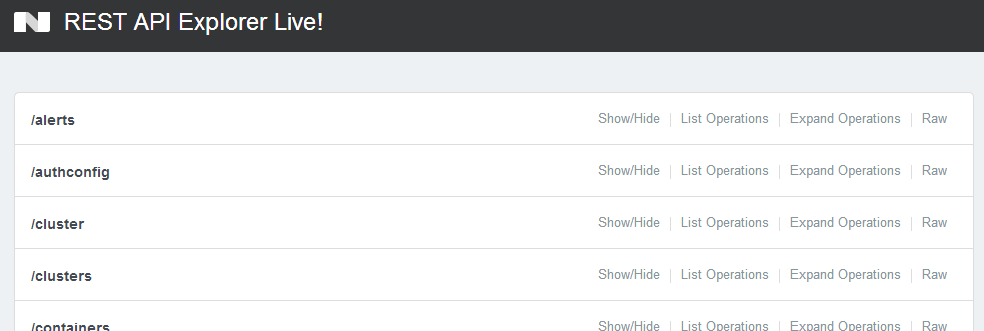

APIs 및 인터페이스

HTML5 UI는 프리즘의 핵심적인 부분으로 간단하고 사용하기 쉬운 관리 인터페이스를 제공한다. 또 다른 핵심 기능은 자동화에 사용할 수 있는 API이다. 프리즘 UI에 노출된 모든 기능은 뉴타닉스 플랫폼과 프로그래밍 방식으로 인터페이스 할 수 있도록 풀 세트의 REST API를 통해 제공된다. 이를 통해 고객과 파트너는 자동화 및 3rd 파티 툴의 사용이 가능하고 자체 UI를 만들 수 있다.

동적 또는 "소프트웨어-정의" 환경의 핵심인 뉴타닉스는 간단한 프로그래밍 및 인터페이스가 가능하도록 광범위한 인터페이스를 제공한다. 메인 인터페이스는 다음과 같다.

- REST API

- CLI - ACLI & NCLI

- 스크립트 인터페이스 (Scripting interfaces)

Note

Nutanix.dev - 뉴타닉스 개발자 포탈

사용 가능한 뉴타닉스 프리즘 및 제품 API에 대해 자세히 알아보려면 샘플 코드를 검토하고 자습형 실습을 살펴보고 다음을 확인한다: https://www.nutanix.dev!

이것의 핵심은 프리즘 UI의 모든 기능과 데이터 포인트를 노출하고 오케스트레이션 또는 자동화 도구가 뉴타닉스 작업을 쉽게 수행할 수 있도록 해주는 REST API이다. 이를 통해 Saltstack, Puppet, vRealize Operations, System Center Orchestrator, Ansible 등과 같은 툴을 사용하여 뉴타닉스를 위한 사용자 정의 워크플로우를 쉽게 만들 수 있다. 또한 이것은 3rd 파티 개발자가 자체 사용자 정의 UI를 만들고 REST를 통해 뉴타닉스 데이터를 가져올 수 있다는 것을 의미한다.

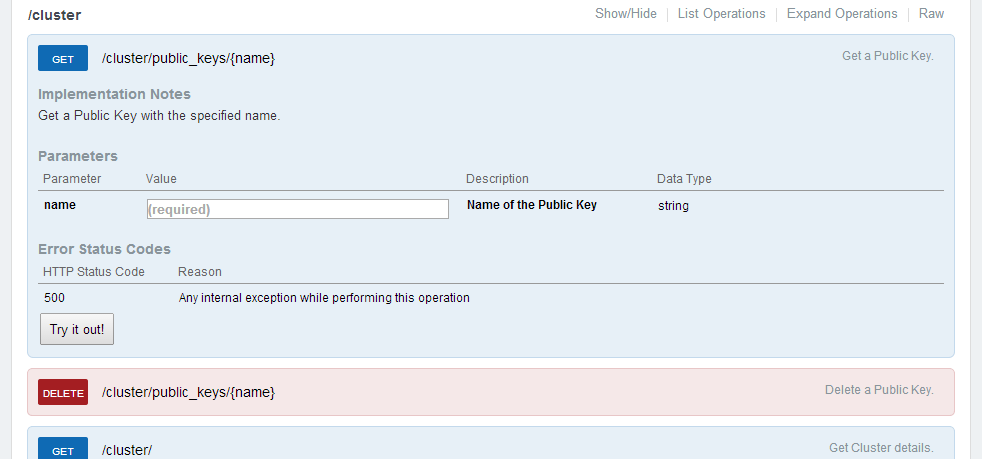

다음 그림은 개발자가 API와 상호 작용하고 예상되는 데이터 포맷을 볼 수 있는 뉴타닉스 REST API Explorer의 작은 스니펫을 보여준다.

프리즘 REST API 익스플로러 (Prism REST API Explorer)

프리즘 REST API 익스플로러 (Prism REST API Explorer)

오퍼레이션을 확장하여 REST 호출의 세부 정보 및 예제를 표시할 수 있다:

프리즘 REST API 호출 예제 (Prism REST API Sample Call)

프리즘 REST API 호출 예제 (Prism REST API Sample Call)

Note

API 인증 스킴 (API Authentication Scheme)

AOS 4.5 버전부터 HTTPS를 통한 기본 인증이 클라이언트 및 HTTP 호출 인증에 활용된다.

ACLI

AOS CLI(ACLI)는 뉴타닉스 제품의 AOS 부분을 관리하기 위한 CLI이다. 본 기능은 AOS 4.1.2 이상의 버전에서 지원된다.

NOTE: 이러한 모든 액션은 HTML5 GUI 및 REST API를 통해 수행할 수 있다. 아래 명령들은 태스크를 자동화하는 추가적인 방법이다.

ACLI 쉘 실행

설명: ACLI 쉘로 진입 (CVM에서 동작)

acli

또는

설명: Linux 쉘에서 ACLI 명령어 실행

ACLI Command

ACLI 결과 값을 JSON 포멧으로 출력

설명: ACLI 결과 값을 JSON 포맷으로 출력

acli –o json

호스트 목록 출력

설명: 클러스터에서 AOS 노드 목록 출력

host.list

네트워크 생성

설명: VLAN 기반 네트워크 생성

net.create TYPE.ID[.VSWITCH] ip_config=A.B.C.D/NN

Example: net.create vlan.133 ip_config=10.1.1.1/24

네트워크 목록 출력

설명: 네트워크 목록 출력

net.list

DHCP 범위 생성

설명: DHCP 범위 생성

net.add_dhcp_pool NET NAME start=START IP A.B.C.D end=END IP W.X.Y.Z

Note: 만약 AOS DHCP 서버의 주소가 네트워크 생성 중에 설정되지 않는 경우에 .254는 아크로폴리스 DHCP 서버에 의해 예약되어 사용된다.

Example: net.add_dhcp_pool vlan.100 start=10.1.1.100 end=10.1.1.200

기존 네트워크 상세 정보 가져오기

설명: VM 이름 / UUID, MAC 주소 및 IP를 포함한 네트워크의 VM 및 세부 정보 가져오기

net.list_vms NETNAME

Example: net.list_vms vlan.133

네트워크에 DHCP 및 DNS 서버 설정

설명: DHCP 및 DNS 설정

net.update_dhcp_dns NETNAME servers=COMMA SEPARATED DNS IPs domains=COMMA SEPARATED DOMAINS

Example: net.set_dhcp_dns vlan.100 servers=10.1.1.1,10.1.1.2 domains=splab.com

VM 생성

설명: VM 생성

vm.create COMMA SEPARATED VM NAMES memory=NUM MEM MB num_vcpus=NUM VCPU num_cores_per_vcpu=NUM CORES ha_priority=PRIORITY INT

Example: vm.create testVM memory=2G num_vcpus=2

대량의 VM 생성

설명: 대량의 VM 생성

vm.create CLONEPREFIX[STARTING INT..END INT] memory=NUM MEM MB num_vcpus=NUM VCPU num_cores_per_vcpu=NUM CORES ha_priority=PRIORITY INT

Example: vm.create testVM[000..999] memory=2G num_vcpus=2

기존 VM으로부터 VM 복제

설명: 기존 VM으로부터 VM 복제

vm.clone CLONE NAME(S) clone_from_vm=SOURCE VM NAME

Example: vm.clone testClone clone_from_vm=MYBASEVM

기존 VM으로부터 대량의 VM 복제

설명: 기존 VM으로부터 대량의 VM 복제

vm.clone CLONEPREFIX[STARTING INT..END INT] clone_from_vm=SOURCE VM NAME

Example: vm.clone testClone[001..999] clone_from_vm=MYBASEVM

디스크를 생성하고 VM에 추가

설명: OS를 위한 디스크 생성

vm.disk_create VM NAME create_size=Size and qualifier, e.g. 500G container=CONTAINER NAME

Example: vm.disk_create testVM create_size=500G container=default

VM에 NIC 추가

설명: NIC을 생성하고 추가

vm.nic_create VM NAME network=NETWORK NAME model=MODEL

Example: vm.nic_create testVM network=vlan.100

VM의 부트 디바이스를 디스크로 설정

설명: VM 부트 디바이스 설정

지정된 디스크 ID로 부트 디바이스 설정

vm.update_boot_device VM NAME disk_addr=DISK BUS

Example: vm.update_boot_device testVM disk_addr=scsi.0

VM의 부트 디바이스를 CD-DROM으로 설정

설명: VM 부트 디바이스를 CD-ROM으로 설정

vm.update_boot_device VM NAME disk_addr=CD-ROM BUS

Example: vm.update_boot_device testVM disk_addr=ide.0

ISO를 CD-ROM에 마운트

설명: ISO를 VM의 CD-ROM으로 마운트

단계:

- ISO 이미지를 컨테이너에 업로드

- 클라이언트 IP에 대한 화이트리스트 설정

- ISO를 공유에 업로드

ISO를 갖는 CD-ROM 생성

vm.disk_create VM NAME clone_nfs_file=PATH TO ISO CD-ROM=true

Example: vm.disk_create testVM clone_nfs_file=/default/ISOs/myfile.iso CD-ROM=true

만약 CD-ROM을 이미 생성하였다면 ISO만 마운트

vm.disk_update VM NAME CD-ROM BUS clone_nfs_file=PATH TO ISO

Example: vm.disk_update atestVM1 ide.0 clone_nfs_file=/default/ISOs/myfile.iso

ISO를 CD-ROM으로부터 분리

설명: ISO를 CD-ROM으로부터 제거

vm.disk_update VM NAME CD-ROM BUS empty=true

VM의 전원 켜기

설명: VM의 전원 켜기

vm.on VM NAME(S)

Example: vm.on testVM

모든 VM의 전원 켜기

Example: vm.on *

접두사와 매칭되는 모든 VM의 전원 켜기

Example: vm.on testVM*

특정 범위 내에 있는 VM의 전원 켜기

Example: vm.on testVM[0-9][0-9]

NCLI

NOTE: 이러한 모든 액션은 HTML5 GUI 및 REST API를 통해 수행할 수 있다. 아래 명령들은 태스크를 자동화하는 추가적인 방법이다.

NFS 화이트리스트에 서브넷 추가

설명: NFS 화이트리스트에 특정 서브넷을 추가

ncli cluster add-to-nfs-whitelist ip-subnet-masks=10.2.0.0/255.255.0.0

뉴타닉스 버전 출력

설명: 뉴타닉스 소프트웨어의 현재 버전 출력

ncli cluster version

숨겨진 NCLI 옵션 출력

설명: 숨겨진 NCLI 명령어 또는 옵션 출력

ncli helpsys listall hidden=true [detailed=false|true]

스토리지 풀 목록 출력

설명: 스토리지 풀 목록 출력

ncli sp ls

컨테이너 목록 출력

설명: 컨테이너 목록 출력

ncli ctr ls

컨테이너 생성

설명: 새로운 컨테이너 생성

ncli ctr create name=NAME sp-name=SP NAME

VM 목록 출력

설명: VM 목록 출력

ncli vm ls

퍼블릭 키 목록 출력

설명: 기존에 등록되어 있는 퍼블릭 키 목록 출력

ncli cluster list-public-keys

퍼블릭 키 추가

설명: 클라이언트 액세스를 위한 퍼블릭 키 추가

퍼블릭 키를 CVM으로 복사

퍼블릭 키를 클러스터에 추가

ncli cluster add-public-key name=myPK file-path=~/mykey.pub

퍼블릭 키 제거

설명: 클라이언트 액세스를 위한 퍼블릭 키 제거

ncli cluster remove-public-keys name=myPK

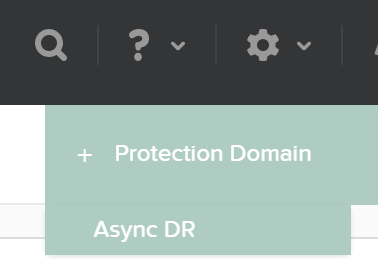

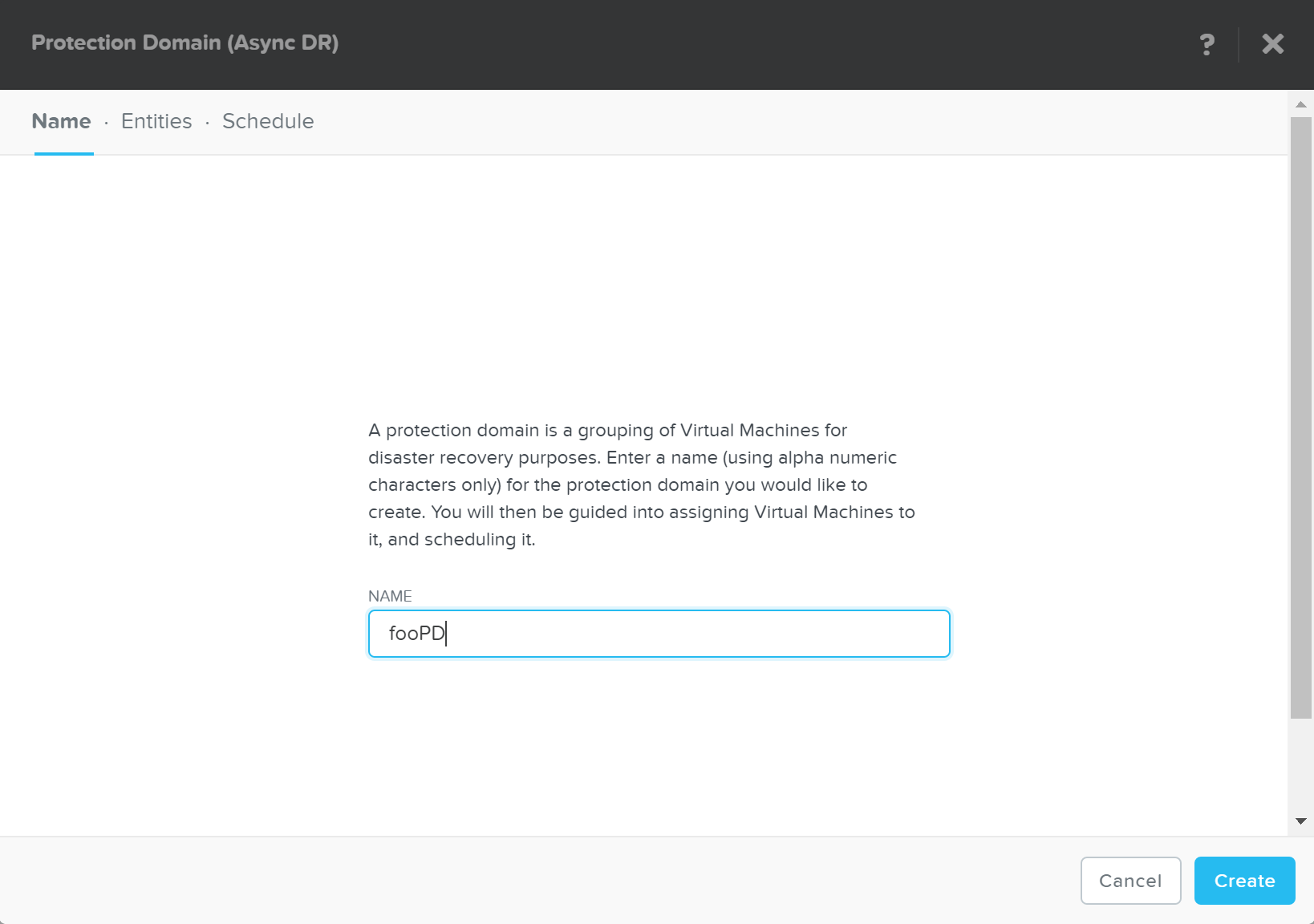

보호 도메인 생성

설명: PD(Protection Domain) 생성

ncli pd create name=NAME

원격 사이트 생성

설명: 복제를 위한 원격 사이트 생성

ncli remote-site create name=NAME address-list=Remote Cluster IP

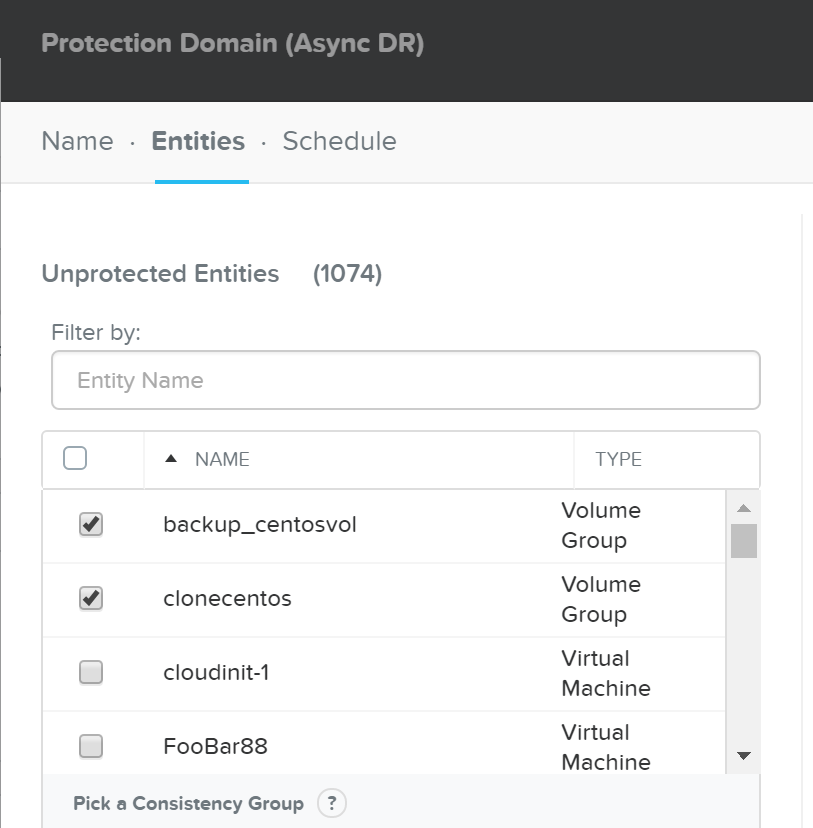

컨테이너의 모든 VM을 위한 PD 생성

설명: 컨테이너에 존재하는 모든 VM을 보호

ncli pd protect name=PD NAME ctr-id=Container ID cg-name=NAME

지정된 VM을 갖는 PD 생성

설명: 지정된 VM 보호

ncli pd protect name=PD NAME vm-names=VM Name(s) cg-name=NAME

DSF 파일(vDisk로 알려진)를 위한 PD 생성

설명: 지정된 DSF 파일 보호

ncli pd protect name=PD NAME files=File Name(s) cg-name=NAME

PD 스냅샷 생성

설명: PD의 One-Time 스냅샷 생성

ncli pd add-one-time-snapshot name=PD NAME retention-time=seconds

원격 사이트로 스냅샷 및 복제 스케줄 생성

설명: 스냅샷을 생성하고, n개의 원격 사이트로의 복제 스케줄 생성

ncli pd set-schedule name=PD NAME interval=seconds retention-policy=POLICY remote-sites=REMOTE SITE NAME

복제 상태 출력

설명: 복제 상태 모니터링

ncli pd list-replication-status

PD를 원격 사이트로 마이그레이션

설명: PD를 원격 사이트로 페일오버

ncli pd migrate name=PD NAME remote-site=REMOTE SITE NAME

PD 활성화

설명: 원격 사이트에서 PD 활성화

ncli pd activate name=PD NAME

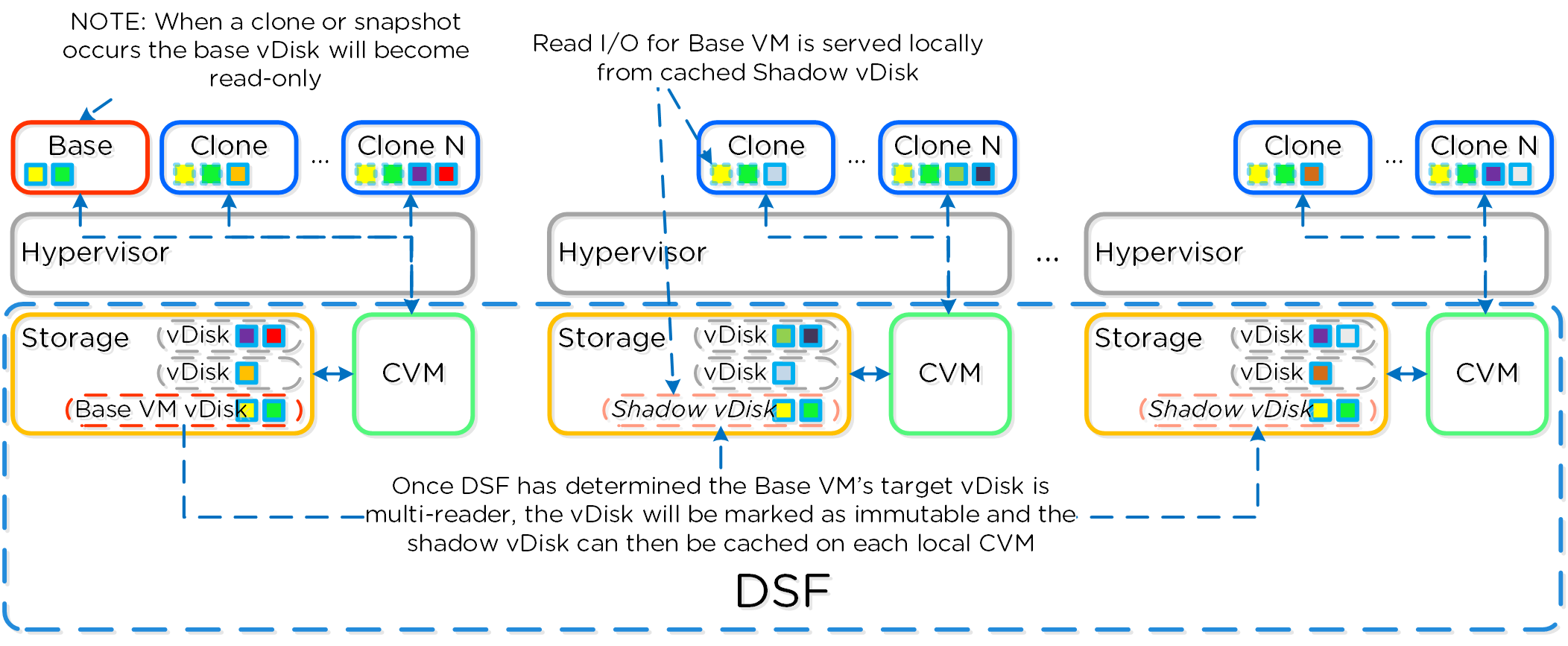

DSF 쉐도우 클론 활성화

설명: DSF 쉐도우 클론 기능 활성화

ncli cluster edit-params enable-shadow-clones=true

vDisk의 데이터 중복제거 활성화

설명: 데이터 중복제거 활성화 및 특정 vDisk에 대한 On-Disk 데이터 중복제거 활성화k

ncli vdisk edit name=VDISK NAME fingerprint-on-write=true/false on-disk-dedup=true/false

클러스터 리질리언시 상태 체크

# 노드 상태 (Node status) ncli cluster get-domain-fault-tolerance-status type=node

# 블록 상태 (Block status) ncli cluster get-domain-fault-tolerance-status type=rackable_unit

PowerShell CMDlets

아래에서 뉴타닉스 PowerShell CMDlets, 사용 방법 및 Windows PowerShell의 몇 가지 일반적인 배경에 대해 다룬다.

기본 설명

윈도우즈 PowerShell은 .NET 프레임워크 기반의 강력한 쉘 및 스크립트 언어이다. 언어를 사용하기가 매우 간단하며 직관적인 인터액티브 방식으로 제작되었다. PowerShell에는 몇 가지 주요 컨스트럭트/아이템이 있다.

CMDlets

CMDlets은 특정 오퍼레이션을 수행하는 명령 또는 .NET 클래스이다. 이들은 대개 Getter/Setter 방법론을 따르며 일반적으로 <Verb>-<Noun> 기반 구조를 사용한다. 예를 들어 Get-Process, Set-Partition 등과 같다.

파이핑 또는 파이프라이닝 (Piping or Pipelining)

파이핑(Piping)은 PowerShell에서 매우 중요한 컨스트럭트로(Linux에서 사용하는 것과 유사) 정확하게 사용하면 작업을 크게 단순화할 수 있다. 파이핑을 사용하면 기본적으로 파이프라인의 한 섹션의 결과를 파이프라인의 다음 섹션의 입력으로 사용할 수 있다. 파이프라인은 필요한 만큼 길어질 수 있다 (파이프의 다음 섹션으로 공급되는 출력이 남아 있다고 가정). 아주 간단한 예제는 현재 프로세스를 가져와서 특정 특성이나 필터와 일치하는 프로세스를 찾아서 정렬하는 것이다.

Get-Service | where {$_.Status -eq "Running"} | Sort-Object Name

for-each 대신에 파이핑을 사용할 수 있다. 예를 들면 다음과 같다.

# For each item in my array

$myArray | %{

# Do something

}

주요 오브젝트 유형 (Key Object Types)

다음은 PowerShell의 주요 오브젝트 유형의 일부이다. getType() 메소드를 사용하여 오브젝트 유형을 쉽게 얻을 수 있다. 예를 들어 $someVariable.getType()은 오브젝트 유형을 반환한다.

변수 (Variable)

$myVariable = "foo"

Note: 변수를 일련의 명령 또는 명령 파이프라인의 출력으로 설정할 수 있다:

$myVar2 = (Get-Process | where {$_.Status -eq "Running})

이 예제에서 괄호 안의 명령이 먼저 수행되고 그 결과가 변수에 저장된다.

배열 (Array)

$myArray = @("Value","Value")

Note: 배열, 해시 테이블 또는 사용자 정의 오브젝트의 배열을 가질 수 있다.

해시 테이블 (Hash Table)

$myHash = @{"Key" = "Value";"Key" = "Value"}

유용한 명령

특정 CMDlet에 대한 도움말 내용 가져오기 (Linux에서 man 페이지와 유사).

Get-Help CMDlet Name

Example: Get-Help Get-Process

명령 또는 오브젝트의 속성 및 메소드를 나열한다.

Some expression or object | Get-Member

Example: $someObject | Get-Member

핵심 뉴타닉스 CMDlets 및 사용법

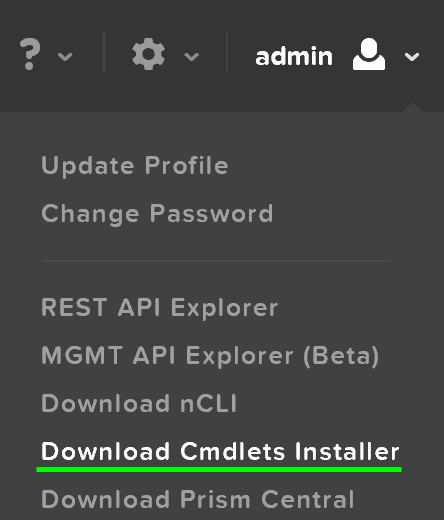

뉴타닉스 CMDlets은 프리즘 UI(AOS 4.0.1 이상의 버전)에서 직접 다운로드할 수 있으며 오른쪽 상단의 드롭-다운 메뉴에서 찾을 수 있다.

프리즘 CMDlets 인스톨러 링크 (Prism CMDlets Installer Link)

프리즘 CMDlets 인스톨러 링크 (Prism CMDlets Installer Link)

뉴타닉스 Snappin 로드

Snappin이 로드되어 있는지 확인하고 그렇지 않으면 로드한다.

if ( (Get-PSSnapin -Name NutanixCmdletsPSSnapin -ErrorAction SilentlyContinue) -eq $null )

{

Add-PsSnapin NutanixCmdletsPSSnapin

}

뉴타닉스 CMDlets 목록 출력

Get-Command | Where-Object{$_.PSSnapin.Name -eq "NutanixCmdletsPSSnapin"}

뉴타닉스 클러스터에 연결

Connect-NutanixCluster -Server $server -UserName "myuser" -Password (Read-Host "Password: " -AsSecureString) -AcceptInvalidSSLCerts

특정 검색 문자열과 일치하는 뉴타닉스 VM 가져오기

Set to variable

$searchString = "myVM"

$vms = Get-NTNXVM | where {$_.vmName -match $searchString}

Interactive

Get-NTNXVM | where {$_.vmName -match "myString"}

Interactive and formatted

Get-NTNXVM | where {$_.vmName -match "myString"} | ft

뉴타닉스 vDisk 가져오기

Set to variable

$vdisks = Get-NTNXVDisk

Interactive

Get-NTNXVDisk

Interactive and formatted

Get-NTNXVDisk | ft

뉴타닉스 컨테이너 가져오기

Set to variable

$containers = Get-NTNXContainer

Interactive

Get-NTNXContainer

Interactive and formatted

Get-NTNXContainer | ft

뉴타닉스 PD 가져오기

Set to variable

$pds = Get-NTNXProtectionDomain

Interactive

Get-NTNXProtectionDomain

Interactive and formatted

Get-NTNXProtectionDomain | ft

뉴타닉스 컨시스턴시 그룹 가져오기

Set to variable

$cgs = Get-NTNXProtectionDomainConsistencyGroup

Interactive

Get-NTNXProtectionDomainConsistencyGroup

Interactive and formatted

Get-NTNXProtectionDomainConsistencyGroup | ft

리소스 및 스크립트:

- Nutanix Github - https://github.com/nutanix

- NutanixDev Github - https://github.com/nutanixdev

- NutanixDev Code Samples - https://github.com/nutanixdev/code-samples

- nutanix.dev blog - https://www.nutanix.dev/blog/

Disclaimer: All code samples are © Nutanix, Inc., and are provided as-is under the MIT license (https://opensource.org/licenses/MIT).

Book of AOS

a·crop·o·lis - /ɘ ‘ kräpɘlis/ - noun - data plane

스토리지, 컴퓨트 및 가상화 플랫폼.

AOS(Acropolis Operating System)는 하이퍼바이저(온-프레미스 또는 클라우드에서 실행)와 실행 중인 워크로드 간의 추상화 계층을 제공하는 핵심 소프트웨어 스택이다. 스토리지 서비스, 보안, 백업 및 재해 복구 등과 같은 기능을 제공한다. 본 BOOK에서는 AOS의 아키텍처 및 기능을 설명한다.

AOS 아키텍처

AOS(Acropolis Operating System)는 플랫폼에서 실행되는 워크로드 및 서비스가 활용하는 핵심 기능을 제공한다. 여기에는 스토리지 서비스, 업그레이드 등과 같은 것들이 포함되지만 이에 국한되지는 않는다.

이 그림은 다양한 레이어에서 AOS의 개념적 특성을 보여주는 이미지를 강조 표시한다.

하이-레벨 AOS 아키텍처 (High-level AOS Architecture)

하이-레벨 AOS 아키텍처 (High-level AOS Architecture)

뉴타닉스의 모든 분산 특성을 기반으로 이를 가상화 및 리소스 관리 공간으로 확장하고 있다. AOS는 워크로드 및 리소스 관리, 프로비저닝 및 운영을 지원하는 백엔드 서비스이다. AOS의 목표는 실행 중인 워크로드에서 촉진 리소스(e.g. 하이퍼 바이저, 온-프레미스, 클라우드 등)를 추상화하고 운영을 위해 단일 "플랫폼"을 제공하는 것이다.

이를 통해 워크로드를 하이퍼바이저, 클라우드 공급자 및 플랫폼 간에 원활하게 이동할 수 있다.

Note

VM 관리를 위해 지원하는 하이퍼바이저

AOS 4.7 현재 AHV와 ESXi가 VM 관리를 지원하는 하이퍼바이저이지만 향후 확대될 수 있다. 볼륨 API 및 읽기 전용 오퍼레이션은 여전히 모두에서 지원된다.

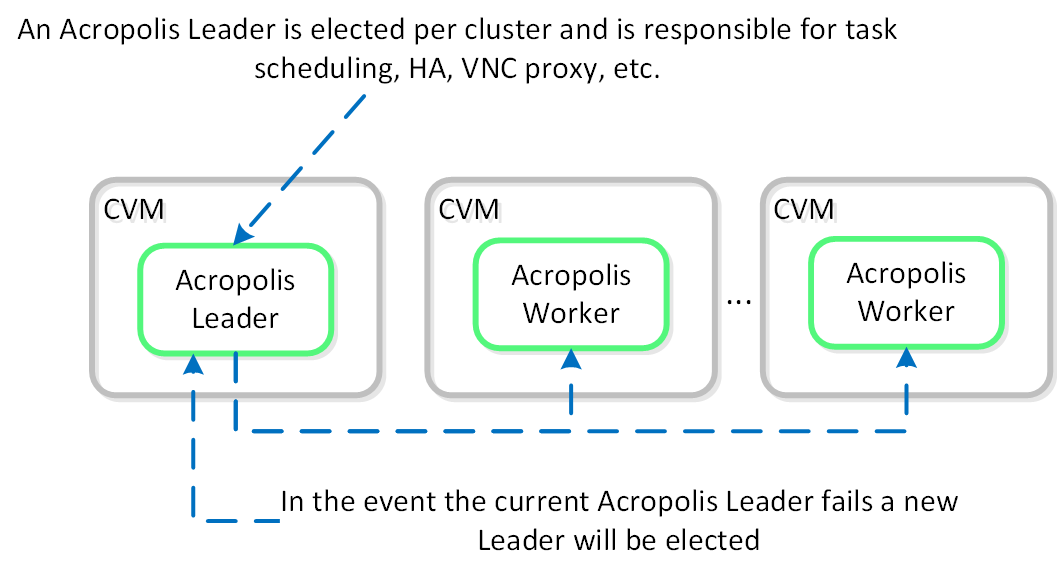

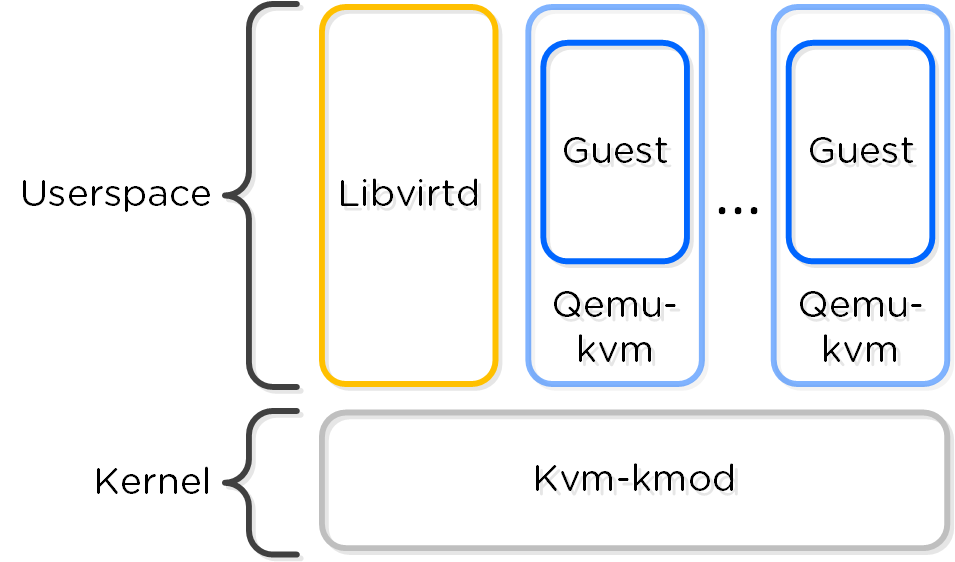

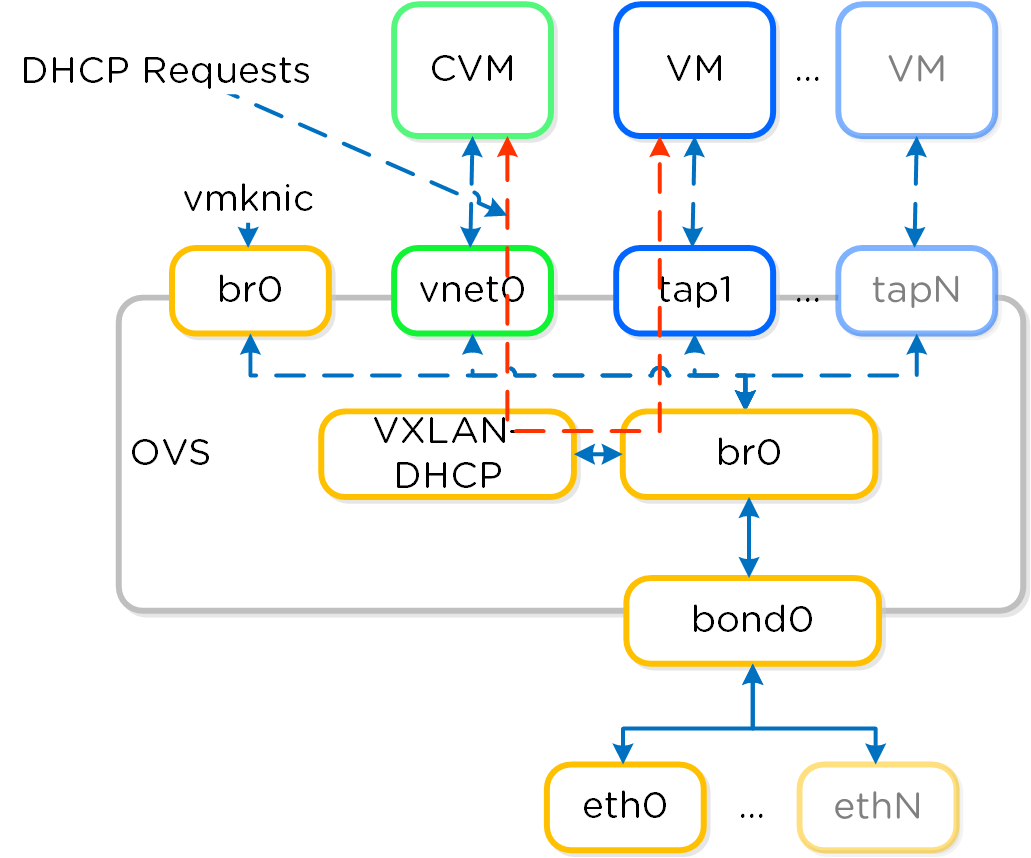

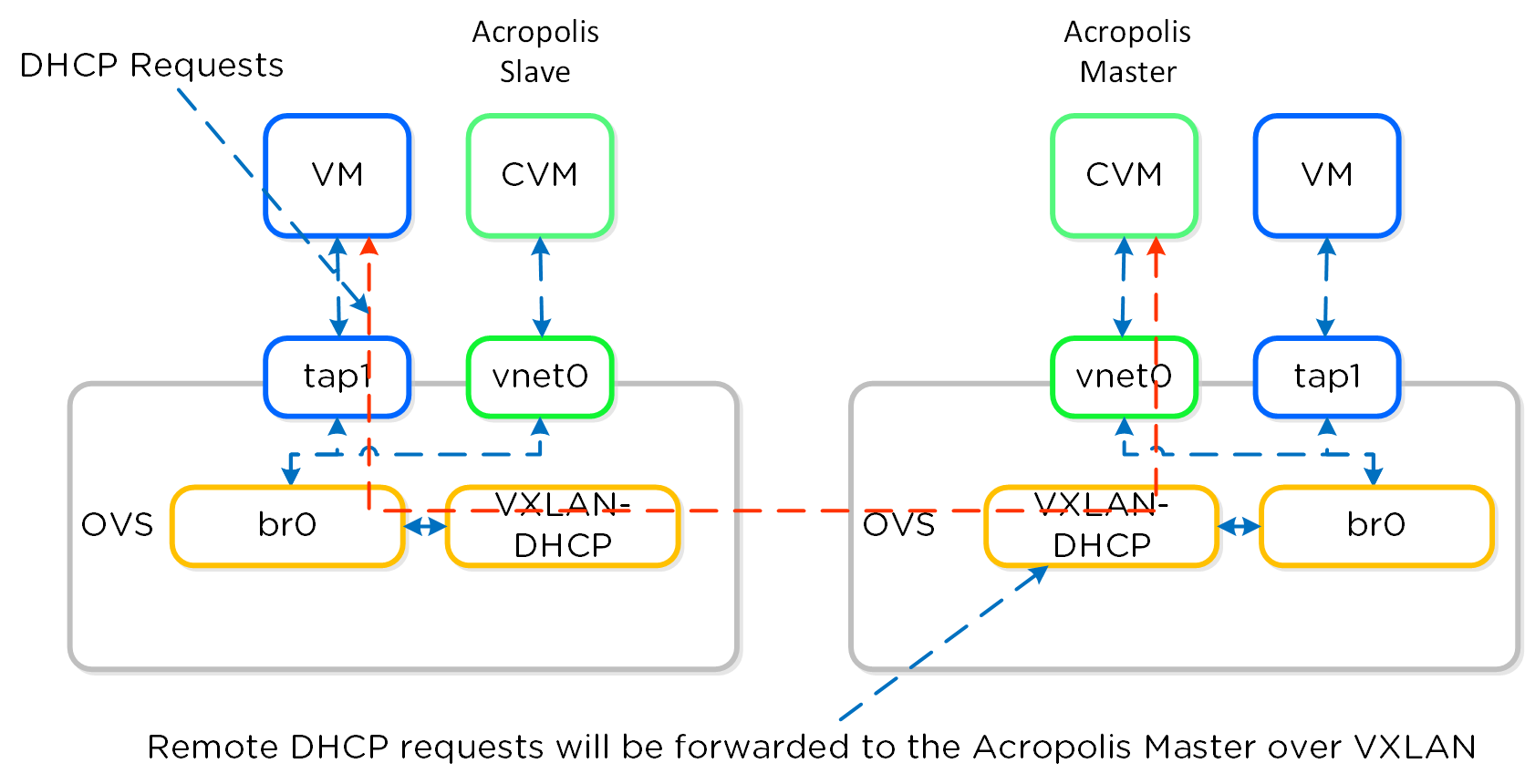

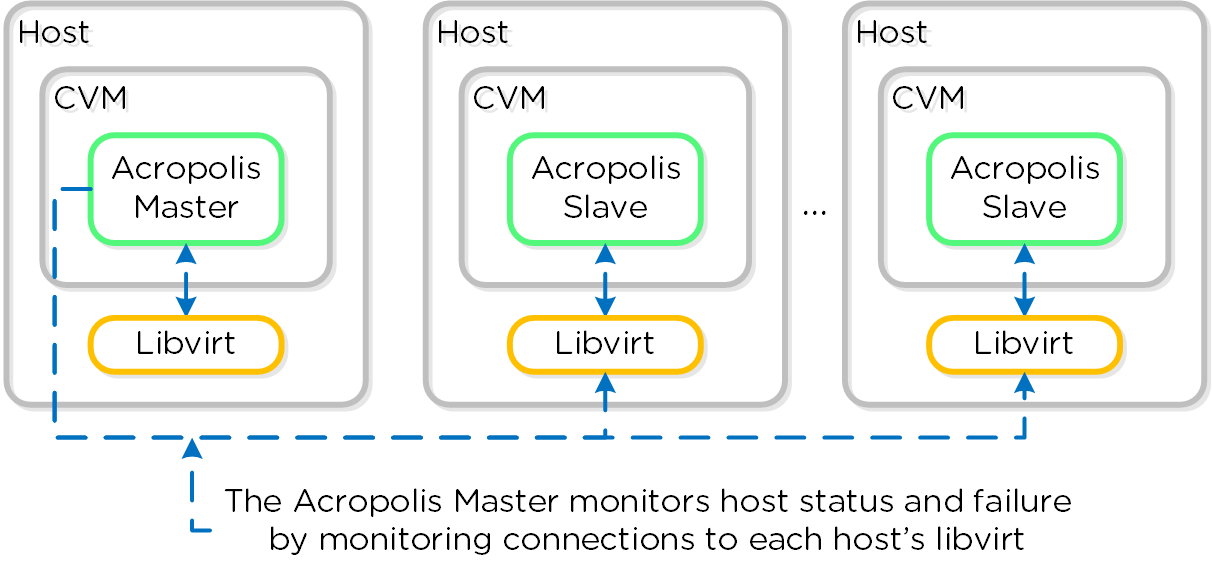

아크로폴리스 서비스

아크로폴리스 워커(Acropolis Worker)는 태스크 스케줄링, 실행, IPAM 등을 담당하는 선출된 아크로폴리스 리더와 함께 모든 CVM에서 실행된다. 리더가 있는 다른 컴포넌트와 마찬가지로 아크로폴리스 리더가 실패하면 새로운 리더가 선출된다.

각각의 역할 구분은 다음과 같다.

- 아크로폴리스 리더 (Acropolis Leader)

- 태스크 스케줄링 및 실행

- 통계 정보 수집 및 퍼블리싱

- 네트워크 컨트롤러 (하이퍼바이저 용)

- VNC 프록시 (하이퍼바이저 용)

- HA (하이퍼바이저 용)

- 아크로폴리스 워커 (Acropolis Worker)

- 통계 정보 수집 및 퍼블리싱

- VNC 프록시 (하이퍼바이저 용)

다음은 아크로폴리스 리더/워커 관계의 개념적 뷰를 보여준다.

아크로폴리스 서비스 (Acropolis Services)

아크로폴리스 서비스 (Acropolis Services)

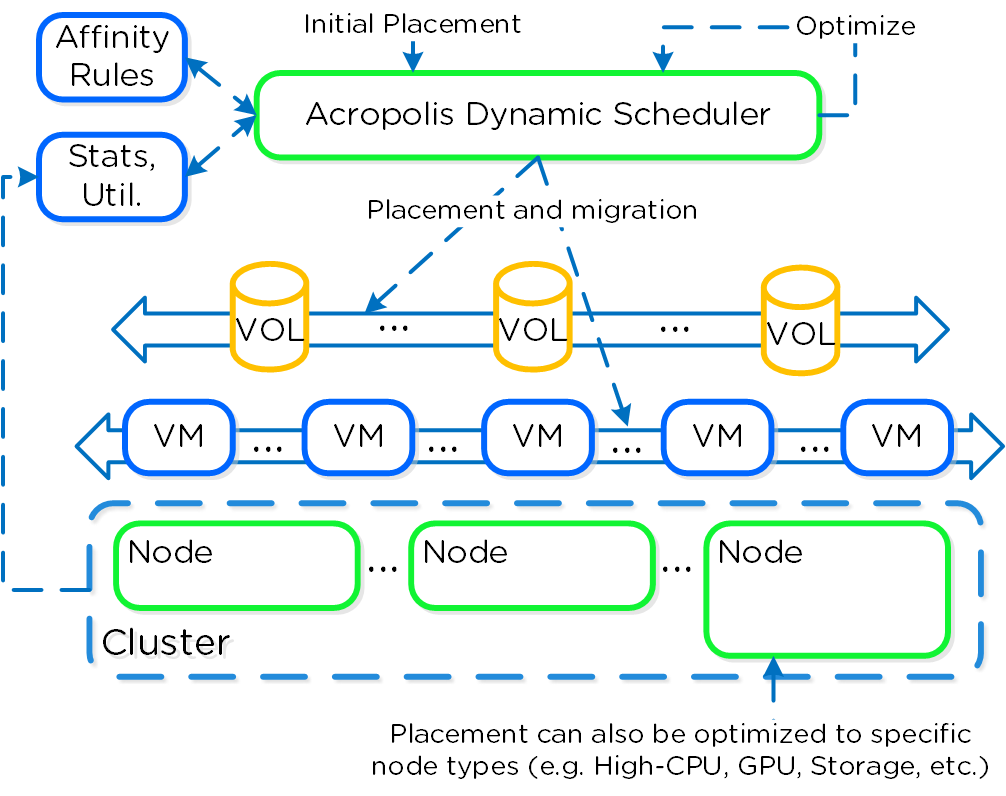

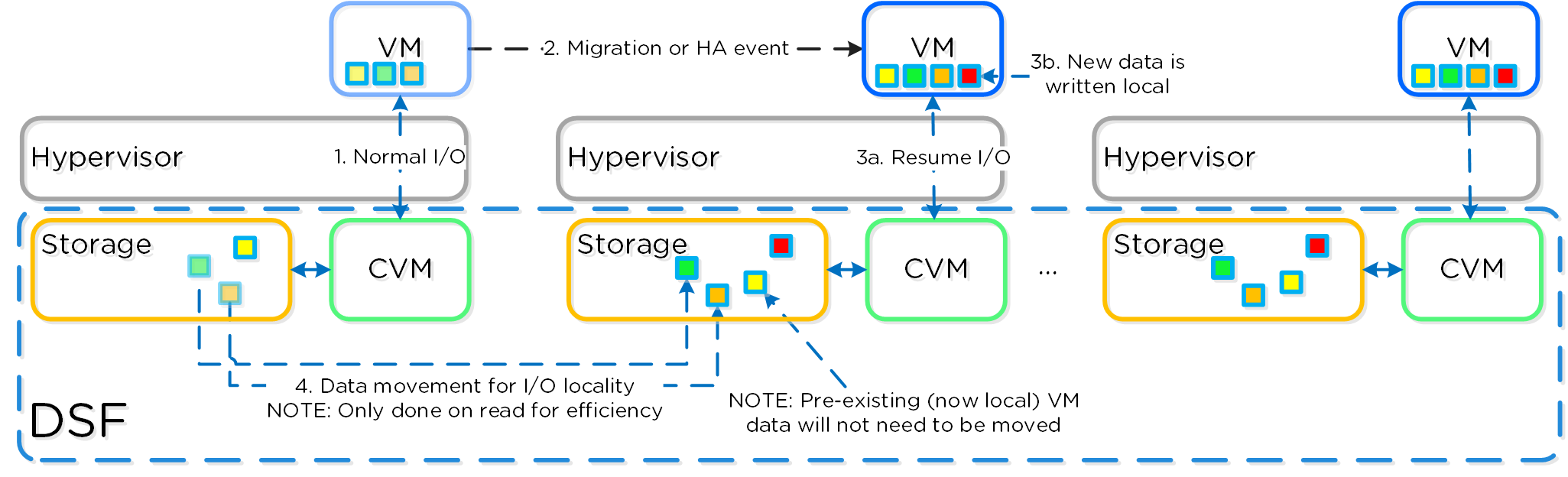

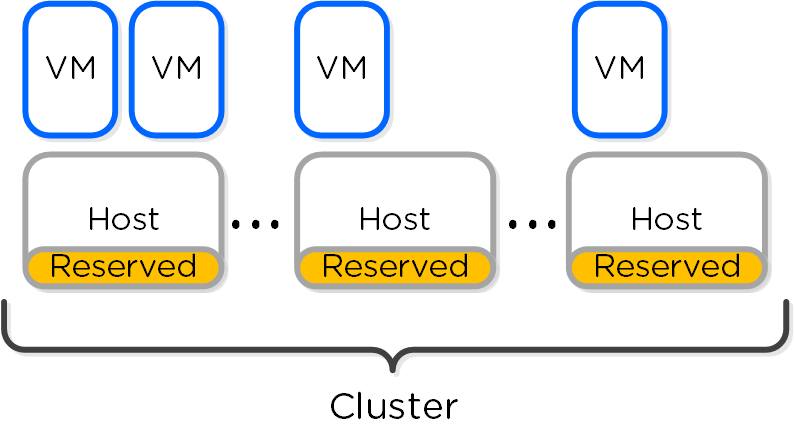

동적 스케줄러

자원을 효과적으로 소비하기 위해서는 효율적인 자원 스케줄링이 필수적이다. AOS 동적 스케줄러(AOS Dynamic Scheduler)는 배치 결정을 위해 컴퓨팅 활용률(CPU/MEM)에 의존하는 전통적인 스케줄링 방법을 확장한다. VM 및 볼륨(ABS) 배치 결정을 위해 컴퓨팅뿐만 아니라 스토리지와 다른 요소를 활용한다. 이를 통해 자원이 효과적으로 소비되고 최종 사용자 성능이 최적화된다.

자원 스케줄링은 두 가지 핵심 영역으로 나눌 수 있다.

- 초기 배치 (Initial Placement)

- 전원을 켤 때 항목이 스케줄링되는 위치

- 런타임 최적화 (Runtime Optimization)

- 런타임 메트릭스 기반으로 워크로드 이동

오리지널 AOS 스케줄러는 출시 이후 초기 배치 결정을 담당했었다. AOS 5.0에서 출시된 AOS 동적 스케줄러는 이를 바탕으로 런타임 자원 최적화를 제공한다.

그림은 스케줄러 아키텍처의 하이-레벨 뷰를 보여준다.

AOS 동적 스케줄러 (AOS Dynamic Scheduler)

AOS 동적 스케줄러 (AOS Dynamic Scheduler)

| 동적 스케줄러는 배치 최적화를 위해 하루 종일 지속적으로 실행된다 (현재 매 15분 마다). | Gflag: lazan_anomaly_detection_period_secs. 예상 수요는 과거 활용률 값을 사용하여 계산되고 스무딩 알고리즘에 제공된다. 이 예상 수요는 이동을 결정하기 위해 사용되며 갑작스러운 스파이크가 결정을 왜곡하지 않도록 한다. |

Note

자원 최적화에 대한 다른 접근 방식 (A different approach towards resource optimization)

기존 스케줄링/최적화 플랫폼(VMware DRS, Microsoft PRO)을 살펴보면 클러스터 자원 전체에서 워크로드/VM의 균형을 균일하게 맞추는데 중점을 둔다. NOTE: 왜곡을 제거하기 위해 얼마나 적극적으로 시도하는가는 밸런싱 설정에 따라 결정된다 (e.g. manual -> none, conservative -> some, aggressive -> more).

예를 들어 클러스터에 3개의 호스트가 있으며 각 호스트의 사용률이 50%, 5%, 5%이다. 일반적인 솔루션은 각 호스트 활용률이 ~20%가 되도록 워크로드를 재조정하려고 한다. 그런데 왜?

우리가 실제로 하려고 하는 것은 왜곡을 제거하는 것이 아니라 자원에 대한 경합을 제거/무효화하는 것이다. 자원에 대한 경합이 없으면 워크로드 밸런싱으로 얻을 수 있는 이득은 없다. 사실 불필요한 이동을 강요함으로써 우리는 자원을 소비하는 필수적인 추가 작업(e.g. 메모리 전송, 캐시 리로컬라이제이션 등)을 유발한다.

AOS 동적 스케줄러는 왜곡 때문이 아니라 자원에 대한 예상 경합이 있는 경우에만 워크로드 이동을 호출한다. NOTE: 아크로폴리스 DSF는 다른 방식으로 동작하고 클러스터 전체에서 데이터의 균일한 분산을 보장하여 핫스팟을 제거하고 재구축 속도를 높인다. DSF에 대한 자세한 내용은 “디스크 밸런싱” 섹션을 참조한다.

전원을 켤 때 ADS는 클러스터 전체에서 VM 초기 배치의 균형을 맞춘다.

배치 결정

배치 결정은 다음 항목을 기반으로 한다:

- 컴퓨트 사용률 (Compute Utilization)

-

각 개별 노드의 컴퓨트 활용도를 모니터링한다. 노드의 예상 CPU 할당이 임계값을 초과하는 경우 (현재 호스트 CPU의 85%) Gflag: lazan_host_cpu_usage_threshold_fraction. 워크로드의 균형을 재조정하기 위해 해당 호스트에서 VM을 마이그레이션한다. 여기서 언급해야 할 핵심 사항은 경합이 있을 때만 마이그레이션이 수행된다는 것이다. 노드 간 사용률에 차이가 있는 경우(예: 3개 노드는 10%, 1개 노드는 50%), 자원에 대한 경합이 없을 때 마이그레이션을 수행하면 아무런 이점이 없으므로 마이그레이션을 수행하지 않는다.

-

- 스토리지 성능 (Storage Performance)

-

하이퍼컨버지드 플랫폼이기 때문에 컴퓨트 및 스토리지 자원을 모두 관리한다. 스케줄러는 각 노드의 스타게이트 프로세스 사용률을 모니터링한다. 특정 스타게이트가 할당 임계값 (현재 스타게이트에 할당된 CPU의 85%)을 초과하는 경우 Gflag: lazan_stargate_cpu_usage_threshold_pct. 핫스팟을 제거하기 위해 호스트 간에 자원을 마이그레이션한다. VM과 ABS 볼륨을 모두 마이그레이션하여 핫 스타게이트를 제거할 수 있다.

-

- [Anti-]Affinity rules

- 선호도(Affinity) 또는 반선호도(Anti-Affinity) 제약조건은 환경의 다른 자원에 기반하여 특정 자원이 스케줄링되는 위치를 결정한다. 라이선스 상의 이유로 VM이 동일한 노드에서 실행되기를 원하는 경우가 있다. 이러한 경우에 VM들은 동일 호스트에 배치된다. 다른 경우에는 가용성을 위해 VM들이 서로 다른 노드에서 실행되도록 할 수 있다. 이러한 경우에 VM들은 서로 다른 호스트에 배치된다.

스케줄러는 이전 항목을 토대로 워크로드 배치의 최적화를 위해 최선을 다할 것이다. 시스템은 너무 많은 마이그레이션이 발생하지 않도록 하기 위해 자원의 이동에 대한 패널티를 부과한다. 이것은 이동이 워크로드에 부정적인 영향을 미치지 않도록 하기 위한 핵심 항목이다.

마이그레이션 후 시스템은 "효과성"을 판단하고 실제 이득이 무엇인지 확인한다. 이 학습 모델은 마이그레이션 결정에 유효한 근거가 있는지 확인하기 위해 자체 최적화할 수 있다.

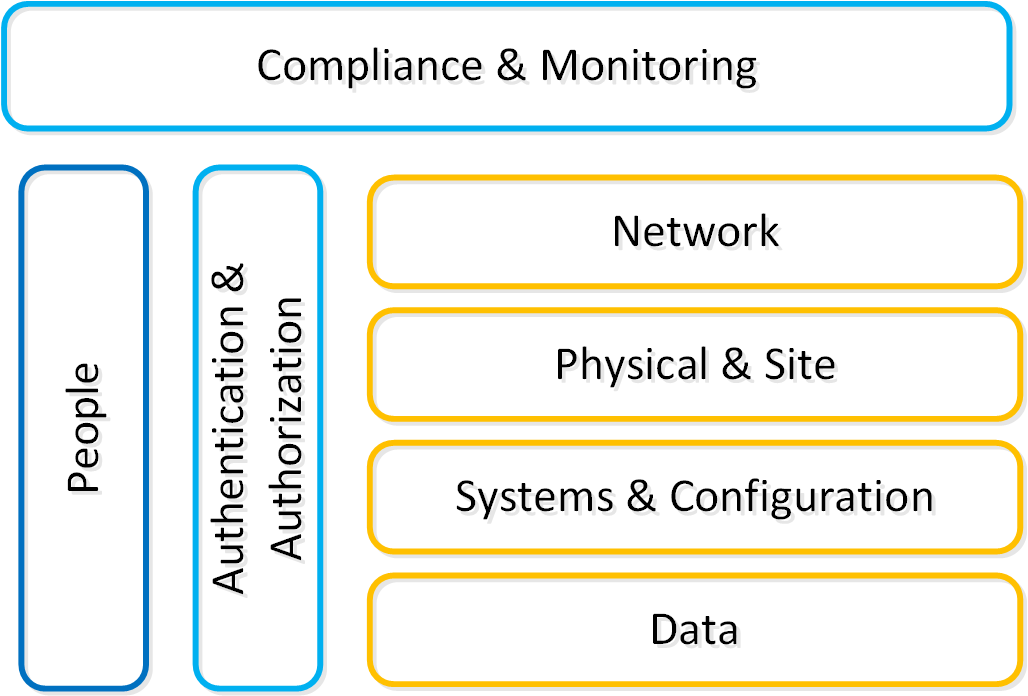

보안

보안은 뉴타닉스 플랫폼의 핵심 부분으로 개발 초기 단계에서부터 적용되었다. 뉴타닉스 SecDL(Security Development Lifecycle)은 개발 프로세스의 모든 단계에 보안을 통합한다. 이 시스템은 최종 사용자가 사후에 플랫폼의 보안을 "강화(Harden)"하도록 요구하는 것이 아닌 공장에서 안전하게 배송된다.

보안에 대해 생각할 때, 뉴타닉스는 실제로 3가지 핵심 목표(CIA 트라이어드라고도 함)를 달성하려고 한다.

- 기밀성 (Confidentially)

- 무단 액세스를 방지하여 데이터 보호 및 보안

- 무결성 (Integrity)

- 무단 변경을 방지하여 데이터의 일관성 및 정확성 보장

- 가용성 (Availability)

- 인증된 사용자가 탄력성과 중복성을 통해 데이터에 액세스할 수 있도록 보장

이것은 간단한 진술로 단순화될 수 있다: 사용자가 나쁜 사람들을 멀리하면서 업무를 수행할 수 있다. 보안을 설계할 때는 다음 다이어그램에서 강조할 몇 가지 핵심 영역을 살펴보아야 한다.

보안 계층 (Security Layers)

보안 계층 (Security Layers)

상기 그림의 각 주제에 대해 다음 섹션에서 자세히 기술한다.

시스템 및 설정 (System & Configuration)

Note

요약:

- 알려진 취약성 패치 및 제거

- 강력한 암호를 적용하고 기본 계정 제거

- 퍼미션 및 사용자 권한 설정

- 사용하지 않는 포트/프로토콜 닫기

- 자동화를 사용하여 기준선(Baseline) 보장

일반적으로 사람들은 "강화(Hardening)"라는 방법을 사용하여 시스템(OS + 앱) 보안을 말한다. 이것은 기준선이라고 하는 특정 표준으로 구성하여 시스템을 보호하는 프로세스이다.

DoD의 IT 조직 (DISA)에는 STIG라고 하는 샘플 강화 안내서가 있다 (자세한 내용은 SCMA 섹션 참조). 여기에는 디렉토리 권한, 사용자 계정 관리, 비밀번호 복잡성, 방화벽 및 기타 여러 구성 설정이 포함된다.

시스템이 해당 표준으로 구성되면 "보안"으로 간주되지만 이것은 프로세스의 시작일뿐이다. 시스템 보안은 수명 기간 동안 유지되어야 하는 것이다. 예를 들어, 표준 강화 기준을 충족하려면 구성 자동화 도구를 사용해야 한다. 이를 통해 시스템은 항상 기준선 "원하는 상태"를 충족하게 된다.

뉴타닉스는 이 섹션의 뒷부분에서 다루는 SCMA라는 툴을 사용하여 CVM 및 AHV 하이퍼바이저에서 이를 보장한다.

데이터 (Data)

Note

요약:

- 데이터에 대한 안전한 액세스 제어

- 항상 백업을 수행

- 데이터 암호화 및 키 보안

데이터는 모든 비즈니스의 핵심이며 회사의 가장 소중한 자산이다. 보안을 고려할 때 데이터 접근성, 품질 및 도난 방지를 보장하는 데 중점을 두어야 한다.

접근성의 개념에서 의사 결정을 내리려면 시스템과 데이터에 지속적으로 액세스해야 한다. 랜섬웨어(Ransomware)라고 하는 최근의 공격 방법 중 하나는 데이터를 암호화한 다음 사용자가 랜섬을 통해 다시 액세스할 수 있도록 하여 데이터에 액세스하는 기능을 위협한다. 이것은 다양한 방법으로 피할 수 있지만 백업의 중요성을 강조한다.

많은 의사 결정 또는 액션이 데이터에 의존하기 때문에 데이터 품질도 중요한 항목이다. 예를 들어 공격자는 시스템에 액세스하여 악의적인 주문을 하거나 상품을 자신의 위치로 우회하는 배송 주소를 업데이트할 수 있다. 데이터를 깨끗하게 유지하려면 로깅 및 체크섬이 매우 중요하다.

마지막으로 데이터를 보호하거나 강화하는 방법은 무엇입니까? 일반적으로 암호화를 사용하여 데이터를 해독할 키가 없는 데이터를 쓸모없게 만든다. 이 경우 누군가 암호화된 파일이나 디스크 디바이스를 훔치면 기본 데이터에 액세스할 수 없게 된다.

네트워크 (Network)

Note

요약:

- 신뢰할 수 있는 네트워크와 신뢰할 수 없는 네트워크 분리

- 경계 및 세그먼트 간의 방화벽 설정

- IDPS를 활용하여 이상 징후 탐지

네트워크는 일반적으로 공격자가 시스템에 액세스하기 위해 사용하는 통신 벡터이다. 여기에는 경계 보안(e.g. 외부 방화벽) 및 내부 침입 방지/검출이 포함된다.

좋은 디자인과 마찬가지로 항상 보안 계층이 있어야 한다: 네트워크에서도 마찬가지다. 높은 보안 네트워크를 신뢰할 수 있는 네트워크에서 분리하고 신뢰할 수 없는 네트워크(e.g. 비즈니스/WiFi 네트워크)에서 네트워크를 보호해야 한다. 사무실의 로컬 네트워크가 안전하다고 가정해도 안전하지 않다.

네트워크의 여러 계층을 가짐으로써 우리는 가장 신뢰할 수 없는 네트워크에 액세스하는 사람이 보안 네트워크를 향해 일하는 것이 더 어려워질 수 있다. 이 과정에서 우수한 IDPS 시스템은 액세스 이상 징후 또는 nmap과 같은 검색 도구를 감지할 수 있다.

인증 및 권한 (Authentication and Authorization)

Note

요약:

- 가능한 경우 MFA/2FA를 사용

- 세분화된 권한 사용

인증은 Active Directory 또는 다른 IDP(Identity provider)와 같은 신뢰할 수 있는 정보로 사용자 ID를 인증하는 것이다. MFA(Multi-Factor Authentication) 또는 2FA와 같은 도구는 2단계 또는 여러 단계를 통해 사용자 인증을 진행한다.

신원이 확인되면 다음은 그들이 할 수 있는 권한이나 액세스 가능한 것을 결정하는 것이다; 이것은 인증의 한 부분이다. foo 사용자는 bar에서 x, y를 수행하고 bas에서 y, z를 수행할 수 있다.

컴플라이언스 및 모니터링 (Compliance & Monitoring)

Note

요약:

- 컴플라이언스는 지속적인 활동이다.

- 이상 징후 모니터링

컴플라이언스는 일반적으로 PCI, HIPAA 등과 같은 특정 인증을 볼 때 사람들이 참조하는 것이다. 그러나 이것은 강화 지침이나 설정된 표준을 준수하도록 더욱 확장된다. 예를 들어 STIG는 샘플 강화 기준이지만 각 회사에는 추가 정책/규칙이 있을 수 있다. 안전한 시스템을 보장하기 위해 시스템은 이러한 정책을 준수하고 준수 상태에 있는지 확인해야 한다.

일반적으로 컴플라이언스는 소급 적용되며 상당히 수동적인 프로세스이다. 나는 이것이 절대적으로 잘못된 접근법이라고 생각한다. 컴플라이언스는 잠재적 위협 벡터를 제한하거나 열린 위협 요소를 닫을 수 있는 유일한 방법이므로 지속적으로 확인해야 한다.

구성 관리 자동화(일명 원하는 상태 구성-DSC)를 처리하는 도구는 여기서 중요한 부분이다. 이를 통해 구성/설정이 항상 기준 또는 원하는 상태로 설정된다.

모니터링 및 침투 테스트는 이러한 컴플라이언스를 검증하고 보장하는 데 중요하다. Nessus, Nmap 또는 metasploit와 같은 도구를 사용하여 시스템의 보안을 테스트할 수 있다. 이러한 테스트 중에 모니터링 및 감지 시스템은 이를 감지하고 경고해야 한다.

사람 (People)

Note

요약:

- 교육, 교육, 교육

- 강력한 관행 및 습관 강화 (e.g. 컴퓨터 잠금)

어느 시스템에서나 사람은 일반적으로 가장 약한 연결 고리이다. 사용자가 피싱 공격이나 사회적 조작에 취약하지 않도록 하려면 교육 및 교육이 중요하다. 우리는 사용자가 무엇을 찾아야 하는지 잘 알고 있어야 하며, 확실하지 않은 경우 알려진 리소스로 에스컬레이션 해야 한다.

한 가지 교육 방법은 실제로 피싱 공격을 시뮬레이션하여 사물에 의문을 제기하고 무엇을 찾아야 하는지 배울 수 있다. 또한 컴퓨터를 잠금 해제 상태로 두지 않거나 암호를 기록하지 않는 등 다른 정책을 시행해야 한다

인증 및 자격 (Certifications & Accreditations)

뉴타닉스는 스택의 일부(온-프레미스 및 오프-프레미스)에 대해 다음과 같은 보안 인증/자격을 보유하고 있다.

- 공통 평가 기준 (Common Criteria)*

- 공통 평가 기준은 주로 공공 시장(주로 국방 및 인텔리전스 용)에 컴퓨터 제품을 판매하는 회사가 한 세트의 표준에 대해서만 평가받도록 하기 위해 만들어졌다. CC는 캐나다, 프랑스, 독일, 네덜란드, 영국 및 미국 정부에 의해 개발되었다.

- *2020년 3월 현재 재인증 중이다.

- Security Technical Implementation Guides (STIGs)

- DOD IA 및 IA-활성화된 디바이스/시스템에 대한 설정 표준. 1998년부터 DISA FSO(Field Security Operations)가 보안 기술 구현 안내서(STIGs)를 제공함으로써 DoD(국방부) 보안 시스템의 보안 상태를 향상시키는 중요한 역할을 수행하였다. STIGs에는 악의적인 컴퓨터 공격에 취약할 수 있는 정보시스템/소프트웨어를 "잠금"할 수 있는 기술 지침이 포함되어 있다.

- FIPS 140-2

- FIPS 140-2 표준은 민감하지만 기밀이 아닌 정보를 수집, 저장, 전송, 공유 및 보급하는 정부 부처 및 규제 산업(금융 및 헬스-케어 기관과 같은)에서 사용할 수 있도록 제품을 인증받으려는 민간 부분 벤더가 제작한 암호화 모듈을 위한 정보 기술 보안 인증 프로그램이다.

- NIST 800-53

- NIST 800-131a

- ISO 27001

- ISO 27017

- ISO 27018

SCMA (Security Configuration Management Automation)

뉴타닉스 보안 엔지니어링은 이제 고객에게 특정 시점의 보안 기준 점검에서 지속적인 모니터링/자체-교정 기준으로 발전하여 클러스터의 모든 CVM/AHV가 배포 수명주기 동안 기준 준수를 유지할 수 있도록 한다. 이 새로운 혁신은 문서화된 보안 기준(STIGs)의 모든 컴포넌트를 검사하고, 준수하지 않은 것으로 발견되면 고객의 개입 없이 지원되는 보안 기준으로 재설정하도록 한다. SCMA는 디폴트로 활성화되어 있으므로 활성화하는 데 필요한 작업이 없습니다.

Note

애드 혹 SCMA 실행 (Ad-hoc SCMA execution)

SCMA는 설정된 스케줄(디폴트 값: HOURLY)에 기반하여 실행되지만 온-디멘드로도 실행할 수 있다. SCMA 툴을 실행하려면 CVM에서 다음 명령어를 수행한다.

###### Run on a single CVMsudo salt-call state.highstate###### Run on all CVMs

allssh "sudo salt-call state.highstate"

뉴타닉스 nCLI를 통해 고객은 보다 엄격한 보안 요구 사항을 지원하기 위해 다양한 구성 설정을 제어할 수 있다.

CVM 보안 설정 (CVM Security Settings)

SCMA 정책의 클러스터 전체 설정을 지원하기 위해 nCLI에 다음 명령이 추가되었다. 아래 목록은 모든 명령과 기능을 제공한다.

CVM 보안 설정 가져오기

ncli cluster get-cvm-security-config

이 명령은 현재 클러스터 설정을 출력한다. 기본 출력은 다음과 같이 표시된다.

Enable Aide : false Enable Core : false Enable High Strength P... : false Enable Banner : false Enable SNMPv3 Only : false Schedule : DAILY

이들 각각은 다음과 같이 정의된다.

- Aide

- 고급 침입 감지 환경('Advanced Intrusion Detection Environment')이 주기적으로 실행되도록 활성화한다.

- 핵심 (Core)

- 문제가 있거나 SCMA가 치료할 수 없는 경우에 스택 추적을 생성한다.

- 강력한 암호 (High Strength Passwords)

- 강력한 암호(minlen=15,difok=8,remember=24)를 적용한다.

- 배너 (Banner)

- 커스텀 로그인 배너를 활성화한다.

- SNMPv3 전용

- SNMPv2 대신에 SNMPv3를 강제한다.

CMV 로그인 배너 설정 (Set CVM login banner)

이 명령은 뉴타닉스 CVM에 로그인할 때 동의 로그인 배너의 국방부(DoD) 지식을 활성화 또는 비활성화한다.

ncli cluster edit-cvm-security-params enable-banner=[yes|no] #Default:no

Note

사용자 정의 로그인 배너 (Custom login banner)

기본적으로 동의 로그인 배너의 국방부 지식이 사용된다. 사용자 정의 배너를 활용하려면 다음 단계를 수행한다 (CVM에서 Nutanix user로 실행).

- 기존 배너의 백업 생성

- sudo cp -a /srv/salt/security/KVM/sshd/DODbanner /srv/salt/security/KVM/sshd/DODbannerbak

- vi를 사용하여 기존 배너를 수정

- sudo vi /srv/salt/security/KVM/sshd/DODbanner

- 모든 CVM에서 단계를 반복하거나 수정된 배너를 모든 CVM으로 복사

- 우의 명령을 사용하여 배너 활성화

CVM 패스워드 강도 설정 (Set CVM password strength)

이 명령은 고강도 패스워드 정책을 활성화 또는 비활성화한다 (minlen=15, difok=8, remember=24).

ncli cluster edit-cvm-security-params enable-high-strength-password=[yes|no] #Default:no

AIDE(Advanced Intrusion Detection Environment) 설정 (Set Advanced Intrusion Detection Environment (AIDE))

이 명령은 AIDE 서비스의 주 단위 실행을 활성화 또는 비활성화한다.

ncli cluster edit-cvm-security-params enable-aide=true=[yes|no] #Default:no

SNMPv3 전용 설정 (Set SNMPv3 only)

이 명령은 SNMPv3 전용 트랩을 활성화 또는 비활성화한다.

ncli cluster edit-cvm-security-params enable-snmpv3-only=[true|false] #Default:false

SCMA 스케줄 설정 (Set SCMA schedule)

이 명령은 SCMA 실행 주기를 설정한다.

ncli cluster edit-cvm-security-params schedule=[HOURLY|DAILY|WEEKLY|MONTHLY] #Default:HOURLY

하이퍼바이저 보안 설정 (Hypervisor Security Settings)

SCMA 정책의 클러스터 전체 설정을 지원하기 위해 nCLI에 다음 명령이 추가되었다. 아래 목록은 모든 명령과 기능을 제공한다.

하이퍼바이저 보안 설정 가져오기 (Get hypervisor security settings)

ncli cluster get-hypervisor-security-config

이 명령은 현재 클러스터 설정을 출력한다. 기본 출력은 다음과 같이 표시된다.

Enable Aide : false Enable Core : false Enable High Strength P... : false Enable Banner : false Schedule : DAILY

하이퍼바이저 로그인 배너 설정 (Set hypervisor login banner)

이 명령은 뉴타닉스 AHV에 로그인할 때 동의 로그인 배너의 국방부(DoD) 지식을 활성화 또는 비활성화한다.

ncli cluster edit-hypervisor-security-params enable-banner=[yes|no] #Default:no

하이퍼바이저 패스워드 강도 설정 (Set hypervisor password strength)

이 명령은 고강도 패스워드 정책을 활성화 또는 비활성화한다 (minlen=15, difok=8, remember=24).

ncli cluster edit-hypervisor-security-params enable-high-strength-password=[yes|no] #Default:no

AIDE(Advanced Intrusion Detection Environment) 설정 (Set Advanced Intrusion Detection Environment (AIDE))

이 명령은 AIDE 서비스의 주 단위 실행을 활성화 또는 비활성화한다.

ncli cluster edit-hypervisor-security-params enable-aide=true=[yes|no] #Default:no

SCMA 스케줄 설정 (Set SCMA schedule)

이 명령은 SCMA 실행 주기를 설정한다.

ncli cluster edit-hypervisor-security-params schedule=[HOURLY|DAILY|WEEKLY|MONTHLY] #Default:HOURLY

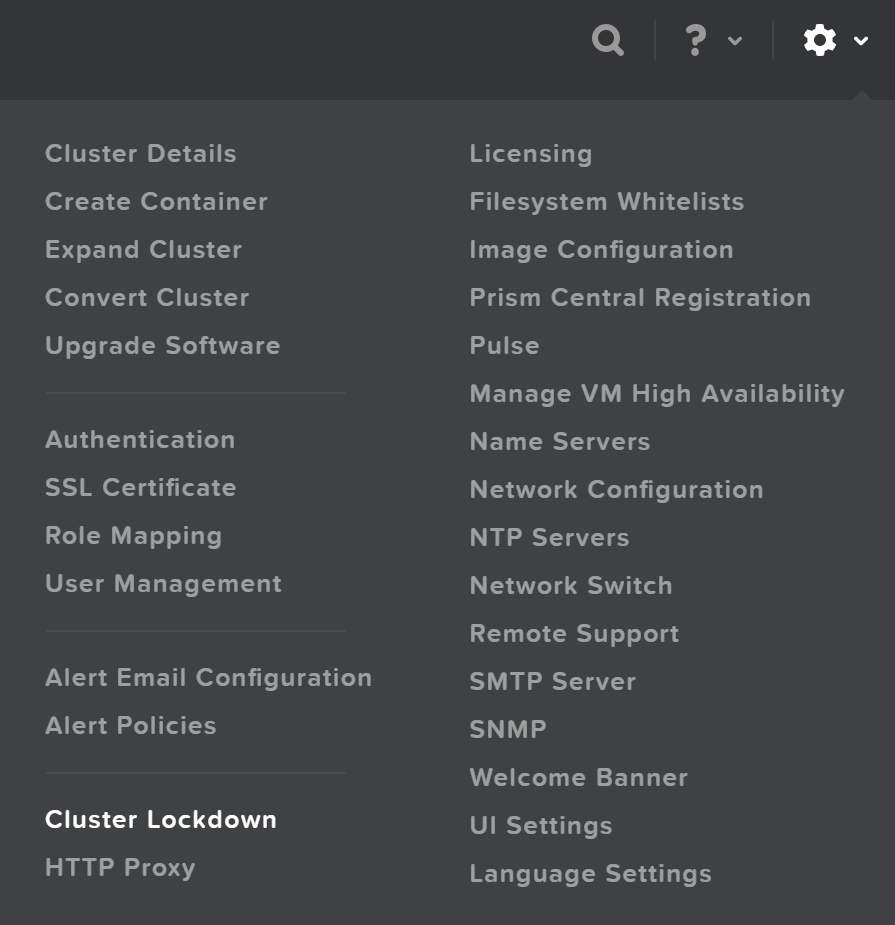

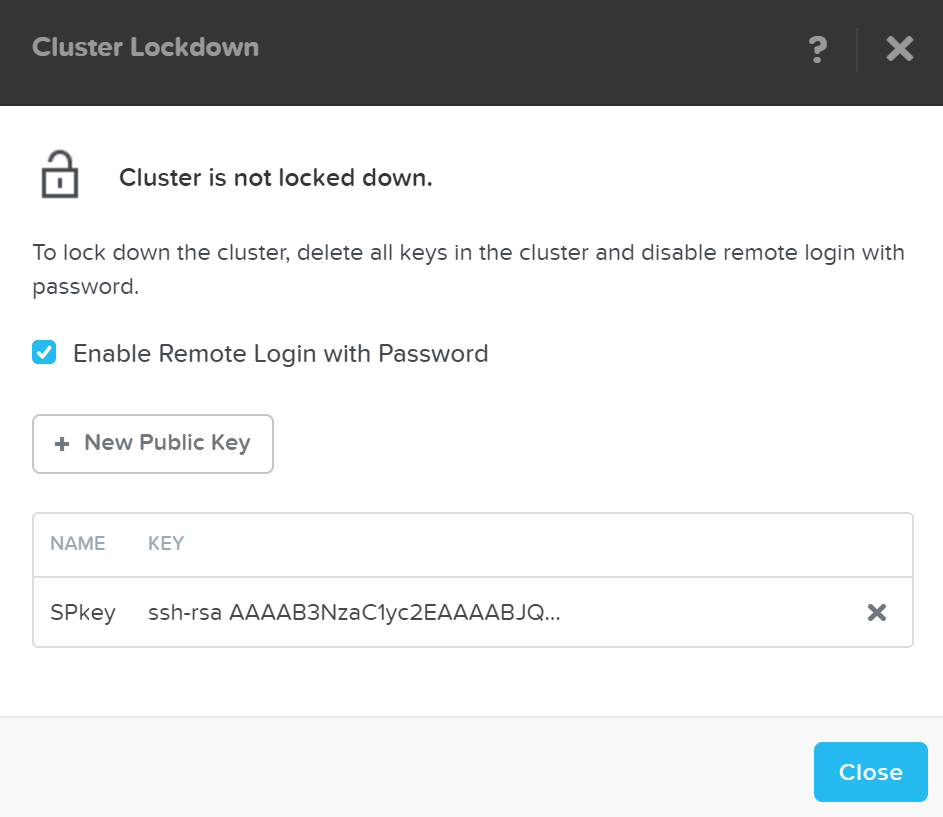

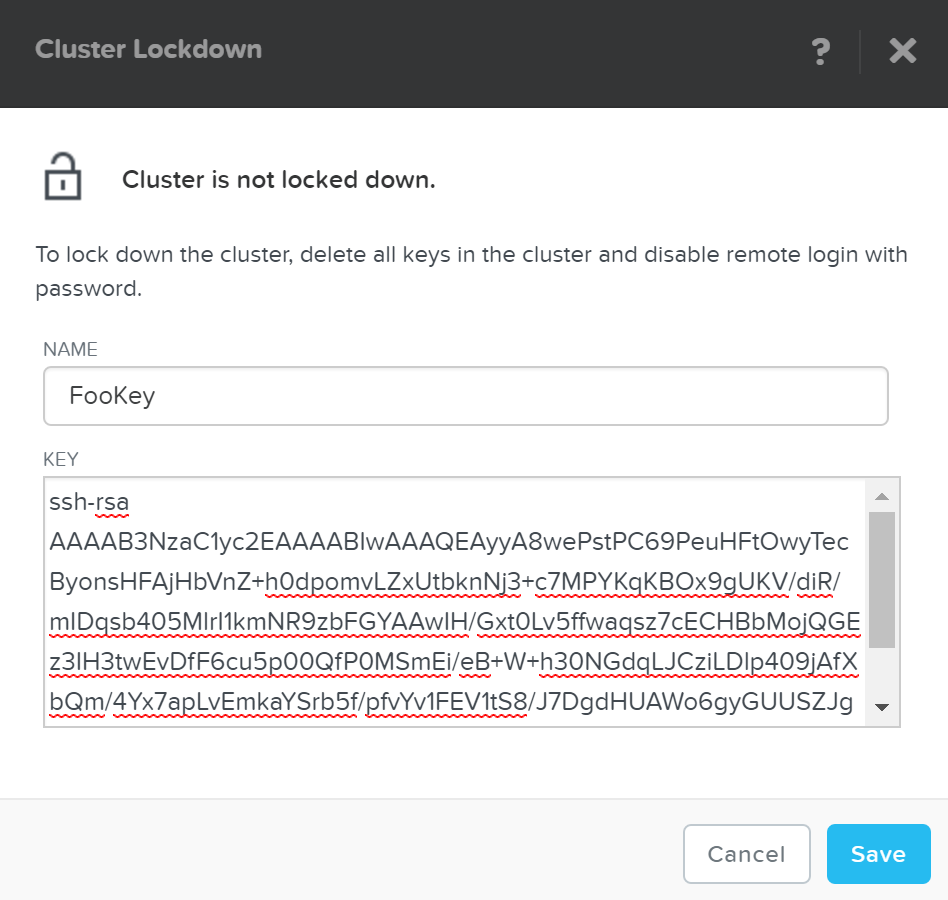

클러스터 잠금 (Cluster Lockdown)

클러스터 잠금은 패스워드 기반 CVM 액세스를 비활성화하고 키 기반 액세스만 허용하는 기능이다.

클러스터 잠금 설정은 프리즘의 설정 메뉴에서 찾을 수 있다.

클러스터 잠금 메뉴 (Cluster Lockdown Menu)

클러스터 잠금 메뉴 (Cluster Lockdown Menu)

현재 설정이 표시되고 액세스를 위해 SSH 키를 추가/제거할 수 있다.

클러스터 잠금 페이지 (Cluster Lockdown Page)

클러스터 잠금 페이지 (Cluster Lockdown Page)

새로운 키를 추가하려면 “New Public Key” 버튼을 클릭하고 공개 키 세부 사항을 입력한다.

클러스터 잠금 – 키 추가 Cluster Lockdown - Add Key)

클러스터 잠금 – 키 추가 Cluster Lockdown - Add Key)

Note

SSH 키 작업 (Working with SSH keys)

SSH 키를 생성하려면 다음 명령을 실행한다:

ssh-keygen -t rsa -b 2048

그러면 키 쌍이 만들어지고 두 개의 파일이 생성된다:

- id_rsa (private key)

- id_rsa.pub (public key - this one is used when adding a key to the cluster)

일부 키를 추가하고 액세스 권한을 확인한 후에 “Enable Remote Login with Password”을 선택 해제하여 패스워드 기반 로그인을 비활성화할 수 있다. 작업을 확인하는 팝업이 나타나면 “OK”를 클릭하여 잠금을 진행한다.

데이터 암호화 및 키 관리

데이터 암호화는 권한이 있는 사람만 데이터를 이해할 수 있는 방식으로 당사자들이 데이터를 인코딩할 수 있도록 허용하는 방법으로 권한이 없는 사람은 이해할 수 없다.

예를 들어, 한 사람에게만 메시지를 보내야 하는 경우 메시지(평문)를 암호(키)로 암호화하여 암호화된 메시지(암호문)를 보낼 수 있다. 이 메시지를 도난당하거나 가로채면 공격자는 메시지를 해독할 암호 없이 대부분 쓸모없는 암호문만 볼 수 있다. 원하는 당사자가 메시지를 받으면 우리가 제공한 키를 사용하여 메시지를 해독할 수 있다.

데이터를 암호화하는 몇 가지 주요 방법이 있다:

- 대칭 암호화 (개인 키 암호화)

- 데이터 암호화 및 복호화를 위해 동일 키 사용

- 예: AES, PGP*, Blowfish, Twofish, etc.

- 비대칭 암호화 (공개 키 암호화)

- 하나의 키는 암호화(공개 키)를 위해 사용하고 다른 키는 복호화(개인 키)를 위해 사용

- 예: RSA, PGP*, etc.

NOTE: PGP(또는 GPG)는 대칭 키와 비대칭 키를 모두 사용한다.

데이터 암호화에 대해 이야기할 때, 암호화는 일반적으로 두 가지 주요 컨텍스트에서 수행된다.

- 전송 중인 데이터(In-transit): 두 당사자 간에 전송 중인 데이터 (e.g. 네트워크를 통해 데이터 전송)

- 정적 데이터(At-Rest): 정적 데이터 (e.g. 디바이스에 저장된 데이터)

네이티브 소프트웨어 기반 암호화(SED 유무에 관계없이), 뉴타닉스는 전송 중인 데이터(In-transit* Data) 및 정적 데이터(Data-at-Rest Data) 암호화를 모두 해결한다. SED 기반 암호화만으로 뉴타닉스는 정적 데이터(Data-at-Rest Data) 암호화를 해결한다. *NOTE: 전송 중인 데이터 암호화는 현재 뉴타닉스 클러스터 내에서 데이터 RF에 적용할 수 있다.

다음 섹션에서 뉴타닉스가 데이터 암호화 및 키 관리 옵션을 관리하는 방법에 대해 설명한다.

데이터 암호화

뉴타닉스는 다음과 같은 세 가지 주요 옵션을 통해 데이터 암호화를 제공한다.

- 네이티브 소프트웨어 기반 암호화(FIPS-140-2 Level-1) * AOS 5.5에서 출시

- 자체 암호화 드라이브(SED) 사용 (FIPS-140-2 Level-2)

- 소프트웨어 + 하드웨어 암호화

암호화는 클러스터 또는 컨테이너 레벨에서 설정하며 하이퍼바이저 유형에 따라 다르다.

- 클러스터 레벨 암호화:

- AHV, ESXi, Hyper-V

- 컨테이너 레벨 암호화:

- ESXi, Hyper-V

NOTE: SED 기반 암호화를 사용하여 배포하는 경우 물리 디바이스가 자체적으로 암호화되므로 클러스터 레벨이 된다.

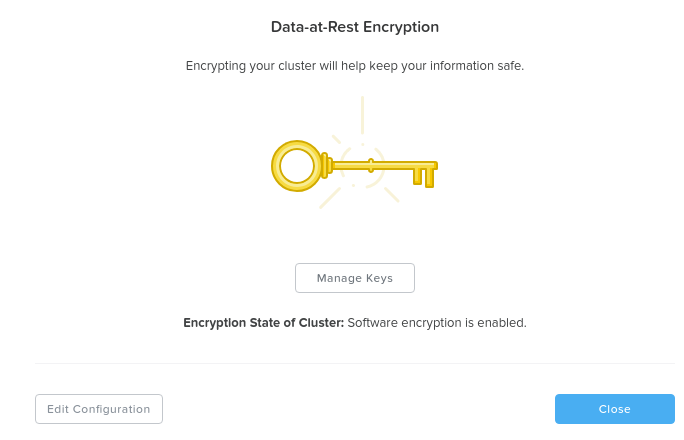

설정 메뉴(기어 아이콘)에서 'Data-at-Rest Encryption'로 이동하여 클러스터의 암호화 상태를 볼 수 있다. 현재 상태를 제공하고 암호화를 설정할 수 있다 (현재 활성화되어 있지 않은 경우).

이 예에서는 클러스터 레벨의 암호화가 설정되어 있음을 알 수 있다.

데이터 암호화 – 활성화 (클러스터 레벨) (Data Encryption - Enabled (cluster level))

데이터 암호화 – 활성화 (클러스터 레벨) (Data Encryption - Enabled (cluster level))

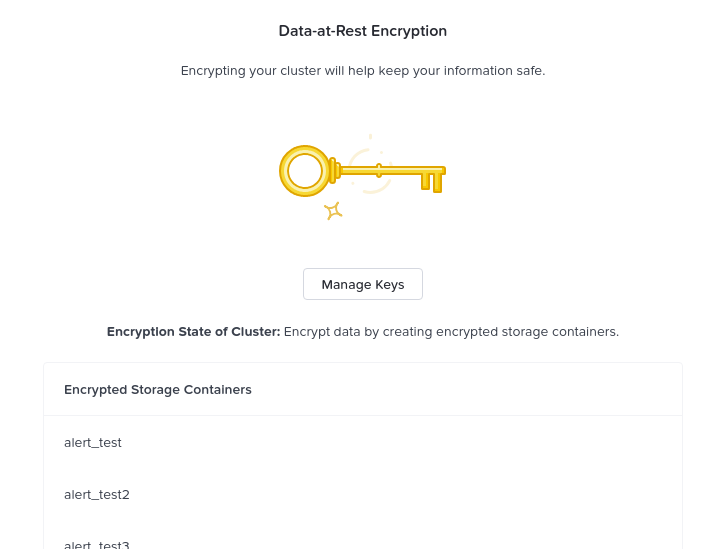

이 예제에서는 다음과 같은 특정 컨테이너에 대해 암호화가 사용되었다.

데이터 암호화 – 활성화 (컨테이너 레벨) (Data Encryption - Enabled (container level))

데이터 암호화 – 활성화 (컨테이너 레벨) (Data Encryption - Enabled (container level))

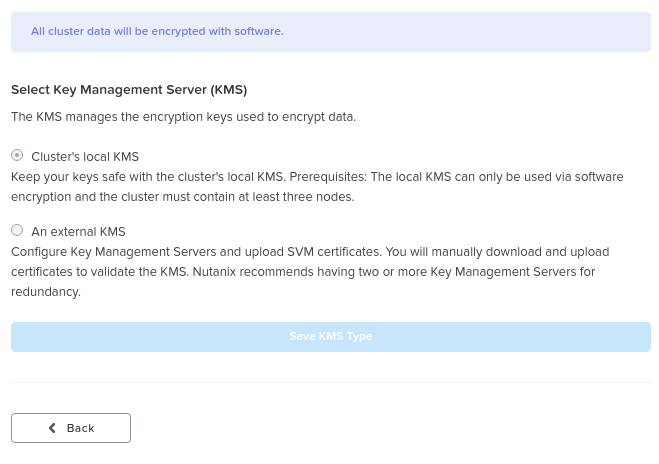

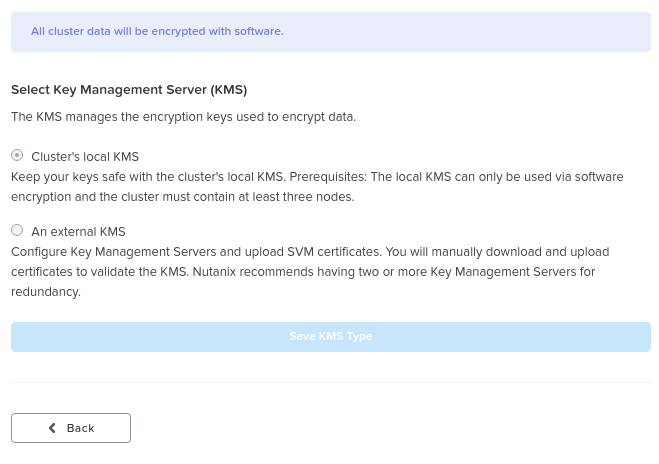

“Edit Configuration” 버튼을 클릭하여 설정을 활성화/수정할 수 있다. 암호화에 사용되는 KMS 또는 현재 활용 중인 KMS 유형을 설정할 수 있는 메뉴가 나타난다.

데이터 암호화 – 설정 (Data Encryption - Configure)

데이터 암호화 – 설정 (Data Encryption - Configure)

외부 KMS인 경우 메뉴는 서명을 위해 CA에 제공할 수 있는 CSR 요청 프로세스로 안내한다.

네이티브 소프트웨어 기반 암호화 (Native Software-based Encryption)

뉴타닉스 소프트웨어 암호화는 네이티브 AES-256 정적 데이터 암호화를 제공한다. 이는 모든 KMIP 또는 TCG 호환 외부 KMS 서버(Vormetric, SafeNet 등) 또는 AOS 5.8에서 도입된 뉴타닉스 네이티브 KMS(아래에서 자세히 설명)와 상호 작용할 수 있다. 암호화/복호화를 위해 시스템은 인텔 AES-NI 가속을 활용하여 소프트웨어로 이 작업을 수행할 때의 잠재적 성능 영향을 최소화한다.

데이터가 쓰일 때 (OpLog 및 익스텐트 스토어) 데이터는 체크섬을 제외하고 디스크에 쓰이기 전에 암호화된다. 이는 데이터가 로컬로 암호화된 다음 암호화된 데이터가 RF를 위해 원격 CVM에 복제됨을 의미한다.

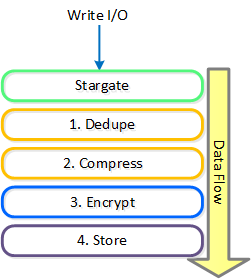

암호화는 디스크에 쓰기 전에 데이터에 마지막으로 적용되는 변환이다.

데이터 암호화 – 애플리케이션 변환 (Data Encryption - Transform Application)

데이터 암호화 – 애플리케이션 변환 (Data Encryption - Transform Application)

Note

암호화 및 데이터 효율성 (Encryption and Data Efficiency)

중복제거 또는 압축을 적용한 후에 데이터를 암호화하므로 이러한 방법을 통한 모든 스토리지 용량 절감 가능이 유지된다. 간단히 말해 중복제거 및 압축 비율은 암호화되거나 암호화되지 않은 데이터에 대해 정확히 동일하다.

데이터를 읽을 때 체크섬 경계에서 데이터를 읽고 복호화 작업을 수행한 후에 게스트 VM에 데이터를 반환한다. 체크섬 경계에서 암호화/복호화 작업을 수행하므로 읽기 증폭이 발생하지 않는다. 인텔 AES NI 오프로드 기능을 활용하기 때문에 성능/레이턴시에 미치는 영향은 거의 없다.

SED 기반 암호화 (SED Based Encryption)

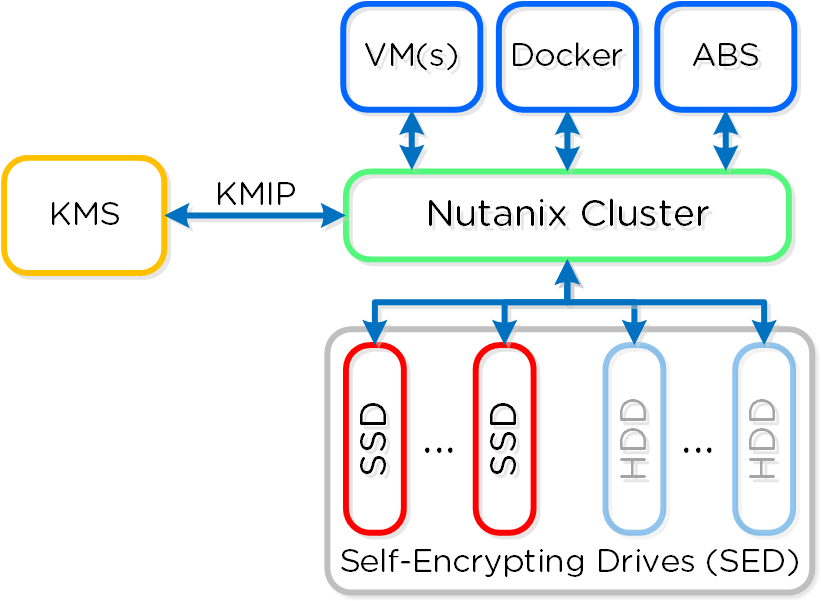

이 그림은 아키텍처의 하이-레벨 개요를 보여준다.

데이터 암호화 - SED (Data Encryption - SED)

데이터 암호화 - SED (Data Encryption - SED)

SED 암호화는 스토리지 디바이스를 보안 또는 보안되지 않은 상태를 갖는 “데이터 밴드"로 분할하여 동작한다. 뉴타닉스의 경우 부트 및 뉴타닉스 홈 파티션은 간단하게 암호화된다. 모든 디바이스 및 밴드는 Level-2 표준에 따라 빅 키로 강력하게 암호화된다.

클러스터가 시작되면 KMS 서버를 호출하여 드라이브 잠금 해제 키를 얻는다. 보안을 위해 클러스터에서 키는 캐싱 되지 않는다. 콜드 부트 및 IPMI 리셋인 경우 노드는 드라이브 잠금 해제를 위해 KMS 서버를 다시 호출할 필요가 있다. CVM을 소프트 리부트 하는 경우에 이러한 과정은 발생하지 않는다.

키 관리 (KMS) [Key Management (KMS)]

뉴타닉스는 다른 전용 KMS 솔루션의 대안으로 네이티브 키 관리(로컬 키 관리자 - LKM) 및 스토리지 기능(AOS 5.8에서 도입)을 제공한다. 이는 전용 KMS 솔루션의 필요성을 없애고 환경을 단순화하기 위해 도입되었지만 외부 KMS는 여전히 지원된다.

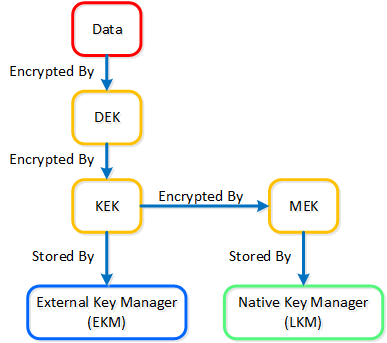

이전 섹션에서 언급했듯이 키 관리는 모든 데이터 암호화 솔루션에서 매우 중요한 부분이다. 안전한 키 관리 솔루션을 제공하기 위해 스택 전체에서 여러 개의 키가 사용된다.

솔루션에 세 가지 유형의 키가 사용된다.

- 데이터 암호화 키 (DEK: Data Encryption Key)

- 데이터 암호화에 사용되는 키

- 키 암호화 키 (KEK: Key Encryption Key)

- DEK 암호화에 사용되는 암호화 키

- 마스터 암호화 키 (MEK: Master Encryption Key)

- KEK 암호화에 사용되는 암호화 키

- 로컬 키 관리자를 사용할 때만 적용 가능

다음 그림은 다양한 키와 KMS 옵션 간의 관계를 보여준다.

데이터 암호화 – 키 관리 (Data Encryption - Key Management)

데이터 암호화 – 키 관리 (Data Encryption - Key Management)

LKM(로컬 키 매니저) 서비스는 모든 뉴타닉스 노드에 분산되며 각 CVM에서 기본적으로 실행된다. 이 서비스는 FIPS 140-2 Crypto 모듈(현재 인증 작업 진행 중)을 사용하며, 키 관리는 키 관리 활동(e.g. re-key, backup keys 등) 외에 최종 사용자에게 투명하다.

데이터 암호화를 설정할 때 'Cluster’s local KMS'를 선택하면 네이티브 KMS를 활용할 수 있다.

데이터 암호화 - 설정 (Data Encryption - Configure)

데이터 암호화 - 설정 (Data Encryption - Configure)

마스터 키(MEK: Master Encryption Key)는 키의 리질리언시 및 보안을 위해 Shamir의 Secret Sharing 알고리즘을 사용하여 클러스터의 모든 노드에 분할되어 저장된다. 키를 다시 구성하려면 최소 ROUNDUP (N / 2) 노드를 사용할 수 있어야 한다. 여기서 N은 클러스터의 노드 수다.

Note

키 백업 및 키 로테이션 (Key Backups and Key Rotation)

시스템은 KEK와 MEK를 모두 로테이션(re-key)할 수 있는 기능을 제공한다. 시스템은 매년 마스터 키(MEK)를 자동으로 로테이션하지만 필요에 따라 이 작업을 수행할 수도 있다. 노드 추가/제거의 경우 마스터 키도 로테이션 한다.

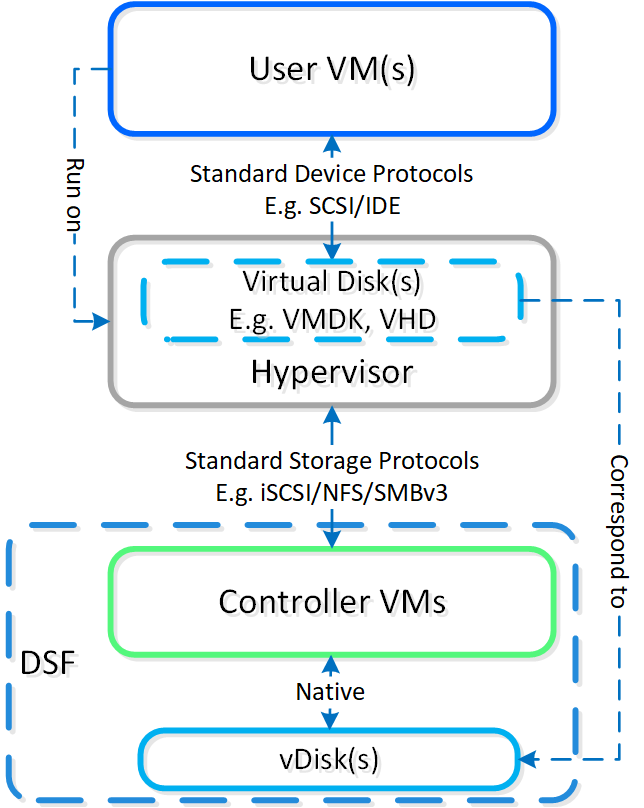

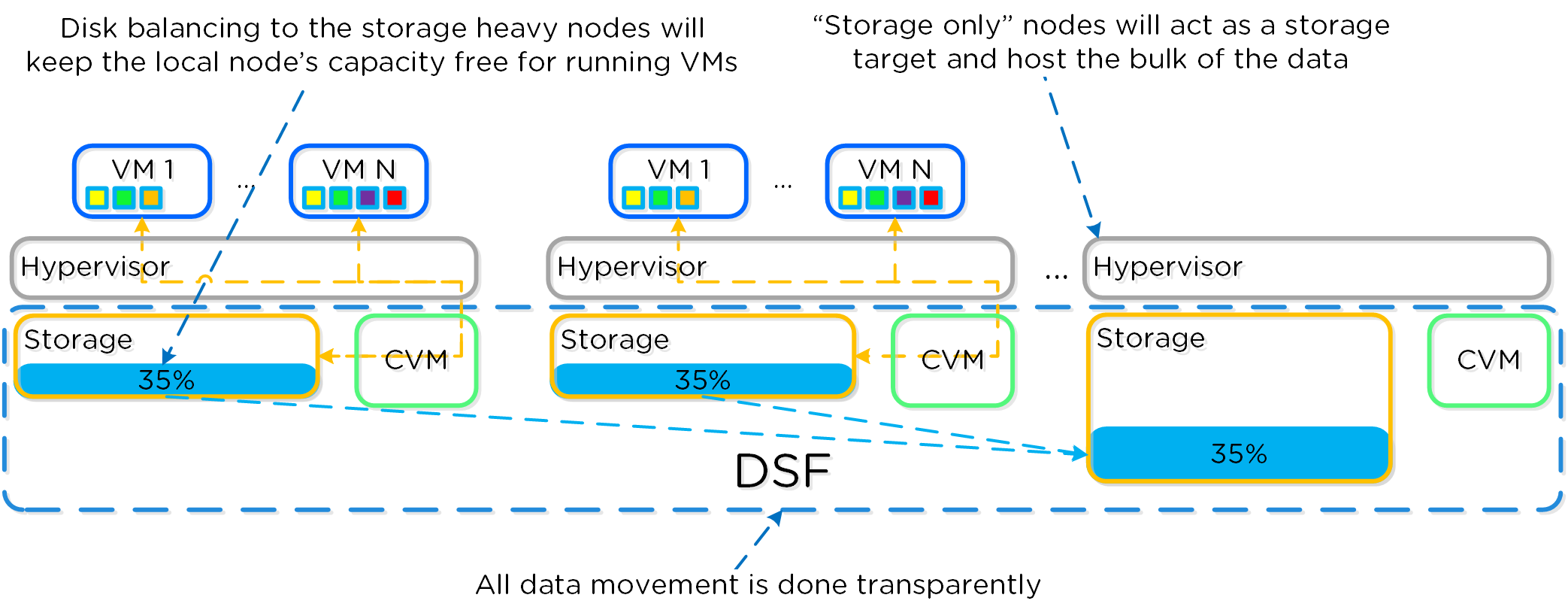

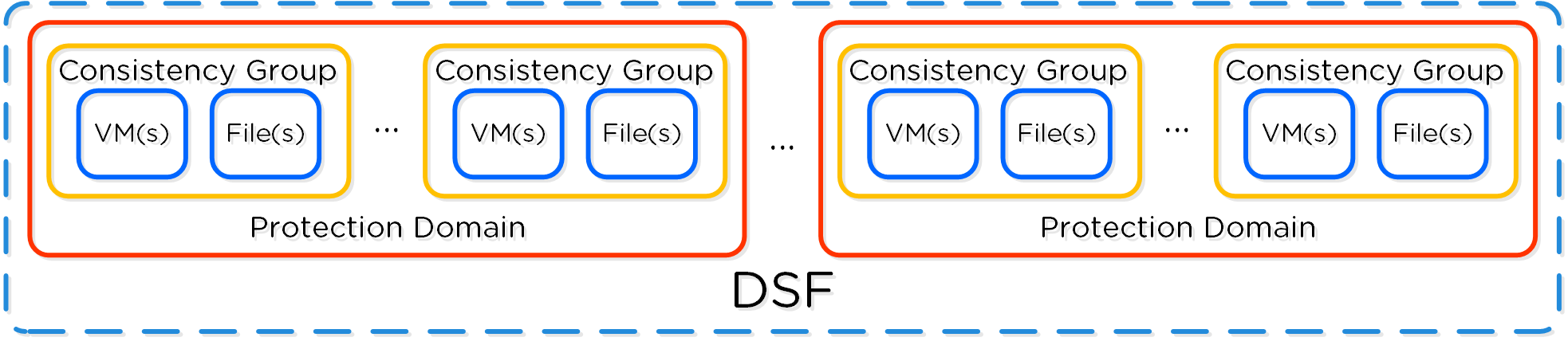

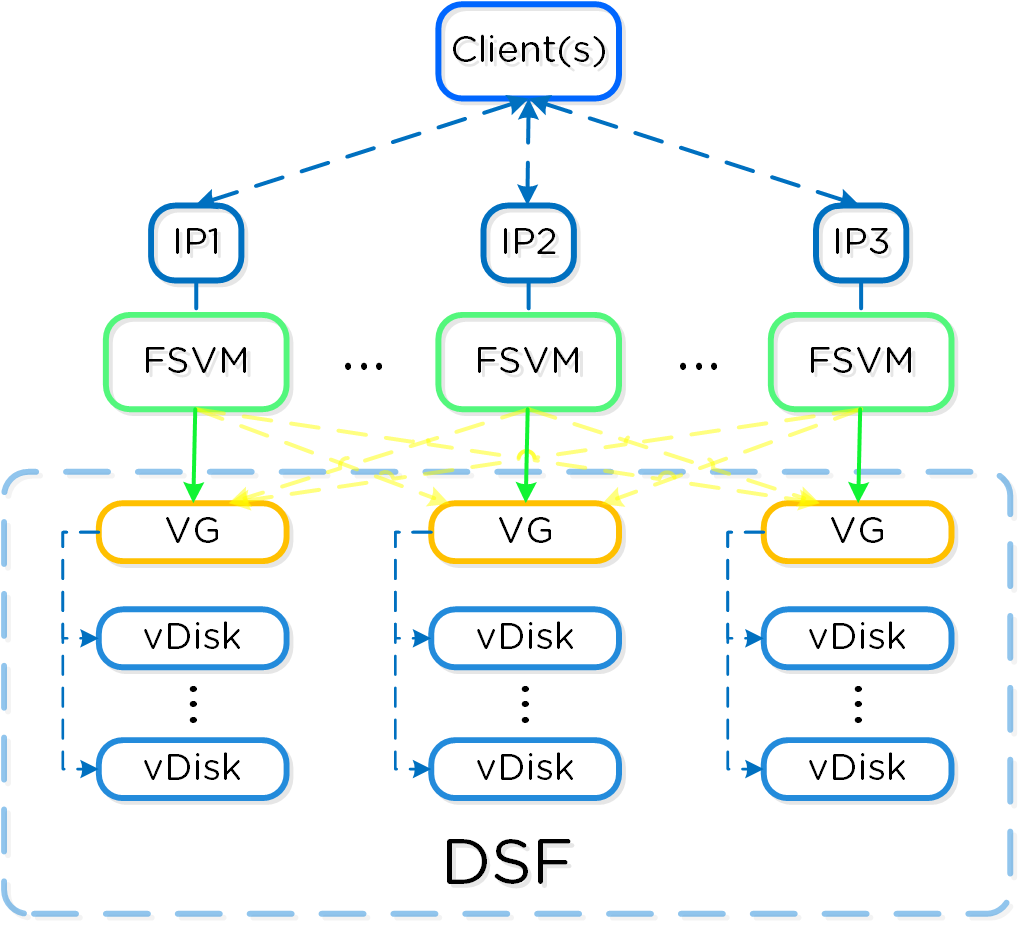

분산 스토리지 패브릭

분산 스토리지 패브릭(Distributed Storage Fabric: DSF)은 중앙 집중식 스토리지 어레이처럼 하이퍼바이저에게 보이지만 모든 I/O는 로컬에서 처리되어 최고의 성능을 제공한다. 이러한 노드들이 분산 시스템을 구성하는 방법에 대한 자세한 내용은 다음 섹션에서 확인할 수 있다.

데이터 구조

뉴타닉스 분산 스토리지 패브릭(Distributed Storage Fabric: DSF)은 다음과 같은 하이-레벨 스트럭트로 구성되어 있다.

스토리지 풀 (Storage Pool)

- 주요 역할: 물리적 디바이스의 그룹 (Group of physical devices)

- 설명: 스토리지 풀은 클러스터의 PCIe SSD, SSD 및 HDD 디바이스를 포함하는 물리적 스토리지 디바이스의 그룹이다. 스토리지 풀은 여러 개의 뉴타닉스 노드에 걸쳐있을 수 있으며 클러스터가 확장됨에 따라 스토리지 풀도 확장된다. 대부분의 설정에서는 단일 스토리지 풀만 활용된다.

컨테이너 (Container)

- 주요 역할: VM/파일의 그룹 (Group of VMs/files)

- 설명: 컨테이너는 스토리지 풀의 논리적 세그먼트이며 VM 또는 파일(vDisk) 그룹을 포함한다. 일부 설정 옵션(e.g. RF)은 컨테이너 레벨에서 설정되지만 개별 VM/파일 레벨에서 적용된다. 컨테이너는 일반적으로 데이터스토어(NFS/SMB인 경우)와 1:1 매핑을 가진다.

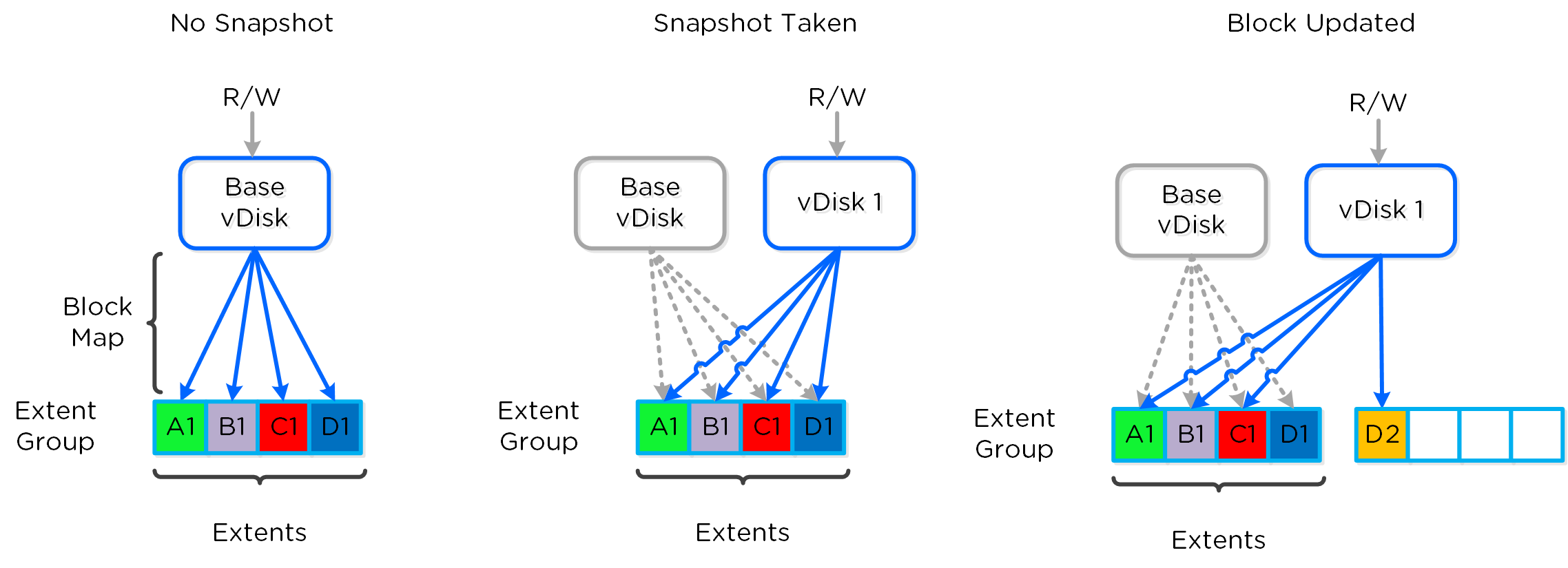

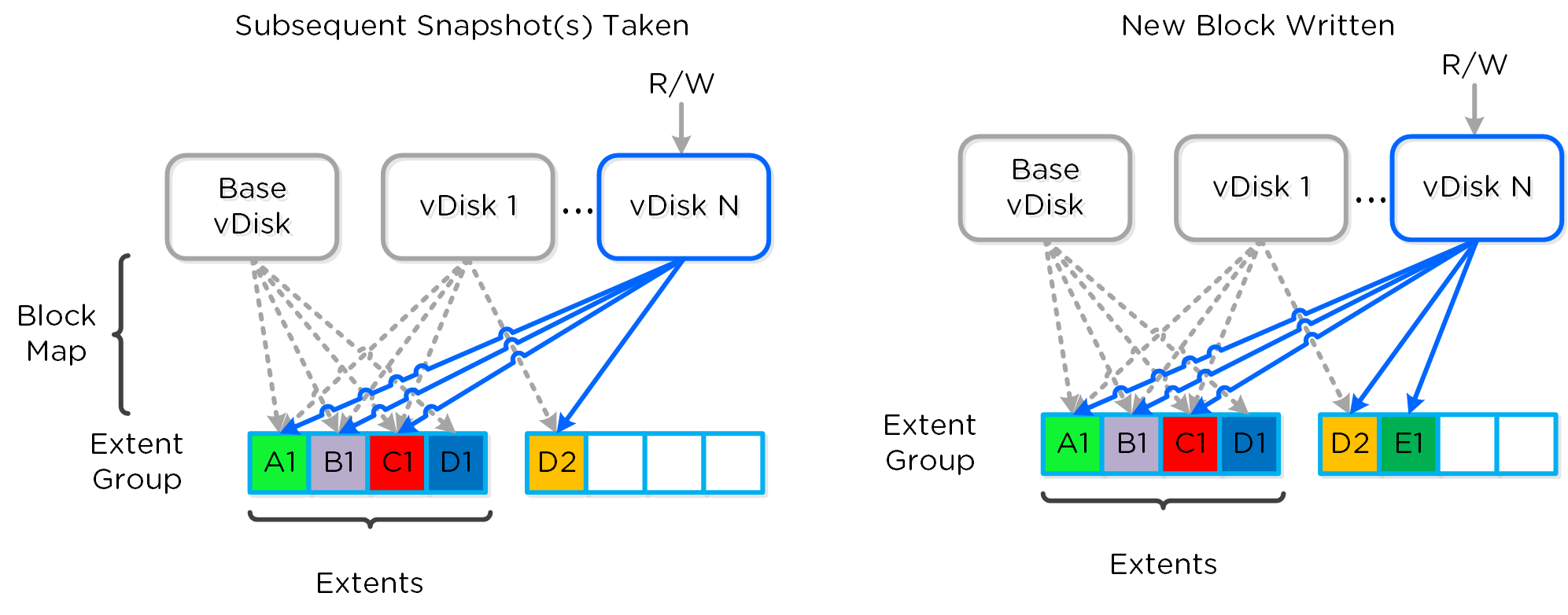

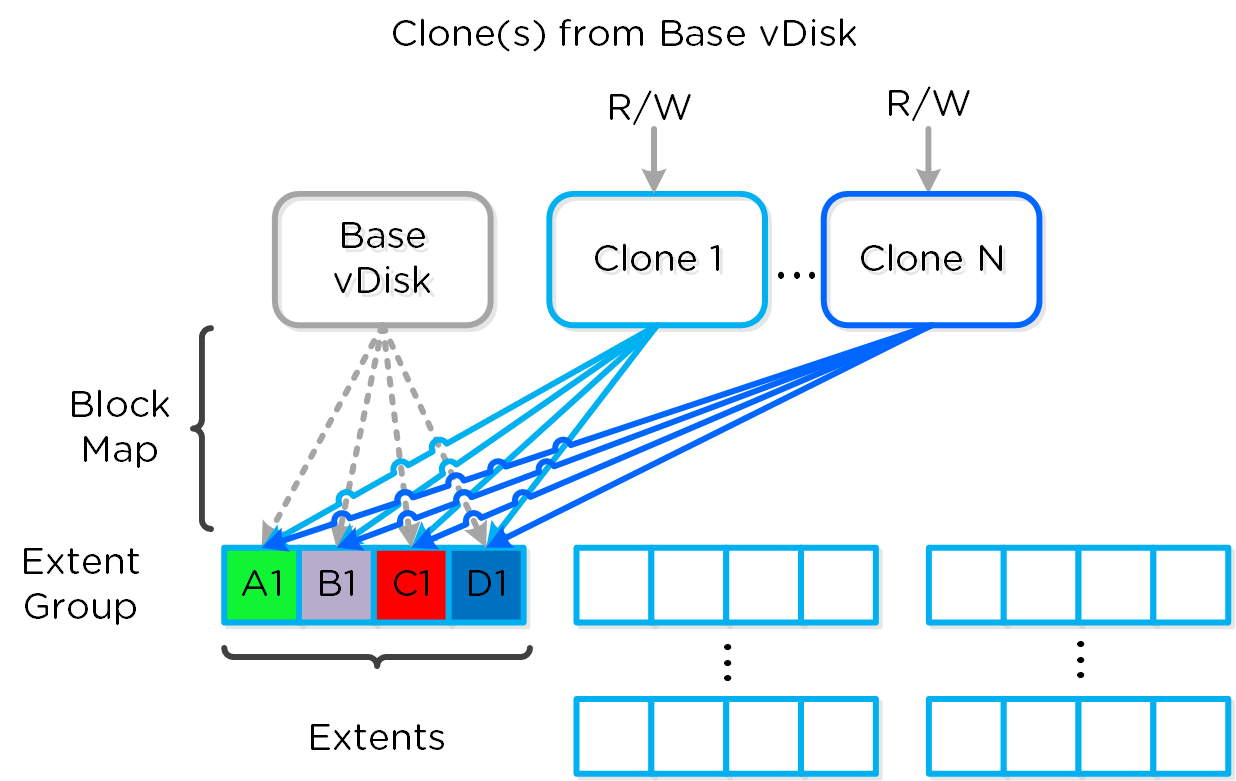

vDisk

- 주요 역할: vDisk

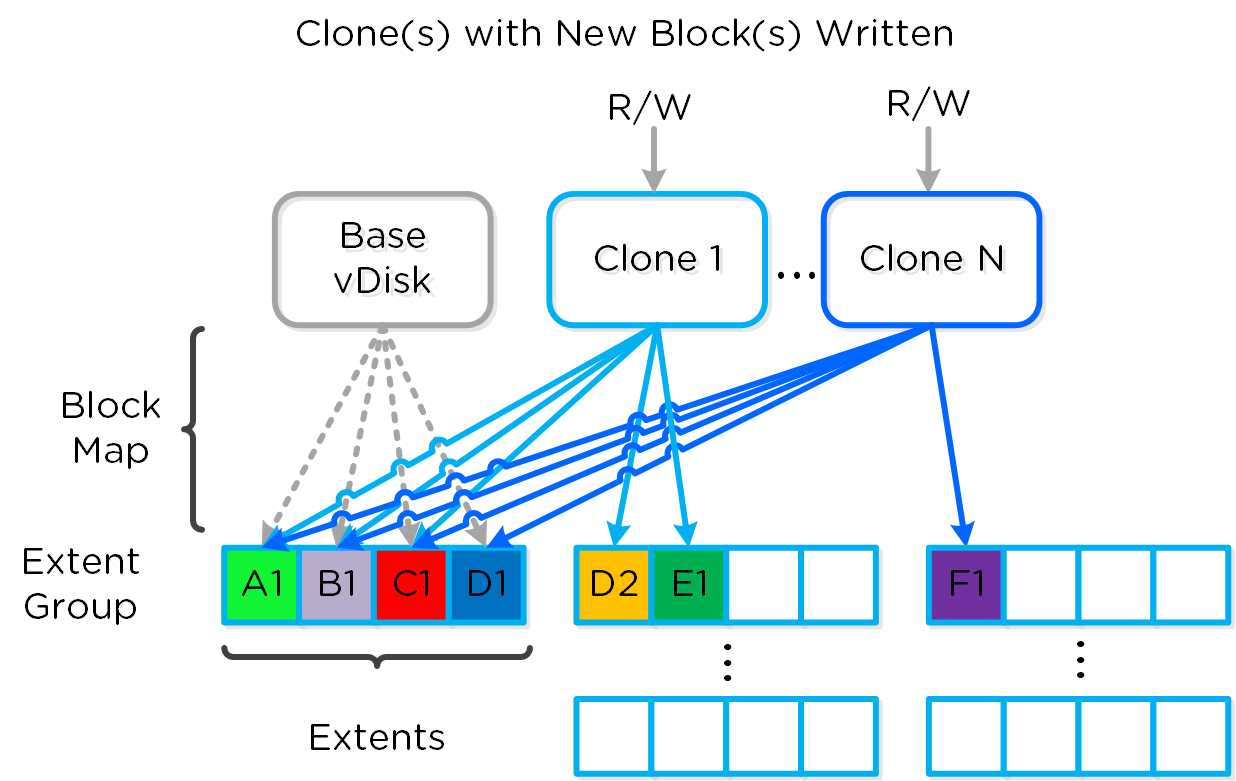

- 설명: vDisk는 .vmdk, VM 하드 디스크를 포함하여 DSF에서 512KB가 넘는 파일이다. vDisk는 논리적으로 "블록 맵(block map)"을 구성하는 vBlock으로 구성되어 있다.

Note

최대 DSF vDisk 크기 (Maximum DSF vDisk Size)

DSF/스타게이트 측면에서 vDisk 크기에 부과된 인위적인 제한은 없다. AOS 4.6에서 vDisk 크기는 크기를 바이트 단위로 저장하는 부호 있는 64비트 정수로 저장된다. 이는 이론상 최대 vDisk 크기가 2^63-1 or 9E18(9 Exabytes) 일 수 있음을 의미한다. 이 값 미만의 제한은 ESXi의 최대 vmdk 크기와 같은 클라이언트 측의 제한 때문이다.

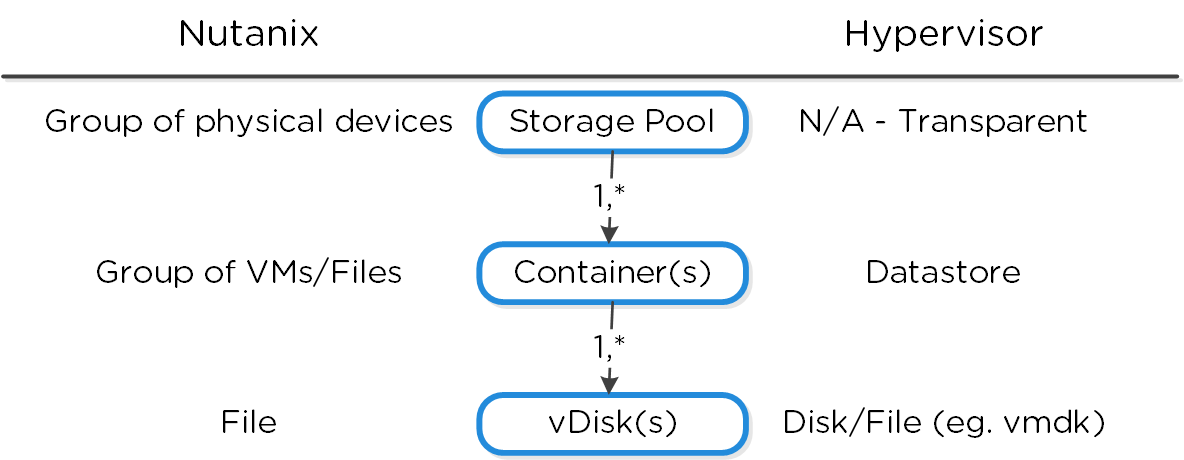

다음 그림은 DSF와 하이퍼바이저 간의 매핑 관계를 보여준다.

하이-레벨 파일시스템 분해 (High-level Filesystem Breakdown)

하이-레벨 파일시스템 분해 (High-level Filesystem Breakdown)

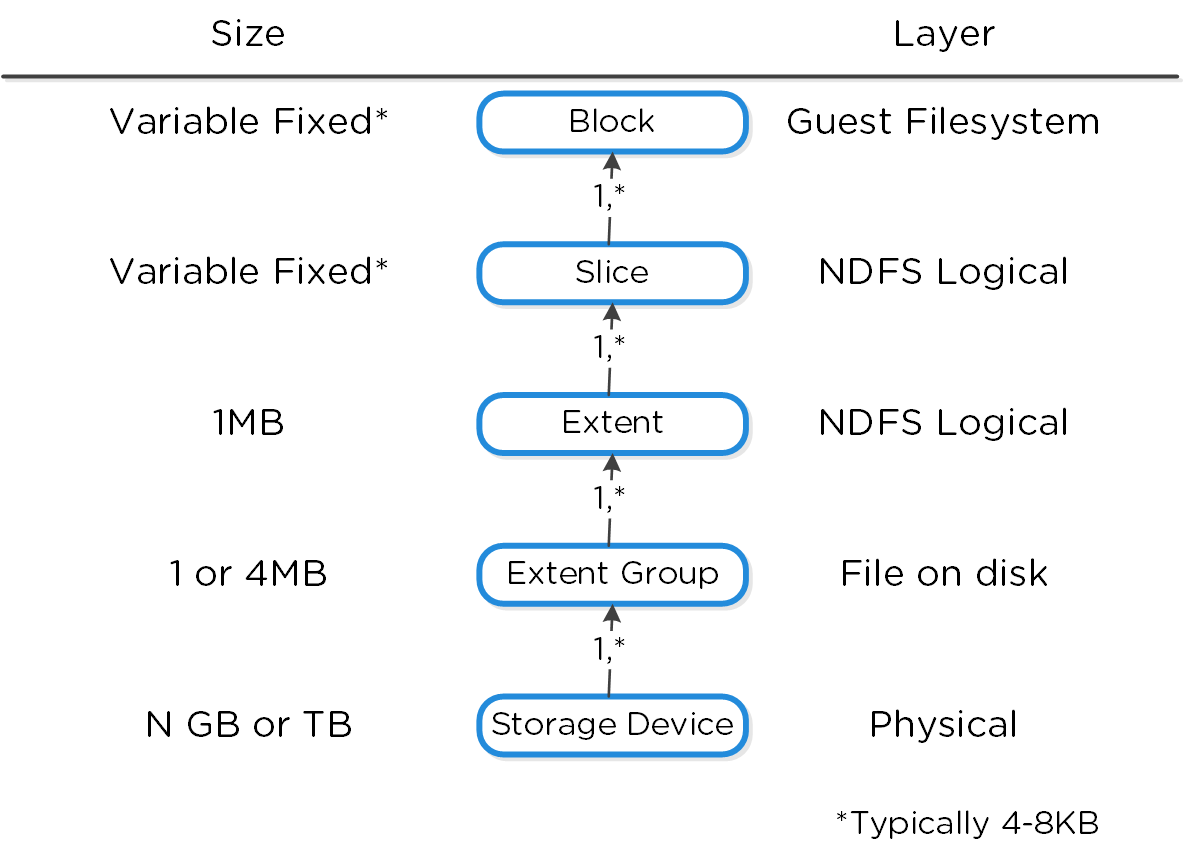

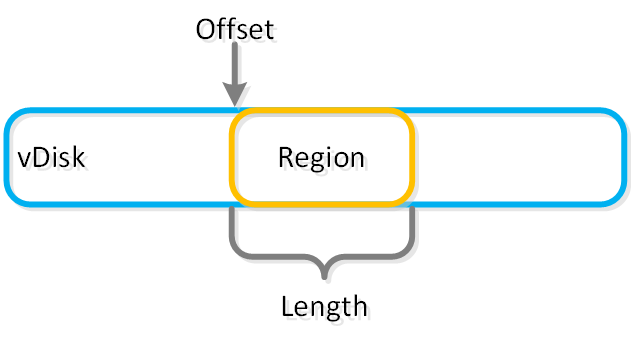

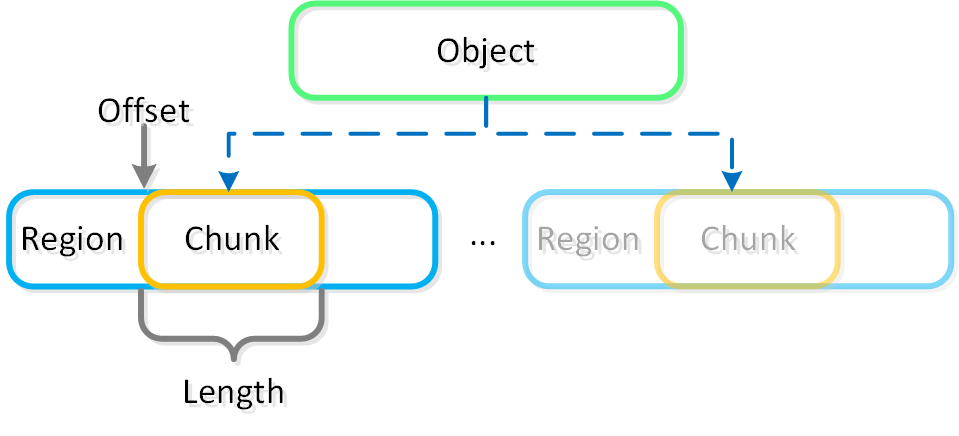

vBlock

- 주요 역할: 1MB의 vDisk 주소 공간 (1MB chunk of vDisk address space)

- 설명: vBlock은 vDisk를 구성하는 1MB 청크의 가상 주소 공간이다. 예를 들어 100MB의 vDisk는 100x1MB vBlock이 있고, vBlock 0은 0-1MB, vBlock 1은 1-2MB이다. 이 vBlock은 익스텐트 그룹으로 디스크에 파일로 저장되는 익스텐트에 매핑된다.

익스텐트 (Extent)

- 주요 역할: 논리적으로 연속적인 데이터 (Logically contiguous data)

- 설명: 익스텐트는 n개의 연속적인 블록(게스트 OS의 블록 크기에 따라 달라짐)으로 구성된 1MB의 논리적으로 연속적인 데이터이다. 익스텐트는 세분화 및 효율성을 위해 서브-익스텐트(슬라이스로 알려진) 기준으로 쓰기/읽기/수정된다. 익스텐트의 슬라이스는 캐시로 이동될 때 읽기/캐시되는 데이터의 양에 따라 트림된다.

익스텐트 그룹 (Extent Group)

- 주요 역할: 물리적으로 연속되어 저장되는 데이터 (Physically contiguous stored data)

- 설명: 익스텐트 그룹은 1MB 또는 4MB의 물리적으로 연속되어 저장되는 데이터이다. 이 데이터는 CVM이 소유한 스토리지 디바이스에 파일로 저장된다. 익스텐트는 성능 향상을 목적으로 노드/디스크 간에 데이터 스트라이핑을 제공하기 위해 익스텐트 그룹 간에 동적으로 분산된다. NOTE: AOS 4.0 현재 익스텐트 그룹은 중복제거에 따라 1MB 또는 4MB가 될 수 있다.

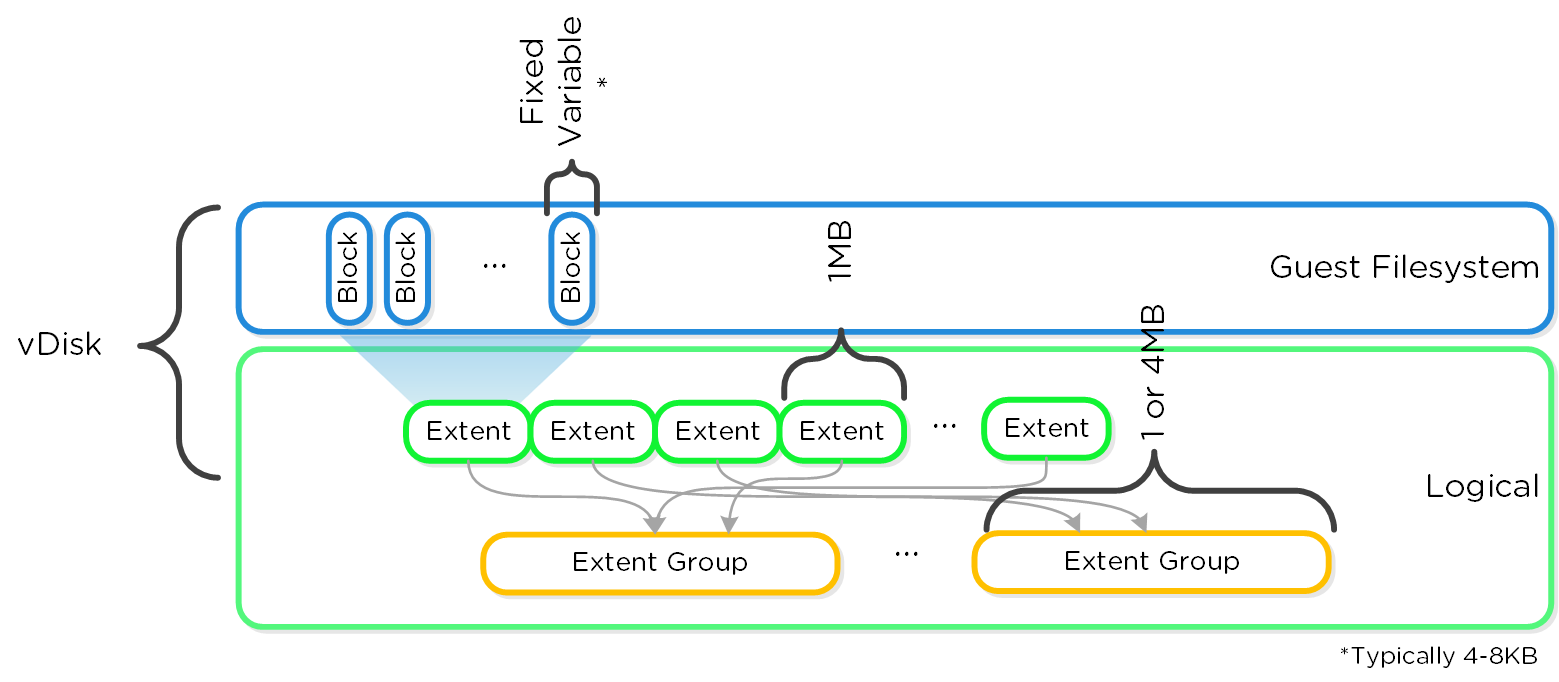

다음 그림은 이러한 스트럭트와 다양한 파일 시스템 간의 관계를 보여준다.

로우-레벨 파일시스템 분해 (Low-level Filesystem Breakdown)

로우-레벨 파일시스템 분해 (Low-level Filesystem Breakdown)

다음은 이러한 유닛이 어떻게 관련되어 있는지를 보여주는 다른 그래픽 표현이다.

그래픽컬 파일시스템 분해 (Graphical Filesystem Breakdown)

그래픽컬 파일시스템 분해 (Graphical Filesystem Breakdown)

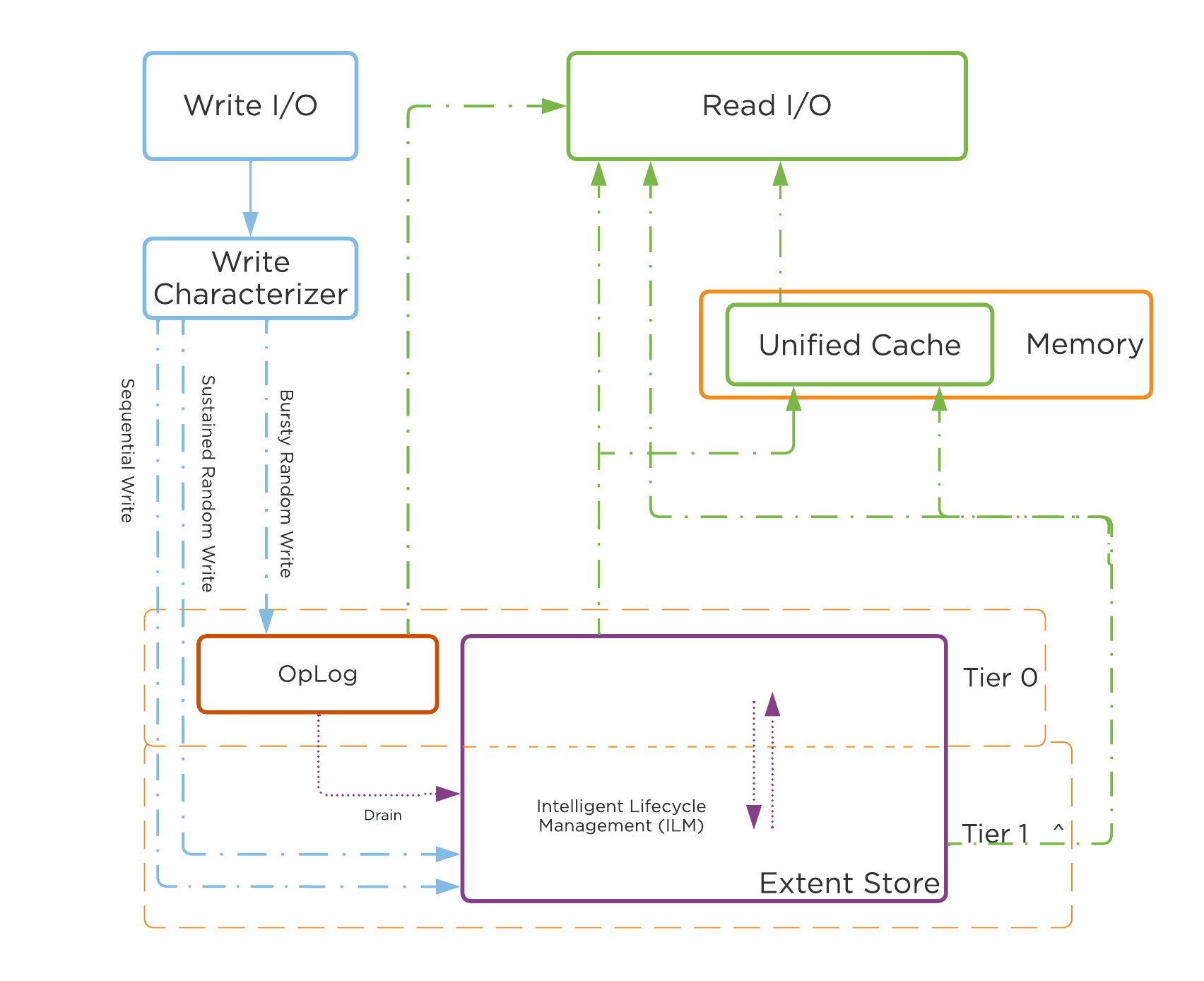

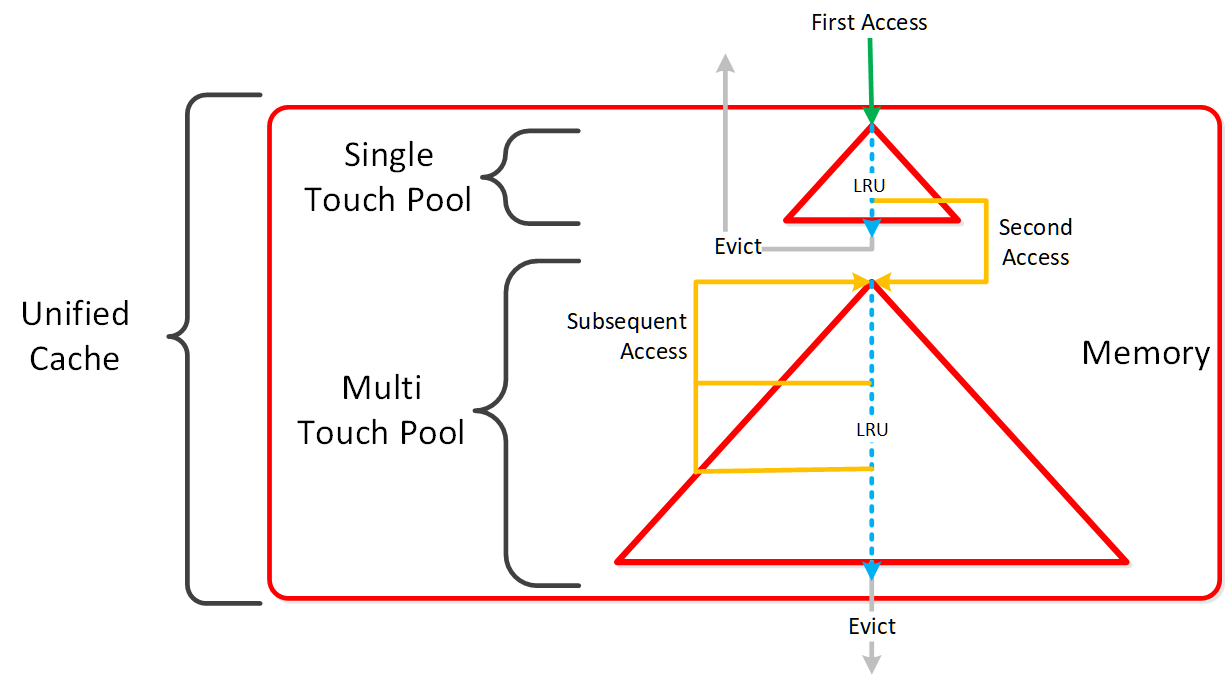

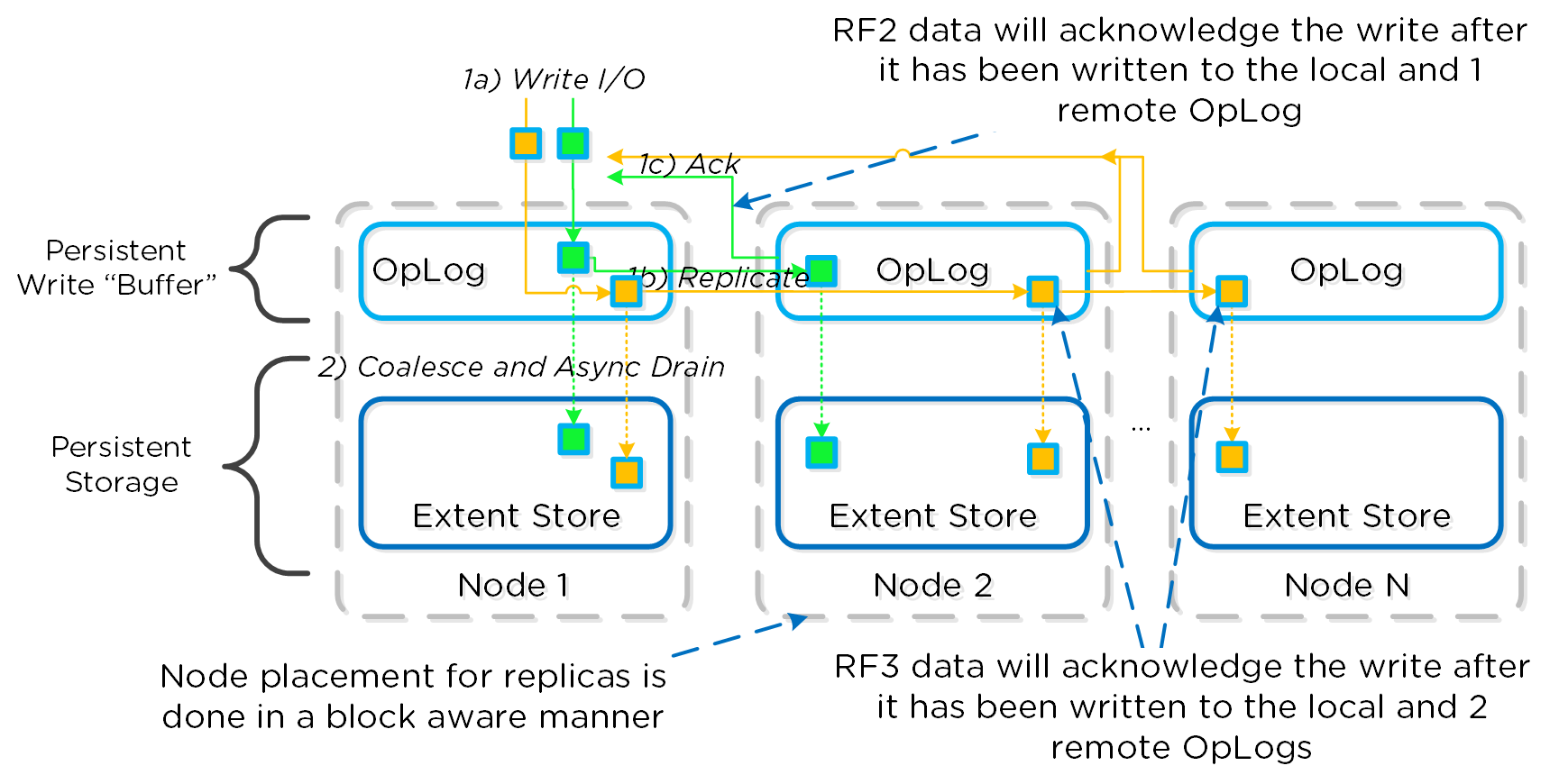

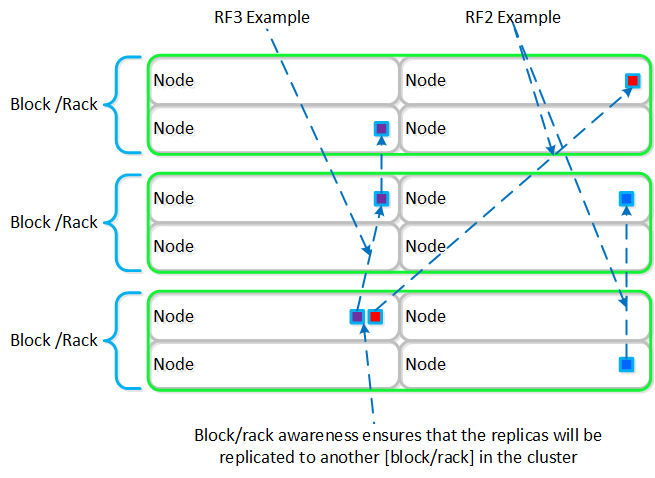

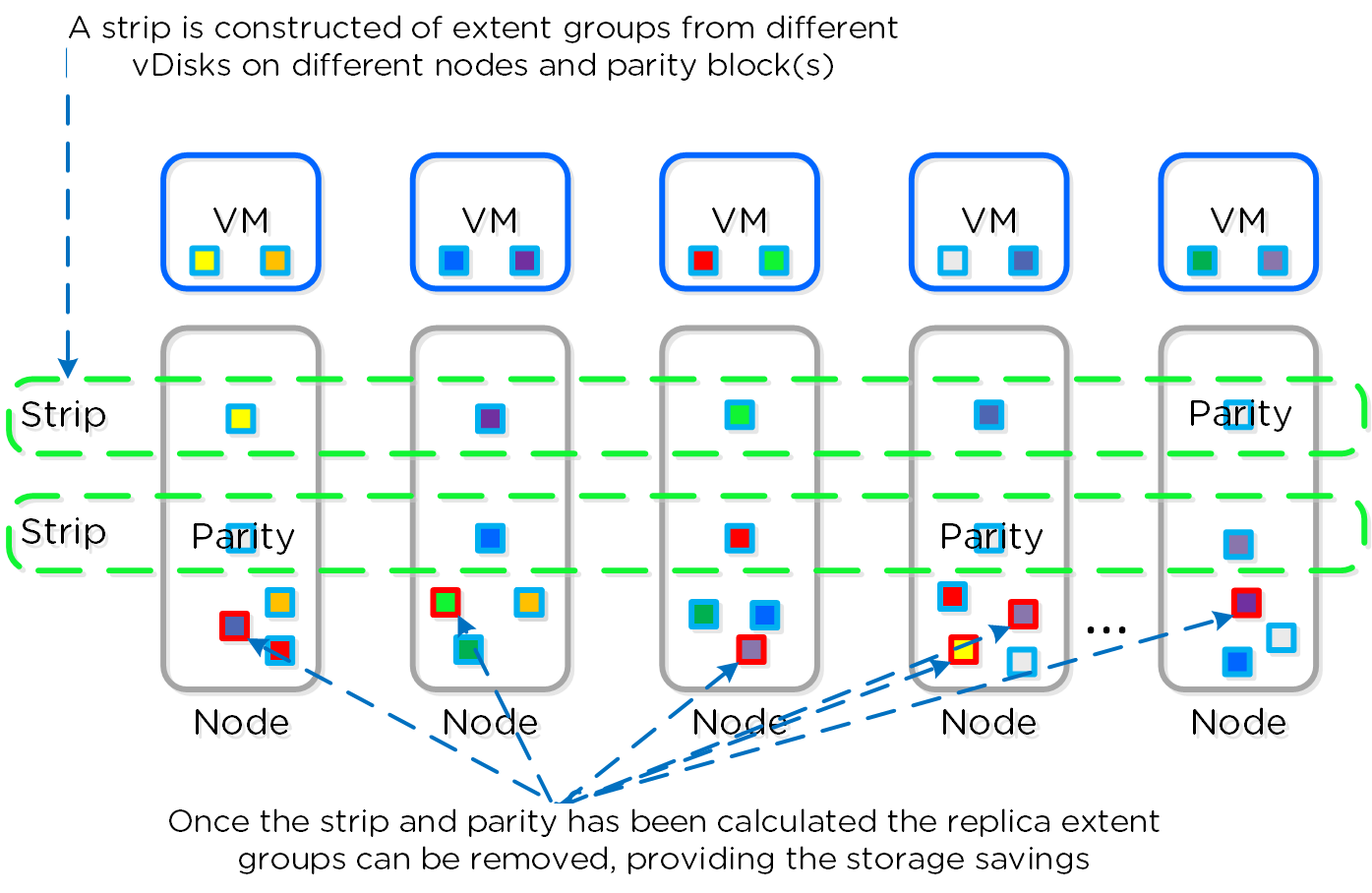

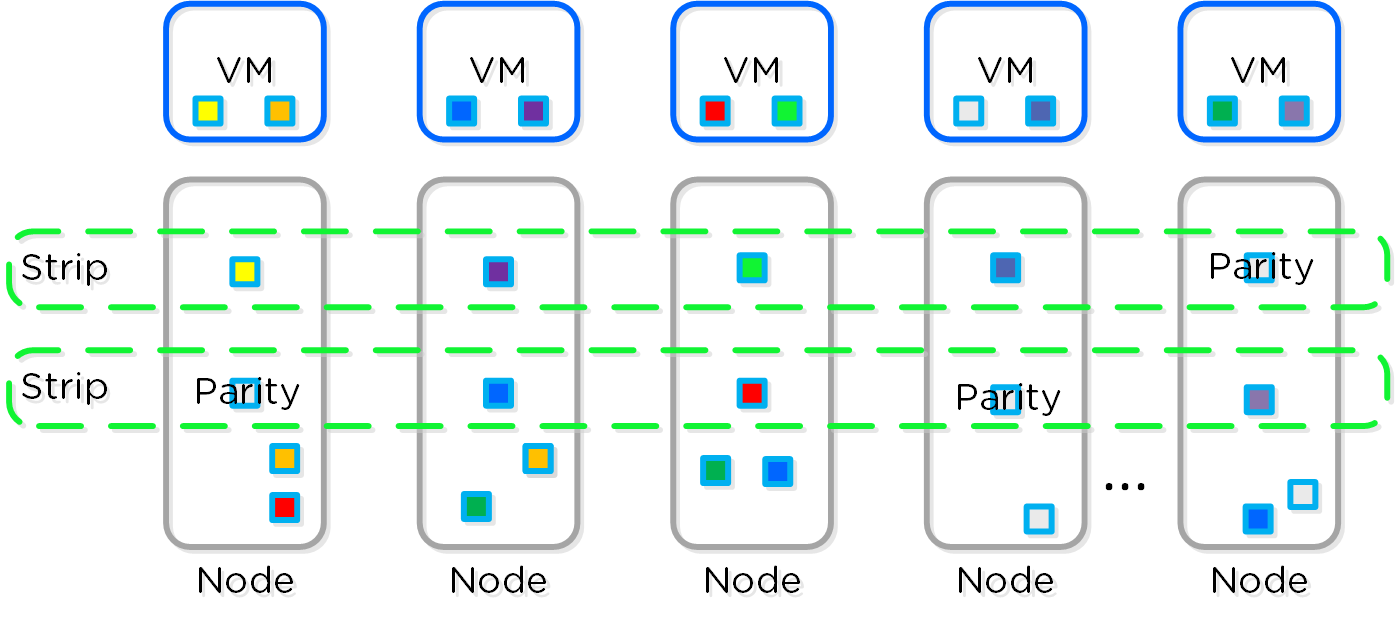

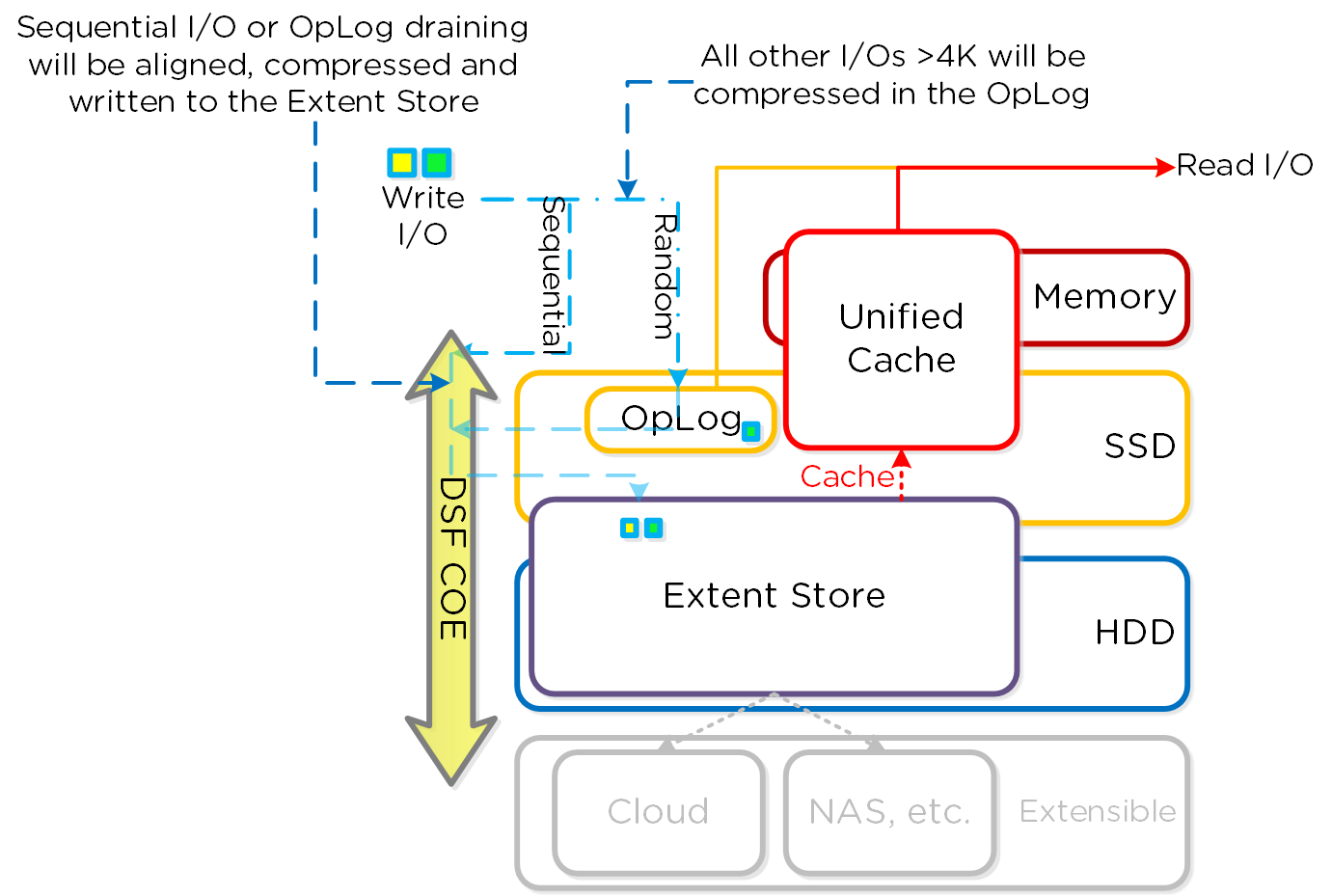

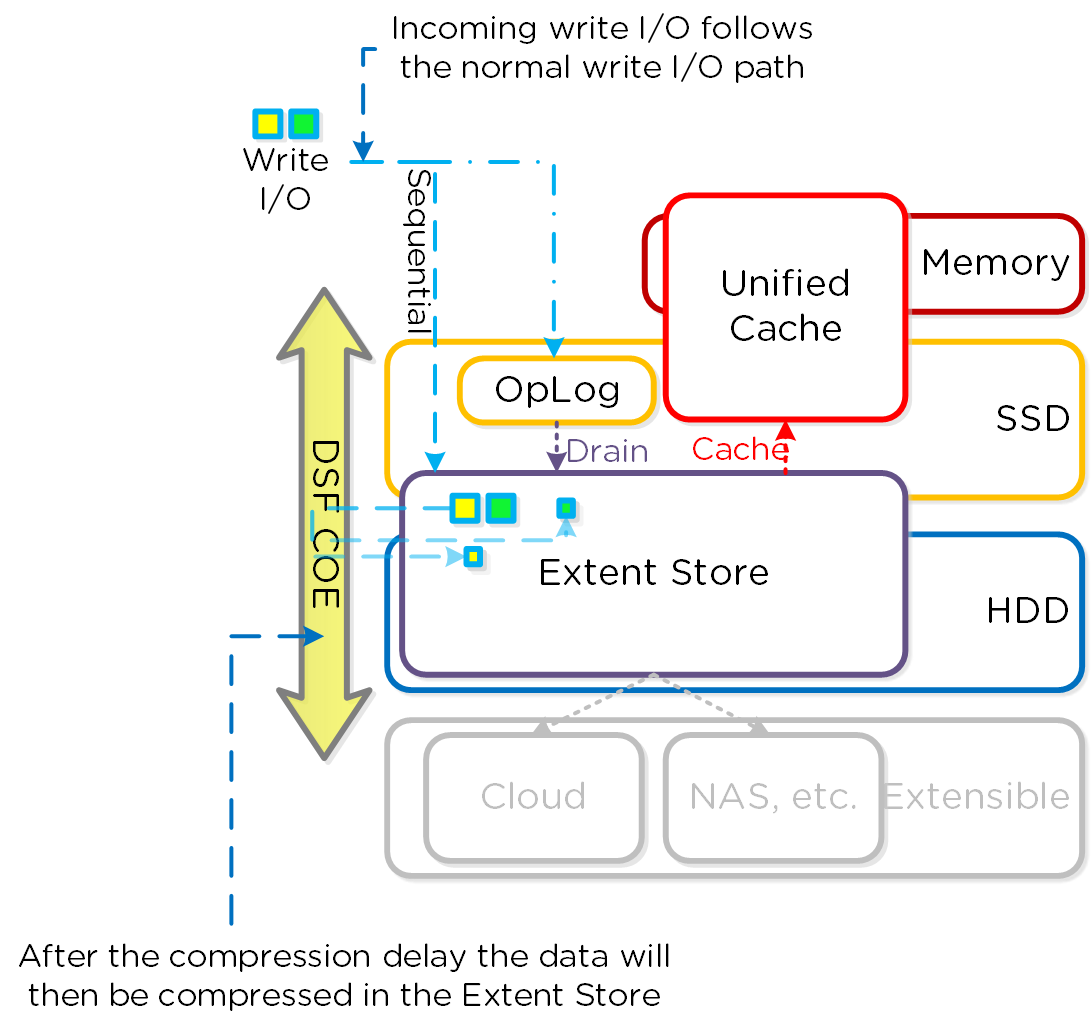

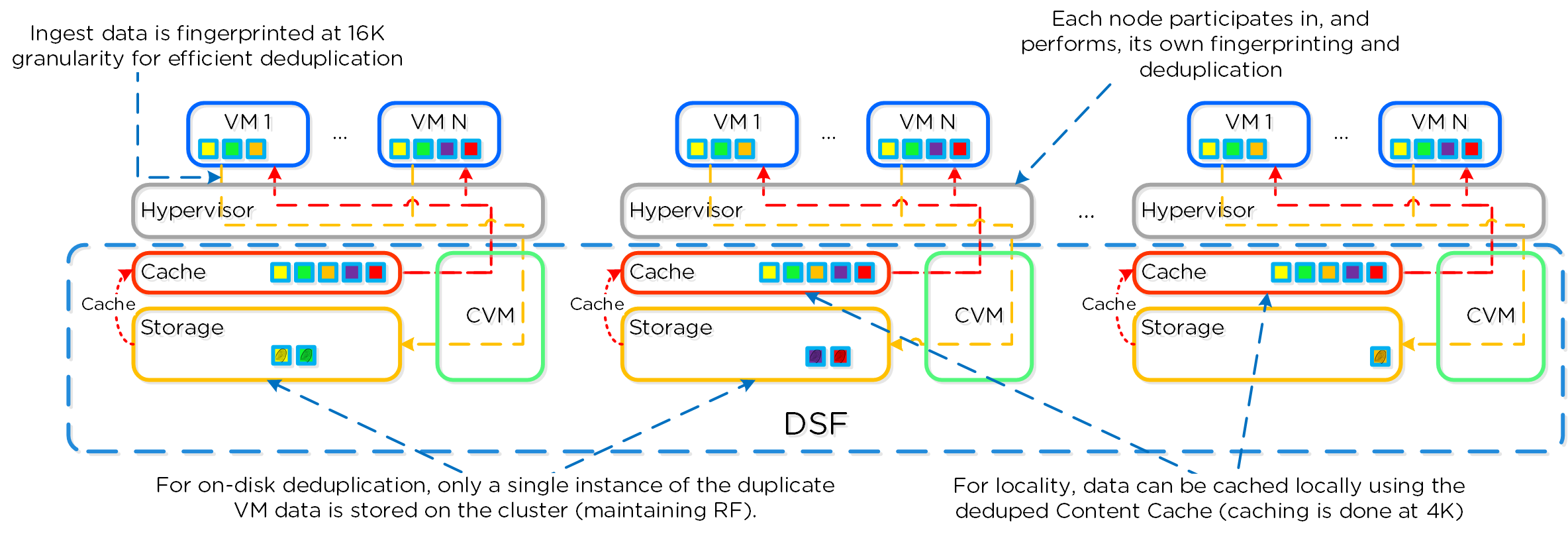

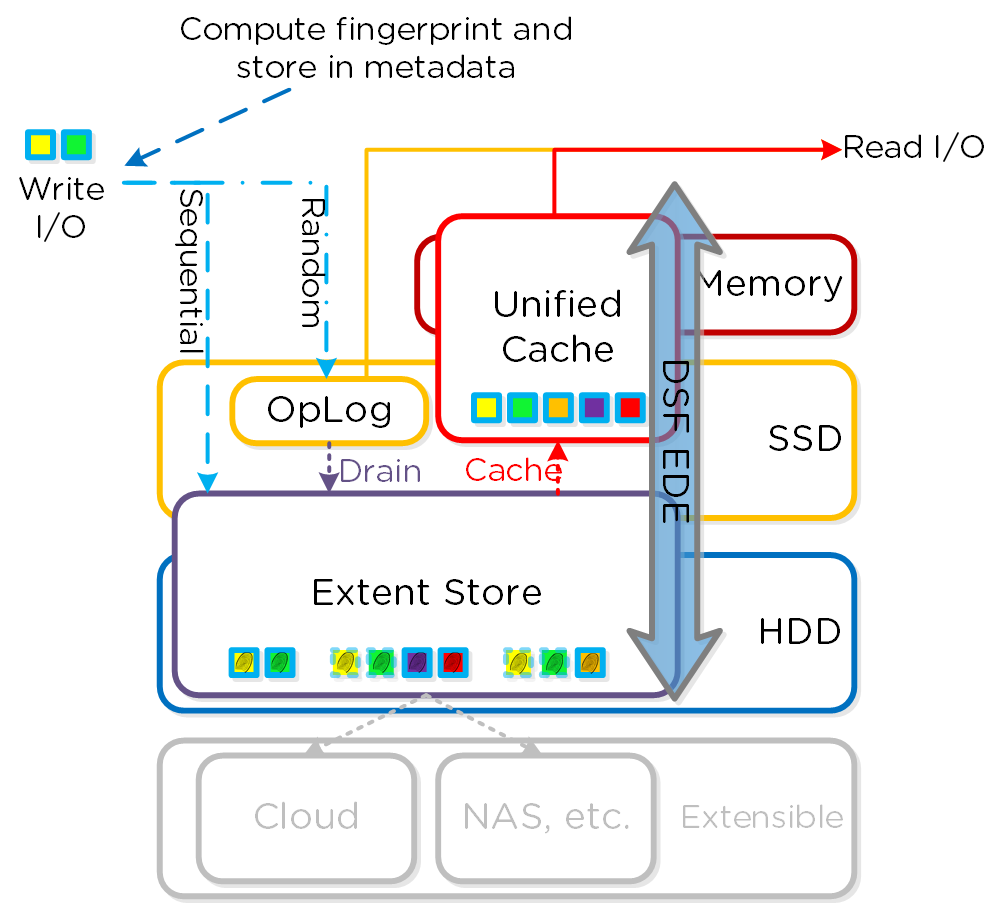

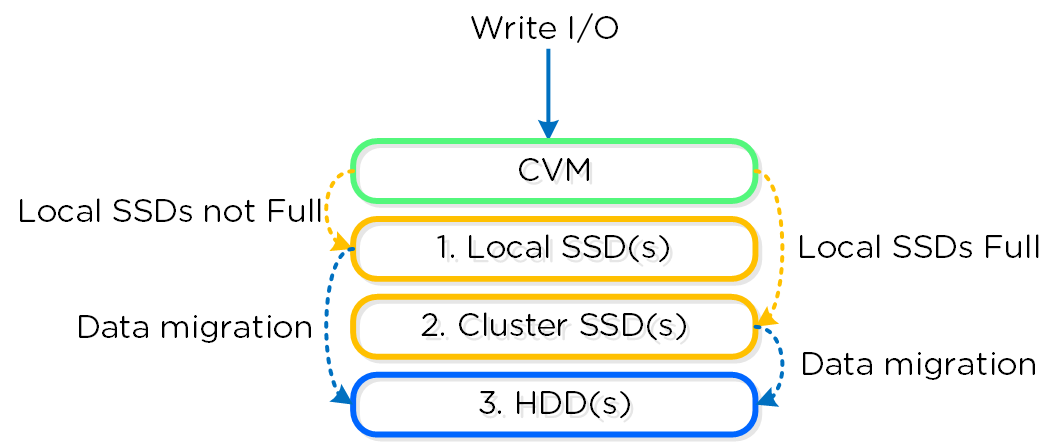

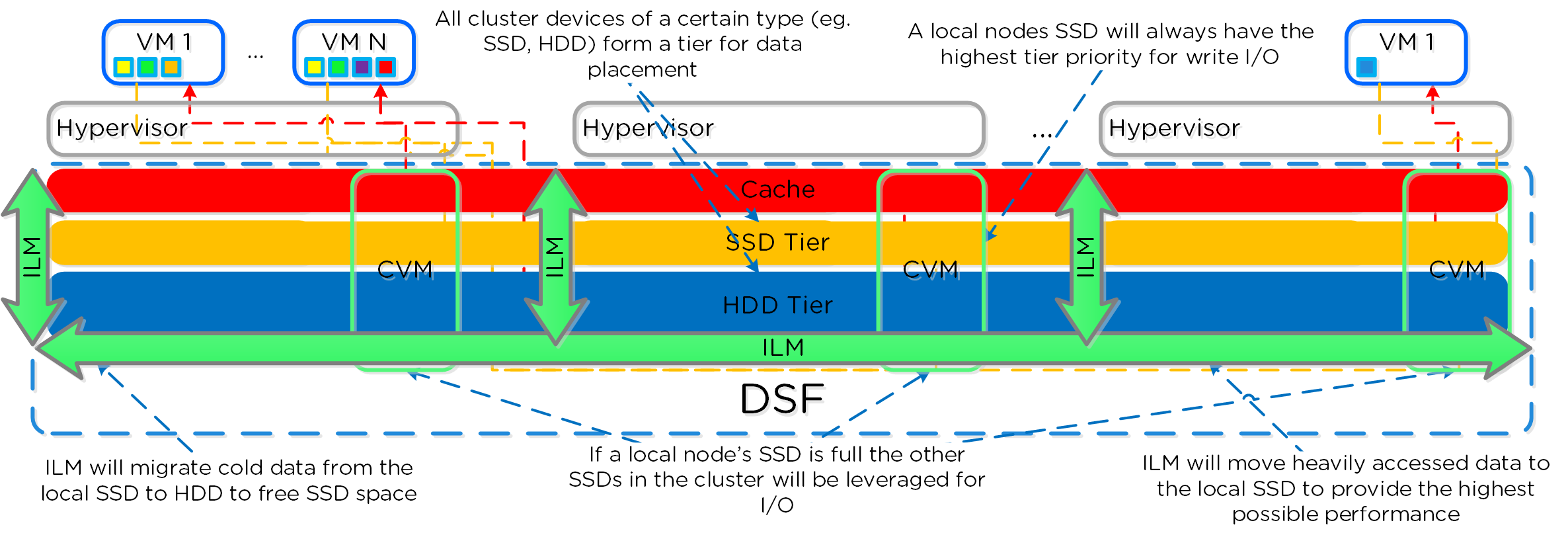

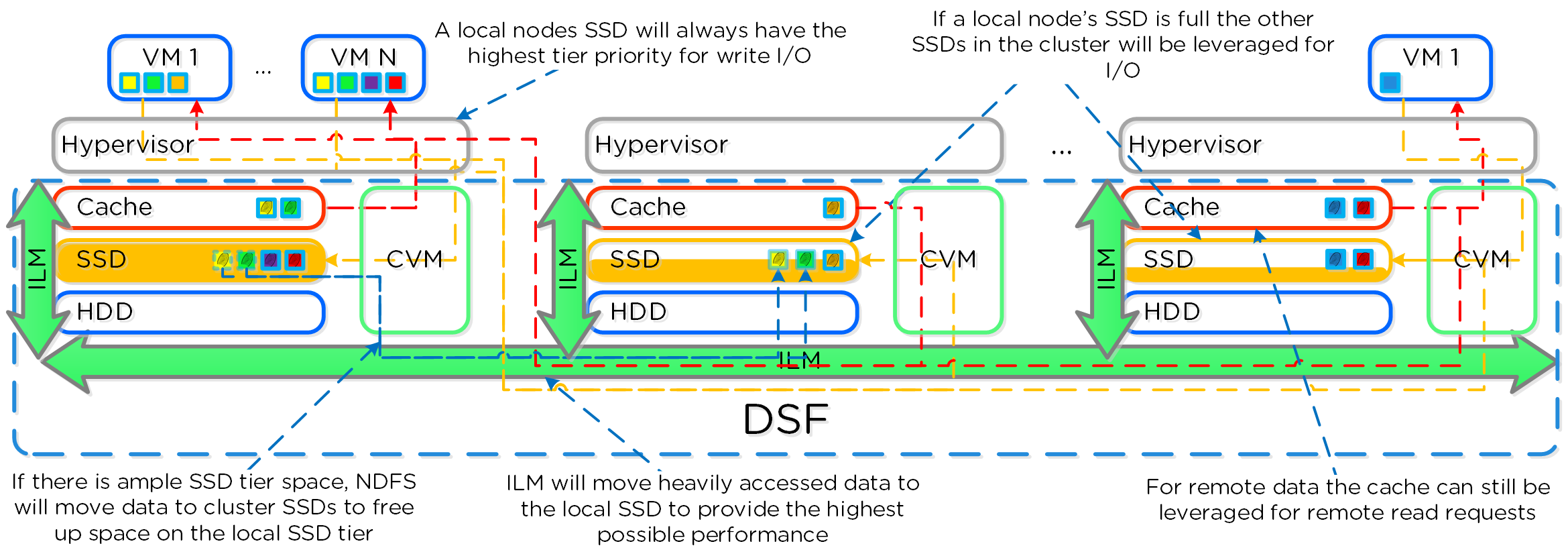

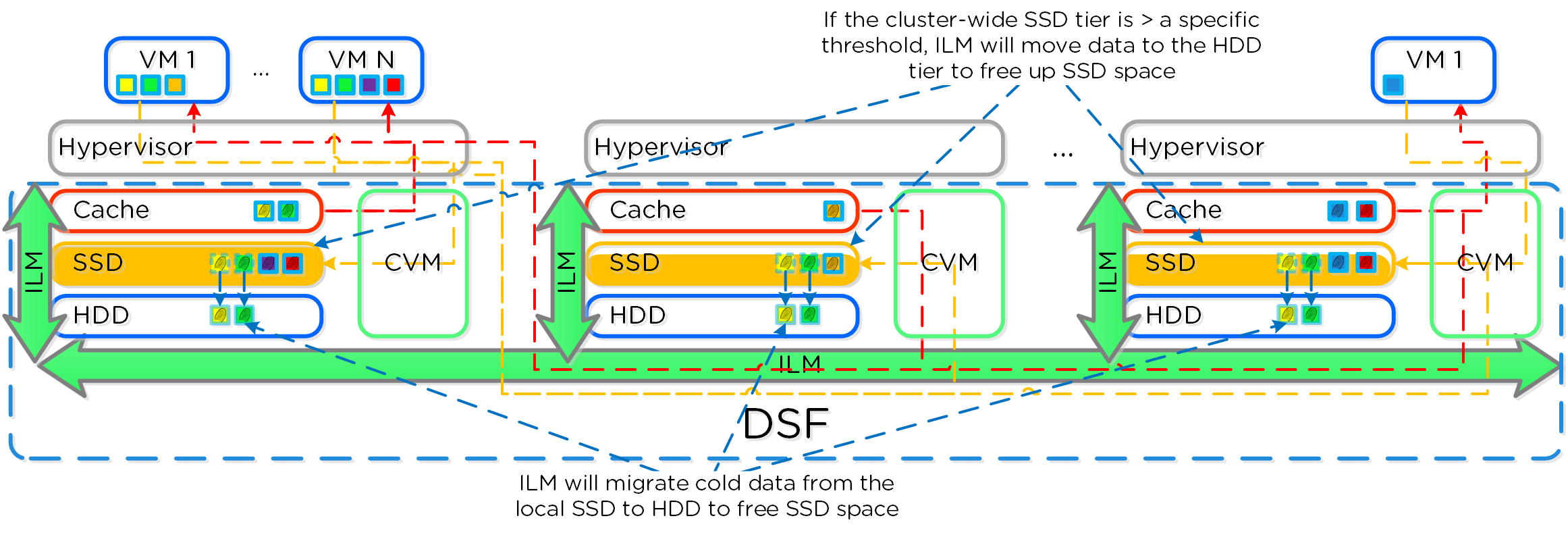

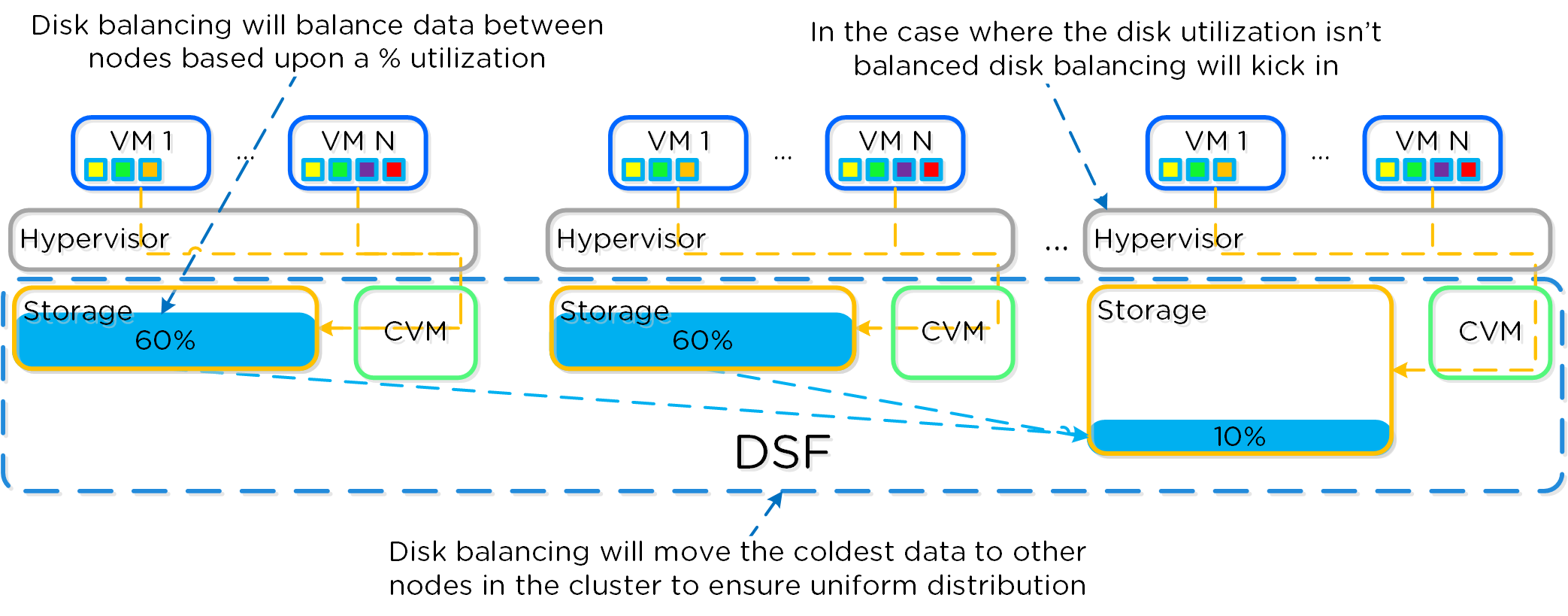

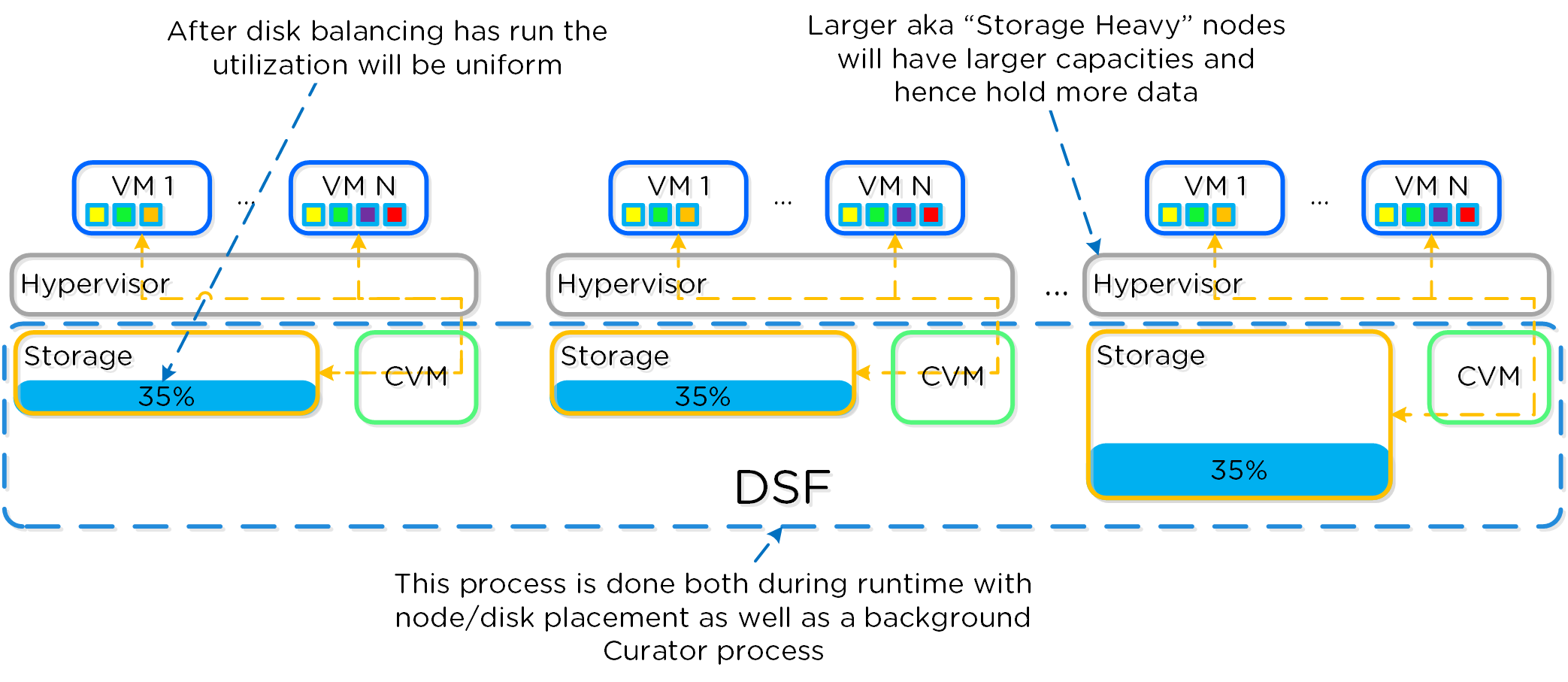

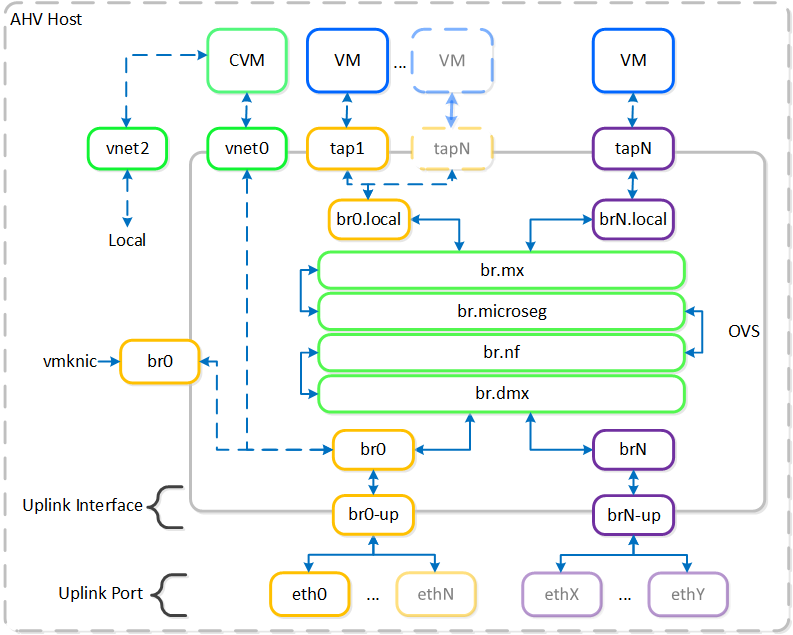

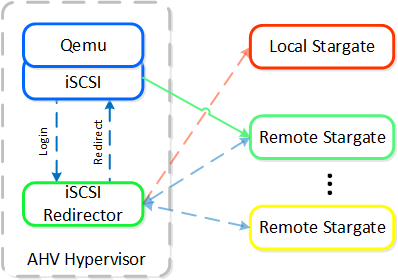

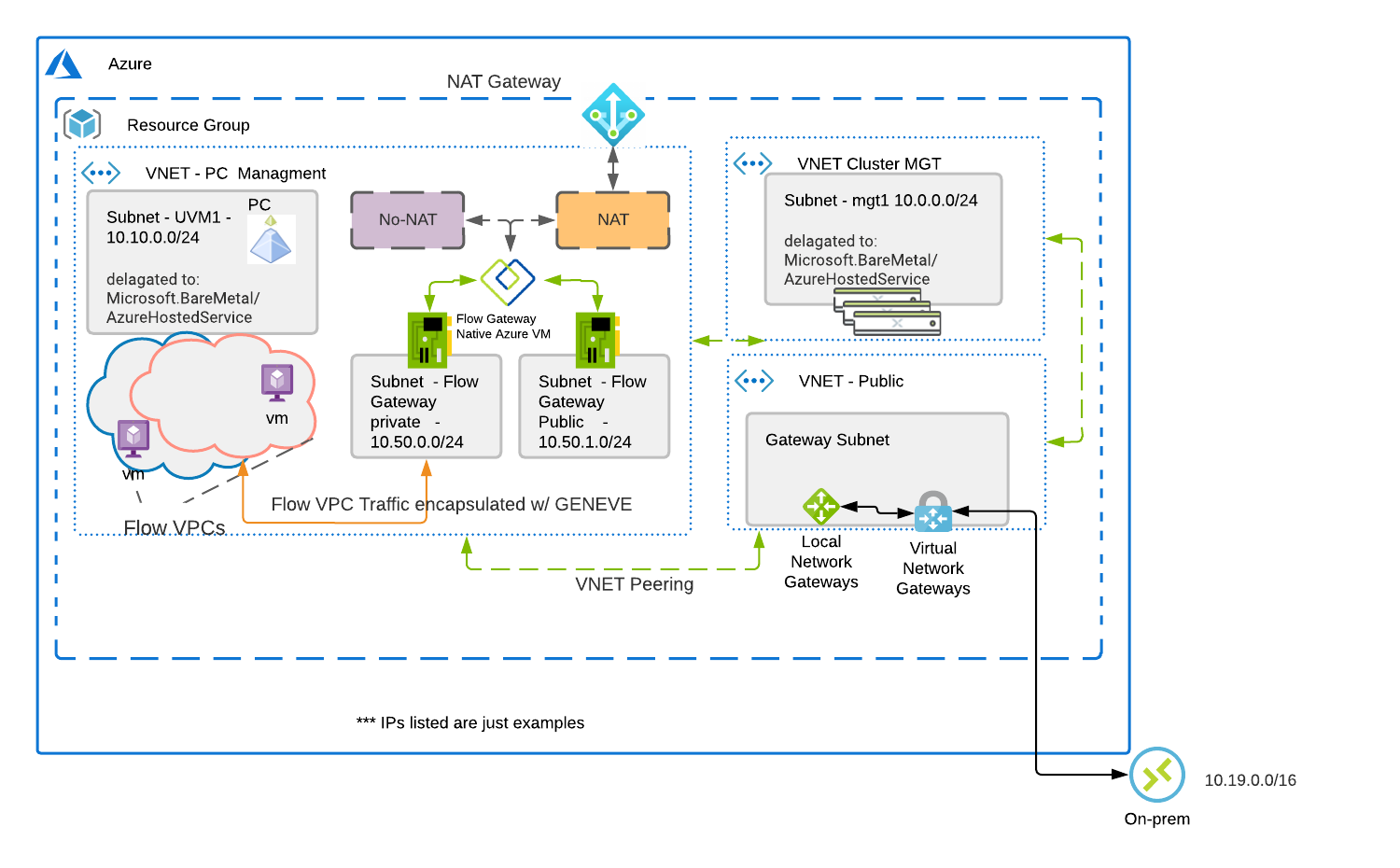

I/O 경로 및 캐시